Vous avez travaillé dur sur votre site web, publié des dizaines, voire des centaines de pages, espérant ainsi augmenter votre visibilité sur Google. Pourtant, votre trafic stagne, votre taux de rebond grimpe, et vous soupçonnez que quelque chose freine votre progression. Et si la cause se cachait derrière ce qu’on appelle les « zombie pages » ? Ce phénomène silencieux mais courant peut pénaliser votre SEO sans que vous vous en rendiez compte. Plongeons ensemble dans ce sujet pour comprendre comment identifier et neutraliser ces pages fantômes.

- Qu’est-ce qu’une zombie page et pourquoi elle nuit au référencement naturel

- Comment détecter les zombie pages sur un site

- Que faire des zombie pages : Suppression, fusion ou optimisation

- Quelles sont les causes les plus fréquentes de la création de zombie pages ?

- Mettre en place une stratégie préventive contre les zombie pages

Qu’est-ce qu’une zombie page et pourquoi elle nuit au référencement naturel

Une zombie page est une page web indexée par Google, mais qui ne remplit aucun objectif de performance. Elle n’apporte pas de trafic organique, ne capte pas l’attention des utilisateurs, n’incite à aucune interaction et ne contribue en rien à la visibilité ou à la notoriété du site. Du point de vue du contenu, il peut s’agir d’une page à faible densité informationnelle, obsolète, mal optimisée, ou encore d’une page générée automatiquement (comme certaines fiches produits sans contenu enrichi ou des pages de pagination mal gérées). Elle peut aussi résulter d’un excès de duplication, d’un maillage interne défaillant ou de l’absence de réelle intention de recherche ciblée.

Le problème principal avec ces pages, c’est qu’elles nuisent à la perception globale de qualité d’un site par les moteurs de recherche. Google, à travers ses différents algorithmes (comme Panda pour la qualité de contenu ou Core Update pour les signaux E-E-A-T), évalue non seulement la performance individuelle d’une page, mais également l’autorité et la cohérence de l’ensemble du domaine. Un volume important de contenus sans valeur ajoutée peut ainsi diluer la pertinence générale du site et entraîner une baisse de positionnement, y compris pour les pages les plus stratégiques.

Autre point critique : le gaspillage du budget de crawl. Googlebot, comme tout robot d’exploration, dispose de ressources limitées pour chaque site : c’est ce qu’on appelle le crawl budget. Ce budget dépend notamment de la popularité du site et de sa structure technique. Lorsqu’il est consommé par des pages sans intérêt, cela retarde l’indexation ou la mise à jour des pages réellement importantes. Les contenus prioritaires peuvent donc être explorés moins fréquemment ou de façon incomplète, ce qui compromet leur visibilité dans les résultats de recherche (SERP).

Il faut également considérer la problématique du PageRank interne. Les pages zombies, si elles sont intégrées dans le maillage du site, captent une partie du jus SEO sans générer de retour sur investissement. Cela contribue à la dilution du PageRank, affaiblissant les performances SEO des pages à fort potentiel. À l’échelle d’un site e-commerce ou d’un média ayant des milliers de pages, l’effet cumulé peut être significatif.

En résumé, la présence de zombie pages entraîne une triple pénalisation :

- elle dégrade les signaux de qualité envoyés à Google,

- elle gaspille le budget de crawl et nuit à l’indexabilité des pages pertinentes,

- et elle affaiblit le maillage interne en dispersant inutilement le PageRank.

Dans une logique de référencement naturel performante et durable, il est donc essentiel d’identifier régulièrement ces pages mortes-vivantes, de comprendre pourquoi elles existent, et d’appliquer les bonnes pratiques pour les désindexer, les consolider ou les optimiser. Un site bien entretenu, à forte densité de valeur ajoutée par page, sera toujours mieux perçu par les algorithmes de Google.

Comment détecter les zombie pages sur un site

Pour identifier les zombie pages, un audit SEO est généralement nécessaire. Plusieurs outils permettent d’analyser l’état de santé de vos pages, dont :

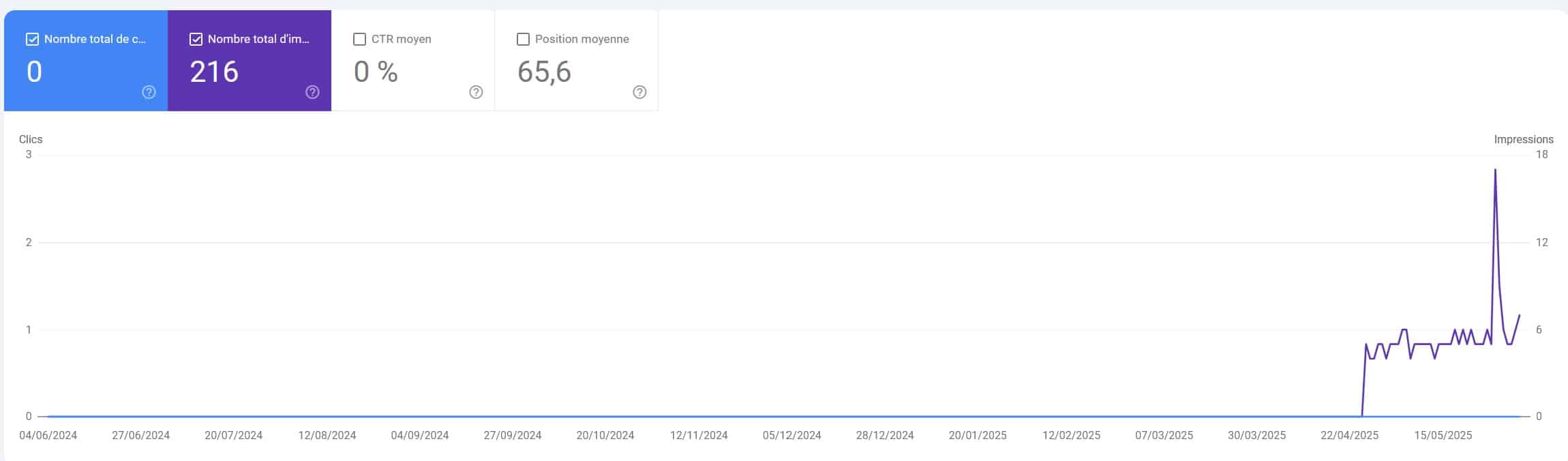

- Google Search Console : en observant les pages indexées sans impressions ou clics depuis plusieurs mois ;

- Google Analytics : pour identifier les pages qui ne génèrent aucun trafic ;

- Outils de crawl SEO comme Screaming Frog, Oncrawl ou Sitebulb : pour croiser les données d’indexation, de contenu, et de performance.

Une fois les données réunies, plusieurs critères permettent de repérer une page zombie :

- Pas ou peu de trafic organique depuis plusieurs mois ;

- Temps de lecture extrêmement court ou taux de rebond très élevé ;

- Aucune conversion ni interaction utilisateur ;

- Contenu très court, pauvre, ou dupliqué ;

- Pages orphelines (non liées par d’autres pages internes).

Attention cependant à ne pas confondre zombie page et page de niche ou evergreen qui, bien que peu visitée, peut avoir une valeur stratégique. Il convient donc d’analyser ces pages au cas par cas, en fonction de leur objectif et de leur potentiel.

Dans La GSC, travailler ces pages permet d’avoir une data supplémentaire pour arbitrer

Que faire des zombie pages : Suppression, fusion ou optimisation

Une fois les zombie pages identifiées à travers un audit SEO ou une analyse comportementale, plusieurs types d’actions peuvent être envisagées. Le choix de la meilleure approche dépend du rôle initial de la page, de son niveau de qualité, de son ancienneté et de son potentiel SEO. L’objectif est toujours le même : réduire le bruit éditorial et concentrer la valeur sur les contenus les plus pertinents. Voici les trois grandes options à envisager :

1. La suppression pure et simple de l’URL

La suppression est souvent la voie la plus directe, mais elle doit être utilisée avec discernement. Une page peut être supprimée lorsqu’elle ne génère aucun trafic depuis plusieurs mois, n’a reçu aucun lien entrant, et ne correspond à aucune intention de recherche identifiée. Il est essentiel de vérifier qu’elle n’est pas référencée en interne ou depuis d’autres sites. Deux méthodes techniques sont alors possibles :

- Redirection 301 : si la page supprimée a une thématique proche d’une autre page pertinente, la redirection permet de préserver un minimum de PageRank et d’expérience utilisateur.

- Code 410 (Gone) : ON l’utilisera de manière exceptionnelle (voir notre article sur le sujet) car c’est un signal explicite envoyé à Google que la page a été définitivement supprimée, plus rapide pour la désindexation qu’un simple 404.

2. La fusion avec une page similaire

La fusion est une excellente alternative à la suppression quand plusieurs contenus traitent d’un sujet proche. Elle permet de centraliser la valeur informationnelle, d’enrichir le contenu cible, et de renforcer son poids SEO. C’est aussi un moyen de réduire la cannibalisation des mots clés : en regroupant deux pages qui se disputaient la même requête, vous améliorez leur performance conjointe. Attention toutefois à bien gérer les redirections et à ajuster les liens internes pour pointer vers la nouvelle version consolidée. La fusion doit aboutir à une page plus riche, mieux structurée, et répondant de façon plus complète à l’intention de recherche ciblée.

3.La réécriture et amélioration du contenu de la page zombie

Dans certains cas, une page zombie peut être réhabilitée si son sujet reste pertinent mais mal traité. L’optimisation peut porter sur plusieurs aspects :

- Ajout de contenu pertinent (textes, images, vidéos, FAQ…) ;

- Optimisation des balises SEO (title, meta description, Hn…) ;

- Meilleur ciblage sémantique et enrichissement du champ lexical ;

- Amélioration du maillage interne pour accroître la visibilité ;

- Réduction du temps de chargement et adaptation mobile.

Il s’agit ici de transformer une page faible en contenu performant, avec une vraie valeur utilisateur, un positionnement clair, et des signaux positifs aux yeux de Google (temps de lecture, taux de clic, partages…).

Un tableau pour résumer les possibilités :

| Action | Quand et comment l’appliquer |

|---|---|

| Suppression | À appliquer si la page est totalement inutile, sans trafic, sans backlinks et sans rôle stratégique. Utiliser une redirection 301 vers une page proche ou un code 410 si aucun équivalent n’existe. |

| Fusion | Pertinent si la page a un contenu faible mais complémentaire à une autre page. Fusionner les contenus, rediriger l’ancienne URL, et revoir les liens internes. |

| Optimisation | À choisir si la thématique est toujours d’actualité mais mal exploitée. Travailler le fond (contenu) et la forme (balises, vitesse, UX) pour améliorer la performance SEO. |

Quelle que soit l’option retenue, ces décisions doivent s’inscrire dans une stratégie éditoriale cohérente. Une analyse post-traitement permet de mesurer l’impact des actions entreprises (trafic, positionnements, taux de clic, etc.) et d’anticiper d’éventuelles retombées négatives. En outre, la présence de zombie pages peut révéler des failles plus profondes dans le processus de production de contenu : manque de ligne éditoriale, duplication de sujets, ou absence de pilotage SEO à la création. En traitant le symptôme, il faut aussi penser à soigner la cause.

Quelles sont les causes les plus fréquentes de la création de zombie pages ?

Les zombie pages ne sont pas systématiquement le fruit d’une mauvaise gestion volontaire. Dans de nombreux cas, elles résultent de mécanismes techniques automatisés, de logiques de production à grande échelle ou d’un manque de suivi stratégique post-publication. Comprendre ces causes permet non seulement de les corriger, mais surtout d’anticiper leur réapparition dans une logique de maintenance SEO continue. Voici les facteurs les plus fréquents à l’origine de l’apparition de ces pages inactives ou invisibles aux yeux des utilisateurs et des moteurs de recherche :

- Génération automatique de pages par les CMS : sur les plateformes e-commerce, les CMS génèrent souvent des pages dynamiques pour chaque combinaison de filtres, de tri ou de variantes de produit (taille, couleur, matière…). Ces pages, bien que techniquement accessibles, ne bénéficient ni de contenu optimisé ni de stratégie sémantique, ce qui les rend inutiles du point de vue SEO. De plus, ces pages peuvent se multiplier de façon exponentielle, surchargent l’indexation et finissent par former des clusters de contenus sans valeur ;

- Contenus dupliqués ou trop généralistes : lorsqu’un même sujet est traité à plusieurs reprises sous des angles trop similaires, sans personnalisation, ni approfondissement, on tombe dans la duplication interne. Cela est fréquent sur les blogs d’entreprise où plusieurs articles sur un même thème sont publiés à différents moments sans différenciation suffisante. Le résultat : plusieurs pages qui se cannibalisent entre elles, n’apportent rien de nouveau, et sont jugées redondantes par Google ;

- Désorganisation ou sur-segmentation de l’arborescence : un site mal structuré peut générer des pages peu accessibles ou isolées. Par exemple, des pages qui ne sont reliées à aucune autre via le maillage interne (pages orphelines), ou des sections mal hiérarchisées avec des sous-catégories pauvres en contenu. Ce type de configuration mène à une indexation de pages peu pertinentes qui échappent au contrôle éditorial et finissent abandonnées ;

- Pages issues de campagnes temporaires non archivées : il est courant de créer des pages spécifiques pour des événements ponctuels : soldes, jeux concours, campagnes de lancement, etc. Mais une fois ces campagnes terminées, ces pages sont souvent oubliées. Elles restent accessibles, parfois indexées, sans mise à jour ni redirection, devenant ainsi des pages zombies qui plombent le site à moyen terme si elles ne sont pas désactivées ou recyclées ;

- Création de pages sans étude d’intention de recherche : une erreur fréquente consiste à publier du contenu uniquement pour remplir un calendrier éditorial, sans réflexion sur le besoin réel de l’utilisateur ou la concurrence déjà présente. Résultat : des contenus vagues, hors cible ou sans ancrage SEO, qui n’ont aucune chance de performer. Ces pages sont invisibles sur Google car elles ne répondent à aucune requête pertinente, et finissent par stagner dans l’oubli ;

- Traductions automatisées ou versions multilingues non gérées : sur les sites multilingues, une mauvaise gestion des balises hreflang ou des traductions incomplètes peut entraîner l’indexation de versions vides, non localisées ou mal comprises par les utilisateurs. Ces pages, peu attractives, deviennent des zombies si elles ne sont pas correctement intégrées dans la stratégie internationale ;

- Tests, bacs à sable ou contenus en cours de rédaction laissés publiés : il arrive que des pages créées pour des tests (A/B testing, prototypage de landing pages, brouillons d’articles) soient indexées par Google si elles ne sont pas bloquées par le fichier robots.txt ou via une balise « noindex ». Ces contenus inaboutis nuisent fortement à la qualité perçue du site.

Chaque cause identifiée révèle un point faible dans la gestion du cycle de vie des contenus : absence de validation éditoriale, défaut de gouvernance SEO, ou automatisation non maîtrisée. Pour limiter l’apparition de nouvelles zombie pages, il est essentiel d’intégrer des garde-fous à chaque étape de production : Réflexion stratégique en amont, validation technique avant mise en ligne, et suivi de performance en aval.

Mettre en place une stratégie préventive contre les zombie pages

La meilleure gestion des zombie pages consiste à prévenir leur apparition en intégrant des pratiques de gouvernance éditoriale et technique. Voici quelques recommandations :

| Bonne pratique | Description détaillée |

|---|---|

| Planification éditoriale rigoureuse | Avant toute création de contenu, il est essentiel d’analyser les intentions de recherche des internautes et de définir une ligne éditoriale précise. Chaque page doit avoir un objectif clair (information, conversion, visibilité) et s’intégrer dans une architecture logique du site. Cela permet de produire moins, mais mieux, en limitant les contenus sans cible ni utilité. |

| Suivi de performance continu | Une fois le contenu publié, il ne suffit pas de le laisser vivre sans surveillance. Il faut régulièrement analyser les données de performance via des outils comme Google Analytics, Google Search Console ou des dashboards SEO. Pages sans trafic, perte de position ou engagement faible doivent alerter pour déclencher une action corrective avant qu’elles ne deviennent des zombies. |

| Audit SEO récurrent | Un audit complet du site (technique, contenu, maillage) doit être planifié au moins tous les 6 à 12 mois. Il permet d’identifier les contenus obsolètes, les erreurs d’indexation, les problèmes de duplication ou de structure. Cela aide à maintenir une base saine et à anticiper les pertes de visibilité liées à la dégradation progressive de certaines pages. |

| Nettoyage des anciennes campagnes | Les pages créées pour des opérations ponctuelles (soldes, événements, lancements produits) doivent être pensées avec une date de fin. Une stratégie de désactivation (redirection, désindexation, archivage) doit être prévue dès leur création. Cela évite qu’elles ne restent en ligne sans trafic ni valeur, tout en continuant à être explorées inutilement par les moteurs. |

| Contrôle du maillage interne | Le maillage interne doit être piloté avec méthode : éviter les liens vers des pages peu pertinentes, veiller à bien relier les pages à forte valeur, structurer les silos thématiques. Un maillage efficace permet à Google de mieux comprendre la hiérarchie de l’information et de favoriser l’exploration des pages prioritaires. Il empêche également les contenus faibles de se maintenir artificiellement dans l’index. |

Mettre en place ces processus dès la conception éditoriale limite considérablement le risque d’accumulation de pages mortes, et renforce l’efficacité globale du site à long terme.

0 commentaires