Le référencement naturel ne repose pas uniquement sur les bons mots-clés, les liens entrants ou l’optimisation des balises HTML. Sous la surface, des éléments techniques plus discrets peuvent influencer la façon dont un site est perçu par les moteurs de recherche. Parmi eux, un facteur souvent négligé mérite qu’on s’y attarde : L’emplacement physique du serveur d’hébergement Web. Chaque milliseconde compte lorsqu’un internaute clique sur un lien. Si le serveur se trouve à des milliers de kilomètres de l’utilisateur, le site peut sembler plus lent à charger, un détail qui n’échappe ni à l’utilisateur, ni à Google. Alors, la position géographique d’un serveur peut-elle réellement jouer un rôle dans le SEO ? La réponse mérite d’être explorée en profondeur.

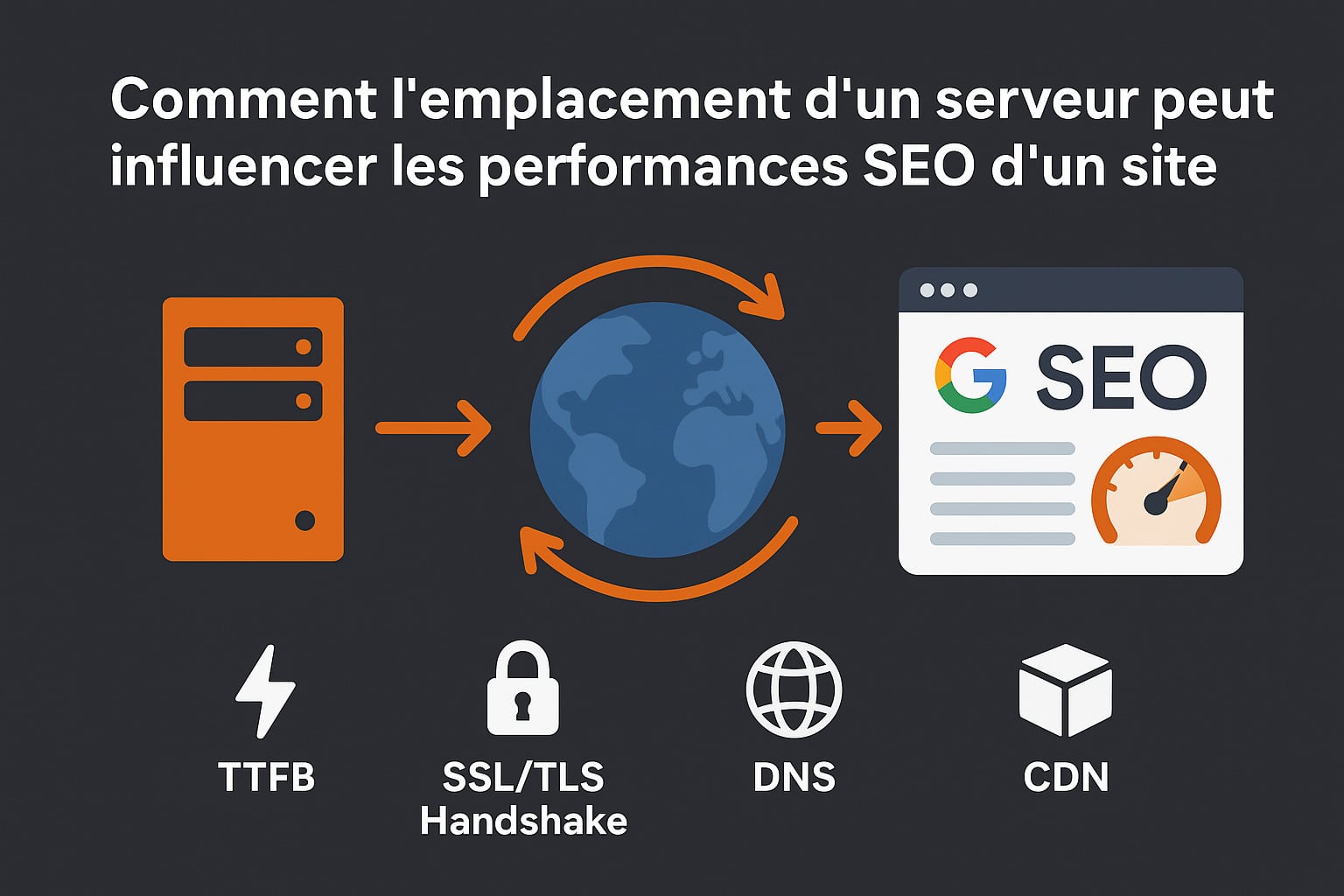

Comment l’emplacement d’un serveur peut influencer les performances SEO d’un site

Pour évaluer l’impact de la localisation géographique d’un serveur sur le SEO, il est nécessaire de revenir à des notions fondamentales du fonctionnement d’Internet, notamment la latence réseau. Lorsqu’un utilisateur tente d’accéder à un site, son navigateur initie une série de requêtes HTTP (ou HTTPS) qui doivent traverser le réseau jusqu’au serveur hébergeant le site. Ce trajet implique plusieurs étapes : résolution DNS, établissement de la connexion TCP, échange de certificats SSL/TLS, récupération des ressources HTML, CSS, JS, images, etc. Chacune de ces étapes est soumise à des délais qui sont influencés par la distance physique entre le client (le navigateur) et le serveur. Plus cette distance est importante, plus les paquets de données mettent de temps à faire l’aller-retour. Cette durée, exprimée en millisecondes, est appelée latence. Et même si ces délais peuvent sembler négligeables pour un utilisateur individuel, leur cumul impacte la rapidité perçue d’un site… et donc son référencement.

Voici les principaux paramètres techniques directement influencés par l’emplacement du serveur :

- Temps de réponse du serveur (TTFB – Time To First Byte) : C’est l’un des indicateurs clés pour le SEO technique. Il mesure le temps écoulé entre l’émission de la requête HTTP par le navigateur et la réception du premier octet de réponse par le client. Un serveur proche géographiquement aura, toutes choses égales par ailleurs, un TTFB plus faible qu’un serveur éloigné. Google ne communique pas officiellement de seuil précis, mais il est admis qu’un TTFB inférieur à 200 ms est idéal, et qu’au-delà de 500 ms, des optimisations sont nécessaires ;

- Phase de handshake SSL/TLS : Sur les sites en HTTPS (ce qui est désormais la norme), l’établissement de la connexion sécurisée nécessite plusieurs échanges entre le client et le serveur. Cette négociation cryptographique (SSL handshake) implique au minimum deux allers-retours réseau. Une latence élevée peut donc ralentir de manière significative l’établissement d’une connexion sécurisée.

- Résolution DNS : Même la requête DNS, c’est-à-dire la recherche de l’adresse IP associée au nom de domaine, peut être ralentie si le serveur DNS utilisé est éloigné de l’utilisateur ou mal configuré (pas de redondance, TTL trop court, etc.). Cela rallonge le temps de chargement initial de la page ;

- Chargement des ressources critiques : Scripts JavaScript, feuilles de style CSS, polices web, images… Toutes ces ressources sont chargées dès l’affichage initial de la page. Si elles sont hébergées sur le même serveur distant, leur chargement sera impacté par la latence ;

- Absence ou mauvaise configuration d’un CDN : Sans CDN, toutes les ressources (dynamiques ou statiques) proviennent du serveur principal. Si celui-ci est à plusieurs milliers de kilomètres de la majorité de vos visiteurs, la performance ressentie s’en ressentira. Un CDN bien configuré permet de distribuer les contenus statiques depuis des nœuds proches de l’utilisateur, mais ne remplace pas totalement l’intérêt d’un hébergement géographiquement optimisé.

Dans les cas où un site est hébergé sur un serveur mutualisé low-cost, ou sur une infrastructure sans réseau optimisé (ex. : absence de cache, absence de compression gzip ou brotli, pas d’HTTP/2), l’impact de la localisation géographique est encore plus marqué. Une latence réseau plus importante peut se traduire par une expérience utilisateur dégradée : lenteur d’affichage, temps d’interaction plus long, frustration… autant de signaux que Google peut interpréter comme des éléments défavorables au bon classement du site.

Google a officiellement confirmé que la vitesse de chargement faisait partie des critères de classement, en particulier depuis l’introduction des Core Web Vitals. Ces indicateurs, comme le Largest Contentful Paint (LCP), le First Input Delay (FID) ou le Time to Interactive (TTI), peuvent être influencés (directement ou indirectement) par l’éloignement du serveur.

Une illustration concrète pour mieux comprendre

Imaginons un site e-commerce en .com hébergé sur un serveur aux États-Unis, mais qui cible exclusivement une audience située en France. Lorsqu’un internaute français visite le site, sa requête doit traverser l’Atlantique et faire l’aller-retour plusieurs fois avant que le contenu de la page ne s’affiche complètement. Cela peut ajouter plusieurs centaines de millisecondes au chargement global de la page. Conséquences potentielles :

- Augmentation du taux de rebond, en particulier sur mobile pouvant enclencher un effet de pogosticking ;

- Réduction du nombre de pages vues par session ;

- Temps de session plus court ;

- Diminution du taux de conversion (panier abandonné, formulaire non rempli…)

Ces indicateurs comportementaux sont surveillés de près par Google. Même s’ils ne sont pas des facteurs de classement directs, ils nourrissent les algorithmes d’évaluation de l’expérience utilisateur. Et cette expérience est, elle, un pilier de plus en plus important dans le positionnement d’un site dans les résultats de recherche.

Géolocalisation du serveur et SEO local : Que faut-il savoir ?

Outre les performances, l’emplacement du serveur peut également jouer un rôle dans le référencement local. Historiquement, Google utilisait plusieurs signaux pour déterminer la localisation d’un site web :

- Le domaine de premier niveau (ex : .fr, .de, .co.uk)

- La langue du contenu

- Les données de la Search Console (ciblage géographique manuel)

- Les adresses IP (adresse IPv4 et IPv6) du serveur

L’adresse IP du serveur peut indiquer le pays dans lequel est hébergé le site. Google utilisait cette donnée pour proposer un contenu plus pertinent aux utilisateurs d’une région donnée. Toutefois, cette pratique est devenue moins centrale ces dernières années, notamment avec l’essor du cloud et des CDN qui rendent les IPs plus dynamiques.

Néanmoins, dans le cas d’un site sans extension géographique (.com, .net) et sans ciblage manuel dans la Search Console, l’adresse IP du serveur peut encore servir d’indice pour Google. Cela peut influencer légèrement la façon dont le site est positionné dans les résultats d’un pays donné.

Par exemple, si vous gérez un site e-commerce en .com, destiné uniquement au marché belge, mais que votre serveur est situé aux États-Unis, Google pourrait (dans certains cas) avoir plus de difficulté à déterminer que votre contenu s’adresse au public belge. Cela n’empêche pas le bon référencement, mais ce sont des détails qui peuvent faire la différence sur un marché compétitif.

Il est donc toujours recommandé de :

- Utiliser une extension géographique locale quand c’est pertinent (.fr, .be, .ch…)

- Déclarer manuellement le ciblage géographique dans la Google Search Console

- Choisir un serveur proche du public cible (ou un CDN efficace)

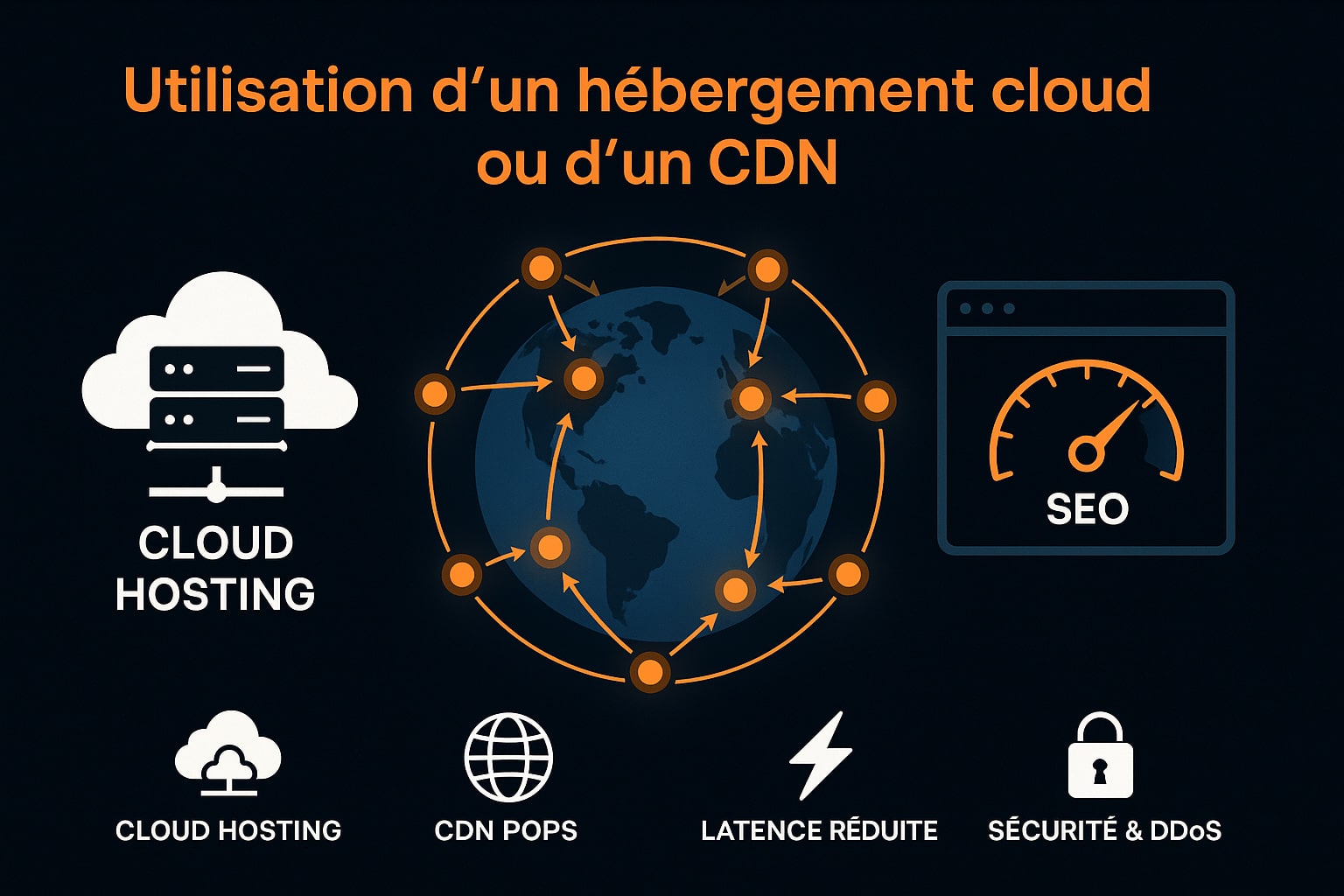

Et si j’utilise un hébergement cloud ou un CDN ?

Avec la généralisation des architectures modernes, de nombreux sites sont aujourd’hui déployés sur des solutions d’hébergement cloud comme Amazon Web Services (AWS), Google Cloud Platform (GCP), Microsoft Azure, OVHcloud ou DigitalOcean. Ces fournisseurs offrent la possibilité de choisir l’emplacement physique de ses serveurs parmi plusieurs régions ou zones de disponibilité réparties dans le monde entier. Cela permet déjà d’optimiser la proximité géographique avec le public cible.

Mais au-delà du choix du datacenter, l’ajout d’un CDN (Content Delivery Network) constitue une couche essentielle pour améliorer les performances de chargement. Un CDN est un réseau de serveurs distribués géographiquement, appelés points de présence ou PoPs (Points of Presence), dont le rôle est de stocker et de livrer les ressources statiques d’un site web (HTML statique, CSS, JavaScript, images, polices, vidéos…) au plus près de l’utilisateur final. Concrètement, lorsqu’un utilisateur accède à votre site, une infrastructure CDN comme Cloudflare, Bunny.net, Fastly ou Akamai utilise des mécanismes de routage DNS avancé et d’anycast pour le rediriger automatiquement vers le nœud le plus proche. Cela permet de réduire la latence réseau, améliorer le TTFB et optimiser les Core Web Vitals.

Dans ce contexte, la localisation géographique du serveur principal (origin server) perd en importance, car :

- Les fichiers statiques sont mis en cache automatiquement sur plusieurs centaines de nœuds répartis sur les cinq continents ;

- Les requêtes sont traitées localement : un visiteur en Asie ne télécharge pas les images depuis un serveur à Paris, mais depuis un PoP situé à Tokyo, Singapour ou Hong Kong ;

- Le DNS anycast et la compression des réponses (brotli, gzip) permettent d’améliorer encore davantage les temps de réponse globaux.

Les CDN modernes offrent également des fonctionnalités avancées, comme :

- Le cache dynamique ou edge computing : Certaines solutions permettent de mettre en cache même des pages HTML générées dynamiquement (ex. : page produit sur un site e-commerce) via des règles de cache intelligentes ;

- L’exécution de scripts au niveau du CDN (ex. : Cloudflare Workers, Vercel Edge Functions), réduisant le besoin de faire appel au serveur d’origine pour chaque requête ;

- La protection contre les attaques DDoS et les pics de trafic, qui évitent de surcharger l’infrastructure centrale.

Il est toutefois important de noter que tous les contenus ne peuvent pas toujours être servis par un CDN. Les requêtes dynamiques non cachables (comme les appels API personnalisés, les requêtes AJAX vers une base de données, ou les soumissions de formulaires) doivent encore être traitées par le serveur d’origine. C’est pourquoi il reste recommandé de placer le serveur principal dans une région géographiquement proche du cœur de son audience.

De fait, l’usage combiné d’un hébergement cloud bien localisé et d’un CDN performant permet :

- D’améliorer sensiblement les performances réseau perçues

- De neutraliser les effets négatifs de l’éloignement géographique

- De stabiliser les temps de chargement quel que soit l’endroit d’où l’utilisateur consulte le site

C’est pourquoi l’implémentation d’un CDN est fortement recommandée, non seulement pour les sites à audience internationale ou multilingue, mais également pour les sites nationaux qui souhaitent garantir une expérience utilisateur optimale, même en période de forte affluence ou depuis des connexions mobiles moins performantes.

L’impact indirect sur l’expérience utilisateur (UX)

Le temps de chargement d’un site, partiellement conditionné par l’emplacement physique du serveur, joue un rôle important dans la perception qu’un visiteur aura de votre site. À ce niveau, l’expérience utilisateur (UX) devient un facteur clé, non seulement en matière de satisfaction, mais aussi dans le cadre de l’optimisation pour les moteurs de recherche.

Il est bien établi que les internautes s’attendent aujourd’hui à des pages qui se chargent instantanément. Plusieurs études (Google, Akamai, Pingdom…) ont montré qu’un retard de plus de 2 à 3 secondes dans l’affichage principal d’une page peut entraîner une hausse relative du taux de rebond et une baisse possible du taux de conversion. Cette impatience numérique touche d’autant plus les utilisateurs mobiles, où les conditions réseau sont souvent moins favorables.

Pour accompagner cette tendance, Google a introduit dans ses algorithmes les Core Web Vitals, des indicateurs de performance orientés UX. Voici les seuils de référence officiellement recommandés :

- Largest Contentful Paint (LCP) : le contenu principal d’une page doit s’afficher en moins de 2,5 secondes ;

- First Input Delay (FID) : le site doit répondre aux premières interactions en moins de 100 ms ;

- Cumulative Layout Shift (CLS) : les décalages visuels ne doivent pas dépasser un score de 0,1.

Un serveur mal positionné géographiquement, en particulier s’il ne bénéficie pas de cache applicatif, de CDN ou d’optimisation réseau, peut allonger le TTFB (Time To First Byte), ralentir le LCP et introduire une latence ressentie par l’utilisateur. En conséquence, l’expérience globale peut s’en trouver dégradée, ce qui pourrait influencer indirectement le positionnement du site dans les résultats de recherche.

Mais il est essentiel de relativiser cet impact. Nous avons toujours constaté chez Facem Web que les signaux UX, bien qu’intégrés aux algorithmes, sont secondaires par rapport au contenu, au backlinking et à la pertinence sémantique. En d’autres termes, un site légèrement lent mais extrêmement pertinent sur le plan éditorial continuera de bien se positionner sur ses requêtes principales, tant que les temps de chargement ne deviennent pas pénalisants à l’extrême.

De plus, les signaux comportementaux tels que le taux de rebond, le temps passé sur le site ou le nombre de pages vues ne sont pas des critères de classement directs dans l’algorithme de Google. Ils peuvent cependant être interprétés comme des signaux faibles contribuant à évaluer la satisfaction de l’utilisateur, ce qui influence parfois la réévaluation d’une page ou d’un domaine à moyen terme.

Il est donc important de distinguer deux aspects :

- L’impact réel sur le SEO (classement, visibilité dans la SERP), qui reste modéré, voire négligeable si le contenu est de qualité et que le site reste globalement fonctionnel ;

- L’impact sur l’expérience perçue par l’utilisateur, qui peut avoir des effets tangibles sur les conversions, les leads, le taux de fidélisation ou la perception globale de la marque.

En résumé, un serveur éloigné géographiquement peut avoir un effet sur certains indicateurs de performance (TTFB, LCP), qui eux-mêmes peuvent influencer l’expérience utilisateur. Mais ce n’est pas un facteur bloquant pour le référencement naturel tant que le site reste accessible, fonctionnel et pertinent. L’expérience utilisateur, bien qu’importante, reste souvent surestimée comme levier direct de SEO. Elle doit être considérée comme un élément d’un ensemble, au même titre que la qualité éditoriale, la stratégie de netlinking ou l’optimisation technique globale du site.

0 commentaires