Autrefois, il suffisait parfois de répéter un mot-clé des dizaines de fois sur une page pour obtenir une place de choix dans les résultats des moteurs de recherche. Cette méthode, connue sous le nom de keyword stuffing, a longtemps été exploitée par les spécialistes du référencement à une époque où les algorithmes étaient plus simples, moins nuancés. Aujourd’hui, les choses ont bien changé, et cette pratique autrefois répandue est désormais considérée comme pénalisante. Pour mieux comprendre cette évolution, examinons les origines du keyword stuffing, les raisons de son déclin, et ce que les moteurs de recherche privilégient désormais.

Les débuts du keyword stuffing et son fonctionnement en SEO

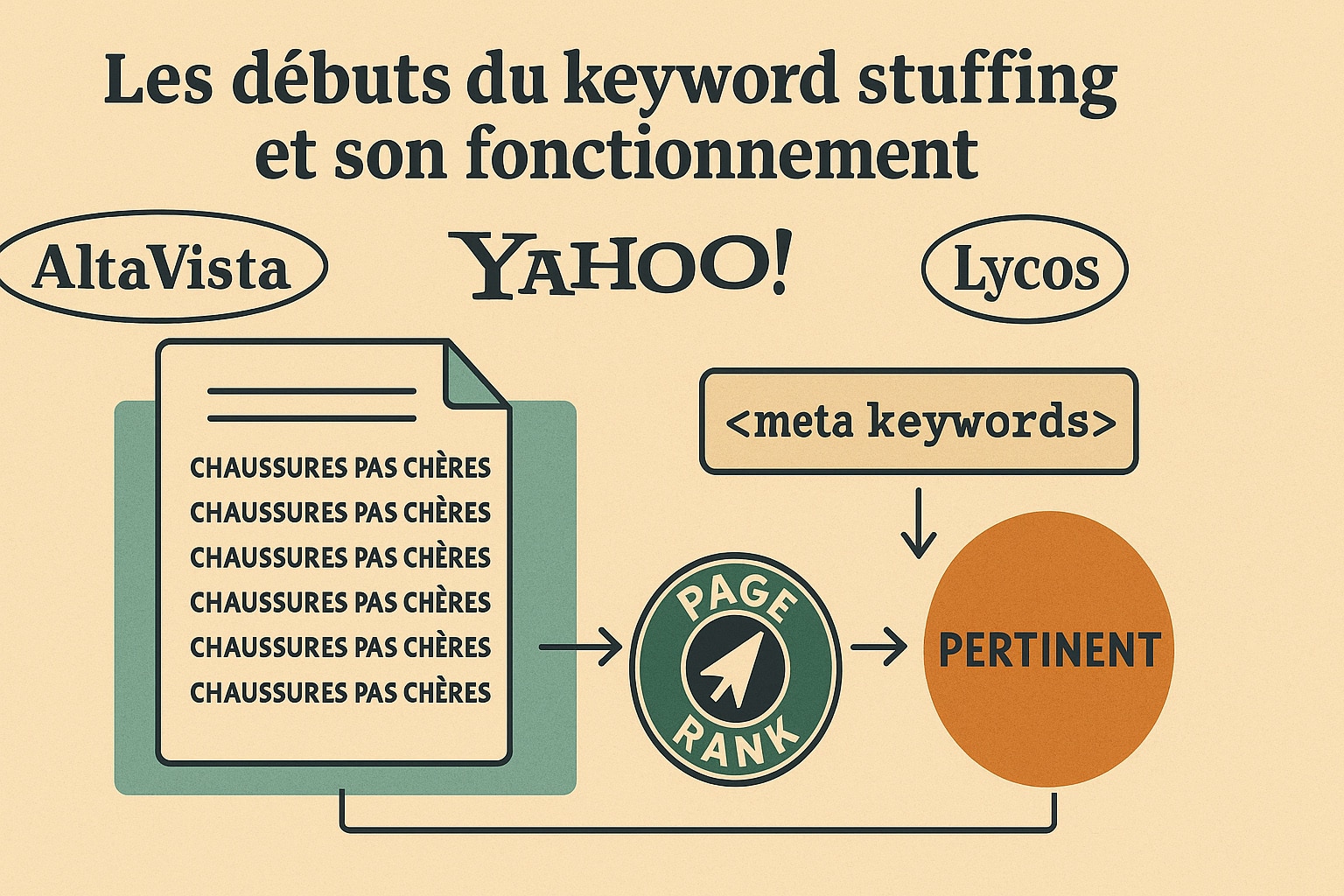

Pour comprendre l’origine du keyword stuffing, il faut remonter aux premières années du référencement naturel, dans les années 1990. À cette époque, le web était encore jeune, les moteurs de recherche balbutiants, et les règles du jeu très peu définies. AltaVista, Yahoo! ou encore Lycos dominaient alors le paysage de la recherche en ligne, bien avant que Google ne s’impose comme l’acteur majeur du secteur. Ces premiers moteurs se basaient essentiellement sur des critères très simples pour classer les pages : la présence des mots-clés recherchés dans le contenu, les balises meta ou encore les titres de page. L’algorithme n’avait ni subtilité ni intelligence contextuelle. Il opérait une lecture littérale des pages, sans réelle capacité à distinguer qualité éditoriale et répétition mécanique. Dans ce contexte naissant, le keyword stuffing s’est imposé comme une technique à la fois rudimentaire et efficace. Le principe était simple : plus un mot-clé apparaissait sur une page, plus le moteur de recherche considérait cette page comme pertinente. Cette méthode a été exploitée massivement par les pionniers du SEO dès la fin des années 90. Elle était enseignée dans les premiers forums spécialisés, partagée dans des ebooks et popularisée par les premiers consultants en référencement, comme Bruce Clay ou Danny Sullivan, qui ont ensuite dénoncé ces méthodes lorsqu’elles ont commencé à nuire à la qualité du web.

On voyait alors des pages entièrement construites autour d’un seul mot ou groupe de mots, répétés à l’excès dans chaque paragraphe. Dans certains cas, les webmasters n’hésitaient pas à insérer des blocs de texte invisible à l’utilisateur – écrit en blanc sur fond blanc, ou réduit à une taille de police minuscule – pour « bourrer » la page de mots-clés sans nuire à l’apparence du contenu à l’écran. D’autres profitaient des balises HTML comme la balise <meta keywords>, aujourd’hui abandonnée par la plupart des moteurs, pour y insérer des listes de centaines de termes espérant couvrir un maximum de requêtes. À titre d’exemple, un site vendant des chaussures pouvait se retrouver avec une page contenant des centaines de variations comme : “chaussures pas chères”, “acheter chaussures”, “chaussures de sport”, “chaussures hommes pas cher”, “chaussures livraison gratuite”, etc., parfois sans aucun enchaînement logique. Ces pages étaient générées automatiquement à l’aide de scripts ou de logiciels dédiés, comme WebPosition Gold ou TrafficSeeker, qui permettaient de « travailler » son SEO de manière industrielle.

Ce phénomène était mondial, mais certaines régions ont vu émerger des « écoles » de SEO très agressives. Aux États-Unis, la Silicon Valley a vu naître les premiers consultants SEO qui jonglaient entre pratiques techniques et expérimentations limites. En Russie, des plateformes comme Yandex ont également été confrontées à cette dérive. En France, le phénomène a pris une ampleur particulière avec la montée de sites MFA (Made For Adsense), dont le modèle reposait entièrement sur le trafic généré par des pages saturées de mots-clés et de publicités.

Le keyword stuffing faisait alors partie d’un ensemble plus large de techniques dites de “black hat SEO”, c’est-à-dire des méthodes contraires aux consignes des moteurs, visant uniquement à tromper l’algorithme pour obtenir un meilleur classement. Parmi ces techniques, on trouvait également le cloaking (présenter un contenu différent au moteur et à l’utilisateur), les fermes de liens, ou encore le contenu dupliqué en masse. Le bourrage de mots-clés, bien que simpliste, était l’une des tactiques les plus utilisées car elle ne nécessitait aucune compétence technique poussée. Mais cette stratégie avait un prix : elle nuisait considérablement à l’expérience utilisateur. Les contenus devenaient illisibles, déshumanisés, écrits uniquement pour les robots. Les internautes, en quête d’informations claires ou de réponses précises, se retrouvaient face à des blocs de texte dénués de sens, truffés de répétitions inutiles. Cette dégradation qualitative du web a rapidement alerté les moteurs de recherche.

Avec l’émergence de Google au tournant des années 2000, la donne a commencé à changer. L’entreprise californienne, fondée par Larry Page et Sergey Brin, a bâti son moteur sur un principe innovant : Le PageRank. Ce système d’évaluation s’appuyait sur la qualité et la quantité de liens pointant vers une page, offrant ainsi une alternative à la simple répétition de mots. Si le keyword stuffing a continué d’exister plusieurs années encore, son efficacité a peu à peu décliné à mesure que Google et les autres moteurs ont raffiné leurs algorithmes, intégrant des signaux de plus en plus fins pour juger de la pertinence d’un contenu.

Comment les moteurs de recherche ont réagi au keyword stuffing

Face à la prolifération du keyword stuffing et à l’altération massive de la qualité des résultats de recherche, les moteurs ont dû réagir pour préserver leur mission première : offrir aux internautes des réponses pertinentes, utiles et accessibles. Cette transition ne s’est pas faite du jour au lendemain. Il a fallu plusieurs années d’évolution algorithmique, de tests grandeur nature et de retours utilisateurs pour que les moteurs deviennent capables de discerner le contenu manipulé du contenu réellement qualitatif. Parmi eux, Google s’est rapidement imposé comme le moteur le plus actif et le plus innovant dans la lutte contre les abus sémantiques. Dans les années 2000, Google a commencé à intégrer des filtres manuels pour repérer les pratiques jugées contraires à ses consignes aux webmasters. Cependant, ces actions restaient ponctuelles et limitées dans leur portée. Le véritable tournant est survenu avec l’introduction de mises à jour algorithmiques d’envergure, qui ont profondément bouleversé le fonctionnement du référencement naturel et rendu le keyword stuffing obsolète.

La première grande rupture a eu lieu en 2011 avec le déploiement de Google Panda. Cette mise à jour, baptisée du nom de l’ingénieur Navneet Panda, visait à abaisser le classement des sites de faible qualité, notamment ceux dont les contenus étaient dupliqués, peu informatifs ou excessivement optimisés. Panda s’attaquait directement aux fermes de contenu et aux pages créées uniquement pour manipuler les classements, souvent truffées de mots-clés sans réelle valeur ajoutée. Il s’agissait d’une offensive majeure contre les méthodes « black hat », y compris le keyword stuffing, qui ne garantissaient ni lisibilité ni pertinence. Deux ans plus tard, en 2013, Google a introduit une nouvelle étape dans cette évolution avec Google Hummingbird, une mise à jour fondée sur la compréhension du langage naturel. Contrairement aux précédents filtres qui se concentraient sur la pénalisation, Hummingbird a redéfini la façon dont le moteur comprenait les requêtes. Il ne s’agissait plus de faire correspondre une requête mot pour mot avec une page, mais d’en interpréter l’intention réelle. Cela a entraîné une reconnaissance bien plus fine des synonymes, des reformulations et des expressions connexes, rendant les répétitions mécaniques inutiles, voire contre-productives.

En parallèle, Google a développé son système d’intelligence artificielle, avec notamment RankBrain dès 2015, puis BERT en 2019. Ces technologies ont permis d’analyser les relations entre les mots dans une phrase et de mieux comprendre le contexte global d’un contenu. Résultat : une page bien écrite, fluide et orientée vers l’utilisateur pouvait surpasser une page artificiellement optimisée autour d’un mot-clé répété. Ces évolutions ont permis de :

- Détecter les usages abusifs de mots-clés grâce à l’analyse sémantique et au traitement du langage naturel ;

- Pénaliser les pages utilisant le keyword stuffing de manière évidente, qu’il s’agisse de sur-optimisation dans le texte visible ou dans le code HTML ;

- Favoriser la contextualisation des contenus, en tenant compte des synonymes, cooccurrences, champs lexicaux et expressions associées.

Mais les progrès ne se sont pas limités à l’algorithme. Google a également renforcé sa communication avec les créateurs de contenu, via la Search Console, les guidelines de qualité, et des documents comme le Search Quality Evaluator Guidelines, où l’on retrouve des concepts-clés comme EEAT (Expérience, Expertise, Autorité, Fiabilité). Ces critères, bien qu’indirectement liés à la lutte contre le keyword stuffing, encouragent une approche qualitative et humaine du contenu, loin des manipulations techniques des débuts. En d’autres termes, les moteurs ne se contentent plus de compter les occurrences d’un mot-clé. Ils évaluent désormais la qualité globale du contenu : pertinence par rapport à l’intention de recherche, structure logique, clarté rédactionnelle, fiabilité des sources, et expérience offerte à l’utilisateur. Ils cherchent à comprendre si le contenu répond réellement à une question ou s’il tente simplement de « forcer » son référencement à travers une sur-optimisation.

Cette transformation a profondément redéfini les pratiques SEO. Le métier de référenceur, autrefois très axé sur les métriques et les répétitions stratégiques, s’est enrichi d’une dimension éditoriale forte. Le SEO est ainsi passé d’une mécanique technique à une discipline plus orientée vers la valeur éditoriale, l’intention de recherche et l’authenticité du contenu. Aujourd’hui, un bon positionnement dépend moins d’un mot-clé répété que de la capacité à informer, rassurer et engager un lecteur humain.

Les bonnes pratiques actuelles en matière de mots-clés

Dans le paysage actuel du référencement naturel, le mot-clé garde bien entendu toute son importance. Il constitue toujours le point d’ancrage d’une stratégie SEO efficace, puisqu’il permet de relier un contenu à une requête précise formulée par un internaute. Toutefois, son usage ne peut plus être mécanique ni isolé : il s’inscrit désormais dans une approche globale orientée vers la compréhension fine de l’intention de recherche et la qualité du contenu. Fini les listes de termes plaqués à répétition ; place à une sémantique riche, à la pertinence contextuelle et à une rédaction pensée pour les lecteurs. La logique actuelle repose sur l’idée que chaque page doit répondre à un besoin précis. Il ne s’agit donc plus simplement d’optimiser des occurrences, mais de construire un environnement thématique cohérent, aligné sur les attentes des utilisateurs et sur la terminologie naturelle qu’ils utilisent dans leurs recherches. Les algorithmes étant désormais capables de reconnaître les paraphrases, synonymes, reformulations et relations sémantiques, il devient inutile (et même risqué) de répéter à l’excès une même expression-clé.

Cette évolution a transformé les bonnes pratiques en matière de mots-clés. Elles vont bien au-delà de la simple insertion d’un terme dans une balise meta ou un titre de page : Elles englobent une vision stratégique, éditoriale et structurelle du contenu web. Voici quelques recommandations essentielles pour tirer parti des mots-clés tout en évitant les pièges de la sur-optimisation :

| Bonnes pratiques | Explication |

|---|---|

| Rédiger pour les utilisateurs | Le contenu doit répondre à une question, résoudre un problème ou fournir une information claire et utile. Il doit s’adresser à une audience humaine, avec un ton adapté et une structure engageante. |

| Varier le champ lexical | Utiliser des synonymes, expressions équivalentes et termes proches pour enrichir la sémantique. Par exemple, si le mot-clé est « formation en ligne », il est judicieux d’y associer des termes comme « cours à distance », « enseignement numérique » ou « apprentissage en ligne ». |

| Insérer naturellement le mot-clé | Le mot-clé principal peut apparaître dans le titre, l’introduction, un ou deux sous-titres, et de manière fluide dans le texte. Il doit être intégré dans un contexte logique, sans forcer la formulation des phrases. |

| Optimiser sans surcharger | Éviter les répétitions excessives. Une densité autour de 1 % est souvent suffisante, voire moins si le texte est long. L’important est que le mot-clé apparaisse suffisamment pour signaler la thématique, sans nuire à la lisibilité. |

| Structurer le contenu | Hiérarchiser avec des titres (H1, H2, H3), paragraphes courts, listes, et tableaux pour favoriser la lisibilité. Cela permet aussi aux moteurs de mieux analyser la logique du contenu et sa pertinence. |

| Travailler l’intention de recherche | Identifier si la requête est informationnelle, transactionnelle ou navigationnelle, et adapter le type de contenu en conséquence. Un mot-clé comme « meilleure assurance auto » implique une approche comparative, tandis que « assurance auto définition » appelle une approche explicative. |

| Soigner le contenu autour du mot-clé | Au-delà du mot-clé lui-même, il faut penser à tout le contenu environnant : les exemples concrets, les chiffres, les références, les cas d’usage… Autant d’éléments qui renforcent la légitimité du contenu. |

| Optimiser les éléments annexes | Le mot-clé peut aussi apparaître dans l’URL, la meta-description, les attributs alt des images ou encore l’ancre des liens internes, à condition que cela reste pertinent. |

Un contenu bien positionné de nos jours est avant tout un contenu utile, bien structuré, et pertinent pour une intention de recherche donnée. Les moteurs de recherche sont devenus des outils d’interprétation plus que de simple indexation : ils cherchent à comprendre si votre page constitue une réponse fiable, claire et complète à une requête réelle.

Il ne s’agit donc plus de plaire uniquement aux robots d’indexation, mais bien d’apporter une valeur concrète à l’utilisateur final. La réussite d’une stratégie de mots-clés repose désormais sur l’équilibre : un mot-clé bien choisi, intelligemment intégré, et soutenu par un contenu solide, sincère et bien rédigé. Cette approche contribue non seulement à un bon positionnement, mais aussi à renforcer la crédibilité de votre site sur le long terme.

0 commentaires