Alors que les outils d’intelligence artificielle deviennent de plus en plus intégrés à notre quotidien numérique, il devient important de comprendre les mécanismes sous-jacents qui permettent à ces technologies d’interagir avec le web. OpenAI, l’un des leaders de l’IA générative, utilise différents types de crawlers (également appelés robots ou agents utilisateurs) pour répondre à des besoins variés : affichage dans les résultats de recherche, interaction via ChatGPT ou encore collecte de données pour l’entraînement de modèles. Chacun de ces robots est conçu avec une finalité bien précise, et il est possible pour les webmasters de gérer leur interaction avec ces agents grâce au fichier robots.txt. Dans cet article, explorons ensemble les différents crawlers utilisés par OpenAI, leur rôle respectif et la manière dont les propriétaires de sites peuvent contrôler leur comportement.

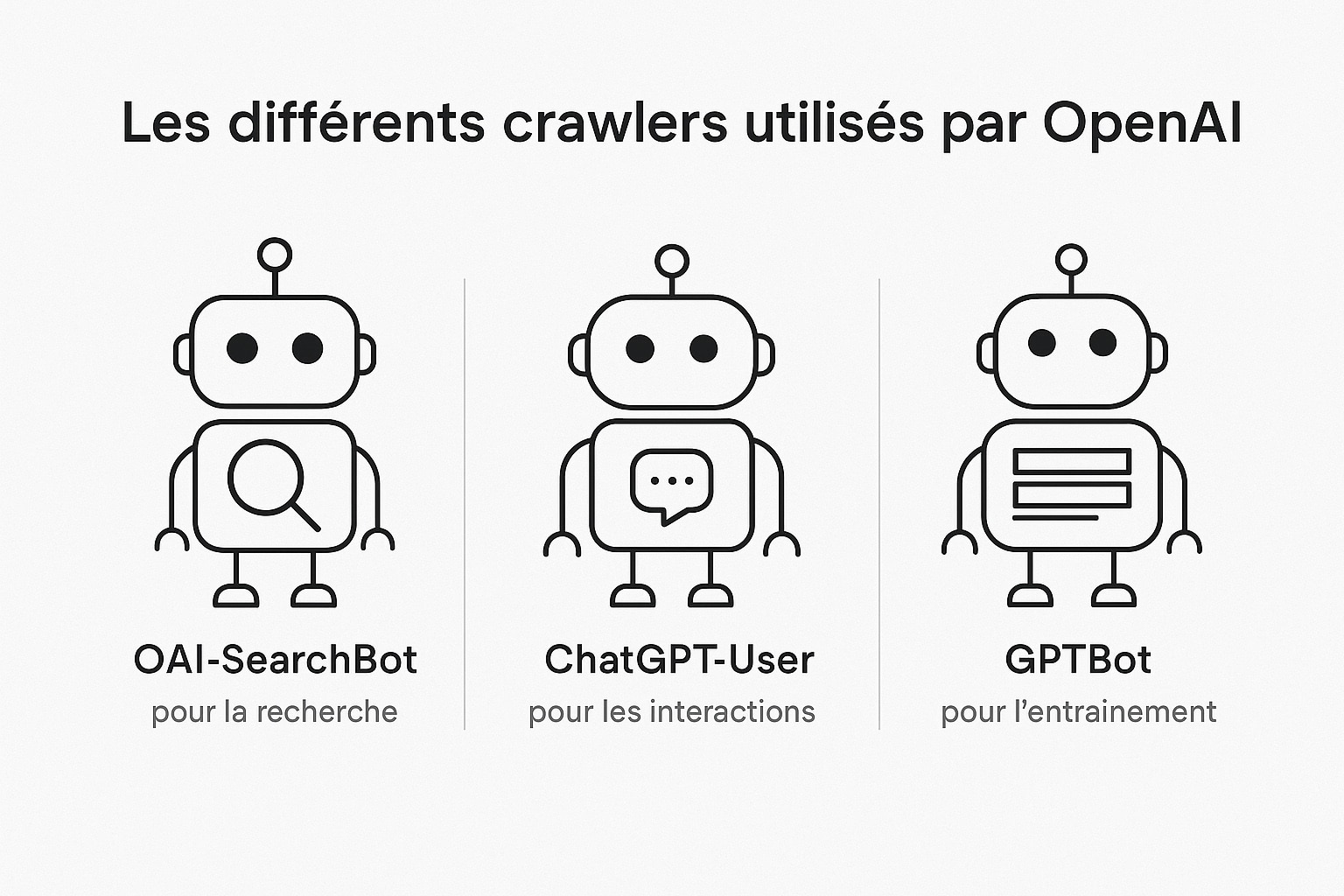

Les différents crawlers utilisés par OpenAI

OpenAI utilise trois agents utilisateurs principaux (également appelés crawlers ou bots) qui remplissent des fonctions bien distinctes au sein de l’écosystème d’intelligence artificielle de l’entreprise. Ces agents ne sont pas interchangeables et leur comportement est dicté par des règles précises. Il est donc essentiel, surtout pour les webmasters, éditeurs et professionnels du référencement, de comprendre ce que fait chacun de ces crawlers pour pouvoir gérer intelligemment leur interaction avec les sites web. Voici une présentation détaillée de chacun de ces agents utilisateurs :

| Agent utilisateur | Description et objectif |

|---|---|

| OAI-SearchBot | OAI-SearchBot est le crawler dédié à la recherche dans l’univers OpenAI. Il est spécifiquement conçu pour découvrir et indexer des contenus qui seront ensuite affichés dans les résultats de recherche proposés par les produits OpenAI, en particulier ChatGPT avec ses fonctions de navigation ou de réponse enrichie. Contrairement à ce que certains pourraient penser, OAI-SearchBot ne collecte pas les données des sites visités dans le but d’entraîner les modèles d’IA. Sa mission est purement centrée sur l’affichage de liens et d’extraits dans des interfaces conversationnelles ou de recherche. Cela signifie qu’un site peut tout à fait accepter que ses contenus soient référencés dans les résultats de ChatGPT sans pour autant autoriser leur usage à des fins d’entraînement d’algorithmes. Le crawler utilise une chaîne d’agent complète qui inclut OAI-SearchBot/1.0 et pointe vers https://openai.com/searchbot pour plus d’informations. Pour être certain d’apparaître dans les résultats de recherche, il est conseillé aux administrateurs de site d’ajouter une règle d’autorisation explicite dans leur fichier robots.txt et de vérifier que les adresses IP associées à ce bot sont bien acceptées. |

| ChatGPT-User | ChatGPT-User représente un type de requête très spécifique : il ne s’agit pas ici d’un crawler automatique, mais plutôt d’un agent utilisateur déclenché par l’interaction directe d’un utilisateur avec ChatGPT ou avec une instance personnalisée (GPT personnalisé). Lorsqu’un utilisateur pose une question dans ChatGPT, il peut arriver que le modèle tente de récupérer des informations supplémentaires sur le web pour répondre plus précisément ou pour actualiser ses réponses avec des données récentes. Dans ce cas, ChatGPT peut visiter une page web en utilisant l’agent ChatGPT-User. L’action est ponctuelle, contextuelle, et dépendante de la requête de l’utilisateur. Par exemple, si un utilisateur demande les horaires d’un événement ou des détails sur un site e-commerce, ChatGPT-User peut visiter ces pages pour fournir une réponse actualisée. Cette capacité d’exploration à la demande diffère d’un crawling classique et ne vise ni l’indexation globale du site ni l’usage des contenus pour entraîner des modèles. Le user-agent est reconnaissable avec une chaîne du type : Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko); compatible; ChatGPT-User/1.0; +https://openai.com/bot. Les IP utilisées sont également publiées pour plus de transparence (chatgpt-user.json). |

| GPTBot | GPTBot est probablement le crawler le plus sensible pour les webmasters. Il s’agit du robot utilisé pour parcourir le web afin de collecter des contenus susceptibles d’être intégrés dans les ensembles de données servant à entraîner les modèles d’intelligence artificielle développés par OpenAI, comme GPT-4 et les versions futures. GPTBot opère selon un principe de crawl actif, ce qui signifie qu’il explore régulièrement et automatiquement de vastes portions du web pour analyser et stocker des contenus textuels. Ces données, une fois collectées, peuvent ensuite être utilisées dans le cadre de l’entraînement des modèles d’IA générative. Cela implique une lecture approfondie des pages visitées, dans le but d’extraire des exemples de langage, de styles, de contextes et d’informations factuelles. Toutefois, GPTBot respecte les directives du fichier robots.txt. Si un site souhaite explicitement ne pas être inclus dans les données d’entraînement, il peut refuser l’accès à GPTBot à l’aide de la directive Disallow: /. Ce choix n’a aucune incidence sur les deux autres agents (OAI-SearchBot et ChatGPT-User), qui peuvent toujours être autorisés ou bloqués indépendamment.La chaîne d’agent typique de GPTBot est : Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko); compatible; GPTBot/1.1; +https://openai.com/gptbot, et la liste des adresses IP est accessible à cette adresse : gptbot.json. |

Chacun de ces bots répond donc à une logique bien définie. Le fait qu’ils puissent être contrôlés séparément permet aux administrateurs de sites de moduler leur stratégie de visibilité et de partage de données. Il est par exemple tout à fait possible d’être présent dans les résultats de recherche de ChatGPT tout en refusant que son contenu soit utilisé pour entraîner des IA génératives. Cette granularité de contrôle est une réponse directe aux préoccupations croissantes sur la propriété du contenu et son usage dans l’intelligence artificielle.

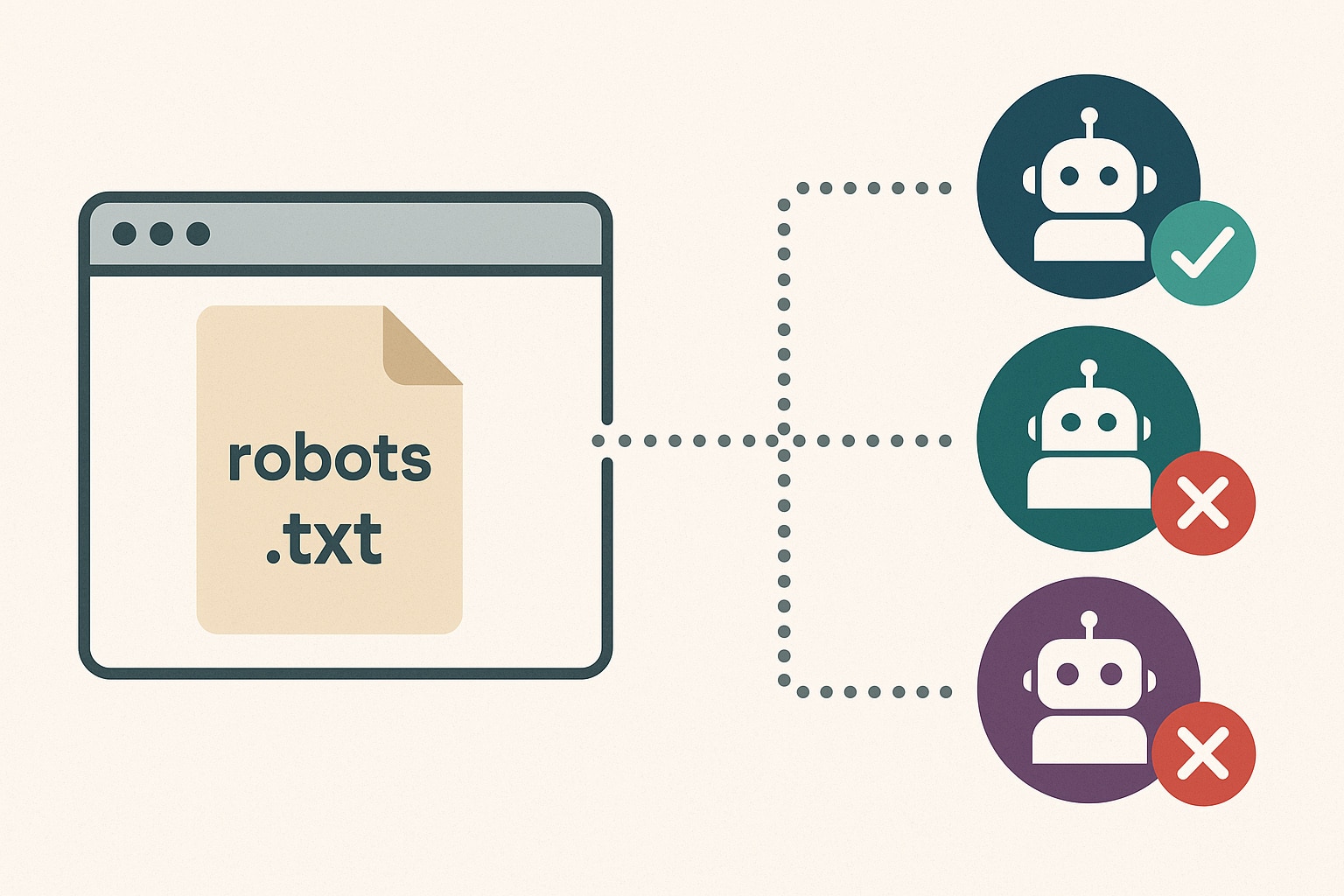

Comment contrôler l’accès de ces agents à votre site web

OpenAI a mis en place une politique claire et modulable permettant aux administrateurs de sites web de décider avec précision comment leurs contenus peuvent interagir avec les différents agents utilisateurs (ou crawlers) de l’entreprise. Cette gestion repose sur un outil bien connu des professionnels du web : le fichier robots.txt. Ce fichier texte, placé à la racine d’un site (ex : https://votresite.com/robots.txt), est interprété par les robots d’indexation pour déterminer s’ils sont autorisés à accéder à tout ou partie du site. Ce qui distingue la stratégie d’OpenAI, c’est que chacun de ses crawlers est traité comme un agent distinct, identifiable par un nom unique dans le fichier robots.txt. Cette séparation permet un contrôle extrêmement fin de l’accès aux contenus : vous pouvez ainsi autoriser un robot à des fins de référencement (OAI-SearchBot), tout en bloquant un autre qui servirait à collecter des données pour entraîner des modèles d’intelligence artificielle (GPTBot), ou encore empêcher les visites déclenchées à la demande des utilisateurs de ChatGPT (ChatGPT-User).

Voici quelques exemples concrets de configurations :

# Autoriser uniquement OAI-SearchBot (pour apparaître dans les résultats de recherche)

User-agent: OAI-SearchBot

Allow: /

User-agent: GPTBot

Disallow: /

User-agent: ChatGPT-User

Disallow: /

# Bloquer uniquement GPTBot (empêche l'entraînement de l'IA sur vos contenus)

User-agent: GPTBot

Disallow: /

# Autoriser tous les agents d’OpenAI (accès total aux contenus)

User-agent: OAI-SearchBot

Allow: /

User-agent: GPTBot

Allow: /

User-agent: ChatGPT-User

Allow: /

# Interdire tous les agents OpenAI (aucun accès)

User-agent: OAI-SearchBot

Disallow: /

User-agent: GPTBot

Disallow: /

User-agent: ChatGPT-User

Disallow: /

Ces exemples montrent à quel point la gestion de l’accès est souple. Vous pouvez même configurer des règles spécifiques pour différentes sections de votre site. Par exemple, vous pourriez autoriser GPTBot à accéder uniquement à un dossier public, tout en lui interdisant l’accès au reste :

# GPTBot peut explorer uniquement /public/

User-agent: GPTBot

Disallow: /

Allow: /public/

Il faut toutefois garder en tête que le fichier robots.txt est un protocole volontairement respecté par les robots bienveillants. OpenAI, en tant qu’acteur responsable, respecte pleinement ces directives. Cependant, ce fichier n’est pas un outil de sécurité en soi : il n’empêche pas techniquement l’accès à une ressource si celle-ci est publiquement accessible. Il sert à indiquer une intention claire de la part du webmaster, que les robots d’indexation suivent conformément à leurs standards. Une fois que vous modifiez ou ajoutez des règles dans le fichier robots.txt, il peut s’écouler environ 24 heures avant que ces changements soient pris en compte par les systèmes d’OpenAI. Ce délai s’explique par les cycles de mise à jour et de validation des robots, qui consultent régulièrement les fichiers robots.txt des domaines qu’ils visitent. Pour optimiser cette gestion, il est recommandé de :

- Vérifier l’emplacement et l’accessibilité de votre fichier

robots.txt; - Tenir une documentation interne de vos choix de configuration pour les différents bots ;

- Mettre à jour le fichier en cas de changement dans votre politique de partage de contenu ;

- Effectuer des tests pour s’assurer que les règles s’appliquent comme prévu.

Une autre bonne pratique consiste à surveiller les journaux de serveur (logs) afin d’identifier quels bots visitent votre site, avec quelles fréquences, et sur quelles pages. Cela peut vous permettre de vérifier que vos consignes sont bien respectées et d’ajuster vos règles si nécessaire. Enfin, en plus des directives du fichier robots.txt, les agents d’OpenAI se basent également sur des plages d’adresses IP bien définies pour garantir que les requêtes proviennent bien de leurs systèmes. Même si ce paramètre est davantage technique, il permet aux administrateurs réseaux d’identifier et de filtrer les accès selon leurs besoins, notamment dans les environnements sensibles ou à fort enjeu de confidentialité.

Ainsi, OpenAI offre un modèle d’interaction responsable et modulable avec les contenus web. Grâce à une bonne configuration du fichier robots.txt, chaque site peut décider dans quelle mesure il souhaite collaborer avec les technologies d’intelligence artificielle d’OpenAI, que ce soit pour améliorer la visibilité de ses pages, faciliter l’assistance aux utilisateurs via ChatGPT, ou participer à l’évolution des modèles d’IA à travers le partage de contenu.

Quelques bonnes pratiques pour gérer OAI-SearchBot, ChatGPT-User & GPTBot

La façon dont vous autorisez ou non l’accès des crawlers d’OpenAI à votre site web ne devrait jamais être laissée au hasard. Elle doit s’inscrire dans une réflexion stratégique globale, à la croisée du référencement, de la gestion des droits sur les contenus et de la politique de partage de données. Ces choix auront un impact non seulement sur votre visibilité dans des interfaces conversationnelles comme ChatGPT, mais également sur l’usage que pourrait faire OpenAI de vos données dans le cadre du développement de ses technologies.Pour déterminer la meilleure configuration possible, il convient d’adopter une approche nuancée. Le type de contenu que vous proposez, votre modèle économique, la sensibilité des informations publiées ou encore vos relations avec les technologies d’IA sont autant de paramètres à prendre en compte. Voici plusieurs conseils pratiques pour affiner votre stratégie :

- Identifiez les sections de votre site à protéger ou à valoriser : Tous les contenus n’ont pas le même niveau de sensibilité ni la même vocation. Par exemple, des articles de blog informatifs peuvent être bénéfiques s’ils apparaissent dans les résultats de recherche d’un outil d’IA, tandis qu’une base de données propriétaire, des ressources payantes ou des contenus contractuels ne devraient pas être exposés aux bots d’indexation ou de collecte ;

- Faites évoluer votre stratégie en fonction des usages réels observés : Surveillez les logs serveur et les statistiques d’accès pour identifier les passages des bots d’OpenAI. Cela vous permettra de mieux comprendre leur comportement, leur fréquence de passage et d’ajuster vos permissions si nécessaire. Par exemple, un pic d’activité du ChatGPT-User peut révéler une forte interaction utilisateur avec vos contenus via GPTs personnalisés ;

- Considérez l’impact indirect sur votre image de marque : Être présent dans les réponses fournies par une IA conversationnelle peut accroître la notoriété de votre site, à condition que les contenus soient bien contextualisés. À l’inverse, si vous jugez que des extraits mal interprétés peuvent nuire à votre discours éditorial, vous pouvez préférer restreindre l’accès à certains crawlers ;

- Évitez une approche « tout ou rien » : Le fichier

robots.txtpermet une gestion granulaire : vous pouvez autoriser ou interdire l’accès à des parties précises de votre site à différents bots. Ainsi, il est tout à fait possible de permettre à OAI-SearchBot de référencer votre blog tout en bloquant GPTBot sur vos pages commerciales ou de documentation interne ; - Impliquez les parties prenantes internes : Les décisions relatives à l’ouverture ou la restriction aux crawlers doivent être prises en concertation avec les équipes concernées : marketing, juridique, produit, informatique… Chacune pourra apporter une lecture complémentaire sur les risques ou opportunités liés à la diffusion ou la réutilisation de certains contenus ;

- Restez informé des évolutions du comportement des bots : OpenAI fait évoluer ses agents utilisateurs en fonction des besoins de ses produits. De nouvelles fonctionnalités peuvent modifier la manière dont les bots interagissent avec le web. Une veille régulière sur la documentation publique d’OpenAI peut vous aider à anticiper ces changements.

Enfin, il peut être utile de documenter toutes vos configurations dans un guide interne destiné aux administrateurs ou aux développeurs. Cela garantit une cohérence dans le temps, surtout si plusieurs intervenants modifient les règles d’accès ou si vous gérez plusieurs domaines.

À mesure que l’intelligence artificielle devient un intermédiaire fréquent entre les internautes et l’information, les sites web ne peuvent plus se contenter d’exister passivement sur le web. Ils doivent choisir dans quelles conditions ils souhaitent apparaître, être analysés ou même inspirer les algorithmes qui façonneront les réponses de demain. Ces choix doivent être faits en toute conscience, avec un équilibre entre ouverture, maîtrise et responsabilité.

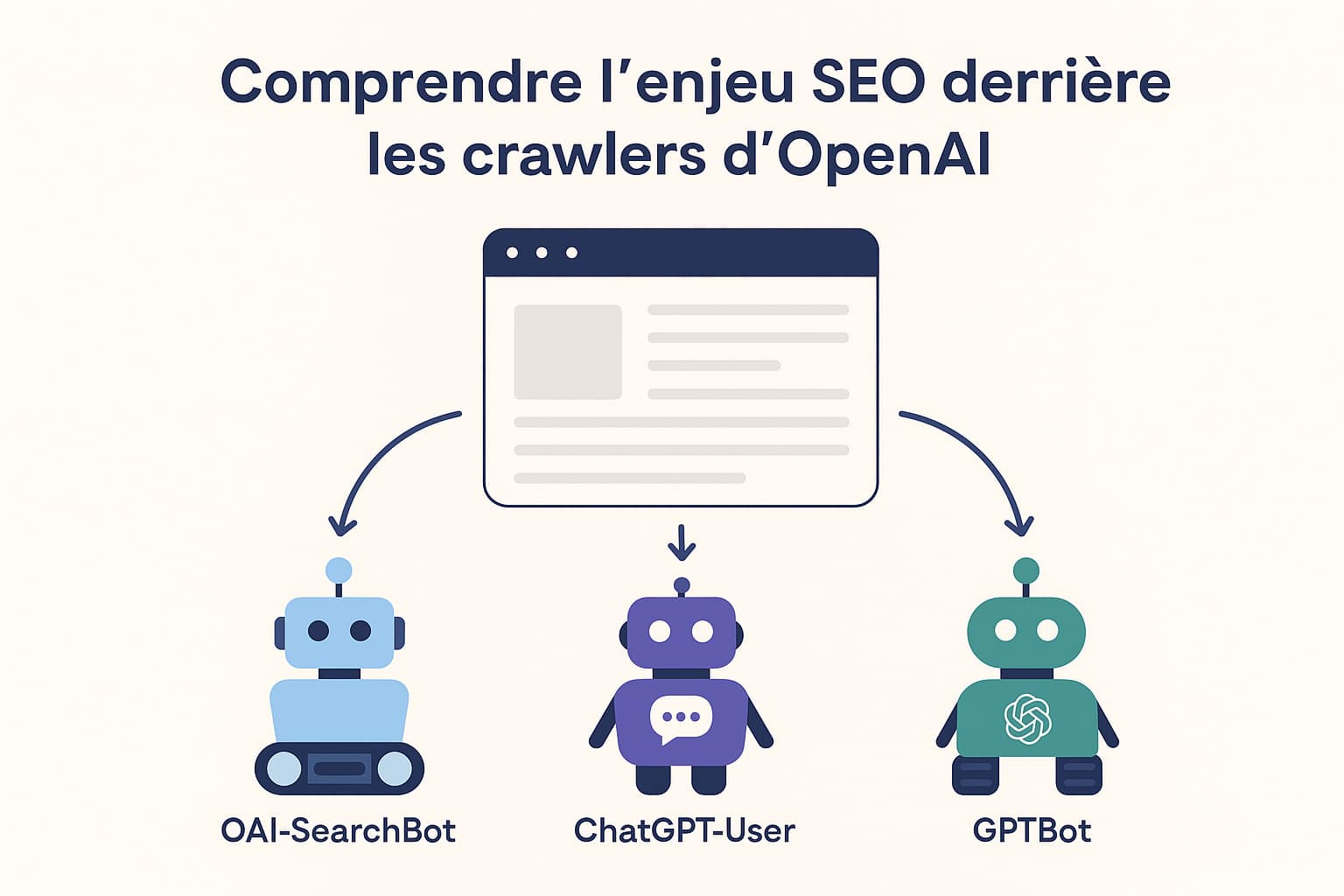

Comprendre l’enjeu SEO derrière les crawlers d’OpenAI

Si les agents utilisateurs d’OpenAI sont avant tout perçus comme des outils techniques, ils introduisent aussi une nouvelle forme de visibilité pour les sites web dans l’écosystème de l’intelligence artificielle. Avec l’émergence des moteurs conversationnels comme ChatGPT et des interfaces enrichies qui proposent directement des liens vers des contenus externes, une nouvelle dimension du référencement naturel voit le jour : le SEO conversationnel. Et dans ce cadre, comprendre comment fonctionnent les crawlers d’OpenAI devient une étape essentielle pour positionner ses contenus dans ces nouvelles sources de trafic.

En effet, la manière dont votre site est exploré par OAI-SearchBot, ou accessible via ChatGPT-User, influence directement vos chances d’être visible dans les réponses générées par ChatGPT. Contrairement aux moteurs de recherche traditionnels, où les résultats sont organisés dans une page dédiée (SERP), ici les liens sont intégrés à des réponses construites, dans un format conversationnel. Le référencement ne repose donc plus uniquement sur des métadonnées ou des balises, mais sur la capacité du contenu à être pertinent, contextualisable et accessible à la demande. Concrètement, cela signifie que :

- Vos contenus doivent être facilement interprétables par une IA, avec une structure claire (titres, paragraphes cohérents, langage naturel) pour maximiser leur réutilisation dans une réponse ;

- Vous devez autoriser

OAI-SearchBotvia votre fichierrobots.txtpour espérer que vos pages soient référencées et proposées dans les fonctionnalités de recherche intégrées à ChatGPT ; - Le temps de chargement, la stabilité des liens et la lisibilité mobile deviennent encore plus déterminants, car ils influencent l’expérience utilisateur indirectement offerte par l’IA lorsqu’elle redirige vers votre site ;

- Le format de vos contenus (FAQ, articles explicatifs, guides pratiques) peut également jouer un rôle dans leur sélection par l’IA, qui privilégie souvent les formats explicatifs ou synthétiques pour répondre à des questions utilisateurs.

De même, les contenus accessibles via ChatGPT-User ne sont pas indexés automatiquement, mais leur lisibilité et leur pertinence peuvent favoriser leur consultation ponctuelle par l’IA lors de requêtes spécifiques. Il est donc recommandé de veiller à la qualité éditoriale de vos pages, y compris dans des sections que vous n’auriez pas spontanément pensées comme « SEO-compatibles », comme des pages produit ou des mentions légales.

Un autre aspect intéressant du SEO via ChatGPT est qu’il est encore peu saturé. Contrairement aux moteurs classiques, où la concurrence est rude sur les premiers résultats, la présence dans une réponse d’IA dépend davantage de la concordance contextuelle entre la demande de l’utilisateur et le contenu de votre page. Cela ouvre des opportunités pour les sites spécialisés, de niche ou très qualitatifs, qui peuvent se démarquer sans nécessairement dominer les classements classiques de Google. Ainsi donc, travailler son SEO pour ChatGPT revient à :

- Assurer une bonne accessibilité technique (robots.txt bien configuré, pas de blocages injustifiés) ;

- Proposer un contenu structuré, clair, et formulé de manière naturelle ;

- Anticiper les questions que se posent les utilisateurs et y répondre de façon directe ;

- Utiliser un balisage HTML propre et sémantique pour aider les crawlers à identifier les informations clés ;

- Éviter le contenu trompeur, dupliqué ou peu fiable, car cela pourrait limiter votre apparition dans les réponses d’IA ;

- Suivre régulièrement les performances de vos pages pour détecter celles qui génèrent du trafic via des outils conversationnels (via UTM ou suivi analytique spécifique).

Cette nouvelle forme de visibilité ne remplace pas le SEO traditionnel, mais elle le complète. Elle invite les créateurs de contenu à penser non seulement pour les moteurs de recherche, mais aussi pour les intelligences artificielles qui deviennent des points de passage incontournables dans l’accès à l’information.

En anticipant cette évolution, vous préparez votre site à capter un trafic qualifié issu des assistants conversationnels et des outils d’IA générative, tout en vous inscrivant dans une logique de transparence, d’utilité et de pertinence éditoriale.

0 commentaires