En référencement naturel, les discussions portent souvent sur les mots-clés, la qualité des contenus ou encore les backlinks. Pourtant, un aspect plus technique, moins visible mais tout aussi essentiel, mérite toute l’attention des spécialistes qu’est l’analyse de logs en SEO. Véritable plongée dans les coulisses de la relation entre un site web et les moteurs de recherche, cette pratique permet de comprendre comment Google explore et interprète vos pages. C’est un outil puissant pour détecter les freins à l’indexation, optimiser le crawl budget et mieux orienter sa stratégie SEO. Plutôt que de se limiter à des suppositions ou à l’observation indirecte via des outils comme la Search Console, l’analyse de logs offre une vision brute et factuelle : Que fait réellement Googlebot (et les autres bots) sur votre site ? Quelles pages explore-t-il, lesquelles ignore-t-il, et à quelle fréquence ? Autant de données précieuses pour quiconque veut aller au-delà des bases du SEO et travailler sur la performance technique d’un site.

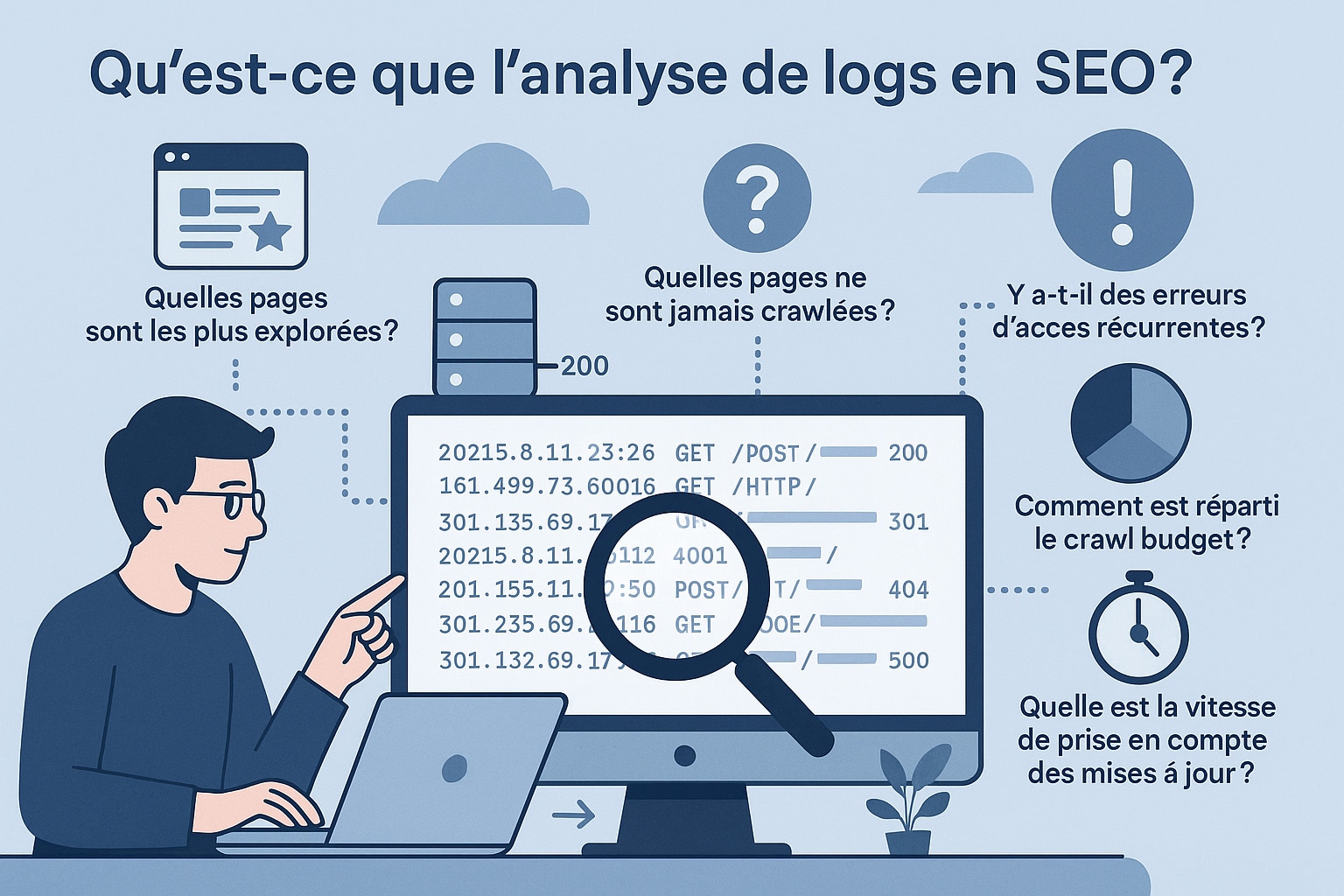

Qu’est-ce que l’analyse de logs en SEO ?

Chaque fois qu’un visiteur (qu’il s’agisse d’un internaute humain ou d’un robot d’indexation) consulte une page de votre site, une requête HTTP est envoyée au serveur. Cette requête est enregistrée dans un fichier texte brut appelé « fichier log » (ou journal serveur). Les serveurs Apache et Nginx, par exemple, génèrent par défaut ces fichiers au format Common Log Format ou Extended Log Format. Ils contiennent des informations détaillées telles que :

- L’adresse IP de la requête, utile pour identifier la source (bot ou utilisateur réel) ;

- La date et l’heure exactes de la requête, permettant d’étudier la fréquence d’exploration ;

- La méthode HTTP utilisée (GET, POST, HEAD…) ;

- L’URL de la ressource sollicitée ;

- Le code de statut HTTP renvoyé par le serveur (200, 301, 404, 500, etc.) ;

- Le User-Agent, qui précise si la requête provient d’un navigateur, de Googlebot, Bingbot ou d’un autre robot d’indexation ;

- Parfois la taille de la ressource servie, ou le temps de réponse du serveur.

Dans une perspective SEO, ces fichiers ne sont pas une simple suite de lignes techniques : ce sont des traces précieuses qui révèlent le comportement réel des robots d’indexation. Contrairement aux sitemaps ou aux balises meta, qui relèvent du déclaratif, les logs montrent ce que Googlebot fait réellement sur le site, et non ce que vous aimeriez qu’il fasse. L’analyse de logs permet ainsi de répondre à des questions stratégiques et techniques :

- Quelles pages sont les plus explorées par Googlebot ? Identifier les pages les plus visitées par les robots est essentiel pour comprendre les priorités que Google attribue à votre site. Si ce sont principalement des pages peu stratégiques (filtres e-commerce, pages d’archives profondes, URL avec paramètres de session ou de tracking), cela peut traduire un gaspillage de crawl budget. À l’inverse, un fort crawl sur les pages transactionnelles ou celles ciblant des mots-clés stratégiques est un bon indicateur de pertinence et de bonne structuration interne ;

- Quelles pages ne sont jamais crawlées ? Lorsqu’une page ne figure jamais dans les logs, c’est le signe qu’elle n’est pas explorée par les robots, et donc qu’elle a peu de chances d’être indexée. Cela peut concerner des pages pourtant essentielles au parcours utilisateur (landing pages, fiches produits stratégiques, pages de services). Les causes sont multiples : profondeur excessive dans l’arborescence, absence de maillage interne, exclusion dans le robots.txt ou encore blocages techniques. L’analyse de logs met en lumière ces pages « fantômes » pour corriger leur accessibilité ;

- Y a-t-il des erreurs d’accès récurrentes ? Les logs enregistrent également les codes HTTP renvoyés par le serveur. Une fréquence élevée d’erreurs 404 (pages introuvables), 500 (erreurs serveur), ou de redirections multiples (301/302 en chaîne) peut nuire fortement à la bonne exploration du site. Les robots gaspillent alors du temps sur des URL inaccessibles ou instables, au détriment des pages stratégiques. Détecter et corriger ces anomalies techniques améliore l’efficacité du crawl et la perception de qualité par Google ;

- Comment est réparti le crawl budget ? Le crawl budget, c’est-à-dire le volume de pages qu’un moteur accepte d’explorer sur une période donnée, n’est pas illimité. Grâce aux logs, on peut vérifier si ce budget est bien utilisé sur les pages prioritaires ou s’il est gaspillé sur des contenus secondaires, peu utiles pour le SEO (tags, filtres, contenus dupliqués). Cette répartition est cruciale sur les sites volumineux, notamment e-commerce, où des milliers d’URL peuvent coexister. Optimiser la répartition du crawl budget permet d’accélérer l’indexation des contenus qui comptent vraiment ;

- Quelle est la vitesse de prise en compte des mises à jour ? Les logs permettent de mesurer le délai entre la modification d’une page (ajout de contenu, mise à jour d’un produit, optimisation SEO) et le moment où Googlebot la revisite. Si ce délai est trop long, cela peut indiquer que la page est jugée secondaire par Google, ou qu’elle est trop profonde dans l’arborescence. Un suivi régulier aide à évaluer l’efficacité des actions SEO et à ajuster la stratégie de maillage interne ou de mise en avant dans le sitemap XML pour accélérer la réindexation.

Concrètement, un fichier log peut contenir des millions de lignes pour un site de grande taille. C’est pourquoi son analyse nécessite des outils spécialisés capables de traiter des volumes massifs de données. Mais c’est précisément cette lecture brute des logs qui permet de détecter des anomalies invisibles autrement : Gaspillage de ressources, surcrawl sur des pages inutiles, ou encore absence totale de crawl sur des pages stratégiques.

Autrement dit, l’analyse de logs en SEO est un outil d’observation directe et factuelle. Là où les sitemaps, balises et autres signaux ne sont que des intentions envoyées aux moteurs, les logs révèlent la réalité : la manière dont Googlebot et ses homologues se comportent réellement sur votre site.

Quelle utilité avantageuse à l’analyse de logs pour le référencement naturel ?

Loin d’être une simple démarche technique réservée aux ingénieurs système, l’analyse de logs en SEO est une méthode qui combine observation technique et stratégie de référencement. Elle permet de comprendre non seulement comment Google explore un site, mais aussi comment cette exploration influe sur la visibilité et la performance globale en SERP. Chaque ligne de log constitue une donnée exploitable, qui, cumulée et analysée, met en lumière des tendances invisibles via des outils classiques comme Google Search Console. Voici les bénéfices les plus notables :

- Optimiser le crawl budget : Google n’explore pas toutes les pages d’un site de la même manière, et son budget de crawl est limité. L’analyse des logs met en évidence les pages qui accaparent inutilement les ressources du robot (filtres e-commerce dynamiques, paramètres d’URL, archives profondes, pages sans valeur SEO). Grâce à cette visibilité, il est possible de réduire ces gaspillages en bloquant certaines URL via le robots.txt, en appliquant des balises

noindex, ou en optimisant la profondeur du maillage interne. Résultat : le bot consacre davantage de temps aux pages stratégiques, améliorant leur fréquence de visite et donc leur probabilité d’indexation ; - Améliorer l’indexation : Certaines pages clés (fiches produits stratégiques, landing pages SEO, articles piliers) peuvent ne jamais être explorées par Google, ce qui les empêche d’intégrer l’index. Les logs permettent d’identifier ces « pages orphelines » du crawl. Une fois repérées, elles peuvent être intégrées au sitemap XML, renforcées dans le maillage interne ou mises en avant via des backlinks internes et externes. C’est une approche très différente d’une simple analyse théorique : ici, on agit sur des données factuelles issues de l’observation réelle du comportement des bots ;

- Détecter les erreurs techniques : Les fichiers logs enregistrent les codes HTTP renvoyés par le serveur. Une concentration anormale d’erreurs 404 (pages introuvables), 301/302 en cascade ou 500 (erreurs serveur) traduit une mauvaise expérience d’exploration pour Googlebot. À grande échelle, cela peut donner l’image d’un site instable et réduire l’efficacité du crawl. En analysant ces anomalies, on peut mettre en place des correctifs : nettoyage des redirections, réduction des chaînes, amélioration du temps de réponse serveur, monitoring des erreurs liées à la charge (timeouts). C’est une approche de maintenance SEO proactive qui va bien au-delà des simples optimisations de contenu ;

- Mesurer l’impact des changements : Après une refonte, une migration ou une optimisation majeure, l’analyse de logs est le seul moyen de vérifier de manière empirique comment Google réagit. Est-ce que le nombre de visites de Googlebot a augmenté sur les nouvelles pages ? Les anciennes URL redirigées sont-elles encore crawlées ? Les erreurs critiques ont-elles disparu ? Ce suivi post-déploiement permet d’anticiper des pertes de trafic et d’ajuster rapidement la stratégie technique avant que les conséquences ne deviennent visibles dans les SERP ;

- Affiner la stratégie SEO : Au-delà de l’aspect technique, les logs apportent une vision très pragmatique des priorités accordées par Google à votre site. Ils permettent de comparer la perception théorique que l’on a du site (via les audits, les outils de crawl ou les hypothèses marketing) avec la réalité observée dans les fichiers serveurs. Si certaines catégories sont largement crawlées mais d’autres délaissées, cela peut indiquer un besoin de rééquilibrer la structure interne, de renforcer les signaux d’autorité ou d’adapter le maillage. L’analyse de logs devient alors un outil de pilotage stratégique, pour valider ou corriger les choix éditoriaux et techniques.

L’analyse de logs SEO est un levier puissant pour améliorer la visibilité et la stabilité d’un site. Elle ne se limite pas à constater le comportement de Googlebot : Elle permet de l’orienter, de l’optimiser et d’en tirer parti. C’est une démarche qui repose sur des données tangibles, exploitables et actionnables, et qui garantit que les moteurs consacrent leurs ressources d’exploration aux pages qui comptent vraiment pour votre business.

Comment réaliser une analyse de logs SEO efficace ?

Une analyse de logs SEO réussie ne se résume pas à ouvrir un fichier texte et parcourir quelques lignes. C’est une démarche méthodique qui implique de collecter, filtrer, traiter et interpréter des volumes parfois gigantesques de données. L’objectif n’est pas seulement de comprendre le comportement de Googlebot, mais d’en tirer des actions concrètes pour améliorer la performance SEO. Voici les étapes clés :

- Collecte des fichiers logs : Les fichiers de logs sont générés par votre serveur web (Apache, Nginx, IIS, etc.) et stockent chaque requête HTTP reçue. Selon l’infrastructure, ils peuvent être récupérés via un accès FTP, une interface d’hébergement (cPanel, Plesk), ou directement par votre équipe technique. Sur des sites à fort trafic, ces fichiers peuvent atteindre plusieurs gigaoctets par jour : il est donc important de prévoir une méthode d’export et d’archivage adaptée. Certains prestataires proposent aussi des solutions de centralisation des logs (ELK stack, Splunk) pour faciliter leur manipulation ;

- Sélection des données utiles : Un fichier log contient toutes les requêtes, qu’elles proviennent d’utilisateurs humains, de robots de monitoring ou de bots SEO. Pour une analyse pertinente, il est indispensable de filtrer ces données et d’isoler les User-Agents des moteurs (Googlebot, Bingbot, AhrefsBot, etc.). Cela permet de se concentrer sur les passages réellement liés à l’indexation. Les IP doivent parfois être vérifiées pour s’assurer qu’il s’agit bien du Googlebot officiel, car certains crawlers malveillants imitent son identifiant ;

- Analyse des crawls : Une fois les données filtrées, il faut les structurer et les interpréter. Des outils spécialisés comme OnCrawl, Botify ou Screaming Frog Log Analyzer permettent de transformer les logs bruts en rapports visuels. On peut ainsi mesurer la fréquence de crawl par URL, identifier les zones les plus explorées, calculer la profondeur d’exploration moyenne, et mesurer la proportion de codes HTTP (200, 301, 404, 500). Ces métriques mettent en évidence si le budget de crawl est utilisé efficacement ou gaspillé sur des zones non stratégiques ;

- Identification des axes d’amélioration : A partir des rapports, le consultant SEO peut dégager des tendances : pages stratégiques peu crawlées, surconsommation du crawl sur des URL inutiles, erreurs techniques répétées. Ces observations servent de base pour des recommandations concrètes : optimisation du maillage interne, nettoyage des redirections, paramétrage du robots.txt, mise en place de balises

noindexou refonte de l’arborescence. Chaque ajustement vise à orienter Google vers les contenus à forte valeur ajoutée ; - Suivi dans le temps : L’analyse de logs n’est pas un exercice ponctuel, mais un travail continu. Les comportements de Google évoluent avec les mises à jour de l’algorithme, les modifications du site ou encore les variations de trafic. Intégrer le suivi des logs dans une routine SEO permet de détecter rapidement de nouveaux problèmes et d’évaluer l’efficacité des optimisations. Après une migration, une refonte ou le lancement de nouvelles sections, les logs sont particulièrement utiles pour vérifier la bonne prise en compte par les moteurs.

En pratique, l’analyse de logs prend toute sa valeur lorsqu’elle est croisée avec d’autres sources : Google Search Console (qui montre les impressions et clics), les outils de crawl classiques (qui révèlent l’état théorique du site), et les données analytiques (qui mesurent l’impact sur les utilisateurs). Cette complémentarité est essentielle pour obtenir une vision complète : ce que l’on déclare aux moteurs, ce qu’ils explorent réellement, et comment les internautes réagissent.

Quels outils SEO choisir pour analyser les logs serveurs ?

Un fichier de logs brut peut rapidement devenir illisible lorsqu’il contient plusieurs millions de lignes. Pour transformer cette masse d’informations en données exploitables, il est indispensable d’utiliser des outils spécialisés. Certains sont orientés SEO, d’autres relèvent davantage de l’administration système, mais tous répondent au même objectif : Rendre lisibles les interactions entre votre site et les robots d’indexation. Voici une sélection des solutions les plus utilisées :

| Outil | Description et cas d’usage |

|---|---|

| Screaming Frog Log File Analyser | Un outil léger et accessible, idéal pour débuter dans l’analyse de logs SEO. Il permet d’importer les fichiers serveurs et de les croiser avec un crawl classique. Ses fonctionnalités incluent :

Convient particulièrement aux consultants SEO indépendants et aux petites structures. |

| OnCrawl | Une plateforme SaaS très complète qui combine analyse de logs et crawl SEO. Adaptée aux sites volumineux (e-commerce, médias, sites internationaux), elle peut traiter des millions d’URL. Ses atouts :

Outil particulièrement recommandé pour les entreprises avec un trafic élevé et une architecture complexe. |

| Botify | Outil premium orienté data-driven, très utilisé par les grandes entreprises. Il croise logs, crawl et données analytiques pour fournir une vision complète du SEO. Fonctionnalités avancées :

Solution robuste mais coûteuse, adaptée aux entreprises avec des enjeux SEO stratégiques à grande échelle. |

| ELK Stack (Elasticsearch, Logstash, Kibana) | Une solution open source plébiscitée par les équipes techniques. Elle permet d’ingérer, traiter et visualiser d’énormes volumes de logs en temps réel. Points forts :

En contrepartie, elle nécessite des compétences techniques pointues pour la configuration et la maintenance. |

| Splunk | Une solution big data propriétaire, très utilisée en cybersécurité, mais adaptable au SEO. Elle excelle dans la gestion de volumes massifs de logs et offre une grande flexibilité d’analyse. Ses atouts :

Comme l’ELK Stack, Splunk demande des ressources techniques avancées et s’adresse surtout aux grandes organisations. |

Le choix de l’outil dépendra avant tout de la taille du site, du volume de logs à traiter, du budget et du niveau d’expertise disponible en interne. Pour un consultant SEO indépendant ou une PME, un outil comme Screaming Frog ou OnCrawl est souvent suffisant. Pour une grande entreprise internationale, Botify ou une solution big data comme ELK s’imposera. Dans tous les cas, l’important est de privilégier une solution capable de croiser les données de logs avec celles issues du crawl et de la Search Console, afin d’obtenir une vision holistique et actionnable.

0 commentaires