Le design et la promotion d’un site web attirent les visiteurs, mais c’est sa structure, la qualité de son contenu et sa facilité de navigation qui déterminent s’ils y restent. Le SEO on-site, ou référencement sur site, regroupe l’ensemble des optimisations effectuées directement sur le site pour améliorer sa visibilité dans les moteurs de recherche tout en offrant une expérience agréable aux utilisateurs. Bien qu’il soit parfois négligé, ce pilier du référencement naturel est essentiel pour bâtir une stratégie SEO solide et durable.

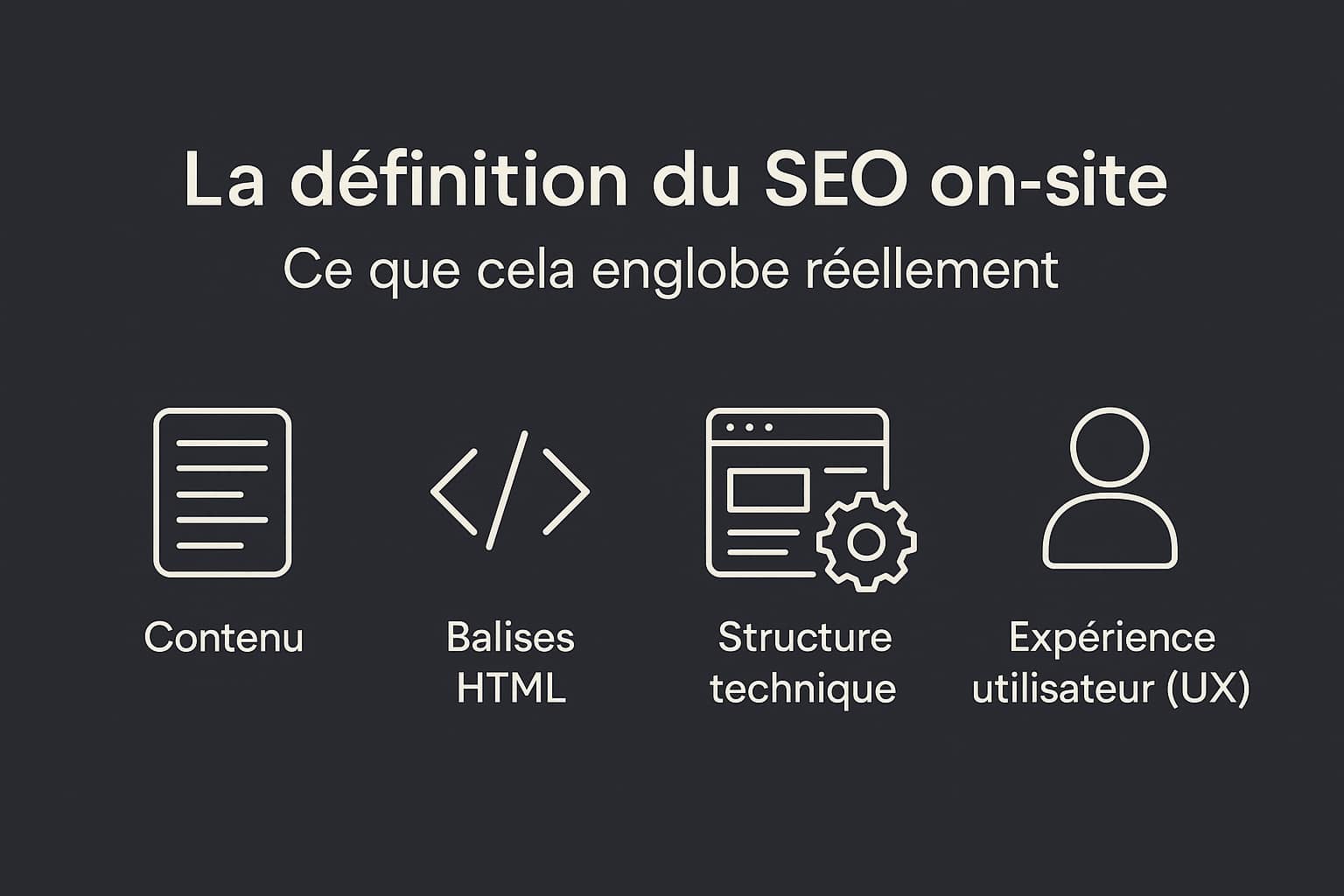

La définition du SEO on-site : Ce que cela englobe réellement

Le SEO on-site désigne l’ensemble des optimisations réalisées directement sur un site web pour en améliorer la visibilité dans les résultats des moteurs de recherche. Contrairement au on-page SEO, qui se concentre principalement sur le contenu et les éléments visibles d’une page (comme les textes, les titres, ou les balises HTML), le SEO on-site adopte une approche plus globale. Il s’intéresse à tous les aspects internes du site, depuis l’infrastructure serveur jusqu’à la qualité éditoriale, en passant par les performances techniques, la sécurité, l’architecture de l’information et l’accessibilité. Ce travail en profondeur permet aux moteurs de recherche comme Google de mieux comprendre le fonctionnement du site, d’évaluer la pertinence des contenus, et de mesurer la capacité de la plateforme à répondre aux intentions de recherche des utilisateurs. Le SEO on-site est donc un pilier stratégique, car il conditionne l’indexation correcte des pages et influence directement leur positionnement dans les résultats de recherche.

Les actions liées au SEO on-site peuvent être regroupées en plusieurs grandes catégories complémentaires :

- Contenu : Qualité, pertinence, unicité, fraîcheur et structure logique de l’information proposée ;

- Balises HTML : Bonne utilisation des balises

title,meta description, des balises de titres Hn, et des attributsaltpour les images ; - Structure technique : Architecture du site, optimisation des URLs, robots.txt, temps de chargement, compatibilité mobile, sécurité (HTTPS) et performances serveur ;

- Expérience utilisateur (UX) : Lisibilité du contenu, fluidité de la navigation, cohérence du design, maillage interne et accessibilité pour tous les profils d’utilisateurs.

Le SEO on-site va bien au-delà du simple contenu visible sur une page et englobe tout l’écosystème technique et éditorial d’un site web, avec pour objectif de maximiser sa lisibilité par les moteurs de recherche et de proposer une expérience optimale aux internautes. Ce travail d’optimisation interne constitue un socle indispensable avant de développer des actions externes comme le netlinking ou les partenariats de visibilité.

Les piliers techniques et éditoriaux du référencement SEO on-site

Le référencement on-site repose sur deux axes principaux : D’un côté les contenus, qui doivent être structurés, pertinents et ciblés ; de l’autre, les aspects techniques du site, souvent invisibles pour l’internaute, mais déterminants pour l’indexation et la compréhension par les moteurs de recherche. C’est la combinaison cohérente de ces deux dimensions qui permet d’obtenir un référencement naturel solide et stable.

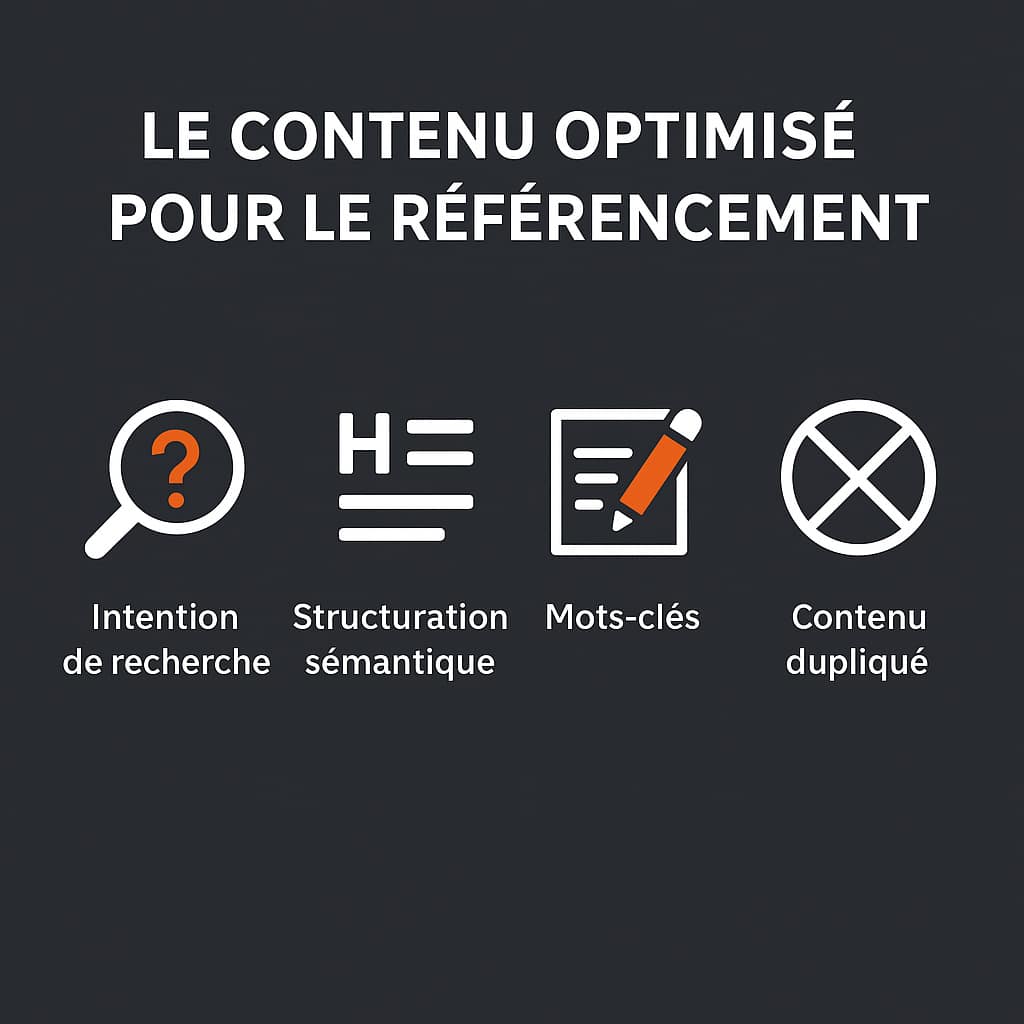

1. Le contenu optimisé pour le référencement

Le contenu est le point d’entrée principal de l’algorithme de Google. Il constitue l’un des piliers les plus influents du SEO on-site. Sans contenu pertinent, structuré et contextualisé, un moteur de recherche ne peut ni comprendre la thématique d’une page, ni la relier efficacement aux intentions de recherche des internautes. Un contenu optimisé pour le référencement ne se résume pas à un simple empilement de mots-clés. Il doit répondre à des critères précis qui touchent autant à la sémantique qu’à la structure technique du texte. Voici les éléments à maîtriser :

- Répondre à une intention de recherche claire : Chaque contenu doit cibler une requête ou une problématique précise. Il est essentiel de distinguer les types d’intention (informationnelle, navigationnelle, transactionnelle) et d’adapter le ton, le format et la profondeur du contenu en conséquence ;

- Structuration sémantique avec les balises Hn : L’utilisation des titres (H1, H2, H3…) permet d’organiser le contenu hiérarchiquement. Google s’appuie sur cette structure pour comprendre les sous-thèmes abordés dans la page. Un bon balisage facilite aussi la génération de featured snippets (extraits optimisés) ;

- Intégration naturelle des mots-clés : Les expressions clés principales doivent être placées stratégiquement : dans le titre (balise

title), les sous-titres, les 100 premiers mots, les attributsaltdes images, les balisesstrong, etc. Il est recommandé d’utiliser des variantes lexicales (LSI) et des synonymes pour enrichir le champ sémantique ; - Prévention du duplicate content : Le contenu dupliqué, qu’il soit interne (entre plusieurs pages d’un même site) ou externe (copié depuis un autre site), nuit fortement au positionnement. Chaque page doit proposer un contenu unique, pertinent et à forte valeur ajoutée. L’utilisation de balises

canonicalpermet aussi de gérer certaines duplications inévitables ; - Optimisation pour l’indexation : Un contenu bien formaté aide les moteurs à crawler la page correctement. Cela inclut des paragraphes courts, des listes à puces, des encadrés de définition, et éventuellement des données structurées (

schema.org) pour enrichir la compréhension du contenu par les robots ; - Éviter le « thin content » : Une page ne contenant que peu de texte sans réelle valeur est rarement bien positionnée. Il faut viser un contenu dense et informatif, d’au moins 800 à 1000 mots pour les pages de blog ou les pages catégories, et bien plus pour les contenus piliers (guides, pages de service, etc.) ;

- Tenir compte de la fraîcheur du contenu : Google valorise les contenus mis à jour régulièrement, notamment sur des thématiques sensibles à l’évolution (actualités, technologies, législation, etc.). Mettre à jour les chiffres, les références et les liens internes est une bonne pratique à intégrer dans une stratégie de contenu durable.

Un contenu optimisé est à la fois lisible pour l’utilisateur et exploitable par les robots d’indexation. Il doit combiner pertinence sémantique, clarté structurelle et richesse d’information. Ce n’est pas la quantité qui prime, mais la capacité du contenu à couvrir un sujet en profondeur, avec des éléments différenciants qui justifient son positionnement en haut des résultats de recherche.

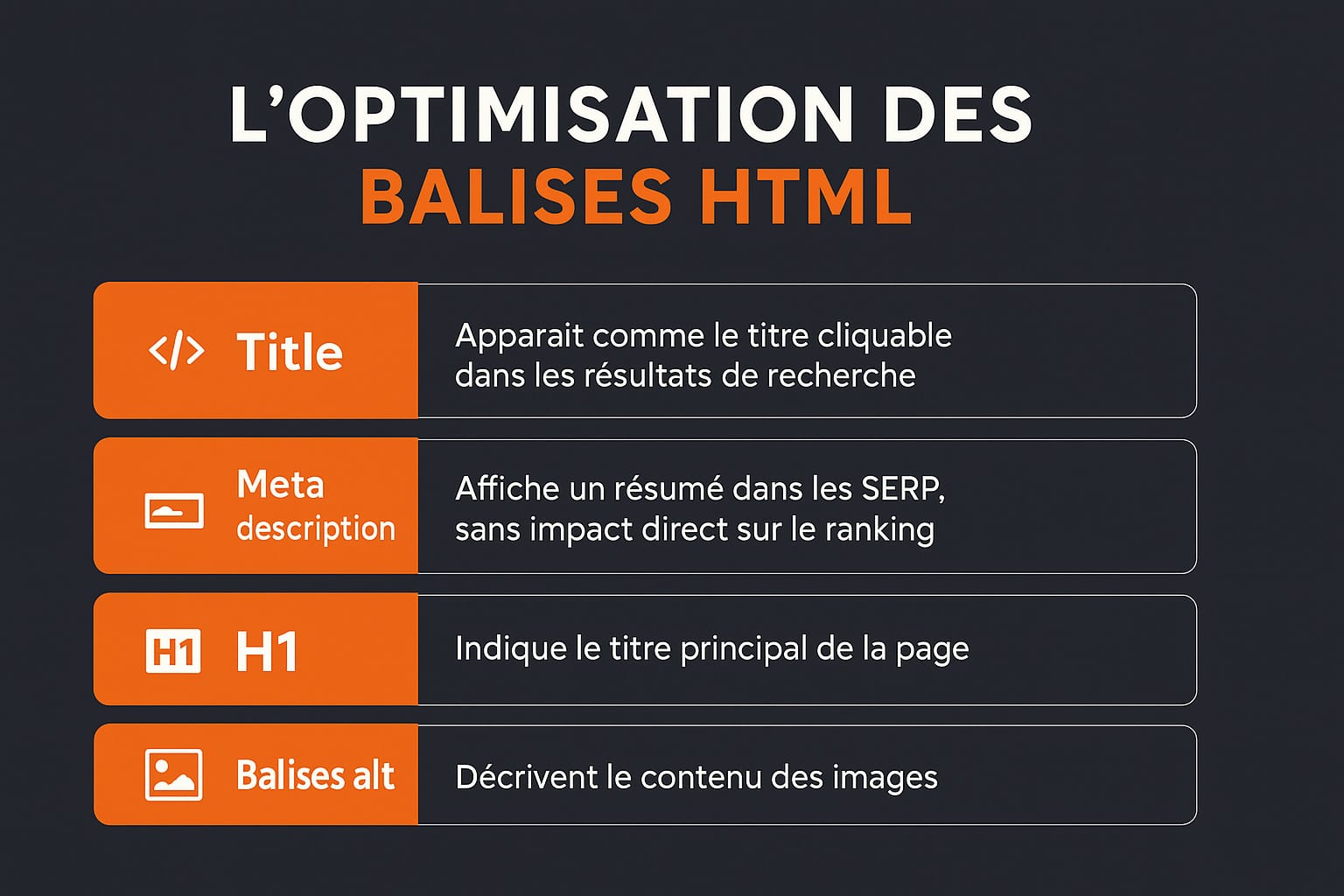

2. L’optimisation des balises HTML et des éléments sémantiques dans le seo on-site

Les balises HTML sont des éléments fondamentaux du SEO on-site car elles structurent l’information pour les moteurs de recherche. Elles permettent de hiérarchiser le contenu, de préciser son objet et d’aider les robots d’indexation à comprendre le contexte et la pertinence de chaque élément d’une page. Une utilisation correcte des balises améliore non seulement la lisibilité du contenu par Google, mais participe aussi à l’obtention d’extraits enrichis (rich snippets), ce qui peut augmenter le taux de clic (CTR) dans les SERP.

| Balise | Rôle | Conseils |

|---|---|---|

| Title | Apparaît comme le lien cliquable dans les résultats de recherche | Inclure le mot-clé principal en début de balise, éviter les doublons, ne pas dépasser 60 caractères |

| Meta description | Texte descriptif visible dans les SERP, sans impact direct sur le classement | Créer un texte unique par page, incitatif, contenant le mot-clé secondaire, entre 150 et 160 caractères |

| H1 | Indique le titre principal du contenu visible sur la page | Un seul H1 par page, avec le mot-clé principal ; ne pas dupliquer le title |

| Balises alt | Texte alternatif des images, lu par les moteurs et les lecteurs d’écran | Décrire l’image de façon concise, intégrer un mot-clé si pertinent, éviter les descriptions génériques |

Ces balises ne sont que la base. Pour une structuration complète et efficace du contenu, il est essentiel d’utiliser également les balises suivantes :

- <H2> à <H6> : pour organiser les sous-sections de la page et créer une arborescence logique et lisible ;

- <strong> et <em> : pour mettre en valeur des mots ou expressions clés sans abuser du gras ;

- <ul>, <ol> et <li> : pour les listes à puces ou numérotées, qui aident à segmenter l’information ;

- <blockquote> : pour les citations, utile dans les articles de fond ou les références externes ;

- Données structurées JSON-LD : pour baliser les contenus spécifiques (articles, produits, FAQ, avis) en utilisant le vocabulaire

schema.org.

Les balises HTML participent aussi à la clarté du DOM (Document Object Model), ce qui facilite l’analyse du code source par les crawlers. Des erreurs dans ces balises, comme des titres non hiérarchisés, des balises manquantes ou des balises dupliquées, peuvent perturber la compréhension de la page et freiner son indexation. L’audit régulier de la structure HTML avec des outils comme Screaming Frog ou Sitebulb permet d’identifier ces problèmes rapidement.

Par ailleurs, il est recommandé de maintenir un code HTML propre, sans balises inutiles, et conforme aux standards W3C. Cela favorise non seulement le SEO, mais réduit également les risques de bugs d’affichage ou de conflits CSS/JavaScript pouvant affecter l’expérience de navigation et le rendu du contenu.

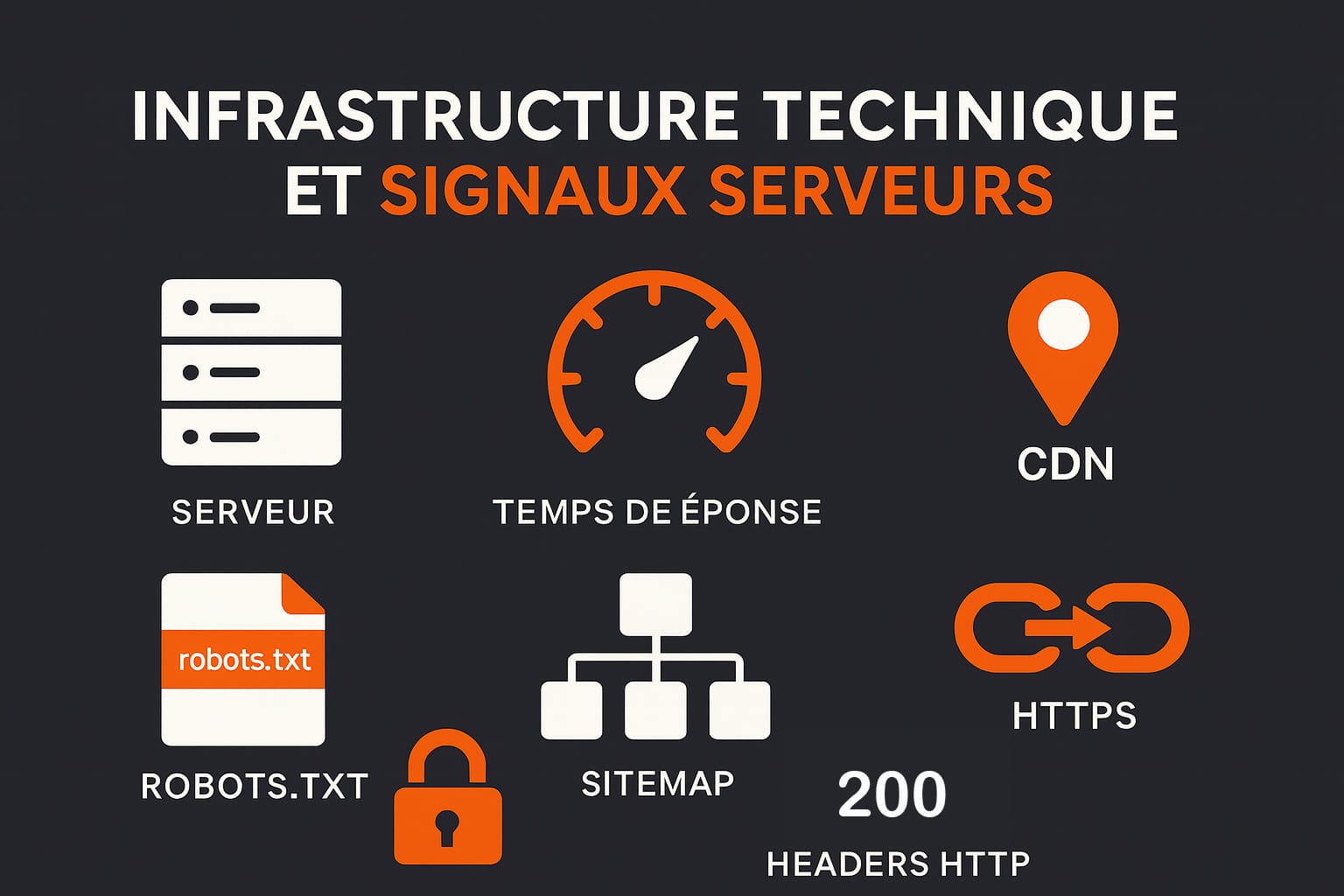

3. L’infrastructure technique et les signaux serveurs

Le SEO on-site repose autant sur la qualité du contenu que sur la solidité de l’infrastructure technique qui le supporte. Un site mal configuré, lent ou inaccessible par intermittence aura beau proposer les meilleurs textes du web, il ne pourra pas atteindre un bon positionnement. L’environnement serveur, la gestion des accès des robots, la structure des URLs ou encore la sécurité HTTPS sont autant de signaux analysés en continu par les moteurs de recherche pour évaluer la fiabilité d’un site. Voici les éléments techniques à prendre en compte :

- Temps de réponse serveur : La vitesse de réponse du serveur est déterminante pour le crawl et l’expérience utilisateur. Un serveur lent allonge le Time To First Byte (TTFB), ralentit le chargement complet de la page (Largest Contentful Paint) et peut conduire Googlebot à réduire la fréquence de crawl. Il est conseillé de choisir un hébergeur performant, avec des ressources dédiées, et d’utiliser des outils comme PageSpeed Insights ou GTmetrix pour analyser les goulets d’étranglement ;

- Adresse IP et géolocalisation : L’adresse IP du serveur peut influencer le référencement local, surtout pour les requêtes géo-dépendantes. Pour un site destiné au public français, il est préférable que le serveur soit localisé en Europe ou que le CDN utilisé (ex. Cloudflare) permette de délivrer les contenus depuis des nœuds proches de l’utilisateur final. Cela réduit la latence et renforce la pertinence géographique ;

- Fichier robots.txt : Ce fichier placé à la racine du site contrôle l’accès des robots aux différentes ressources. Une mauvaise directive

Disallowpeut bloquer l’indexation de pages importantes (ex. : /blog/, /produits/). Il est crucial de tester les règles avec la Search Console et de vérifier que les ressources essentielles (JS, CSS, images) ne sont pas bloquées si elles influencent le rendu de la page ; - Sitemap XML : Le sitemap fournit aux moteurs une carte structurée des pages à indexer. Il doit être généré dynamiquement pour rester à jour et contenir uniquement des URLs indexables (code 200, non canonique, non bloquées par robots.txt). Il est recommandé de séparer les sitemaps volumineux (ex. : un sitemap pour les articles, un autre pour les produits) et de le soumettre via Google Search Console et Bing Webmaster Tools ;

- Réécriture d’URL et redirections : Des URLs propres, hiérarchisées et stables sont essentielles. L’usage d’URLs courtes, contenant les mots-clés principaux, sans paramètres inutiles, améliore le crawl et la lisibilité. La mise en place correcte des redirections 301 évite la perte de PageRank lors de la suppression ou modification d’une page. Il faut également limiter les chaînes de redirection (redirect chains) et les boucles infinies ;

- HTTPS : Google considère le HTTPS comme un signal de confiance. Un site sans certificat SSL ou avec un certificat mal configuré (incomplet, expiré, ou non reconnu) peut être affiché comme « non sécurisé » par les navigateurs, ce qui nuit à la crédibilité et au référencement. Le protocole HTTPS permet également de bénéficier des dernières fonctionnalités HTTP/2 ou HTTP/3 pour des chargements plus rapides ;

- Headers HTTP et codes de réponse : chaque page doit retourner un code de réponse HTTP cohérent. Les erreurs 404 non gérées, les réponses 500 en cas de surcharge ou les mauvaises redirections (302 au lieu de 301) perturbent les robots d’indexation. Il est important de surveiller les journaux serveurs (logs) pour détecter les anomalies, notamment via des outils comme Screaming Frog ou Log File Analyzer.

Une infrastructure technique bien pensée facilite le crawl, réduit les erreurs d’indexation et améliore les signaux Core Web Vitals. Cela permet aux moteurs de recherche de parcourir plus efficacement le site, d’évaluer la pertinence des contenus dans un contexte technique sain, et donc d’en améliorer le classement global. Le socle technique, bien que souvent invisible, conditionne directement les performances SEO à moyen et long terme.

Une architecture de site bien pensée ne se contente pas de faciliter la navigation pour les utilisateurs : elle joue un rôle stratégique dans le SEO on-site en influençant la manière dont les moteurs de recherche explorent, comprennent et valorisent les différentes pages d’un site. Googlebot parcourt les pages à partir de liens internes. Si l’architecture est désorganisée ou incohérente, certaines pages peuvent rester non découvertes ou être mal contextualisées. L’objectif est donc d’organiser l’information de manière logique, hiérarchisée et thématique, afin de maximiser la découverte, l’indexation et la distribution de l’autorité (PageRank) à travers l’ensemble du site.

- Organisation en silos thématiques ou en clusters : Il est recommandé de regrouper les contenus par thématique dans des sections clairement définies (par exemple : /seo/, /e-commerce/, /blog/…). Cette structuration permet de renforcer la pertinence sémantique globale du site en créant des groupes de pages cohérents, reliés par des liens internes contextuels ;

- Maillage interne optimisé : Chaque page importante doit recevoir des liens internes provenant de contenus connexes. Les ancres de liens (anchor text) doivent être descriptives, naturelles et, si possible, contenir des mots-clés secondaires ou des variantes sémantiques. Il est également utile d’insérer des liens dans le contenu principal (in-content linking), plutôt que dans les menus ou le pied de page uniquement ;

- Utilisation d’URLs lisibles et descriptives : Une URL courte, sans paramètres inutiles, contenant des mots-clés hiérarchisés (ex. :

/seo/seo-on-site) est plus facilement interprétée par les robots. Elle favorise également un meilleur taux de clic dans les résultats de recherche ; - Profondeur de crawl limitée : Pour que Google explore efficacement un site, les pages stratégiques doivent être accessibles en 3 clics maximum depuis la page d’accueil. Plus une page est enfouie dans l’arborescence, plus elle risque d’être mal explorée ou ignorée ;

- Éviter les contenus orphelins : Une page sans lien entrant interne est considérée comme isolée par Google. Même si elle est incluse dans le sitemap, elle sera souvent jugée moins pertinente et peu reliée au reste du site. Un audit du maillage interne permet d’identifier et corriger ce type de problème.

Il est également pertinent d’utiliser des outils de visualisation d’arborescence comme Screaming Frog, Oncrawl ou Sitebulb pour auditer la structure interne d’un site. Ces outils permettent de repérer les zones trop profondes, les liens cassés, les boucles de redirection et les pages mal reliées.

Une architecture bien conçue facilite donc la distribution du PageRank interne, améliore la vitesse de crawl, renforce la contextualisation sémantique des pages, et contribue à un meilleur classement global dans les SERP. C’est une composante du seo on-site qui a un impact structurel à long terme, notamment pour les sites à fort volume de pages ou les plateformes e-commerce complexes.

0 commentaires