Depuis la publication récente de documents judiciaires aux États-Unis dans le cadre du procès antitrust contre Google, un pan entier du fonctionnement réel du moteur de recherche a été mis en lumière. Parmi les révélations majeures : le rôle central joué par les signaux utilisateurs, l’utilisation extensive des données de navigation via Chrome, l’importance croissante de la popularité réelle des sites, et surtout, l’intégration d’outils avancés comme RankEmbedBERT et Navboost dans le processus de classement. Ces éléments redéfinissent en profondeur l’interprétation des données issues de la Google Search Console (GSC). Beaucoup de professionnels SEO observent une baisse de la position moyenne dans GSC, accompagnée d’une hausse des impressions mais d’un volume de clics qui stagne, voire diminue. Cela peut sembler inquiétant au premier abord. Pourtant, à la lumière des mécanismes révélés, cette évolution représente en réalité une opportunité SEO stratégique.

Pourquoi la position moyenne baisse mais les impressions augmentent

Traditionnellement, une baisse de la position moyenne dans la Google Search Console (GSC) était interprétée comme un signal négatif : perte de visibilité, déclassement algorithmique ou pénalité suite à un core update. Cette interprétation s’appuyait sur une vision linéaire et positionnelle du SEO, centrée sur les 10 premiers résultats de recherche. Or, l’arrivée de RankEmbedBERT modifie profondément cette lecture. Ce système, révélé officiellement dans le cadre de la procédure antitrust aux États-Unis, est désormais un des éléments centraux du classement Google. Contrairement aux anciens modèles d’évaluation, RankEmbedBERT repose sur des embeddings sémantiques multidimensionnels, combinés à deux sources de données majeures :

- 70 jours de journaux de recherche (requêtes, documents consultés, clics, rebonds, durée de session),

- les évaluations des quality raters, apportant une dimension humaine de validation qualitative.

Ces embeddings permettent à Google de projeter chaque page web dans un espace vectoriel où les documents sont comparés non plus uniquement par mots-clés, mais selon leur proximité sémantique avec des intentions de recherche détectées. Cela signifie que votre contenu peut désormais être jugé pertinent même s’il ne cible pas explicitement une requête, mais si son sens global correspond aux attentes implicites de l’utilisateur.

Conséquence directe : Votre page peut être exposée à un spectre de requêtes plus large, y compris des requêtes génériques ou périphériques à votre sujet d’origine. Cette expansion du périmètre d’exposition entraîne mécaniquement :

- Une augmentation des impressions, car la page apparaît sur de nouvelles SERP, parfois à des positions basses,

- une baisse de la position moyenne, car ces nouvelles occurrences sont moins bien classées initialement,

- des clics stables ou en recul, si le contenu ou le snippet ne convainc pas l’utilisateur face à la concurrence immédiate.

Dans GSC, cela crée ce que beaucoup interprètent comme une « anomalie », alors qu’il s’agit en réalité d’un effet naturel de l’élargissement contextuel opéré par RankEmbedBERT. Ce phénomène est encore amplifié par Navboost, un autre système interne mis en lumière par les documents judiciaires. Navboost n’est pas un moteur algorithmique classique : il s’agit d’une vaste base de données de logs de clics, collectés depuis 2005 (d’abord via la Google Toolbar, puis via Chrome), qui attribue un poids à chaque URL en fonction de sa performance comportementale. Les critères de Navboost incluent notamment :

- le nombre de clics par requête,

- le type de clic (clic long = utilisateur resté sur la page / clic court = retour immédiat aux SERP),

- la fréquence de clics sur l’URL à travers différentes sessions,

- et parfois même l’origine du clic (appareil, géolocalisation, langue, etc.).

Il ne s’agit donc pas d’un score calculé en temps réel, mais d’un score accumulé au fil du temps, servant de mémoire comportementale pour affiner les classements. Ainsi, lorsque votre page commence à apparaître pour de nouvelles requêtes (sous l’effet de RankEmbedBERT), Navboost évalue sa pertinence a posteriori, en se basant sur les clics générés (ou non) par cette nouvelle exposition.

Si les clics sont absents ou peu engageants (temps de session très court, retour rapide aux SERP), la page ne progressera pas immédiatement dans les classements pour ces requêtes. Mais l’inverse est également vrai : un taux de clics élevé, combiné à une interaction satisfaisante, peut entraîner une remontée progressive dans les positions, validée par la mémoire de Navboost. Ce modèle basé sur l’expérimentation et l’observation du comportement utilisateur à grande échelle transforme totalement la manière d’interpréter les KPI SEO dans GSC. Une baisse de la position moyenne peut désormais être le signal d’une phase de test par Google, visant à évaluer la pertinence de votre contenu dans de nouveaux contextes de recherche.

Autrement dit, si votre contenu s’étend sémantiquement au-delà de vos mots-clés initiaux, il sera testé dans un environnement plus compétitif. La phase de test se traduit souvent par une hausse des impressions, sans clics immédiats, donc par une dégradation apparente de la position moyenne. Mais si cette phase est bien exploitée (en améliorant le contenu, en ajustant les titres, ou en retravaillant l’intention utilisateur) elle peut aboutir à une forte croissance du trafic organique à moyen terme.

Le signal réel à surveiller n’est donc plus uniquement la position moyenne, mais la convergence entre impressions, clics, et engagement utilisateur, tel qu’observé à travers les outils GSC, Analytics, et éventuellement des outils tiers spécialisés dans les comportements sur SERP.

Interpréter les signaux utilisateurs à la lumière des documents judiciaires

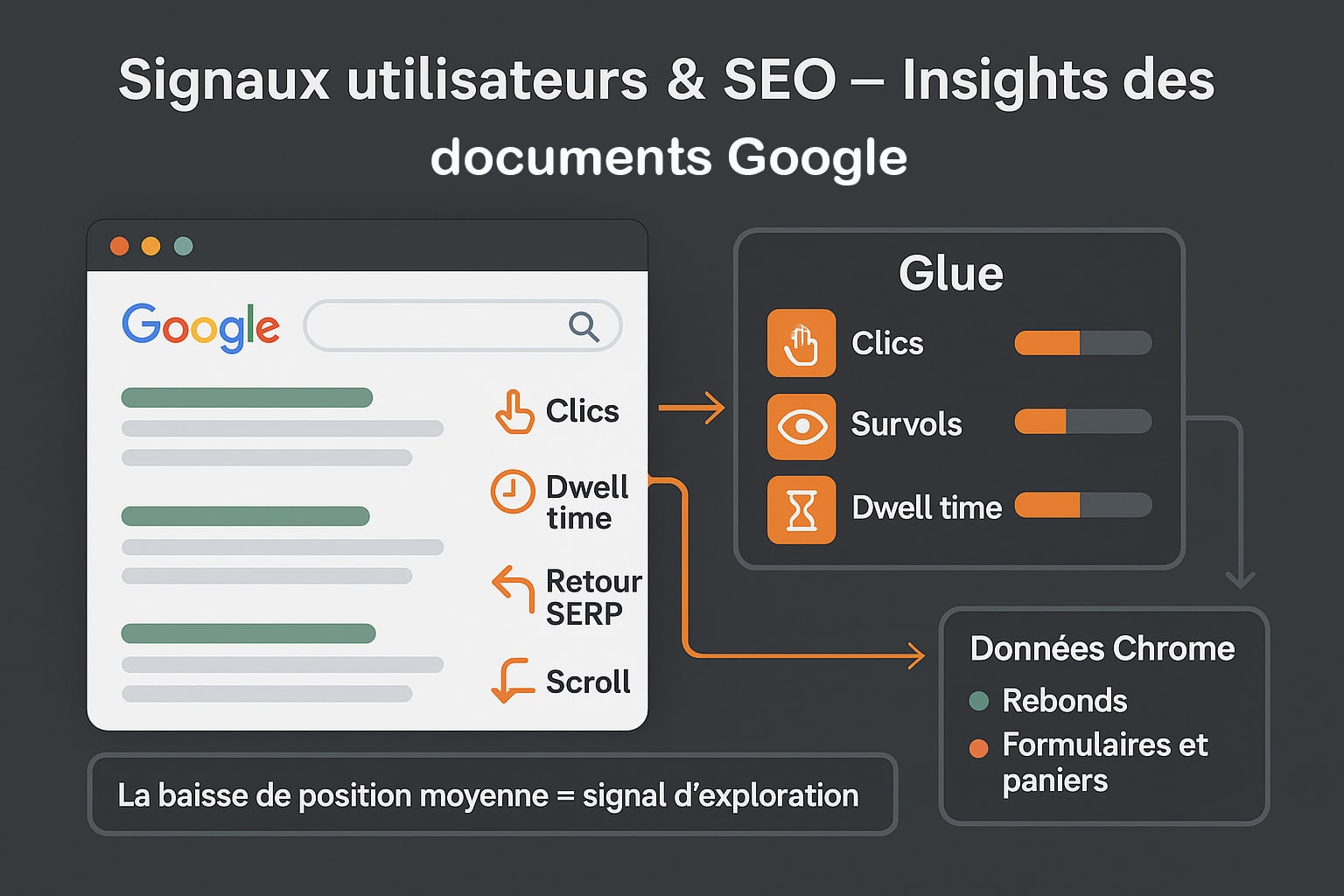

Les révélations issues des documents judiciaires du procès antitrust contre Google ont levé le voile sur un aspect longtemps sujet à controverse dans la communauté SEO : L’utilisation massive, systématique et structurée des signaux comportementaux des utilisateurs comme leviers de classement. Alors que Google a longtemps minimisé leur rôle en public, ces documents prouvent que l’analyse comportementale est intégrée à plusieurs niveaux critiques du moteur de recherche. Parmi les systèmes internes dévoilés, l’un des plus importants est « Glue », une architecture centrale d’observation et de corrélation des signaux utilisateurs. Glue fonctionne comme un gigantesque tableau de bord unifié qui capte une grande variété de données liées à chaque interaction utilisateur, et ce, dès l’instant où une requête est saisie dans la barre de recherche.

Parmi les métriques suivies par Glue, on retrouve :

- Les requêtes exactes formulées par les utilisateurs, incluant l’ordre des mots, la langue, les fautes de frappe ou les reformulations,

- La position du curseur dans la SERP, indiquant les zones de concentration de l’attention visuelle (approche implicite de suivi du regard),

- Les clics réels, les survols de souris (hover tracking) et les premières interactions sur la page de résultats,

- La durée de consultation des pages cliquées, aussi appelée dwell time,

- Le taux de retour rapide à la SERP (pogo-sticking), indicateur d’insatisfaction immédiate,

- Les mouvements de scroll, les clics profonds (navigation secondaire dans le site) et l’utilisation de formulaires ou de paniers.

Ces données comportementales sont ensuite corrélées avec celles collectées par le navigateur Chrome, permettant à Google d’observer ce que les concurrents ne peuvent pas voir : Le comportement réel post-SERP. Autrement dit, même si un utilisateur ne revient pas immédiatement aux résultats de recherche, Google peut suivre sa session via Chrome et enrichir sa compréhension de l’engagement sur le site visité. Les signaux captés incluent alors :

- La récurrence des visites (trafic direct ou répété),

- Le taux de rebond réel (au niveau navigateur, pas seulement Analytics),

- Les interactions actives comme l’ajout au panier, le clic sur un bouton CTA, ou la validation d’un formulaire,

- Et même la vitesse de navigation ou le temps de chargement observé côté client.

Google dispose ainsi d’un modèle extrêmement précis de ce qu’on peut appeler la qualité perçue en situation réelle. Une page qui capte l’attention, génère des clics, retient les utilisateurs et provoque des actions significatives sera naturellement jugée plus pertinente, même si elle ne dispose pas d’un nombre massif de backlinks ou d’un contenu parfaitement optimisé sur le plan technique.

Dans ce contexte, il est donc parfaitement logique qu’une page dont le contenu est pertinent mais encore peu reconnu (en termes de notoriété SEO) soit affichée plus souvent, y compris dans des positions plus faibles (position 8 à 20), simplement pour mesurer la réaction utilisateur à grande échelle. Cela crée mécaniquement une hausse des impressions, accompagnée d’une baisse de la position moyenne, notamment si ces nouvelles expositions se font sur des requêtes plus concurrentielles ou de longue traîne.

Si l’expérience utilisateur issue de ces requêtes est jugée positive (par exemple, un taux de clic supérieur à la moyenne de position, un dwell time élevé, ou un faible taux de retour SERP), alors la page peut progresser dans le classement pour ces termes, de façon incrémentale. À l’inverse, une expérience neutre ou négative ralentira cette progression, sans pour autant entraîner une pénalité directe.

Autrement dit, ce que vous perceviez hier comme une alerte peut aujourd’hui être un signal d’exploration algorithmique positif.

Ce changement de paradigme impose une nouvelle lecture des KPIs : les SEOs doivent cesser de considérer la position moyenne comme un indicateur de performance absolu. Elle devient plutôt un traceur de phase d’expérimentation orchestrée par Google, qui attend en retour des preuves de pertinence comportementale avant de valider une position pérenne dans les résultats.

En intégrant cette logique dans votre stratégie SEO, vous pourrez transformer chaque phase de test en opportunité d’optimisation ciblée. Et c’est précisément là que réside l’avantage concurrentiel : comprendre les intentions derrière les impressions, pour améliorer l’expérience et provoquer le clic décisif.

Comment transformer cette dynamique RankEmbedBERT en levier SEO

La nouvelle dynamique induite par RankEmbedBERT, Navboost et les signaux comportementaux doit être interprétée comme une opportunité d’optimisation avancée. En comprenant la logique algorithmique derrière la baisse de position moyenne, les SEO peuvent ajuster leur stratégie pour renforcer leur présence sur des requêtes à fort potentiel même si elles ne génèrent pas encore de clics massifs.

Voici une méthodologie concrète et reproductible pour tirer parti de cette évolution :

- Accédez à Google Search Console et sélectionnez la période des 16 derniers mois afin d’identifier les évolutions sur le long terme, incluant les effets différés des core updates ;

- Appliquez le filtre géographique « Pays = France » afin d’exclure les données internationales qui pourraient fausser l’analyse (notamment à cause de la non-disponibilité actuelle des AI Overviews en France) ;

- Exportez les requêtes pour vos principales pages ou catégories, puis classez-les selon la variation de position moyenne ;

- Repérez les requêtes où la position moyenne a baissé significativement, tout en observant une hausse nette des impressions. Ce sont des signaux typiques d’un élargissement expérimental de votre couverture sémantique ;

- Analysez ensuite les clics associés à ces requêtes. S’ils sont stables ou en léger recul malgré l’augmentation des impressions, vous êtes probablement dans une phase de test algorithmique par RankEmbedBERT et/ou Navboost.

Ces phases de test sont précieuses : elles vous indiquent que Google envisage votre contenu pour des requêtes plus concurrentielles ou connexes. Pour maximiser votre impact à ce stade, vous devez renforcer la pertinence perçue de votre contenu sur ces nouveaux contextes de recherche. Voici les optimisations recommandées à appliquer :

- Réécrivez vos titres SEO en intégrant les nouveaux mots-clés générateurs d’impressions, tout en conservant la clarté et l’attrait émotionnel. Pensez à la hiérarchie d’information : les 65 premiers caractères doivent susciter le clic ;

- Ajoutez des sections ou blocs de contenu répondant aux requêtes émergentes. Cela peut inclure des FAQ, des exemples concrets, ou des compléments de contexte permettant de capter des requêtes longues (longue traîne) ;

- Analysez en profondeur les concurrents positionnés sur ces mêmes requêtes : Quels types de contenu proposent-ils ? Utilisent-ils des schémas structurés (FAQ, HowTo, Breadcrumbs) ? Quelle est la structure de leur balisage HTML (Hn, paragraphes, listes) ?

- Surveillez les SERP enrichies (People Also Ask, Featured Snippets, vidéos, carrousels) sur ces requêtes. Adapter votre format à ces intentions peut vous aider à gagner en visibilité indirecte même sans progression immédiate en position organique.

Il est aussi pertinent d’utiliser des outils tiers comme Ahrefs, SEMrush ou SEOClarity pour compléter l’analyse GSC avec :

- Le taux de clic attendu (expected CTR) en fonction de votre position,

- Le CTR relatif (votre CTR comparé à la moyenne sectorielle sur la même position),

- Le potentiel de croissance SEO estimé en cas de remontée en position sur ces requêtes testées.

Bien entendu, ne négligez pas la cohérence thématique interne de votre site : L’interconnexion entre vos contenus via un maillage logique et contextuel (interne ou contextuel enrichi) renforce la capacité de RankEmbedBERT à interpréter la pertinence globale de votre domaine sur un sujet donné. Cette approche proactive et structurée transforme ce qui, en surface, semble être une perte de position, en véritable levier de croissance SEO pilotée par les données ainsi que l’explique par ailleurs Olivier Duffez ici sur le sujet à la suite du post suivant de Fabien Faceries, son associé sur un outil qui peut vous aider 🙂

En effet, Olivier propose un outil pratique pour travailler la question dans ce sujet : My Ranking Metrics. Cela permet non seulement de récupérer des clics, mais aussi d’asseoir une légitimité sémantique durable aux yeux des systèmes de classement modernes.

0 commentaires