Sur un site web, toutes les pages accessibles à l’utilisateur ne figurent pas forcément dans les résultats de recherche de Google. Certaines sont volontairement écartées de l’index, d’autres ignorées par les moteurs pour des raisons techniques ou qualitatives. On parle alors de pages « désindexées ». Que recouvre exactement ce terme en SEO ? Dans quels cas une page peut-elle être exclue de l’index ? Et surtout, quels sont les impacts de cette situation sur la visibilité d’un site ? À travers cet article, découvrons ensemble ce qu’implique la désindexation, et comment l’aborder dans une stratégie de référencement naturel efficace.

Quels mécanismes permettent de désindexer une page ?

Une page désindexée est une page qui ne figure pas dans l’index d’un moteur de recherche comme Google : Concrètement, elle ne peut pas apparaître dans les pages de résultats (les SERP), même si elle reste accessible via son URL, et elle se distingue ainsi d’une page fantôme (présente mais rendue invisible par un blocage technique), d’une page zombie (indexée mais sans valeur ni trafic) ou d’une page orpheline (isolée car sans liens internes), car ici le point commun est l’exclusion explicite ou progressive de l’index, qu’elle soit volontaire ou provoquée par des signaux techniques et algorithmiques. Voici les principaux mécanismes qui conduisent à la désindexation :

- La balise meta robots « noindex » : Insérée directement dans le code HTML de la page, cette balise indique explicitement aux robots des moteurs de recherche qu’ils ne doivent pas indexer cette page. Elle est généralement placée dans la section

<head>du document. Lorsqu’un robot respecte cette directive, la page sera explorée (si elle n’est pas bloquée par le robots.txt), mais elle ne sera pas enregistrée dans l’index de Google. C’est la méthode la plus couramment utilisée pour exclure volontairement une page de l’index. Exemple :<meta name="robots" content="noindex">; - L’en-tête HTTP X-Robots-Tag : À la différence de la balise meta, cet en-tête est appliqué côté serveur, ce qui permet de contrôler l’indexation de contenus non HTML tels que les fichiers PDF, images, ou documents téléchargeables. Il est particulièrement utile lorsqu’on souhaite gérer le comportement des robots sur des ressources que l’on ne peut pas modifier directement en HTML. Par exemple, une directive

X-Robots-Tag: noindexdans la réponse HTTP d’un fichier PDF empêchera son indexation tout en permettant son téléchargement ou affichage via lien direct ; - Une suppression manuelle via Google Search Console : Cet outil mis à disposition par Google permet aux webmasters de demander la suppression temporaire d’une page déjà indexée. Cette opération est particulièrement utile en cas de publication accidentelle, de contenu obsolète ou sensible, ou encore lors d’une migration de site. Il est important de noter que cette demande ne désindexe pas définitivement la page : si aucune autre mesure technique n’est mise en place (comme un noindex ou un code 404/410), la page pourrait réapparaître ultérieurement dans les résultats ;

- Le fichier robots.txt : Ce fichier, situé à la racine du site, donne des instructions générales aux robots sur les zones à ne pas explorer. Toutefois, un blocage via robots.txt empêche uniquement le crawl, pas l’indexation. En effet, si une page bloquée est découverte par d’autres moyens (par exemple via un lien externe ou un sitemap), Google peut malgré tout l’indexer, sans en connaître le contenu exact. Pour une désindexation sûre, ce fichier doit être utilisé en complément d’autres techniques comme la balise noindex ou l’en-tête X-Robots-Tag ;

- Une erreur technique ou un code HTTP inadapté : Lorsqu’une page renvoie un code d’erreur comme 404 (page non trouvée), 410 (contenu définitivement supprimé) ou dans certains cas 403 (accès interdit), Google finit par la retirer de son index, considérant qu’elle n’est plus pertinente pour les utilisateurs. Cette désindexation n’est pas immédiate : selon la popularité de la page et la fréquence de crawl, elle peut prendre plusieurs jours ou semaines. Ces codes doivent être utilisés avec précaution pour éviter de désindexer involontairement des pages encore utiles.

Enfin, il faut noter qu’une page peut aussi être désindexée sans intervention humaine. Google prend parfois l’initiative de retirer des pages jugées de faible qualité, dupliquées ou redondantes, notamment lorsqu’elles ne répondent pas aux critères de pertinence ou de performance attendus.

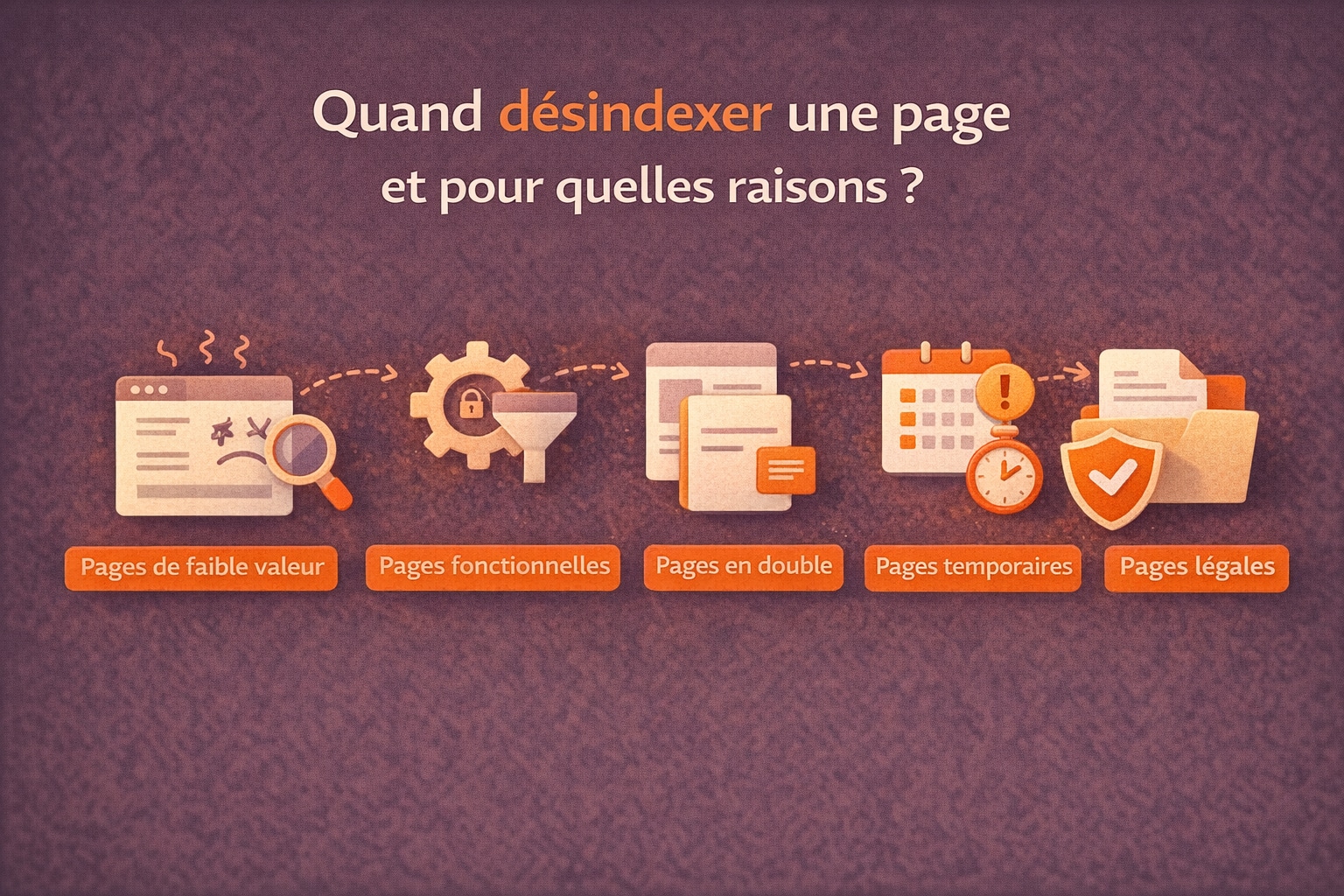

Quand faut-il désindexer une page et pour quelles raisons ?

Désindexer une page n’est pas une erreur en soi. Au contraire, dans une stratégie SEO bien pensée, cela peut s’avérer utile, voire bénéfique. L’objectif n’est pas de “cacher” du contenu au hasard, mais de renforcer la qualité globale du site en s’assurant que les moteurs de recherche ne consacrent du temps et de l’attention qu’aux pages réellement utiles, pertinentes et alignées avec vos objectifs (trafic, conversions, notoriété, autorité thématique). Autrement dit, désindexer revient souvent à assainir l’écosystème : vous réduisez le bruit, vous évitez de diluer vos signaux SEO, et vous facilitez la compréhension de votre offre ou de vos sujets par Google. C’est particulièrement vrai sur les sites qui accumulent des contenus avec le temps (blogs anciens, e-commerce, sites institutionnels), où certaines pages finissent par exister “par inertie” sans apporter de valeur. Voici les cas les plus fréquents où la désindexation est recommandée :

- Pages pauvres ou sans valeur ajoutée : Contenus trop courts, trop génériques, obsolètes, dupliqués, ou créés uniquement pour “faire du volume”. Ces pages peuvent affaiblir l’impression de qualité globale et monopoliser du crawl sans bénéfice réel ;

- Pages techniques ou fonctionnelles : Résultats de recherche interne, filtres de tri, pages de connexion, étapes de tunnel, zones d’administration, paramètres d’affichage… Elles sont nécessaires à l’expérience utilisateur, mais n’ont pas vocation à se positionner dans Google ;

- Pages en double : Lorsqu’un même contenu existe sous plusieurs URL (facettes e-commerce, tags trop proches, pagination mal gérée, versions imprimables, variantes d’URL). Désindexer aide à éviter la dilution et la confusion sémantique ;

- Pages temporaires ou de test : Brouillons publiés par erreur, pages de préproduction, landing pages de campagne périmées, tests A/B non finalisés, pages de staging. L’idée est de garder un index propre et maîtrisé ;

- Pages liées à des obligations légales : Mentions légales, CGV, politique de confidentialité, pages cookies… Elles doivent rester accessibles aux utilisateurs, mais ne visent généralement pas un objectif de visibilité organique.

La désindexation permet donc d’alléger l’index, de mieux canaliser le budget de crawl et de concentrer les efforts d’optimisation sur les pages qui comptent vraiment pour le positionnement. Elle participe aussi à limiter la dilution du PageRank et à réduire les risques de cannibalisation, en évitant que des pages concurrentes internes se disputent les mêmes requêtes.

Mais il y a un point de vigilance souvent sous-estimé : si vous désindexez une page, vous devez aussi contrôler ce qui, dans votre site, continue de la “pousser”. En pratique, une page désindexée ne devrait plus être alimentée par le maillage interne comme si elle était stratégique. Si elle reste largement liée depuis le menu, des catégories, des articles, des blocs “à lire aussi” ou des liens contextuels, vous envoyez des signaux contradictoires : d’un côté vous dites à Google “n’indexe pas”, de l’autre vous continuez à lui indiquer qu’elle est importante en lui transmettant du PageRank et en facilitant son crawl. Résultat : vous gaspillez une partie de votre potentiel de maillage et vous rendez l’architecture moins cohérente. La bonne pratique consiste donc, après une désindexation, à auditer et ajuster les liens internes : Supprimer ou remplacer les liens vers la page désindexée, rediriger vers une page équivalente si elle existe, ou encore la rendre accessible uniquement via des parcours utiles aux utilisateurs (sans sur-optimiser sa présence dans l’architecture SEO). Dans certains cas, on peut conserver un accès utilisateur (par exemple via un compte client), tout en évitant que la page soit mise en avant dans le site comme une page “SEO”.

Enfin, attention : Désindexer une page sans analyse préalable peut être contre-productif. Il est essentiel d’évaluer l’historique de trafic, les backlinks éventuels, la présence dans la longue traîne, et l’importance stratégique de la page avant de la retirer de l’index. Une page bien positionnée, même ancienne, peut continuer à générer un trafic qualifié, des conversions ou servir de point d’entrée pertinent. Dans le doute, une optimisation (enrichissement, fusion, redirection) peut parfois être plus rentable qu’une désindexation immédiate.

Comment savoir si une page est désindexée et quelles actions mener ?

Détecter les pages désindexées est une étape clé dans tout audit SEO, car une page peut être exclue de l’index pour de bonnes raisons… ou à cause d’un détail technique passé inaperçu. L’enjeu n’est pas seulement de constater l’absence d’indexation, mais de comprendre pourquoi la page n’est plus (ou n’a jamais été) prise en compte par Google, puis d’arbitrer entre plusieurs actions : réindexer, corriger, consolider, rediriger ou assumer la désindexation. Avant tout, il faut garder en tête une nuance importante : une page peut être crawlable (explorable par Googlebot) mais non indexable (exclue de l’index), ou inversement. Une page bloquée au crawl peut parfois rester indexée sous forme d’URL “nue” si Google la découvre via des liens externes. C’est précisément pour cela qu’il est utile de croiser plusieurs sources de données (GSC, crawl, logs serveur, analytics) afin d’éviter les faux diagnostics. Voici quelques méthodes pratiques :

- Google Search Console : Dans le rapport « Pages » (anciennement « Couverture »), les pages désindexées apparaissent avec des statuts et motifs explicites comme « Exclue par la balise noindex », « Bloquée par le fichier robots.txt », « Autre page avec balise canonical correcte », « Page avec redirection » ou encore « Explorée, actuellement non indexée ». L’intérêt de la Search Console est double : elle explique la cause la plus probable et elle permet de tester une URL précise via l’outil d’inspection (dernier crawl, indexabilité, canonical choisie par Google, ressources bloquées, etc.) ;

- Commande site (opérateur booléen) : : En tapant

site:votredomaine.com/url-de-la-page(ou simplementsite:votredomaine.compuis en filtrant), vous obtenez une indication rapide de l’indexation. Cette méthode reste utile pour des vérifications instantanées, mais elle n’est pas exhaustive : Google peut ne pas afficher toutes les pages indexées, et l’ordre d’affichage varie. Elle doit donc servir de signal d’alerte, pas de preuve unique ; - Outils de crawl (Screaming Frog, Sitebulb, etc.) : Ils détectent les balises

noindex, les canonical, les directives robots, les codes de réponse HTTP (200, 301, 404, 410…), et identifient les URL accessibles via le maillage interne. Cela permet de repérer les pages “poussées” par le site mais non indexables, ou au contraire des pages accessibles uniquement par URL directe (cas proche des pages orphelines). Un crawl est aussi très utile pour repérer des chaînes de redirection ou des pages qui devraient être indexées mais envoient des signaux contradictoires ; - Analyse des sitemaps : Comparer les URL présentes dans le sitemap XML avec les URL réellement indexées (via GSC) permet de repérer des incohérences. Si un grand nombre d’URL soumises sont exclues, cela signale souvent un problème d’indexabilité, de qualité perçue ou de configuration (canonical, noindex, duplication, facettes, etc.) ;

- Logs serveur (si disponibles) : L’analyse des logs indique si Googlebot visite réellement la page, à quelle fréquence, et quel code HTTP il reçoit. C’est un excellent moyen de différencier une page qui n’est plus crawlée (faible intérêt, lien interne absent) d’une page crawlée mais volontairement désindexée (noindex, canonical, etc.) ;

- Outils analytics : Si une page reçoit encore du trafic organique mais disparaît des impressions/clics dans la Search Console, cela peut indiquer une chute récente d’indexation ou une bascule vers une autre URL (canonical, redirection, réécriture). Croiser analytics et Search Console aide à mesurer l’impact réel de la désindexation.

Une fois la cause identifiée, les actions à mener dépendent de l’objectif : voulez-vous que la page revienne dans l’index ou souhaitez-vous au contraire confirmer son exclusion ? En fonction des résultats, voici les décisions possibles :

| Cas détecté | Action recommandée |

|---|---|

| Page désindexée par balise noindex | Retirer la balise si la page est stratégique, vérifier qu’elle renvoie bien un code 200, puis demander une réindexation via l’inspection d’URL. Contrôler aussi que le maillage interne la met réellement en avant. |

| Page bloquée par robots.txt | Ouvrir l’accès si l’objectif est l’indexation, ou maintenir le blocage si la page n’a pas vocation à être visible. Si vous souhaitez une désindexation nette, privilégier un noindex (accessible au crawl) plutôt qu’un simple blocage. |

| Erreur 404 ou 410 | Rediriger si la page a des liens entrants ou une valeur historique (backlinks, trafic, conversions). Sinon, laisser la page disparaître naturellement de l’index. Nettoyer le maillage interne pour supprimer les liens cassés. |

| Page exclue automatiquement | Améliorer le contenu (enrichissement, mise à jour, meilleure intention de recherche), renforcer le maillage interne, clarifier la canonical, réduire la duplication et améliorer les signaux qualité (UX, vitesse, structure). Sur certains cas, fusionner avec une page plus forte et rediriger. |

Dans la pratique, l’étape la plus importante après le diagnostic consiste à aligner tous les signaux. Par exemple, si vous voulez réindexer une page Web, il ne suffit pas d’enlever un noindex : Il faut aussi vérifier que la page est bien reliée depuis le site, qu’elle n’est pas en concurrence avec une autre URL similaire, que sa canonical pointe vers elle-même, qu’elle est présente dans le sitemap, et qu’elle répond à une intention de recherche identifiable. À l’inverse, si vous assumez la désindexation, il est recommandé de retirer les liens internes qui “poussent” la page (menus, blocs de suggestions, liens contextuels), pour éviter de gaspiller du PageRank et de brouiller la lecture de l’architecture.

Un suivi régulier des pages désindexées permet ainsi de garder le contrôle sur l’architecture du site, d’éviter les pertes de visibilité non anticipées, et de maintenir une cohérence entre l’intention SEO et les signaux envoyés aux moteurs. C’est aussi un excellent moyen d’anticiper les dérives d’un site qui grossit : plus un site s’enrichit, plus les risques d’incohérences d’indexation augmentent, et plus la discipline de monitoring devient une force.

0 commentaires