Lorsqu’on conçoit un site riche en contenus, la page d’accueil devient rapidement un espace stratégique. Elle sert à la fois de point d’entrée pour les visiteurs et de repère majeur pour les moteurs de recherche. Dans ce contexte, de nombreux éditeurs choisissent un affichage aléatoire des articles afin d’éviter une page figée, de donner de la visibilité à des contenus variés et de rompre la monotonie. Cette approche, séduisante en apparence, soulève pourtant de nombreuses questions du point de vue du référencement naturel. L’affichage aléatoire en page d’accueil est souvent adopté par des portails de ressources, des médiathèques en ligne ou des sites dont les contenus sont ajoutés par lots. L’objectif est clair : faire tourner les liens, exposer un maximum de pages et donner l’impression d’un site vivant, même lorsque les mises à jour ne sont pas régulières. Mais le SEO ne fonctionne pas uniquement à l’intuition. Il repose sur des signaux, des structures et une certaine stabilité que les moteurs de recherche analysent sur le long terme. Dans cet article, voyons ensemble l’impact seo de l’affichage aléatoire des articles en page d’accueil. Nous verrons ses avantages, ses limites, puis ses effets concrets sur le crawl, l’indexation et la circulation du PageRank interne, afin de déterminer dans quels cas cette stratégie peut être pertinente et comment l’utiliser sans nuire à la performance globale du site.

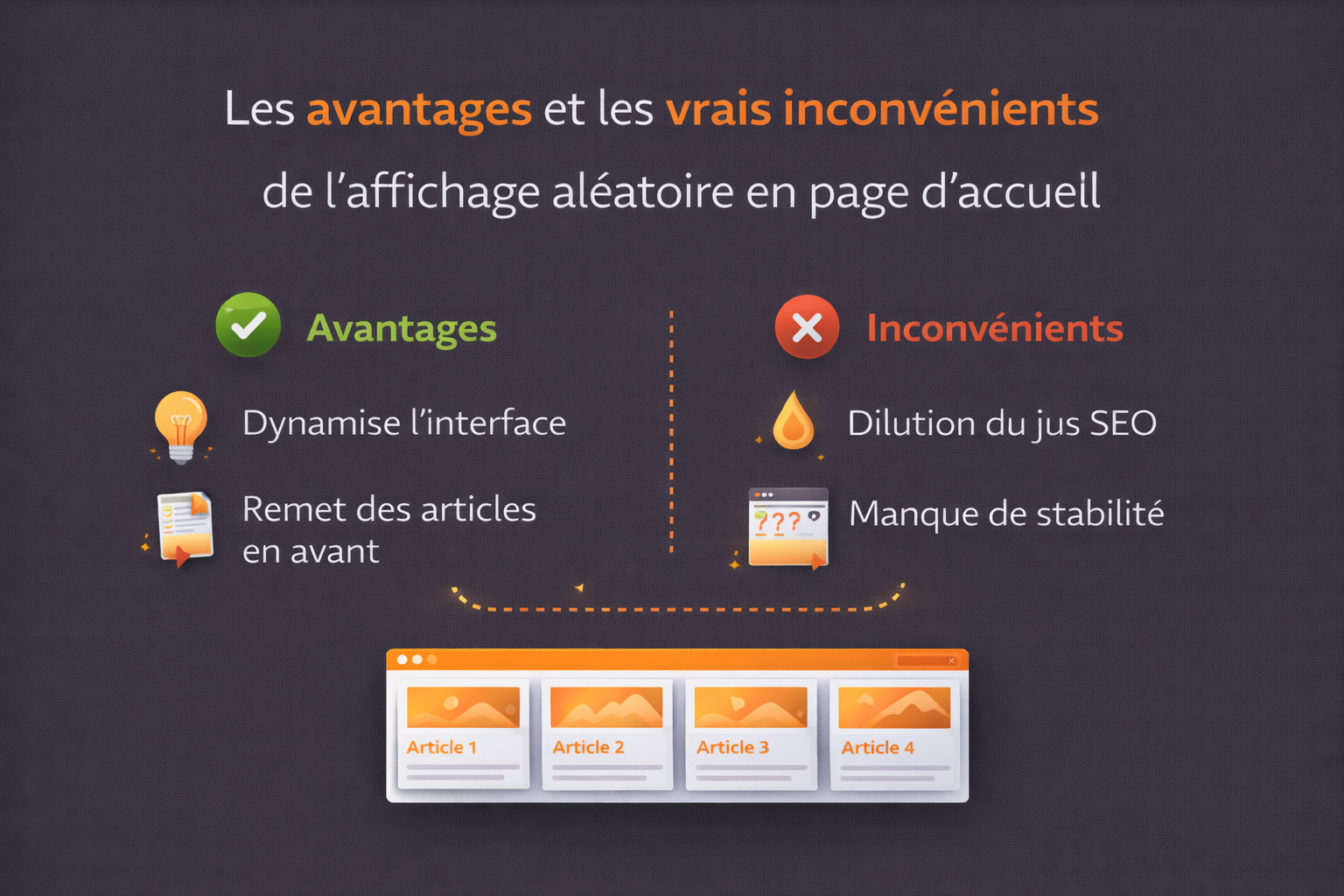

Les avantages et les vrais inconvénients de l’affichage aléatoire en page d’accueil

L’affichage aléatoire des contenus en page d’accueil est souvent perçu comme une solution séduisante, à la fois pour dynamiser l’interface et pour faire émerger des articles variés. Sur le plan de l’expérience utilisateur, cette approche peut effectivement donner l’impression d’un site vivant, en perpétuel renouvellement. Un visiteur régulier ne verra jamais exactement la même sélection de contenus, ce qui peut encourager la curiosité et l’exploration de pages qu’il n’aurait peut-être jamais consultées autrement. D’un point de vue éditorial, l’aléatoire permet également de redonner ponctuellement de la visibilité à des articles plus anciens. Au lieu de rester relégués dans les profondeurs de l’arborescence ou dans des archives peu consultées, certains contenus peuvent refaire surface en page d’accueil et bénéficier temporairement d’un regain d’attention. Pour des sites riches en contenus, cette logique peut sembler intéressante car elle évite une mise en avant exclusivement focalisée sur les dernières publications.

Cependant, ces bénéfices apparents masquent des limites structurelles importantes, en particulier sur le plan du référencement naturel. La première problématique concerne la diffusion du jus de lien. La page d’accueil est, dans la majorité des cas, la page la plus puissante d’un site, celle qui concentre le plus de popularité interne et externe. Chaque lien sortant depuis cette page participe à la redistribution de ce capital. Multiplier ou faire varier aléatoirement les liens internes revient à diluer ce jus de lien et à réduire mécaniquement le poids transmis à chaque page ciblée. Il est important de rappeler qu’un lien interne n’est jamais neutre. Créer un lien, c’est aussi accepter que la page source perde une partie de sa capacité de transmission. Lorsque les liens pointent vers des contenus sans réelle proximité sémantique avec la page d’accueil ou sans enjeu stratégique clair, cette dilution devient contre-productive. On se retrouve alors avec une page d’accueil affaiblie, qui transmet de manière dispersée une autorité pourtant précieuse.

À cela s’ajoute un second problème majeur : L’instabilité introduite par l’aléatoire. Du point de vue des moteurs de recherche, et notamment du crawl, la stabilité est un signal important. Une page clé dont les liens internes changent en permanence ajoute une couche supplémentaire de complexité pour l’exploration et l’interprétation du site. Une url peut être fortement exposée un jour, puis totalement absente le lendemain, sans logique apparente. Cette variabilité rend plus difficile l’identification des pages réellement structurantes dans l’architecture du site. De manière générale, les bonnes pratiques SEO privilégient la mise en place de liens en dur, c’est-à-dire des liens stables, réfléchis et intangibles dans le temps. Ces liens permettent aux moteurs de recherche de comprendre clairement la hiérarchie du site, les pages prioritaires et les relations sémantiques entre les contenus. L’aléatoire va à l’encontre de cette logique en introduisant une incertitude permanente.

L’affichage des derniers articles, par ordre chronologique, est souvent considéré comme une alternative plus raisonnable. Il présente en effet un avantage non négligeable : chaque nouveau contenu bénéficie automatiquement, pendant un temps donné, du jus de lien de la page d’accueil. Cela peut faciliter son indexation initiale et accélérer sa prise en compte par les moteurs de recherche. En revanche, cet effet est temporaire. Dès que de nouveaux articles sont publiés, les précédents disparaissent de l’accueil et perdent ce lien stratégique. Ce fonctionnement pose lui aussi question, car il crée une forme de volatilité du maillage interne. Les articles bénéficient d’un soutien SEO fort mais éphémère, ce qui peut être problématique pour des contenus à vocation durable. C’est pourquoi, si l’on choisit malgré tout d’afficher les derniers articles en page d’accueil, il est recommandé d’en limiter le volume, par exemple à trois maximum. Cela permet de contenir la dilution du jus de lien tout en conservant un minimum de dynamisme éditorial.

Ainsi, si l’affichage aléatoire est clairement défavorable d’un point de vue SEO, l’affichage chronologique n’est pas exempt de défauts non plus. Il reste toutefois moins impactant, car il conserve une certaine logique temporelle et offre au moins une opportunité d’indexation facilitée pour les nouveaux contenus. Dans tous les cas, ces solutions ne doivent jamais remplacer un maillage interne structuré, pensé sur le long terme, avec des liens en dur orientés vers les pages réellement stratégiques du site.

Les effets de l’affichage aléatoire sur le crawl et l’indexation Google

Pour mesurer précisément l’impact de l’affichage aléatoire sur le crawl et l’indexation, il est indispensable de revenir sur le fonctionnement réel des moteurs de recherche, et en particulier de Googlebot. Le crawl repose sur une logique de découverte et de priorisation des urls à partir d’un ensemble de points d’entrée, parmi lesquels la page d’accueil occupe une place centrale. Cette page est généralement la plus fortement crawlée, la plus populaire en termes de liens entrants et celle qui sert de point de départ à la majorité des parcours d’exploration. Googlebot fonctionne avec un budget de crawl limité, alloué à chaque site en fonction de plusieurs signaux : popularité globale du domaine, fréquence de mise à jour, qualité perçue des pages, performances serveur et stabilité de l’architecture interne. À l’intérieur de ce budget, le robot hiérarchise les urls à explorer en s’appuyant notamment sur la structure des liens internes. Les pages qui reçoivent des liens stables, répétés et situés haut dans l’arborescence, en particulier depuis la page d’accueil, sont perçues comme prioritaires et explorées plus fréquemment.

Lorsque les liens présents en page d’accueil varient de manière aléatoire, cette hiérarchisation devient plus floue. À court terme, l’aléatoire peut effectivement accélérer la découverte d’un volume important d’urls, notamment sur des sites publiant régulièrement de nouveaux contenus ou disposant d’un stock important de pages peu maillées. Googlebot, en rencontrant des liens différents à chaque passage, peut crawler plus rapidement des pages qui, dans une structure plus classique, auraient mis davantage de temps à être découvertes. Cependant, ce bénéfice ponctuel se paie sur le moyen et le long terme. La variabilité constante des liens de la page d’accueil introduit une instabilité dans les signaux envoyés au moteur. Googlebot ne se contente pas de découvrir des urls, il analyse aussi la récurrence des liens pour estimer l’importance relative des pages. Une url qui apparaît de façon intermittente en page d’accueil reçoit un signal faible et incohérent : elle est parfois mise en avant comme prioritaire, puis disparaît totalement du périmètre de crawl principal.

Cette instabilité affecte directement la fréquence de crawl. Les pages soutenues par des liens en dur, positionnés de manière fixe dans la navigation ou sur la page d’accueil, sont explorées de façon régulière, parfois plusieurs fois par jour sur des sites à fort trafic. À l’inverse, une page uniquement visible de manière aléatoire peut être crawlée de façon sporadique, avec des intervalles parfois très longs, surtout si elle se situe à une profondeur élevée dans l’arborescence et ne bénéficie pas d’un maillage transversal suffisant. Un autre point technique souvent sous-estimé concerne la consommation du budget de crawl. À chaque passage sur la page d’accueil, Googlebot doit réanalyser l’ensemble des liens présents pour détecter les variations. Lorsque ces liens changent en permanence, le robot consacre une partie de son budget à recalculer des chemins internes instables, au détriment de l’exploration approfondie de pages réellement stratégiques. Sur des sites volumineux, cela peut entraîner une exploration inefficiente, avec un crawl dispersé et moins prévisible.

En matière d’indexation, l’affichage aléatoire n’est pas véritablement bloquant en soi. Google est capable d’indexer une page même si elle n’est visible que temporairement en page d’accueil. En revanche, l’indexation durable et la mise à jour régulière des contenus indexés dépendent fortement de la profondeur de clic et de la cohérence du maillage interne. Une page qui oscille entre une visibilité maximale et une invisibilité totale peut être indexée, mais rester longtemps dans un état de faible priorité, avec des mises à jour de cache et de signaux retardées. Sur les sites de grande taille, cette problématique est amplifiée. Si l’affichage aléatoire devient le principal levier pour faire remonter des contenus, certaines urls peuvent rester durablement à plus de trois ou quatre clics de la page d’accueil. Or, au-delà de ce seuil, Googlebot tend à réduire la fréquence de crawl, surtout si les pages concernées n’envoient pas de signaux forts de popularité ou de fraîcheur. L’indexation initiale peut alors être lente, voire partielle, et certaines pages risquent de ne jamais atteindre leur plein potentiel de visibilité. De plus, l’absence de liens fixes vers les catégories ou silos thématiques affaiblit la compréhension globale de la structure du site. Google s’appuie sur les liens internes pour inférer les relations sémantiques entre les pages. Un maillage instable, dominé par l’aléatoire, rend plus difficile l’identification des thématiques majeures, des pages piliers et des contenus secondaires. Cela peut avoir un impact indirect sur le positionnement, en diluant la pertinence sémantique perçue.

Pour toutes ces raisons, l’affichage aléatoire doit être envisagé comme un mécanisme secondaire, éventuellement utile pour la découverte ponctuelle de contenus, mais jamais comme un pilier central de la stratégie de crawl et d’indexation. La base doit rester constituée de liens en dur, stables dans le temps, positionnés sur la page d’accueil et dans la navigation principale, permettant à Googlebot de comprendre clairement la hiérarchie, les priorités et la logique éditoriale du site. Ce n’est qu’en s’appuyant sur cette stabilité que l’on peut, le cas échéant, introduire des éléments dynamiques sans compromettre l’efficacité du crawl ni la lisibilité de l’architecture interne aux yeux des moteurs de recherche. La meilleure approche consiste souvent à combiner stabilité et dynamisme. Une page d’accueil structurée autour de blocs fixes, représentant les thématiques majeures et les contenus prioritaires, peut être enrichie par un espace dédié à l’aléatoire. Cette combinaison permet de préserver une architecture claire tout en profitant des bénéfices de la variation.

En SEO, il ne s’agit pas de choisir entre rigidité et mouvement, mais de trouver un équilibre cohérent avec les objectifs du site, son volume de contenu et les attentes des utilisateurs. L’affichage aléatoire, bien encadré, peut alors devenir un levier complémentaire plutôt qu’un facteur de fragilisation.

0 commentaires