Dans l’univers du référencement naturel, la visibilité d’un site web dépend fortement de sa présence dans l’index de Google et des autres moteurs de recherche. Mais que se passe-t-il lorsqu’une page n’est plus indexée ? Est-ce toujours un problème ? Pas nécessairement. C’est là qu’intervient une notion essentielle : la désindexation. Si l’indexation est synonyme de visibilité, la désindexation, elle, peut être subie ou, au contraire, volontaire et stratégique. Dans cet article, nous allons explorer en profondeur ce que signifie la désindexation en SEO, dans quels cas elle est nécessaire, comment elle fonctionne techniquement, et quelles sont ses implications pour la performance d’un site.

La définition et l’origine de la désindexation en SEO

En SEO, la désindexation désigne le retrait d’une ou plusieurs pages d’un site web de l’index d’un moteur de recherche. Concrètement, cela signifie que la page n’est plus référencée dans les résultats de recherche (SERP), bien qu’elle reste techniquement accessible via son URL. Cela s’oppose à l’indexation, processus par lequel une page est reconnue, interprétée, puis stockée dans la base de données d’un moteur, afin d’être affichée lorsqu’une requête pertinente est formulée par un utilisateur.

Ce mécanisme s’inscrit dans un schéma technique en trois étapes, fondamental au fonctionnement des moteurs de recherche :

- Crawl : les robots (ou crawlers), comme Googlebot, naviguent sur le web et visitent les pages disponibles ;

- Indexation : les pages explorées sont analysées, puis intégrées à l’index de Google (ou d’un autre moteur), une base de données géante structurée ;

- Classement (ranking) : lors d’une recherche, l’algorithme trie les pages de l’index selon leur pertinence, et les affiche par ordre de priorité dans les SERP.

La désindexation, qui survient entre l’indexation et le classement, empêche donc l’affichage de la page, mais pas son exploration (sauf si elle est bloquée par d’autres directives, comme le fichier robots.txt). C’est une distinction importante : une page peut être désindexée, mais toujours crawlée, ce qui permet aux moteurs de suivre les liens qu’elle contient, d’évaluer sa pertinence globale ou de détecter des signaux utiles pour d’autres pages du site.

La désindexation est un besoin apparu avec l’explosion des contenus

La notion de désindexation s’est structurée au fil de l’évolution du web. À la fin des années 1990 et au début des années 2000, l’enjeu principal pour les webmasters était d’être indexé. Plus une page était présente dans l’index, plus elle avait de chances d’apparaître sur des requêtes. C’était l’époque où l’on cherchait à tout prix à multiplier les pages, souvent de manière artificielle, avec des techniques comme le cloaking, les pages satellites ou le bourrage de mots-clés. Mais à partir de 2005, avec la généralisation des CMS comme WordPress, Joomla ou Drupal, la création de contenus automatisés devient massive. Chaque filtre, tag, pagination ou variation d’URL peut générer une nouvelle page. Résultat : les sites génèrent rapidement des centaines voire des milliers de pages peu qualitatives, sans intérêt éditorial, souvent redondantes. C’est là que la désindexation commence à apparaître comme une solution, non pour cacher, mais pour optimiser la visibilité.

Des évolutions majeures côté moteur de recherche (Google)

L’importance de la désindexation s’est accentuée avec certaines mises à jour algorithmiques majeures déployées par Google :

- Google Panda (2011) : cette mise à jour a ciblé les sites à contenu faible ou dupliqué. Pour y échapper, de nombreux webmasters ont commencé à désindexer les pages pauvres afin de ne garder que les pages les plus qualitatives dans l’index ;

- Google Penguin (2012) : même si cette mise à jour visait principalement les profils de liens abusifs, elle a renforcé l’attention portée à la qualité globale d’un site, y compris son maillage interne. Les pages sans valeur, non liées ou isolées, ont ainsi été désindexées pour éviter d’affaiblir le site.

- Fred Update (2017) : cette mise à jour non confirmée officiellement par Google a touché de nombreux sites de faible qualité, souvent monétisés de façon agressive. Là encore, la désindexation s’est imposée comme un moyen de nettoyer l’index pour conserver une empreinte plus qualitative.

Ces évolutions illustrent une réalité désormais bien intégrée dans les stratégies SEO : plus n’est pas toujours mieux. Il est préférable d’avoir 100 pages bien positionnées et utiles, que 1 000 pages qui nuisent à la perception globale du site.

Une notion liée aux performances d’indexation

Sur le plan technique, la désindexation s’inscrit également dans une logique de gestion des ressources de crawl. Google, comme les autres moteurs, alloue un budget de crawl à chaque site. Cela signifie que le nombre de pages explorées chaque jour est limité. Si une part importante de ce budget est gaspillée sur des pages peu utiles, cela peut freiner l’exploration des contenus stratégiques. Désindexer les pages inutiles permet donc d’optimiser ce budget, en libérant les robots pour les pages à plus forte valeur ajoutée. La désindexation est aussi un signal indirect donné au moteur : elle montre que l’éditeur du site prend le contrôle de sa structure, assume ses choix de visibilité, et ne cherche pas à gonfler artificiellement son empreinte web. Dans certains cas, notamment en audit SEO, une désindexation massive bien menée peut améliorer la performance organique globale d’un site de manière significative, sans créer une seule nouvelle page.

Pourquoi désindexer une page : usages, enjeux et bonnes pratiques

Longtemps perçue comme un signe d’échec ou de pénalisation, la désindexation est possiblement un levier stratégique du SEO moderne. Elle ne signifie pas forcément qu’une page est mauvaise ou qu’elle doit être supprimée. Bien au contraire, dans de nombreux cas, elle permet de mieux contrôler la visibilité d’un site et de concentrer les efforts de référencement sur les pages réellement utiles. Encore faut-il savoir quand et comment s’en servir…

Les cas où la désindexation peut être volontaire et bénéfique

Dans une logique d’optimisation du crawl, de la qualité éditoriale et de la cohérence thématique, il peut être pertinent de désindexer certaines pages. Voici les cas les plus fréquents :

- Pages pauvres en contenu : Lorsqu’une page ne contient qu’un texte minimal, sans valeur informative ou sémantique, elle peut nuire à la perception globale de qualité du site. Cela concerne souvent des pages générées automatiquement, des résultats de filtres ou des fiches produit trop succinctes. Les désindexer permet d’éviter de « diluer » la valeur globale du site aux yeux de Google.

- Pages dupliquées : Dans les sites e-commerce ou les blogs, il est fréquent d’avoir des versions similaires d’un même contenu (produits avec déclinaisons, pages imprimables, versions AMP, archives mensuelles…). Même avec des balises

canonical, la désindexation peut s’imposer pour éviter que ces doublons n’impactent négativement le référencement. - Pages techniques ou utilitaires : Mentions légales, politique de confidentialité, CGU, panier, étapes de tunnel d’achat… ces pages ne visent pas à se positionner dans les SERP. Les désindexer permet d’orienter les robots vers des contenus plus stratégiques.

- Pages obsolètes ou en refonte : Lors d’une migration, d’une refonte ou d’un audit SEO, certaines pages ne sont plus d’actualité ou doivent être remplacées. Les désindexer permet de gérer proprement leur disparition progressive des résultats, tout en redirigeant vers les nouvelles versions.

- Pages privées ou restreintes : Tout contenu destiné à des utilisateurs identifiés (intranet, espace client, contenus premium, documents confidentiels…) ne doit pas apparaître publiquement dans Google. Il est donc essentiel de le désindexer pour éviter toute exposition non souhaitée.

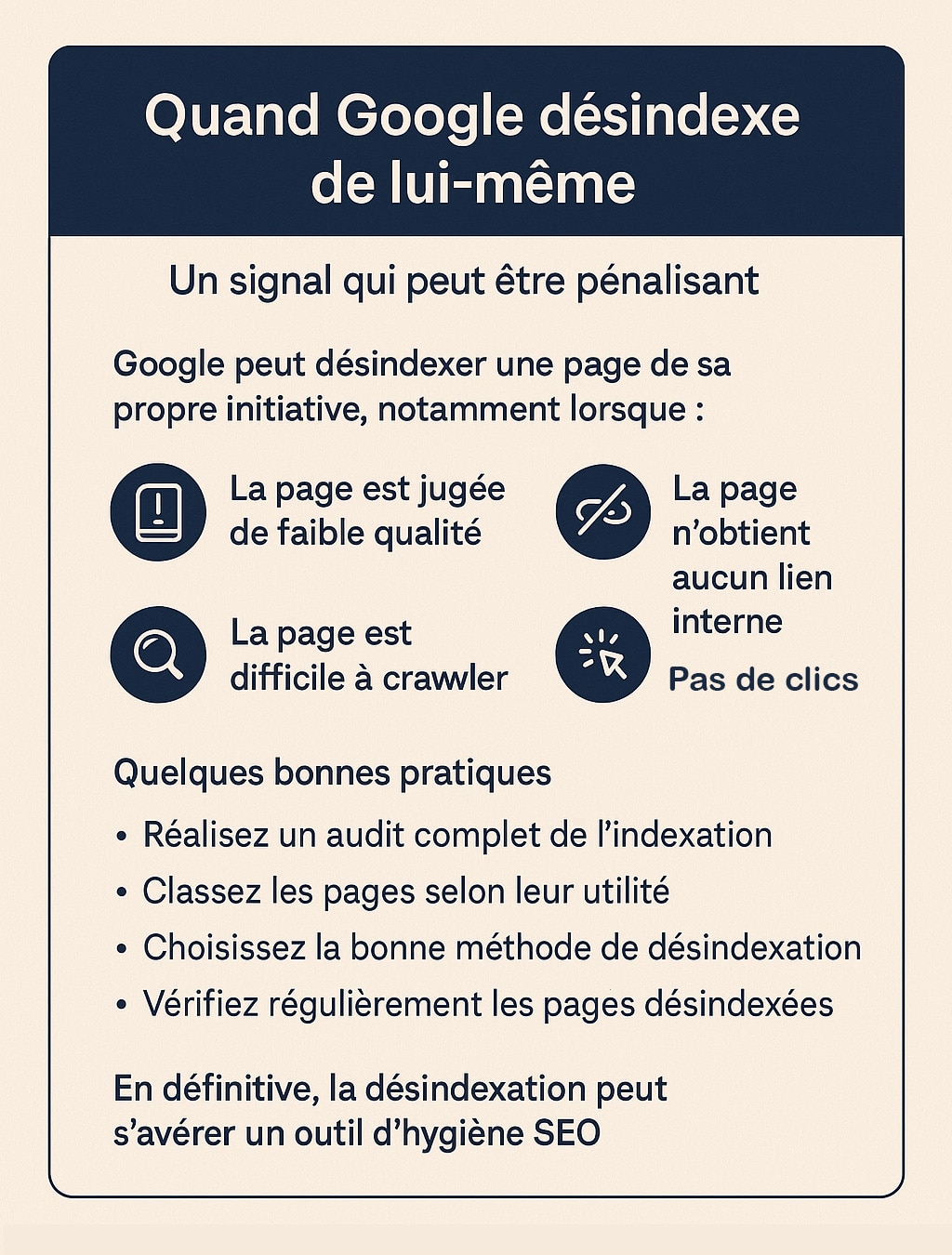

Quand Google désindexe de lui-même : Un signal qui peut être évidemment pénalisant

Il est important de comprendre que la désindexation ne provient pas toujours d’une décision du webmaster. Google peut aussi désindexer des pages de sa propre initiative, sans demande explicite de votre part. Cela se produit notamment lorsque :

- La page est jugée de faible qualité : Trop lente, vide, ou avec un contenu redondant (même avec un fort volume de texte parfois) déjà présent ailleurs.

- La page est difficile à crawler : Erreurs techniques, ressources bloquées, JavaScript non interprétable.

- La page n’obtient aucun lien interne : Une page orpheline (non liée) est souvent ignorée par Googlebot.

- La page n’est jamais consultée : Si une page ne génère ni clics, ni impressions dans Google, le moteur peut décider qu’elle n’a pas lieu d’être indexée.

Ces désindexations « automatiques » peuvent surprendre, voire inquiéter, surtout lorsqu’elles concernent des pages que vous considérez comme importantes. Mais elles sont en réalité une façon pour Google de maintenir la qualité de son index. Pour réagir efficacement :

- Utilisez Google Search Console : Dans le rapport « Pages », consultez la section « Non indexée » pour comprendre les raisons invoquées par Google.

- Corrigez les problèmes détectés : Enrichissez le contenu, améliorez les temps de chargement, ajoutez des liens internes, corrigez les balises mal configurées.

- Soumettez manuellement les pages à l’index via l’inspecteur d’URL dans Search Console, une fois les corrections effectuées.

Dans certains cas, la réindexation ne sera pas immédiate, surtout si la page reste jugée peu pertinente. Il est alors plus judicieux de repenser son rôle dans votre stratégie globale : Vaut-elle vraiment la peine d’être conservée dans l’index ? Ne vaut-il tout simplement pas faire une redirection 301 ? Nous en reparlons un peu plus loin dans l’article.

Quelques bonnes pratiques pour une désindexation maîtrisée

Pour faire de la désindexation un atout et non un risque, elle doit s’intégrer dans une approche globale, réfléchie et pilotée. Voici les recommandations à suivre :

- Réalisez un audit complet de l’indexation avec des outils comme Google Search Console, Screaming Frog, OnCrawl ou Ahrefs. Identifiez les pages sans trafic, sans valeur SEO ou problématiques ;

- Classez les pages selon leur utilité : pages à conserver, à améliorer ou à désindexer. Appuyez-vous sur des critères de performance (visites, backlinks, mots-clés positionnés), de contenu, et de maillage interne ;

- Choisissez la bonne méthode de désindexation (balise

noindex, header HTTP, Search Console, erreur 410…) selon le type de page et l’objectif visé ; - Vérifiez régulièrement les pages désindexées pour éviter des suppressions non désirées. Les erreurs sont fréquentes, surtout lors de migrations ou de modifications massives ;

- Gardez une documentation claire des pages désindexées volontairement, pour suivre leur évolution, et ne pas les réintégrer accidentellement plus tard.

En définitive, la désindexation peut s’avérer un outil d’hygiène SEO. Comme on épure un inventaire, elle permet de clarifier le positionnement du site, d’optimiser la compréhension des moteurs et de favoriser l’indexation des contenus les plus stratégiques. Utilisée intelligemment, elle contribue à construire un site plus lisible, plus performant et mieux aligné avec les attentes de l’algorithme… et de vos utilisateurs.

Les méthodes techniques pour désindexer une page d’un moteur de recherche

La désindexation d’une page web peut être obtenue par plusieurs moyens techniques, chacun ayant ses particularités, ses limites et ses contextes d’usage. Le choix de la méthode dépend du type de contenu, de l’objectif poursuivi (temporaire ou permanent), et du degré de contrôle souhaité sur l’exploration de la page par les robots. Voici les principales méthodes utilisées en SEO pour désindexer une page de façon maîtrisée :

| Méthode | Explication et cas d’usage |

|---|---|

<meta name="robots" content="noindex"> |

Cette balise HTML, placée dans l’en-tête (<head>) d’une page, indique aux moteurs de recherche de ne pas indexer le contenu, tout en autorisant l’exploration. C’est la méthode la plus utilisée pour désindexer proprement une page sans la bloquer aux robots.Cas d’usage : pages de faible valeur SEO, contenus utilitaires, fiches produits en rupture, pages de filtres. |

X-Robots-Tag: noindex |

Ce tag HTTP fonctionne comme la balise meta noindex, mais s’applique directement dans l’en-tête de la réponse serveur (HTTP header). Il est particulièrement utile pour les formats non-HTML comme les PDF, images, documents Office ou pages générées dynamiquement.Cas d’usage : fichiers téléchargeables, pages servies via une API, contenus non éditoriaux. |

robots.txt |

Ce fichier placé à la racine du site web permet de bloquer l’exploration de certaines parties du site par les crawlers. Attention : un blocage via robots.txt n’empêche pas toujours l’indexation si Google connaît déjà l’URL via des liens externes.Cas d’usage : zones sensibles (admin, scripts), pages de test, dossiers techniques. À utiliser avec précaution. |

| Google Search Console (suppression d’URL) | L’outil de suppression temporaire d’URL permet de retirer rapidement une page ou un ensemble de pages des résultats de recherche Google pendant environ 6 mois. Cette solution n’est pas une méthode de désindexation permanente, mais elle est utile pour un retrait immédiat. Cas d’usage : fuites d’informations, contenu sensible, erreur de publication, suppression urgente. |

| Code de statut HTTP 404 ou 410 | Un code 404 (page non trouvée) ou 410 (page définitivement supprimée) indique aux robots que la page n’existe plus. Google finit par désindexer ce type de page après quelques crawls. Le 410 est plus rapide et plus définitif que le 404. Cas d’usage : anciennes URL inutiles, suppression de contenu obsolète, nettoyage de masse post-refonte mais surtout réponse à un hack suite à un blast SEO. |

Quelle méthode privilégier pour désindexer une page ?

Parmi ces options, la balise noindex reste la plus souple et la plus maîtrisée. Contrairement à un blocage via robots.txt, elle autorise Google à accéder au contenu, ce qui permet de maintenir la logique du maillage interne et d’éviter les pages orphelines ou mal comprises. C’est particulièrement important pour les sites structurés en silo ou en cluster, où la compréhension du lien entre les pages est un facteur de positionnement. En revanche, les méthodes plus radicales comme le code 410 ou la suppression via Google Search Console doivent être réservées aux cas où le contenu doit disparaître rapidement ou définitivement de l’index. Elles coupent l’accès à la page de manière frontale, et ne permettent plus aux robots de suivre les liens internes qui y figurent.

Recommandations pour une désindexation efficace : Si vous souhaitez en faire une

- Vérifiez que la page n’est pas bloquée par

robots.txtavant d’ajouter une balisenoindex. Si elle l’est, Google ne pourra pas lire la balise et la page restera potentiellement indexée ; - Associez la désindexation à un suivi dans Search Console pour vérifier si le moteur a bien pris en compte la directive ;

- Évitez les erreurs techniques : une mauvaise configuration du serveur ou des balises contradictoires (ex. :

noindex, followsur une page bloquée en crawl) peut empêcher le moteur de comprendre vos intentions ; - Documentez toutes vos actions dans une feuille de suivi, surtout en cas de désindexation massive ou lors d’une refonte de site.

La désindexation est une opération fine qui demande rigueur et planification. Mal utilisée, elle peut entraîner une perte de trafic, une mauvaise interprétation du site ou des erreurs de crawl. Bien maîtrisée, elle devient un outil puissant pour sculpter la présence d’un site dans l’index, renforcer son autorité sur ses pages clés, et maintenir un profil SEO propre et cohérent.

Pour aller plus loin sur la désindexation non voulue : Des outils complémentaires pour forcer l’index

Comme nous l’avons vu plus haut, il arrive que Google désindexe automatiquement une page, sans que cela soit souhaité. Cela peut être dû à un contenu jugé trop pauvre, à un problème technique ou à une absence de liens internes. Bien que le problème soit fort probablement structurel, il existe plusieurs outils pour forcer ou accélérer l’indexation lorsqu’une page mérite d’être visible dans les résultats de recherche. En voici une rapide présentation sachant que de notre point de vue, il convient de les utiliser de manière modérée.

Utiliser l’outil de la Google Search Console

Le moyen le plus direct pour tenter de réindexer une page est d’utiliser l’outil d’inspection d’URL dans Google Search Console. Cet outil permet d’analyser l’état actuel d’une page et d’en demander manuellement l’indexation si elle n’apparaît plus dans les résultats de recherche.

| Fonctionnalité | Description |

|---|---|

| Inspection d’URL | Permet de vérifier si une page est indexée, détecter d’éventuels problèmes (balise noindex, redirection, erreur serveur…) et afficher la dernière date de crawl. |

| Demande d’indexation | Si la page n’est pas indexée, un clic sur « Demander une indexation » relance le crawl. Google décidera ensuite de la réintégrer, ou non, en fonction de sa qualité et de son accessibilité. |

L’ajout au sitemap XML : Un pré-requis qui ne garantit pas tout

Le sitemap XML reste une solution simple et efficace pour signaler aux moteurs les pages importantes d’un site. Il doit être à jour, exempt d’erreurs, et soumis via Google Search Console.

| Avantage | Description |

|---|---|

| Signal de priorité | Le sitemap aide Google à détecter rapidement les nouvelles pages ou celles mises à jour. Il complète l’analyse du crawl naturel. |

| Structure optimisée | Un sitemap bien conçu exclut les pages non indexables (404, 301, noindex) et ne contient que les URL utiles au SEO. |

Le renforcement du maillage interne : Une solution généralement pérenne

Le maillage interne est essentiel pour aider les robots à découvrir ou redécouvrir des pages. Plus une page reçoit de liens internes depuis des contenus stratégiques, plus elle a de chances d’être explorée à nouveau.

| Technique | Impact sur l’indexation |

|---|---|

| Liens depuis des pages à fort trafic | Augmente la probabilité de crawl grâce à une meilleure visibilité dans le parcours utilisateur et dans les logs serveur. |

| Intégration dans les menus, catégories ou contenus connexes | Facilite l’accès régulier des robots à la page. Une page bien intégrée dans la structure du site est perçue comme plus importante. |

Les autres leviers pour lutter contre la désindexation des pages

En complément des méthodes précédentes, certains outils ou protocoles peuvent accélérer l’indexation ou alerter les moteurs sur une mise à jour de page.

| Outil ou méthode | Description |

|---|---|

| Ping automatique | Fonction intégrée à WordPress et d’autres CMS qui notifie automatiquement les moteurs lors de la publication ou mise à jour d’un contenu. |

| Protocole IndexNow | Proposé par Bing et Yandex, ce protocole permet d’alerter directement les moteurs lorsqu’un contenu est modifié. Google y expérimente de manière partielle. |

| API d’indexation Google | Permet d’envoyer une demande directe à Google pour certains types de contenus spécifiques (offres d’emploi, vidéos). Nécessite une implémentation côté serveur. |

Si une page précieuse disparaît des résultats sans que vous l’ayez voulu, ces outils offrent des moyens de relancer son indexation. Toutefois, aucune méthode ne garantit une réintégration automatique. Il est essentiel que la page respecte les bonnes pratiques techniques, qu’elle soit bien reliée au reste du site et qu’elle propose un contenu utile pour les utilisateurs.

Forcer l’indexation, c’est en quelque sorte un élément extrême qui doit trouver des réponses ailleurs. Si Google n’en veut pas, vous devez trouver les raisons qui motivent sa désindexation et y remédier.

0 commentaires