Quand on veut gagner en visibilité sur le web, le SEO est souvent l’un des premiers leviers à activer. Mais pour qu’il soit vraiment efficace, il ne suffit pas d’aligner quelques mots-clés ou de publier du contenu au hasard. Le référencement naturel demande une vraie réflexion, une vision claire sur le long terme, et surtout un plan bien construit. Imaginons que le SEO soit une chasse au trésor : sans carte ni boussole, difficile d’arriver au bon endroit. Dans cet article, voyons comment pas à pas nous pouvons construire une stratégie SEO solide, en passant par la technique, le contenu, l’analyse de données et l’étude de la concurrence.

Commencer par définir ses objectifs et analyser l’existant du site Internet

La création d’un plan stratégique en SEO commence inévitablement par la définition d’objectifs précis. Il ne s’agit pas seulement de vouloir « améliorer le référencement » de manière vague, mais bien de formuler des intentions concrètes, mesurables et directement liées aux enjeux globaux de l’organisation. Cette phase préparatoire est essentielle pour construire une stratégie cohérente et pertinente, adaptée aux besoins spécifiques de l’entreprise et à son positionnement sur le marché. Les objectifs SEO peuvent généralement se répartir en trois grandes catégories :

- Les objectifs commerciaux : L’un des rôles principaux du SEO est de soutenir la croissance du chiffre d’affaires ou de la base clients. Cela peut se traduire par la génération d’un volume plus important de ventes sur un site e-commerce, l’augmentation des demandes de devis dans un contexte B2B, ou encore le développement du nombre d’inscriptions à une newsletter, un webinaire ou une plateforme en ligne. Ces objectifs visent à transformer le trafic organique en actions concrètes, mesurables et alignées avec les indicateurs de performance commerciaux définis par l’entreprise ;

- Les objectifs marketing : Le référencement naturel joue également un rôle stratégique dans le positionnement de la marque sur son marché. Il peut aider à accroître la notoriété d’une entreprise auprès de nouvelles audiences, à améliorer sa visibilité sur des thématiques ciblées ou à renforcer sa présence sur des requêtes spécifiques liées à ses offres. Un bon positionnement sur Google permet aussi de capter un trafic plus qualifié, c’est-à-dire composé d’utilisateurs ayant une réelle intention d’achat ou d’interaction, et d’optimiser les étapes du tunnel de conversion via un contenu adapté à chaque niveau de maturité du prospect ;

- Les objectifs techniques : Le SEO ne se limite pas au contenu ou aux mots-clés : la performance technique du site est un pilier fondamental. Un site rapide, fluide et bien structuré favorise à la fois une meilleure expérience utilisateur et une meilleure compréhension par les moteurs de recherche. Les objectifs techniques peuvent inclure la réduction des temps de chargement (notamment via les Core Web Vitals), l’optimisation de l’ergonomie sur mobile, la correction des erreurs d’exploration (pages non indexées, erreurs 404, redirections mal configurées), ainsi que la mise en conformité avec les bonnes pratiques de sécurité (passage en HTTPS, gestion des cookies, protection des données personnelles, etc.). Tous ces éléments participent à l’indexabilité du site et influencent directement son classement dans les résultats de recherche.

Une fois ces objectifs définis, il convient de réaliser un état des lieux précis du site existant. Cela passe par un audit SEO complet, qui permettra d’identifier les points de blocage, les opportunités d’optimisation, et de poser des bases solides pour le déploiement de la stratégie. L’audit SEO se décompose généralement en trois volets complémentaires :

- L’audit technique : Il s’agit de vérifier la bonne indexation des pages par les moteurs de recherche, d’évaluer les temps de chargement (notamment via les Core Web Vitals), d’analyser la structure des URLs, la compatibilité mobile (responsive design), ainsi que l’utilisation correcte des balises HTML fondamentales (title, meta description, H1, Hn, balises ALT, etc.) ;

- L’audit sémantique : Cette analyse porte sur la qualité du contenu proposé : pertinence thématique par rapport aux mots-clés visés, richesse lexicale, structure des textes, taux de duplication, cannibalisation éventuelle entre plusieurs pages, ou encore la présence d’un champ lexical cohérent avec les intentions de recherche des utilisateurs ;

- L’audit off-site : Ce volet évalue la popularité du site sur le web. Il s’agit notamment de cartographier le profil de liens (backlinks), d’en évaluer la qualité (autorité, diversité, thématique), de repérer les éventuels liens toxiques pouvant nuire au référencement, et d’analyser la visibilité de la marque sur d’autres canaux (réseaux sociaux, citations locales, mentions dans des articles, etc.).

L’ensemble de ces données issues des audits permet non seulement de dresser un diagnostic complet de la situation actuelle du site, mais aussi de prioriser les actions à mettre en œuvre. Ce socle analytique servira de référence tout au long de la stratégie SEO, permettant de mesurer les progrès réalisés au fil du temps, d’ajuster les actions en fonction des résultats, et de mieux allouer les ressources disponibles.

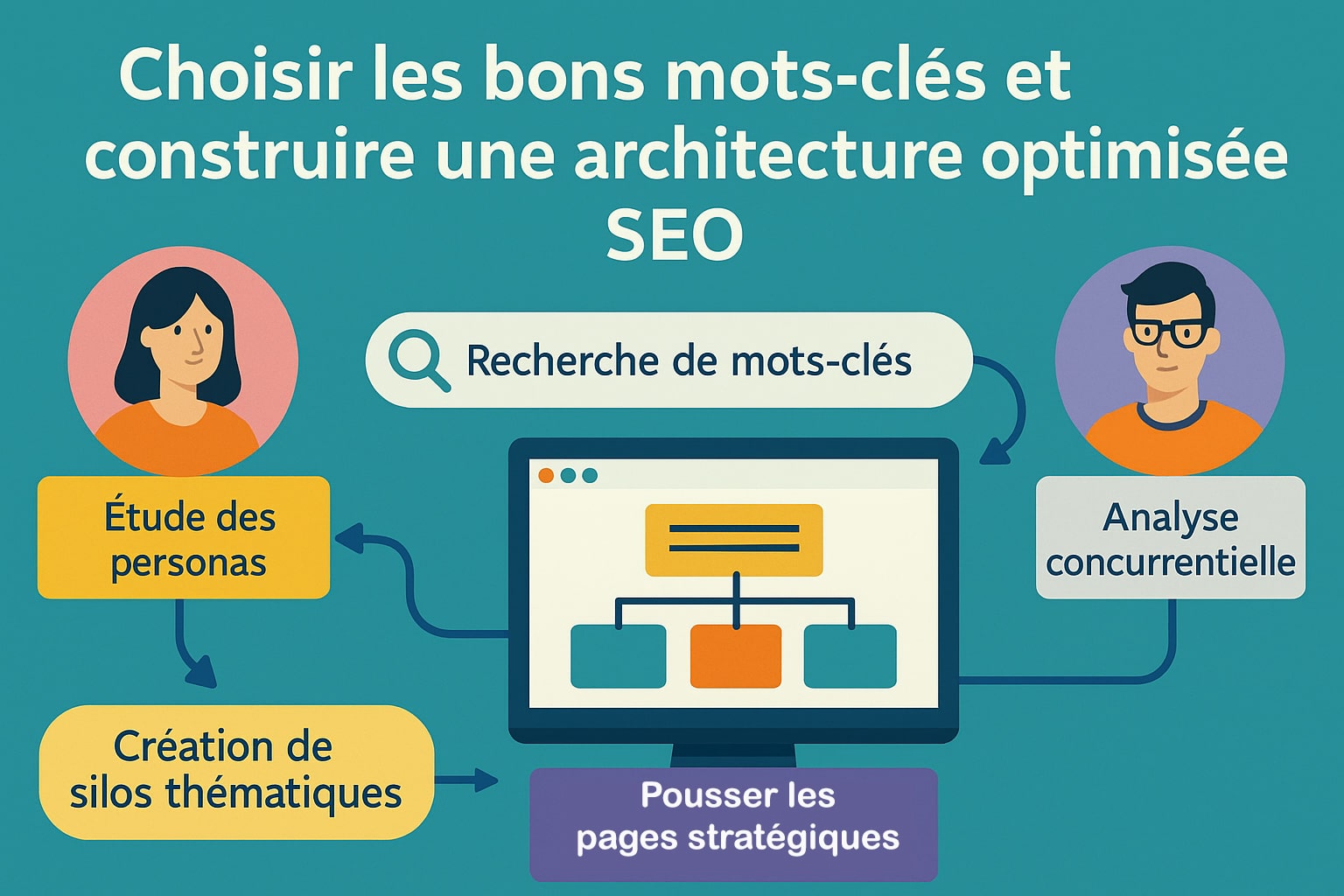

Choisir les bons mots-clés et construire une architecture optimisée SEO

La recherche de mots-clés constitue la base de toute stratégie SEO efficace. C’est à partir de ces termes que le contenu va être structuré, que les priorités éditoriales seront définies, et que l’architecture du site pourra être optimisée. Il ne suffit pas de se concentrer uniquement sur les mots-clés à fort volume : l’objectif est d’identifier les expressions les plus pertinentes, en phase avec les intentions de recherche des utilisateurs, leur niveau de maturité dans le parcours d’achat et les objectifs de conversion du site. Pour mener à bien cette étape, plusieurs actions complémentaires sont nécessaires :

- Étude des personas : Avant même de commencer à lister des mots-clés, il est important de comprendre qui sont les utilisateurs cibles : quelles sont leurs attentes, leurs préoccupations, leur vocabulaire, leurs comportements de recherche ? Identifier les différents profils types (personas) permet de mieux cerner les besoins informationnels à adresser, et d’adapter la stratégie sémantique aux différentes phases du cycle de décision (information, comparaison, action) ;

- Recherche de mots-clés : Cette étape repose sur l’utilisation d’outils spécialisés comme Google Keyword Planner, SEMrush, Ahrefs, Ubersuggest ou encore AnswerThePublic. Elle permet d’identifier un ensemble de mots-clés principaux (head keywords), secondaires (middle tail) et de longue traîne (long tail), en tenant compte du volume de recherche, de la concurrence, de la saisonnalité, mais aussi de la pertinence contextuelle par rapport à l’activité du site. L’analyse doit également intégrer les variations lexicales, les synonymes, et les questions fréquemment posées par les internautes ;

- Analyse concurrentielle : Étudier les mots-clés sur lesquels les concurrents sont positionnés peut révéler des opportunités stratégiques : requêtes peu exploitées, niches sémantiques, pages faibles à surpasser, ou encore angles de contenu différenciants. Cette veille concurrentielle permet également d’identifier les standards de contenu attendus par Google sur des requêtes spécifiques (type de format, longueur, structure, média utilisé…).

Une fois la recherche sémantique terminée, il est essentiel d’intégrer ces mots-clés dans une architecture de site logique, évolutive et bien structurée. L’objectif est double : faciliter la navigation des utilisateurs tout en permettant aux moteurs de recherche de comprendre clairement les relations entre les contenus.

La construction de cette architecture passe par plusieurs principes :

- Hiérarchisation des contenus : Organiser les pages en niveaux : pages principales (catégories ou pages piliers), sous-pages (services, produits, sous-thématiques), articles de blog ou FAQ (contenus de soutien). Chaque niveau doit répondre à un objectif précis dans le parcours utilisateur et être optimisé autour d’un champ lexical cohérent ;

- Création de silos thématiques : Le siloing consiste à regrouper les contenus par thématique, autour de mots-clés structurants. Chaque silo est relié par un maillage interne cohérent qui favorise la transmission de l’autorité sémantique et la navigation logique. Cette approche renforce la pertinence perçue par Google sur des sujets spécifiques et facilite l’indexation ;

- Navigation optimisée : Le menu principal, les liens internes, le fil d’Ariane, les pages de catégorie ou les suggestions de lecture doivent guider l’utilisateur de manière fluide. Une bonne architecture permet également de limiter la profondeur de clic (nombre de clics pour atteindre une page) et d’éviter les pages orphelines ou isolées dans l’arborescence.

À ce stade, il est recommandé de formaliser une cartographie du site à l’aide d’un outil de mind mapping (comme XMind, Miro ou MindMeister). Cette représentation visuelle aide à planifier l’ensemble des contenus à produire ou à optimiser, à répartir les mots-clés selon les pages cibles, et à anticiper l’évolution future de l’arborescence au fur et à mesure que le site s’enrichit.

Une architecture bien pensée, alignée sur une stratégie sémantique solide, offre une double valeur : elle améliore l’expérience utilisateur, tout en renforçant la compréhension et la valorisation du contenu par les moteurs de recherche. Cela pose les fondations d’un SEO durable et performant.

Mettre en œuvre, suivre et ajuster la stratégie SEO

Une fois les bases posées, vient le temps de l’action. Le déploiement de la stratégie SEO comprend trois volets essentiels : technique, éditorial et netlinking.

L’optimisation technique en référencement naturel

L’optimisation technique constitue un pilier fondamental du référencement naturel. Ainsi le SEO technique vise à garantir que les moteurs de recherche peuvent explorer, comprendre et indexer efficacement les contenus d’un site web. Un site bien optimisé sur le plan technique facilite non seulement l’accessibilité de ses pages, mais renforce également sa légitimité auprès des algorithmes de classement. Cette phase intervient en amont de la stratégie de contenu, car sans base technique saine, même les meilleurs contenus risquent de rester invisibles. Voici les principaux axes d’optimisation à considérer :

- Implémenter un fichier robots.txt et un sitemap.xml à jour : Le fichier

robots.txtpermet de contrôler l’accès des robots d’indexation à certaines sections du site, tandis que le fichiersitemap.xmlfournit une liste structurée des URL à explorer. Ces deux éléments doivent être correctement configurés et mis à jour pour assurer une indexation cohérente et exhaustive des contenus stratégiques ; - Identifier et corriger les erreurs d’exploration : Il est essentiel de surveiller régulièrement les erreurs 404 (pages non trouvées), les redirections erronées (boucles ou chaînes de redirections), ainsi que les pages orphelines (pages sans lien entrant). Ces anomalies nuisent à la fois au crawl des robots et à la structuration interne du site. Un audit via Google Search Console ou Screaming Frog permet de les repérer efficacement ;

- Gérer les balises essentielles à l’indexation : Chaque page doit comporter une balise

<title>unique, descriptive et optimisée autour d’un mot-clé cible. Les balises H1, H2, etc., doivent être hiérarchisées logiquement pour structurer le contenu, et les balisescanonicaldoivent être correctement utilisées pour éviter les problèmes de contenu dupliqué ; - Contrôler l’indexabilité et le maillage interne : Il convient de vérifier quelles pages sont indexées (et pourquoi), en s’appuyant notamment sur les rapports de Google Search Console. Le maillage interne doit permettre aux robots de passer facilement d’une page à une autre et de redistribuer l’autorité sémantique entre les contenus. Les liens internes doivent être contextuels, pertinents et limiter les niveaux de profondeur ;

- Structurer les données avec le balisage sémantique (données structurées) : L’implémentation de balises schema.org permet aux moteurs de recherche de mieux interpréter le contenu d’une page. Cela peut faciliter l’affichage de résultats enrichis (rich snippets), comme les avis clients, les événements, les recettes ou les FAQ. Ce balisage améliore indirectement le taux de clics en renforçant la visibilité des pages dans les SERP ;

- Assurer la cohérence des versions du site : Le site doit être accessible via une seule version (avec ou sans www, en HTTPS uniquement), avec des redirections 301 bien configurées pour éviter la duplication d’URL. Il est également important de contrôler la structure des URL, en privilégiant des formats courts, explicites, et intégrant si possible des mots-clés significatifs.

L’optimisation technique SEO n’est pas un exercice ponctuel, mais un processus continu qui demande une veille régulière, des outils adaptés et une bonne coordination entre les équipes spécialisées dans le référencement naturel, le développement et le contenu. C’est elle qui garantit que tous les autres efforts (rédaction, netlinking, stratégie éditoriale) puissent porter pleinement leurs fruits en assurant aux contenus la meilleure visibilité possible dans les moteurs de recherche.

La production de contenu en SEO

La création de contenu constitue l’un des leviers les plus puissants en matière de référencement naturel. Chaque page indexée représente une opportunité de se positionner sur des requêtes précises et d’élargir la couverture sémantique d’un site. Pour être performante, la production de contenu doit répondre à une logique SEO rigoureuse, fondée sur la pertinence des mots-clés, la structuration du texte, la richesse lexicale et le maillage interne stratégique.

Un contenu efficace en SEO repose sur un équilibre entre exhaustivité, optimisation sémantique et logique de distribution interne des liens. Il ne s’agit pas uniquement de publier régulièrement, mais de construire une architecture éditoriale cohérente, alignée sur les requêtes cibles et capable de générer des signaux forts pour les moteurs de recherche.

- Créer des pages piliers pour les mots-clés stratégiques : Les pages piliers doivent être conçues pour se positionner sur les mots-clés principaux et les requêtes à fort volume. Elles servent de points d’ancrage sémantique pour tout un champ lexical, en intégrant de manière naturelle les termes associés, variantes, synonymes et expressions connexes. Ces pages doivent être approfondies, structurées avec des balises Hn pertinentes, et intégrer des paragraphes riches en mots-clés sans tomber dans la sur-optimisation.

- Publier des articles de blog pour couvrir les requêtes longue traîne : Les contenus de blog permettent d’élargir le champ sémantique et de répondre à des intentions de recherche spécifiques, souvent moins concurrentielles mais cumulativement très génératrices de trafic. Chaque article peut cibler une requête précise ou une question utilisateur. L’utilisation d’expressions de longue traîne améliore la densité thématique globale du site, tout en renforçant la pertinence des pages piliers via le maillage interne.

- Optimiser chaque contenu sur le plan SEO : Chaque page doit être structurée avec rigueur : une seule balise H1 contenant le mot-clé principal, des sous-titres H2 et H3 organisant les sections, une présence régulière du mot-clé cible dans les zones chaudes (introduction, début de paragraphes, titres), sans surcharger le texte. L’attribut ALT des images doit également inclure des termes descriptifs en lien avec le sujet traité. Le contenu doit intégrer un maillage interne réfléchi, en créant des liens vers des pages complémentaires, des articles connexes, des pages services ou produits, afin de redistribuer l’autorité thématique, faciliter l’indexation, et guider les robots dans une logique de silo sémantique.

Enfin, un calendrier éditorial structuré autour des mots-clés identifiés en phase amont permet de bâtir progressivement une présence forte sur l’ensemble des thématiques visées. Chaque nouveau contenu vient ainsi renforcer la structure SEO globale, tout en consolidant les pages stratégiques déjà existantes. Le contenu devient alors un vecteur d’autorité, un levier de visibilité, et un élément structurant du maillage interne.

La stratégie de netlinking en référencement : L’âme du Web !

Le netlinking, aussi appelé link building, est un levier incontournable pour accroître l’autorité et la visibilité d’un site aux yeux des moteurs de recherche. Il repose sur l’acquisition de liens entrants (backlinks) depuis d’autres sites web, idéalement dans la même thématique ou dans un environnement éditorial pertinent. Ces liens agissent comme des votes de confiance qui signalent à Google que le contenu référencé est fiable, pertinent et digne d’être bien positionné. Une stratégie de netlinking performante ne se résume pas à accumuler des liens en quantité. La qualité, la diversité et la cohérence thématique des sources sont des critères déterminants. L’objectif est de bâtir un profil de liens naturel, équilibré et durable dans le temps, en évitant toute approche artificielle ou à risque (liens toxiques, réseaux de sites privés, échanges systématiques).

- Obtenir des liens de qualité depuis des sites de votre thématique : Un bon backlink provient idéalement d’un site disposant déjà d’une certaine autorité dans votre secteur. Il doit être contextuel, intégré dans un contenu pertinent, et pointer vers une page en lien direct avec la thématique du texte source. Les liens obtenus depuis des sites d’actualité, des blogs spécialisés ou des annuaires éditoriaux sélectifs sont souvent plus efficaces que ceux venant de plateformes généralistes ;

- Créer des partenariats éditoriaux : Le guest blogging, les interviews croisées, les tribunes d’experts ou les contributions à des médias spécialisés sont autant d’opportunités pour obtenir des liens de manière naturelle. En apportant de la valeur à d’autres éditeurs de contenus, il est possible de gagner en visibilité tout en renforçant son netlinking de façon qualitative ;

- Surveiller et entretenir son profil de liens : Il est indispensable de suivre régulièrement l’évolution de son profil de backlinks pour repérer d’éventuels liens toxiques ou artificiels (liens spammy, profils de forums, fermes de liens, etc.). Une surveillance proactive permet de désavouer ces liens auprès de Google via l’outil de désaveu, et de protéger la réputation SEO du site sur le long terme.

Attention toutefois aux indicateurs SEO classiques comme le DA (Domain Authority), le TF (Trust Flow) ou le CF (Citation Flow). Bien qu’ils puissent fournir des repères, ces métriques restent des indicateurs propriétaires, souvent manipulables et loin de refléter l’algorithme réel de Google. Une évaluation qualitative des liens, basée sur le contexte, le contenu, et la nature éditoriale du site référent, est toujours préférable. Pour éviter les erreurs stratégiques, il est vivement recommandé de faire appel à un spécialiste du netlinking SEO. Ce dernier saura identifier les opportunités pertinentes, négocier des liens de qualité et éviter les pratiques à risque qui pourraient pénaliser le site (filtre Penguin, baisse de visibilité, chute de positions).

Enfin, une stratégie SEO, qu’elle soit technique, sémantique ou off-site, doit être suivie et réévaluée régulièrement à l’aide d’indicateurs précis. Voici quelques éléments à surveiller pour mesurer l’efficacité des actions mises en œuvre :

| Indicateur SEO à suivre | Outils recommandés |

|---|---|

| Évolution des positions sur les mots-clés cibles | SEMrush, Ahrefs, Google Search Console |

| Volume et qualité du trafic organique | Google Analytics, Search Console |

| Analyse du profil de backlinks (quantité, qualité, toxicité) | Ahrefs, Majestic, SEO Observer |

| Identification de nouveaux liens ou de liens perdus | Ahrefs, Monitor Backlinks |

| Détection de liens à désavouer | Google Search Console, outils d’audit spécialisés |

Dans un écosystème numérique en constante évolution, le netlinking reste l’un des signaux de confiance les plus puissants pour les moteurs de recherche. Mais il doit être pensé comme un travail de fond, progressif, stratégique et constamment ajusté en fonction des retours observés sur le terrain et des mises à jour de l’algorithme de Google.

0 commentaires