Dans l’univers des systèmes d’exploitation, UNIX occupe une place à part, presque mythique. Il est la pierre angulaire de nombreuses technologies modernes, souvent méconnue du grand public mais omniprésente dans les infrastructures informatiques professionnelles. Des serveurs web aux superordinateurs, en passant par macOS ou Android (via Linux), son empreinte est partout. Pour comprendre la logique de fonctionnement de l’informatique moderne, il est indispensable de revenir aux fondations posées par UNIX.

La définition de UNIX : un système d’exploitation à la philosophie unique

Le terme UNIX désigne un système d’exploitation multitâche et multi-utilisateur dont les bases ont été posées à la fin des années 1960, dans le contexte très spécifique des laboratoires Bell, situés à Murray Hill, dans le New Jersey (États-Unis). Il est né de la volonté de créer un système plus simple et plus efficace que Multics (Multiplexed Information and Computing Service), un projet ambitieux mais devenu trop complexe, développé conjointement par AT&T, General Electric et le MIT. C’est dans ce contexte qu’en 1969, Ken Thompson, bientôt rejoint par Dennis Ritchie, entame le développement d’un nouveau système, d’abord sur un mini-ordinateur PDP-7 de Digital Equipment Corporation (DEC). Le système ne s’appelait pas encore UNIX. À ses débuts, il était désigné de manière informelle comme « Unics », en clin d’œil à Multics, avant que le nom UNIX ne soit officialisé. Ce système novateur répondait aux besoins d’un environnement multi-utilisateur dans un cadre universitaire et industriel, avec un objectif de sobriété, de robustesse, et de simplicité architecturale.

Très tôt, UNIX s’est démarqué par sa philosophie de conception, qui reste encore aujourd’hui une référence pour les développeurs et administrateurs système. L’approche minimaliste et modulaire, pensée par ses créateurs, visait à construire un ensemble d’outils spécialisés, chacun conçu pour une tâche précise. Cette manière de penser le système a conduit à la création d’un vaste ensemble de petites commandes interconnectables, capables de produire des résultats complexes par simple composition. Cette philosophie est explicitement formulée dans les UNIX Design Principles, rédigés dans les années 1970 et enseignés dans de nombreuses écoles d’informatique. Voici les principaux concepts qui définissent cette approche :

- Un outil, une fonction : Chaque commande ou utilitaire UNIX est conçu pour effectuer une seule tâche de manière efficace. L’idée est de les combiner en chaînes, plutôt que d’avoir de gros programmes monolithiques ;

- L’usage de la ligne de commande (CLI) comme interface principale : La ligne de commande permet l’automatisation de tâches complexes, la manipulation avancée de fichiers, et la configuration fine du système ;

- Tout est fichier : Une devise emblématique d’UNIX. Fichiers texte, répertoires, périphériques (comme un disque dur ou une imprimante), processus, sockets : tout est traité comme un fichier, avec une interface uniforme pour les lire et les écrire ;

- Portabilité du code : Grâce au langage C, dans lequel UNIX a été réécrit dès 1973, le système est devenu portable entre différentes architectures matérielles, ce qui a facilité sa diffusion dans les milieux universitaires et industriels.

La réécriture d’UNIX en langage C est un tournant historique, orchestré par Dennis Ritchie, lui-même co-créateur du langage. Cela a permis à UNIX de ne plus être dépendant d’une architecture matérielle précise, contrairement à la majorité des systèmes d’exploitation de l’époque, souvent écrits en assembleur et donc non transférables d’un ordinateur à un autre. Cette portabilité a été un des principaux leviers de la diffusion d’UNIX dans les années 1970 et 1980, notamment dans les universités comme l’Université de Californie à Berkeley. Il faut également souligner qu’UNIX n’est pas un système monolithique unique, mais une famille de systèmes partageant des caractéristiques communes, issues des versions historiques développées par AT&T, Berkeley (BSD), et d’autres acteurs majeurs comme IBM, HP ou Sun Microsystems. Au fil du temps, des systèmes comme AIX, Solaris, HP-UX ou encore macOS ont intégré ou repris les principes fondamentaux d’UNIX, souvent certifiés conformes à la norme SUS (Single UNIX Specification) ou POSIX (Portable Operating System Interface).

La notion de système d’exploitation « multitâche » désigne la capacité d’exécuter plusieurs processus de manière quasi-simultanée. UNIX a mis en place très tôt un modèle de gestion des processus préemptif, où le système peut allouer dynamiquement du temps processeur à plusieurs tâches, même en présence de multiples utilisateurs connectés en session distante. De plus, grâce à ses permissions de fichiers et sa gestion des utilisateurs, UNIX s’est imposé comme un système hautement sécurisé et adaptable dans les environnements multi-utilisateurs, bien avant que cette exigence ne devienne la norme dans le monde professionnel. Enfin, la structure hiérarchique du système de fichiers (débutant toujours à la racine /) reflète aussi la rigueur et l’élégance conceptuelle du système. Chaque élément y trouve sa place selon une logique préétablie (/bin pour les commandes système, /etc pour les fichiers de configuration, /home pour les répertoires utilisateurs, etc.), facilitant la maintenance, la sauvegarde, ou encore l’automatisation via scripts shell.

Au-delà d’un simple système d’exploitation, UNIX est donc devenu un modèle de conception informatique. Il a influencé les pratiques de développement, les langages de programmation, et l’organisation logicielle de milliers de projets. Sa philosophie inspire toujours les systèmes modernes, notamment les distributions GNU/Linux et macOS, mais aussi des outils de développement, des serveurs web, des infrastructures réseau et bien plus encore.

Résumé des étapes clés de l’évolution d’UNIX

- 1969 : création d’UNIX par Ken Thompson, Dennis Ritchie et Brian Kernighan aux Bell Labs.

- 1973 : réécriture du système en langage C, ce qui le rend portable entre différentes architectures matérielles.

- Fin des années 1970 : UNIX est adopté dans le monde académique, notamment via l’Université de Californie à Berkeley, qui développe sa propre version : BSD (Berkeley Software Distribution).

- Années 1980 : explosion des variantes UNIX, utilisées dans les stations de travail, serveurs, et superordinateurs. Des versions propriétaires apparaissent chez IBM (AIX), Sun Microsystems (Solaris), HP (HP-UX), etc.

- 1991 : création de Linux par Linus Torvalds, un noyau libre inspiré d’UNIX. Cela marque le début de l’ère de l’open source à grande échelle.

Depuis, le standard UNIX a évolué sous la forme de la norme POSIX, qui définit les règles de compatibilité des systèmes de type UNIX. Aujourd’hui, macOS est certifié UNIX, et la plupart des systèmes Linux suivent cette norme sans être officiellement « UNIX ». Voici un aperçu des principales familles UNIX et UNIX-like :

| Famille | Exemples de systèmes |

|---|---|

| UNIX propriétaires | AIX (IBM), HP-UX (Hewlett-Packard), Solaris (Oracle) |

| UNIX BSD | FreeBSD, OpenBSD, NetBSD |

| UNIX certifiés | macOS, AIX, HP-UX |

| UNIX-like (non certifiés) | Linux, Android, Chrome OS |

Le fonctionnement du système UNIX : Structure, processus et fichiers

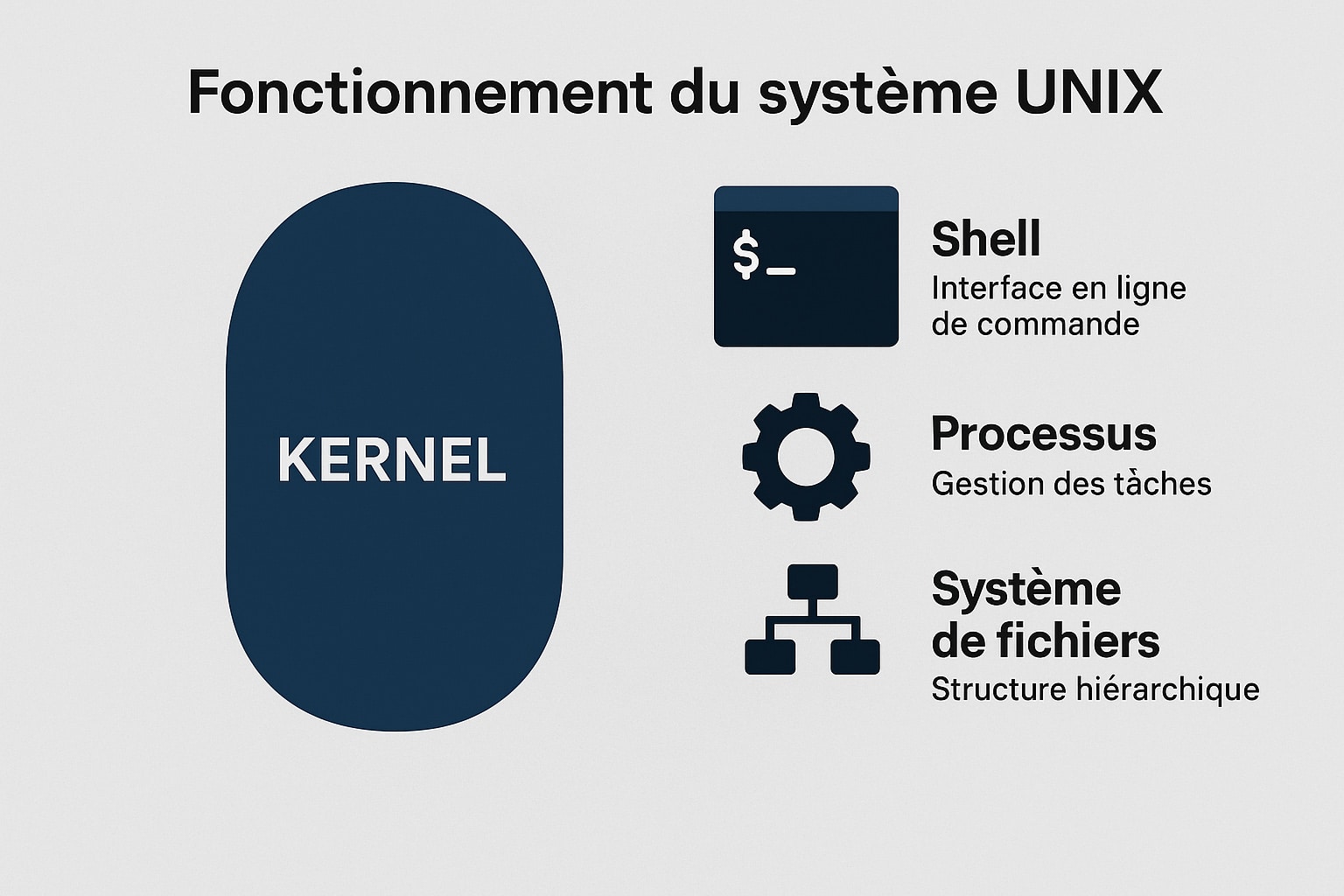

Le système UNIX repose sur une architecture technique à la fois cohérente, modulaire et élégante. Il a été conçu pour fonctionner efficacement dans un environnement multi-utilisateur, tout en assurant des performances stables et une sécurité renforcée. Son fonctionnement repose sur une interaction fluide entre plusieurs couches logicielles, dont le noyau, l’interface utilisateur (le shell), et le système de fichiers. Cette structure permet un contrôle précis des ressources matérielles tout en offrant aux utilisateurs une grande flexibilité dans l’exécution des tâches.

Au centre de cette architecture se trouve le noyau (kernel), composant essentiel du système d’exploitation. Il est responsable de l’abstraction du matériel et joue le rôle d’intermédiaire entre les applications utilisateur et les ressources matérielles comme le processeur, la mémoire vive, les disques ou les périphériques d’entrée/sortie.

Les composants techniques clés du système UNIX

- Le noyau (kernel) : il gère les appels système, les interruptions, les périphériques, la mémoire et la gestion des processus. Chaque fois qu’un programme ou un utilisateur tente d’accéder à une ressource matérielle, c’est le noyau qui orchestre cette interaction. UNIX utilise un modèle de noyau monolithique — tout le code du noyau s’exécute dans un même espace mémoire — ce qui permet une exécution rapide, mais nécessite une grande rigueur dans le développement.

- Le shell : interface en ligne de commande, le shell permet à l’utilisateur d’interagir avec le système via des instructions textuelles. Il agit comme une couche de communication entre l’utilisateur et le noyau. Il en existe plusieurs variantes, chacune avec ses propres fonctionnalités :

sh(Bourne shell) : le shell d’origine, simple et rapide.bash(Bourne Again SHell) : le plus répandu dans les distributions modernes.ksh(KornShell) : orienté programmation avec des extensions avancées.zsh: shell moderne, personnalisable, souvent utilisé dans les environnements de développement.

Le shell permet aussi d’écrire des scripts, ce qui automatise des suites de commandes et facilite la gestion quotidienne du système.

- Le système de fichiers hiérarchique : UNIX adopte une structure en arbre, avec une racine

/à partir de laquelle tous les fichiers et répertoires sont organisés. Cette organisation repose sur des répertoires standardisés :/bin: contient les commandes de base du système (cp, mv, ls, etc.)./etc: héberge les fichiers de configuration du système./home: répertoire personnel de chaque utilisateur./dev: contient les fichiers de périphériques (claviers, disques, ports série)./var: pour les fichiers variables (logs, spool d’impression, mails)./tmp: utilisé pour les fichiers temporaires.

Cette standardisation est non seulement un gain en clarté pour l’utilisateur, mais aussi un atout majeur pour l’administration, les sauvegardes, ou la migration de systèmes.

- Les processus : dans UNIX, tout programme exécuté devient un processus, identifié par un PID (Process ID). Le système gère les processus de manière fine, en attribuant des priorités et en permettant leur suspension, leur reprise ou leur arrêt. UNIX est un système multitâche préemptif, ce qui signifie que le noyau peut interrompre un processus pour en exécuter un autre, assurant ainsi un partage équitable des ressources. De plus, la création de processus enfants via l’appel système

fork()et leur gestion parexec()permet une architecture très flexible pour les applications.

La logique de commandes et de scripts dans UNIX

UNIX repose largement sur une interaction en ligne de commande (ainsi que pour Linux). Chaque action que l’utilisateur souhaite effectuer passe par une commande, souvent associée à des options et à des arguments. Cette simplicité apparente cache une puissance considérable, car ces commandes peuvent être chaînées grâce aux pipes (|), aux redirections (>, <), et combinées au sein de scripts. Les pipes permettent d’acheminer la sortie d’une commande vers l’entrée d’une autre. Cela favorise la composition de tâches complexes avec des commandes très simples. Quant aux redirections, elles permettent d’enregistrer la sortie dans un fichier, ou de lire depuis un fichier au lieu du clavier. Exemple classique de commande :

ps aux | grep apacheCette commande envoie la liste de tous les processus en cours (ps aux) à travers un pipe (|) vers la commande grep apache, qui filtre les lignes contenant le mot « apache ». Cela permet, par exemple, d’identifier les processus liés à un serveur web Apache en activité.

Ce type d’assemblage est typique de la philosophie UNIX, qui repose sur le principe suivant : « assembler des briques simples pour construire des outils puissants ». Grâce aux scripts shell, il est également possible d’automatiser ces séquences. Un script shell peut inclure des structures de contrôle (boucles, conditions, fonctions), des expressions régulières, et même des appels réseau ou des interactions avec la base de données. C’est un outil incontournable pour les administrateurs système.

Le modèle de permissions et la sécurité des fichiers

Chaque fichier dans UNIX possède un système de permissions en trois parties : Uilisateur (owner), groupe (group), et autres (others). À chaque catégorie sont associés trois types de droits : lecture (r), écriture (w), et exécution (x). Ce modèle de contrôle d’accès granulaire permet de sécuriser efficacement les données et les exécutions dans un environnement multi-utilisateur. Par exemple, la commande suivante permet de modifier les permissions d’un fichier :

chmod 755 monscript.shElle attribue les droits rwx (lecture, écriture, exécution) au propriétaire, et rx (lecture, exécution) au groupe et aux autres. Cette flexibilité dans la gestion des droits est essentielle pour garantir la sécurité des fichiers, notamment dans les environnements de production ou les serveurs accessibles à distance.

Le rôle central des appels système

Enfin, il est important de mentionner le rôle des appels système dans UNIX. Ce sont les interfaces par lesquelles les programmes utilisateurs accèdent aux services du noyau. Lorsqu’un processus souhaite lire un fichier, allouer de la mémoire, créer un nouveau processus, ou communiquer avec un autre processus, il utilise un appel système. Parmi les plus connus : open(), read(), write(), fork(), exec(), wait(). Ces appels constituent le socle technique sur lequel reposent les opérations les plus fondamentales du système UNIX. C’est cette interface stable, documentée et rigoureuse qui a permis la création de milliers de logiciels compatibles avec les systèmes UNIX et UNIX-like.

Les systèmes d’exploitations basés sur UNIX

Les héritiers modernes d’UNIX : Influence sur les systèmes d’exploitation actuels

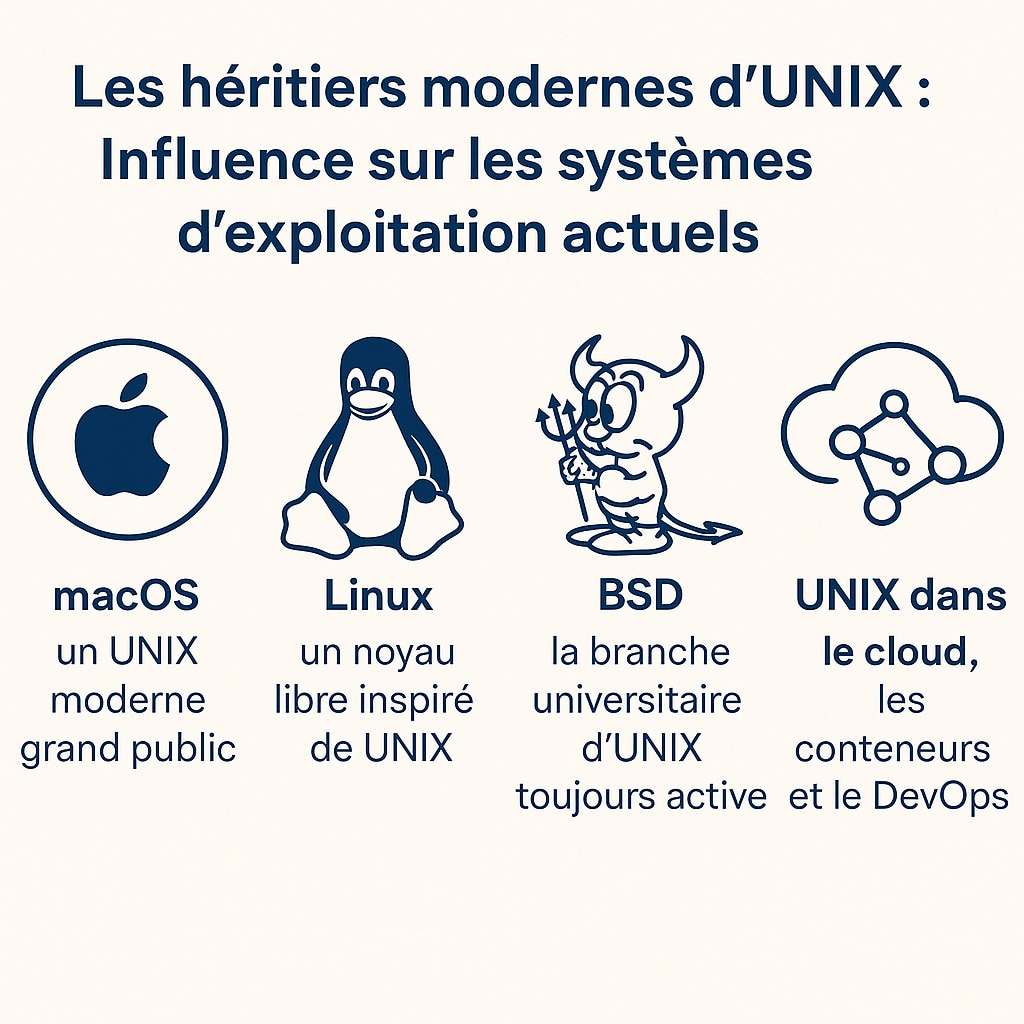

Depuis sa création à la fin des années 1960, UNIX a profondément influencé l’évolution des systèmes d’exploitation. Son architecture, ses principes de conception et sa logique modulaire ont traversé les décennies pour inspirer de nombreux projets logiciels, y compris ceux qui dominent aujourd’hui le monde des infrastructures, du développement logiciel et même de l’informatique grand public. Bien qu’UNIX, dans sa forme historique, soit aujourd’hui moins utilisé directement sur les postes de travail, son empreinte est omniprésente dans les technologies contemporaines. Cette influence s’exprime notamment à travers les systèmes UNIX certifiés, les systèmes dits UNIX-like et les nombreuses API ou interfaces respectant les standards POSIX (Portable Operating System Interface).

macOS : un UNIX moderne grand public

Le système d’exploitation d’Apple, macOS, est aujourd’hui l’un des rares OS commerciaux officiellement certifiés UNIX. Depuis Mac OS X (2001), Apple a bâti son système sur Darwin, un noyau libre dérivé de BSD (Berkeley Software Distribution) combiné au micro-noyau Mach. Ce socle UNIX apporte à macOS sa robustesse, sa gestion avancée des processus et des utilisateurs, ainsi que sa compatibilité avec de nombreux outils en ligne de commande, très prisés par les développeurs. Cette base technique permet aussi d’utiliser sur macOS des gestionnaires de paquets comme Homebrew, facilitant l’installation de nombreux logiciels UNIX et open source.

Linux : Un noyau libre inspiré de UNIX

En 1991, Linus Torvalds, alors étudiant à l’Université d’Helsinki, lance un projet personnel de noyau de système d’exploitation, qu’il baptise Linux. Bien que Linux ne soit pas dérivé du code UNIX d’origine, il en reprend l’architecture et les concepts fondamentaux, en particulier la gestion des processus, le système de fichiers hiérarchique, et la philosophie « tout est fichier ». Associé aux outils GNU (créés dans le cadre du projet du même nom par Richard Stallman), Linux devient un système d’exploitation libre, complet, et conforme aux standards UNIX. Linux est aujourd’hui omniprésent :

- Dans les serveurs web (Apache, Nginx) et les services cloud (AWS, Google Cloud, Azure) ;

- Dans les infrastructures réseau et télécoms ;

- Dans les objets connectés et systèmes embarqués (domotique, IoT) ;

- Dans les smartphones via Android, qui utilise un noyau Linux modifié.

Sa grande modularité, son modèle de développement communautaire et sa compatibilité POSIX en font l’héritier technique et philosophique direct d’UNIX, bien qu’il ne soit pas, juridiquement parlant, un UNIX certifié.

BSD : la branche universitaire d’UNIX toujours active

Le projet BSD (Berkeley Software Distribution), né à l’Université de Californie à Berkeley dans les années 1970, est une autre grande lignée UNIX. Contrairement à Linux, BSD est directement dérivé du code UNIX d’AT&T. À la suite de litiges juridiques dans les années 1990, BSD a évolué en plusieurs variantes open source, dont les plus populaires sont :

- FreeBSD : Axé sur la performance et la stabilité, très utilisé dans les datacenters et serveurs web (Netflix l’utilise pour son infrastructure) ;

- OpenBSD : Reconnu pour sa sécurité et sa rigueur dans le développement ;

- NetBSD : Réputé pour sa portabilité sur de nombreuses architectures matérielles.

Ces systèmes respectent strictement la tradition UNIX, tant dans leur fonctionnement que dans leur structure logicielle. Ils restent des choix solides pour les utilisateurs à la recherche de stabilité, de transparence du code, et de respect des normes POSIX.

UNIX dans le cloud, les conteneurs et le DevOps

La philosophie UNIX continue de guider les pratiques modernes d’infrastructure. Le concept de petits outils spécialisés et combinables est aujourd’hui au cœur des chaînes d’outils DevOps et de l’architecture des conteneurs. Par exemple :

- Docker, un outil de virtualisation légère, repose sur des fonctions du noyau Linux (cgroups, namespaces), héritées de la logique UNIX de séparation et d’isolation des processus ;

- Kubernetes, orchestrateur de conteneurs, applique des principes de modularité et de découplage proches de ceux d’UNIX ;

- CI/CD (Intégration et Déploiement Continu) utilise des scripts shell, des commandes en ligne, et des pipelines automatisés qui suivent les pratiques UNIX historiques d’automatisation et de contrôle.

Les systèmes UNIX-like sont également omniprésents dans les systèmes d’exploitation de cloud public, de serveurs virtualisés et dans les images de conteneurs utilisées quotidiennement par les développeurs. De fait, si UNIX n’est plus toujours visible sous son nom d’origine, ses concepts sont partout. Qu’il s’agisse de la structure d’un système Linux, de l’utilisation d’un terminal sous macOS, de l’administration d’un serveur cloud ou de la conception de microservices, UNIX est toujours là, en toile de fond, structurant les bases du monde numérique moderne.

0 commentaires