Imaginez pouvoir développer une application sur votre ordinateur portable, l’envoyer sur un serveur distant ou dans le cloud, et être sûr qu’elle fonctionnera exactement de la même manière, sans ajustement. C’est ce que permet Docker, un outil devenu incontournable dans le monde du développement logiciel moderne. Docker révolutionne la manière dont les applications sont conçues, testées, déployées et exécutées, en s’appuyant sur un concept puissant : la conteneurisation.

La définition de Docker et les principes de base

Docker est une plateforme open source qui permet d’automatiser le déploiement d’applications dans des conteneurs logiciels. Un conteneur est une unité standard de logiciel qui regroupe le code et toutes ses dépendances pour que l’application s’exécute rapidement et de manière fiable dans n’importe quel environnement. Pour bien comprendre Docker, il faut remonter à ses origines. Le projet Docker a été lancé en mars 2013 par Solomon Hykes, ingénieur franco-américain, alors qu’il travaillait chez dotCloud, une startup basée à San Francisco spécialisée dans les plateformes en tant que service (PaaS). Le concept de conteneur existait déjà, notamment grâce à des technologies comme LXC (Linux Containers), développées à partir de 2008 dans le monde Linux. Cependant, Docker a su démocratiser et simplifier cette approche, en y ajoutant une couche d’abstraction et des outils pour faciliter son adoption par les développeurs.

Docker a rapidement gagné en popularité, au point que dotCloud a fini par changer de nom en 2013 pour devenir Docker Inc. En 2014, l’entreprise a lancé la première version stable de Docker, la version 1.0, annoncée à San Francisco lors de la conférence DockerCon. Ce moment a marqué un tournant dans l’histoire des environnements applicatifs, en rendant la conteneurisation accessible à grande échelle. Contrairement aux machines virtuelles traditionnelles, qui nécessitent un système d’exploitation complet pour chaque instance, Docker partage le noyau du système d’exploitation hôte via un système de virtualisation légère. Cette approche permet une utilisation plus efficiente des ressources, avec un temps de démarrage bien plus court que celui des VM. Le résultat : un déploiement rapide, un meilleur rendement serveur et une expérience de développement plus fluide. Le succès de Docker repose sur une architecture modulaire, organisée autour de composants bien définis :

- Docker Engine : ce composant central agit comme le moteur de la plateforme. Il fonctionne comme un démon (daemon) tournant en arrière-plan, qui gère la création, le lancement et l’arrêt des conteneurs via une API REST ;

- Docker Images : les images Docker sont des fichiers immuables construits à partir d’un fichier

Dockerfile. Chaque image est une pile d’instructions empilées, versionnées et réutilisables, ce qui permet une portabilité parfaite entre les environnements ; - Docker Containers : ce sont les unités d’exécution générées à partir d’images. Chaque conteneur représente un processus isolé, tournant dans son propre espace utilisateur, mais partageant les ressources de l’hôte, comme le CPU ou la RAM.

Un autre élément clé dans l’écosystème Docker est le Docker Hub, une bibliothèque en ligne qui centralise des milliers d’images prêtes à l’emploi. Cet outil facilite l’accès à des stacks technologiques complets (comme une base de données MySQL ou un environnement Python) en une simple commande, sans configuration complexe.

Docker ne fonctionne pas de manière isolée : Il s’inscrit dans une tradition d’évolution technologique de l’infrastructure logicielle. Il s’appuie sur des innovations issues du noyau Linux, comme cgroups (control groups) pour la gestion des ressources, et namespaces pour l’isolation. Ces fonctionnalités, intégrées dans le noyau depuis les années 2006–2007, ont permis à Docker de bâtir une solution puissante sans réinventer la roue, tout en proposant une interface beaucoup plus accessible aux développeurs.

Comment fonctionne Docker en pratique ?

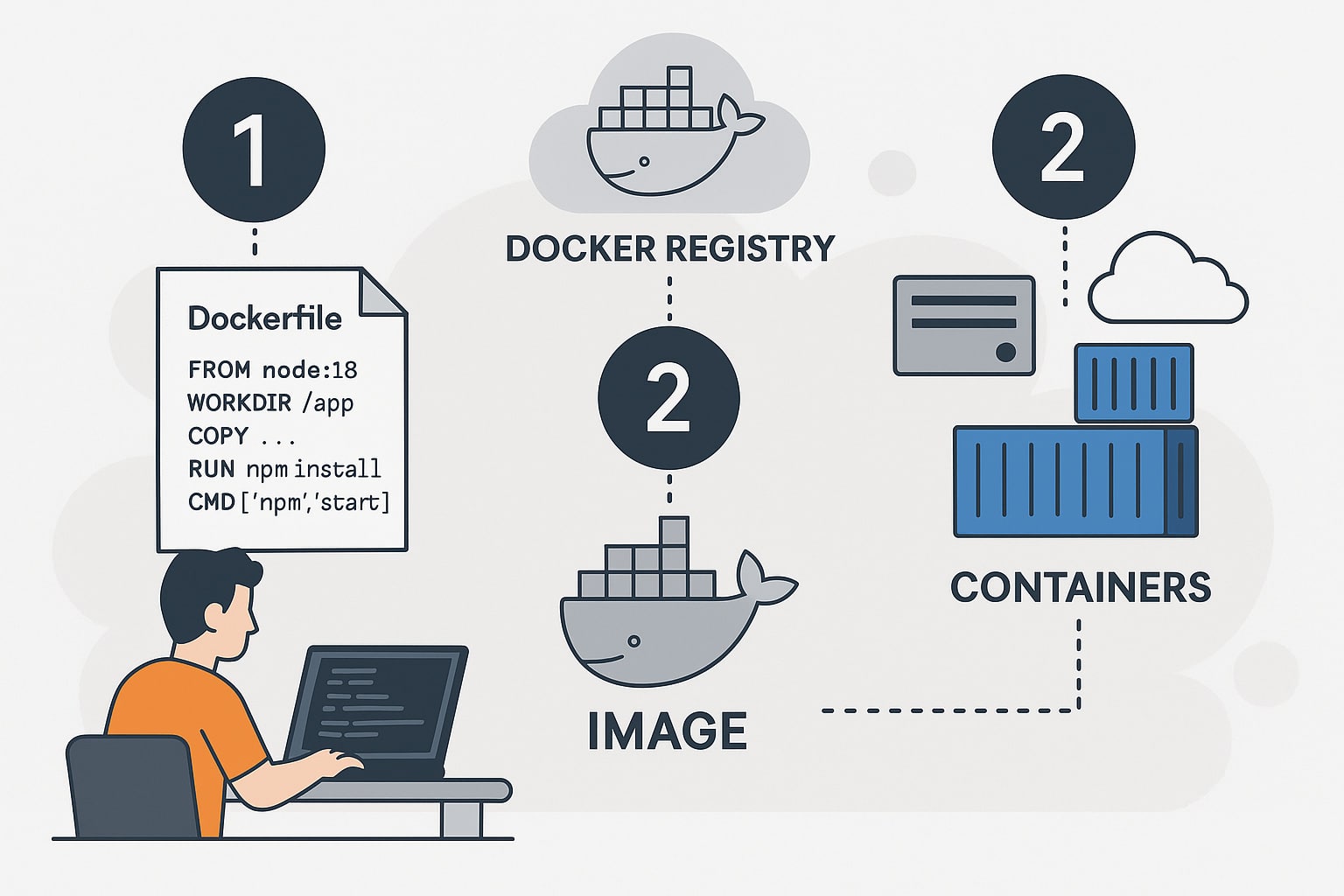

Le fonctionnement de Docker repose sur une logique simple mais redoutablement efficace : « construire une fois, exécuter partout ». Cela signifie qu’une application, une fois empaquetée dans un conteneur Docker, peut être exécutée dans n’importe quel environnement compatible, sans que le développeur n’ait à se soucier des dépendances, des conflits de versions ou des différences entre systèmes d’exploitation. Cette approche révolutionne les méthodes traditionnelles de déploiement, souvent sujettes à des erreurs et à des incompatibilités entre les environnements de développement, de test et de production. Dans un flux de développement classique, l’utilisation de Docker suit plusieurs étapes bien définies :

- Création d’une image Docker : Le développeur écrit un fichier appelé

Dockerfile, qui liste toutes les instructions pour construire une image. Ces instructions incluent la base du système (par exemple une image officielle de Node.js, Python ou Ubuntu), les fichiers de l’application, les dépendances à installer, et la commande à exécuter au démarrage ; - Construction de l’image : A partir de ce

Dockerfile, Docker construit une image en empilant les couches décrites. Chaque étape correspond à une couche de l’image, ce qui permet de réutiliser des couches déjà existantes pour gagner en efficacité et en temps de build ; - Stockage de l’image : Une fois créée, l’image peut être poussée vers un registre Docker tel que Docker Hub, GitLab Container Registry ou Amazon Elastic Container Registry (ECR). Ce registre agit comme un dépôt centralisé, où les équipes peuvent retrouver et utiliser des images de manière collaborative ;

- Déploiement du conteneur : L’image est ensuite tirée (pull) depuis le registre vers un système cible – poste de développement, machine de test, serveur de production ou infrastructure cloud. Un conteneur est créé à partir de cette image et exécute l’application dans un environnement totalement isolé et standardisé.

Voici un exemple simple de Dockerfile pour une application Node.js :

FROM node:18

WORKDIR /app

COPY . .

RUN npm install

CMD ["npm", "start"]

Ce fichier indique à Docker d’utiliser une image officielle de Node.js version 18, de créer un dossier de travail /app, d’y copier les fichiers du projet, d’installer les dépendances via npm et de lancer l’application avec npm start. Ce processus est identique, qu’il soit exécuté sur une machine personnelle à Paris, un serveur à Francfort ou un cluster cloud à Montréal. Ce niveau de portabilité change la donne pour les développeurs, mais aussi pour les équipes DevOps. L’un des points forts de Docker est son intégration avec les pipelines d’intégration continue (CI) et de déploiement continu (CD). Par exemple, une plateforme comme GitHub Actions peut automatiquement construire une image Docker à chaque push de code, la tester, puis la déployer vers un serveur cible.

Lorsque les applications grandissent en complexité et nécessitent plusieurs services (base de données, API, front-end…), Docker permet également de les gérer via des outils comme Docker Compose. Celui-ci permet de décrire plusieurs conteneurs dans un seul fichier docker-compose.yml, facilitant leur coordination et leur déploiement groupé. On peut ainsi, en une seule commande, faire tourner un environnement complet avec toutes ses dépendances, que ce soit en local ou sur un serveur distant. Enfin, pour les environnements de production à grande échelle, Docker est souvent utilisé en tandem avec des outils d’orchestration. Le plus connu d’entre eux est Kubernetes, développé à l’origine par Google. Kubernetes permet de gérer dynamiquement des centaines voire des milliers de conteneurs répartis sur plusieurs machines physiques ou virtuelles. Il assure le redémarrage automatique des conteneurs en cas d’échec, leur répartition intelligente selon la charge, leur mise à jour sans interruption de service, et bien plus encore.

Il existe aussi d’autres orchestrateurs comme Docker Swarm, intégré nativement dans Docker, ou encore Nomad de HashiCorp. Mais Kubernetes est aujourd’hui le standard le plus adopté pour les déploiements en production dans les entreprises de toutes tailles, des startups aux géants du web comme Spotify, Airbnb ou Shopify.

Les avantages de Docker pour les développeurs et les entreprises

L’adoption de Docker transforme en profondeur la manière de concevoir, tester, déployer et maintenir des applications logicielles. En proposant une approche modulaire et standardisée, Docker répond à des besoins techniques, organisationnels et économiques. Qu’il s’agisse d’une startup agile ou d’un grand groupe industriel, les bénéfices de cette technologie s’étendent bien au-delà du simple packaging applicatif. Voici une synthèse des principaux avantages de Docker, à la fois du point de vue des développeurs, des équipes DevOps et des décideurs techniques :

| Avantage | Description |

|---|---|

| Portabilité | Les conteneurs Docker fonctionnent de manière identique sur tous les systèmes compatibles : ordinateurs portables, serveurs sur site, services cloud (AWS, GCP, Azure), ou même sur un Raspberry Pi. Cette uniformité élimine le problème classique du « ça marche chez moi mais pas ailleurs ». |

| Rapidité | Contrairement aux machines virtuelles, les conteneurs démarrent en quelques millisecondes. Cette vélocité favorise les cycles de développement rapides, les tests fréquents et les déploiements immédiats. Elle est essentielle dans les environnements agiles et DevOps. |

| Isolation | Chaque conteneur s’exécute dans un espace clos, avec ses propres variables d’environnement, bibliothèques, processus et système de fichiers. Cela permet d’exécuter plusieurs versions d’une même application ou de bibliothèques sans conflits. |

| Réduction des coûts | La légèreté des conteneurs permet de faire tourner plus d’instances sur une même machine physique. Moins de consommation de ressources signifie moins de serveurs, donc moins de coûts matériels, énergétiques et de licences logicielles. |

| Automatisation | Docker s’intègre facilement aux pipelines CI/CD (GitLab CI, GitHub Actions, Jenkins, CircleCI, etc.). Il devient ainsi simple d’automatiser la construction, les tests, le déploiement et la mise à jour des applications, avec une fiabilité accrue. |

| Traçabilité et versioning | Chaque image Docker est versionnée et peut être enregistrée avec un tag. Il est ainsi possible de revenir à une version antérieure d’un environnement logiciel, de tracer l’évolution des builds et de renforcer l’auditabilité des systèmes. |

| Sécurité | Grâce à l’isolation native, une faille dans un conteneur n’affecte pas nécessairement le système hôte ou les autres conteneurs. De plus, Docker propose des mécanismes pour signer, scanner et contrôler les images afin de détecter des vulnérabilités. |

| Scalabilité | En combinaison avec des orchestrateurs comme Kubernetes, Docker permet de déployer dynamiquement un grand nombre de conteneurs, d’adapter la charge à la demande et d’assurer une haute disponibilité des services. |

| Interopérabilité | Docker est agnostique en matière de langage, de framework ou de système d’exploitation sous-jacent. Il peut contenir une application Java, un backend en Node.js, une base de données PostgreSQL et un front-end React, dans des conteneurs distincts mais interconnectés. |

| Écosystème riche | L’écosystème Docker comprend des milliers d’images officielles ou communautaires sur Docker Hub, des outils comme Docker Compose, Docker Desktop, Docker Registry, et des intégrations avec les principaux éditeurs du marché. |

Au-delà des aspects techniques, Docker simplifie profondément la collaboration entre équipes. Grâce à la création d’images partagées, chaque membre d’un projet peut utiliser exactement le même environnement de développement. Finis les problèmes de compatibilité liés aux différences de configuration entre les postes. Cette homogénéité renforce la productivité et réduit les erreurs liées aux décalages entre les environnements locaux et ceux de production. Pour les équipes DevOps, Docker facilite la mise en place de workflows fluides : Une application peut être validée, testée et livrée automatiquement, à chaque mise à jour du code, avec un niveau de contrôle sans précédent. Le principe de l’infrastructure comme code, combiné à Docker, offre une reproductibilité maximale, ce qui est essentiel pour les audits, les restaurations d’environnement ou les tests à grande échelle.

Côté entreprise, Docker répond aussi aux enjeux de transformation numérique et d’adoption du cloud. Il permet de migrer facilement des applications vers des infrastructures hybrides ou multi-cloud, sans refactorisation lourde. Certaines entreprises, comme ING, eBay ou PayPal, ont adopté Docker pour réduire leurs cycles de livraison et améliorer la résilience de leurs services. Enfin, Docker soutient une logique de durabilité : En optimisant l’usage des ressources matérielles, il permet de limiter le gaspillage énergétique lié à la surprovisionnement d’infrastructures, un enjeu de plus en plus pris en compte dans les politiques RSE des organisations.

0 commentaires