De nombreux webmasters ont longtemps eu pour habitude de bloquer l’exploration de leurs fichiers JavaScript et CSS via le fichier robots.txt. Cette pratique, autrefois tolérée, est désormais clairement déconseillée. Elle peut même entraîner une pénalité en matière de référencement naturel. Google a récemment confirmé ce changement de posture à travers plusieurs communications officielles. Ce durcissement s’inscrit dans une volonté plus large de mieux comprendre les pages web telles qu’elles sont réellement rendues côté utilisateur, ce que l’équipe de Google avait déjà laissé entrevoir quelques mois auparavant dans d’autres publications techniques.

- Avant-propos : De Google Webmaster Tools à Google Search Console

- Google veut mieux comprendre l’usage des technologies côté webmaster

- Apprenez à bien gérer vos propriétés dans la Google Search Console

- Suivre, diagnostiquer et améliorer : la Search Console comme outil d’optimisation continue

- Pourquoi la Search Console reste incontournable dans une stratégie SEO moderne

Avant-propos : De Google Webmaster Tools à Google Search Console

Lancé en 2006 sous le nom de Google Webmaster Tools, cet outil gratuit avait pour objectif de fournir aux webmasters des informations sur l’état d’indexation de leurs sites dans le moteur de recherche Google. Il proposait à l’origine des fonctionnalités basiques comme la soumission de sitemaps, l’analyse des erreurs d’exploration ou l’affichage des mots-clés les plus recherchés. Mais à mesure que les usages web ont évolué et que le référencement s’est ouvert à de nouveaux profils (rédacteurs, consultants SEO, développeurs front-end…), Google a décidé de faire évoluer l’image et la portée de l’outil.

Le 20 mai 2015, Google annonce officiellement que « Webmaster Tools » devient Google Search Console. Ce changement de nom marque aussi un changement de posture : l’outil ne s’adresse plus seulement aux « webmasters », mais à tous les professionnels impliqués dans la performance d’un site dans les résultats de recherche. Depuis cette date, Search Console n’a cessé de s’enrichir : nouvelle interface (2018), rapports sur les Core Web Vitals (2020), inspection d’URL en temps réel, rapports sur les données structurées (FAQ, événements, produits), intégration avec Google Analytics 4… Elle est désormais au cœur de toute stratégie SEO sérieuse.

Google veut mieux comprendre l’usage des technologies côté webmaster

En matière de contenu, il est bien établi que le texte reste une base essentielle pour un bon positionnement sur les moteurs de recherche. La rédaction web optimisée permet de mieux se référencer, comme nous l’abordons dans notre formation dédiée au référencement naturel. Cependant, cette approche uniquement textuelle est aujourd’hui remise en question par les évolutions des algorithmes de Google. La firme de Mountain View insiste désormais sur une analyse plus globale des sites web, prenant en compte non seulement les contenus écrits, mais aussi les ressources techniques qui influencent l’affichage réel des pages. Comme le rappelle Google, « si nos systèmes d’indexation fonctionnaient autrefois comme d’anciens navigateurs en mode texte, ils tendent désormais à reproduire l’expérience de navigation réelle de l’utilisateur ».

Concrètement, cela signifie que Google cherche à interpréter le rendu complet d’une page web, tel qu’un navigateur moderne le ferait, en exécutant le JavaScript, en appliquant les feuilles de style CSS, et en affichant les images dynamiquement chargées. Toute ressource bloquée — volontairement ou non — dans le fichier robots.txt peut ainsi nuire à la bonne compréhension du contenu par Googlebot. Cette évolution impose donc aux webmasters et développeurs de repenser la structure de leur site pour la rendre totalement accessible au robot d’indexation. Bloquer l’accès aux fichiers JS ou CSS n’est plus une simple question d’optimisation technique, cela devient un véritable obstacle au bon référencement.

Google recommande désormais de manière explicite de laisser accessibles ces ressources, afin de permettre une interprétation fidèle du comportement et de la mise en forme du site. Cela s’inscrit dans une logique plus large d’évaluation de la qualité de l’expérience utilisateur, en cohérence avec les critères Core Web Vitals ou encore l’indexation mobile-first. Il est donc essentiel que les responsables de site effectuent une analyse complète de leur fichier robots.txt, mais aussi des appels de ressources tiers, pour s’assurer que l’intégralité des éléments nécessaires au rendu visuel soit correctement accessible et interprétable par les moteurs de recherche.

Pour aller plus loin avec le Google Webmaster Tools

La structure technique d’un site web ne doit plus être reléguée au second plan. Elle constitue aujourd’hui un levier important pour le référencement naturel. L’un des principes fondamentaux à intégrer dans vos réflexions est celui de l’amélioration progressive. Ce concept repose sur une approche inclusive du développement web. Il consiste à garantir un fonctionnement minimal du site sur tous les navigateurs, puis à enrichir progressivement l’expérience utilisateur selon les capacités du terminal. Cela implique plusieurs bonnes pratiques :

- Soigner la sémantique HTML en utilisant correctement les balises comme

<em>,<strong>,<header>,<article>, etc. - Assurer l’accessibilité aux utilisateurs avec des technologies d’assistance ;

- Déporter les effets visuels dans des feuilles de styles CSS bien structurées ;

- Optimiser le chargement des scripts JavaScript pour qu’ils ne bloquent pas le rendu initial.

Dans une logique de performance, il est également recommandé de minimiser, compresser et concaténer vos fichiers CSS et JS. En réduisant le nombre de requêtes HTTP et le poids des fichiers, vous améliorez significativement le temps de chargement, un facteur clé pour l’expérience utilisateur et les Core Web Vitals de Google.

Si vous utilisez WordPress, des extensions comme WP Rocket vous permettent d’automatiser ces optimisations en quelques clics. Ce plugin permet notamment de :

- Activer le chargement différé (lazy load) des images et iframes ;

- Fusionner et minifier les fichiers CSS et JS ;

- Mettre en cache les pages pour un accès plus rapide.

Nous avons d’ailleurs détaillé les bénéfices de WP Rocket dans un article consacré à Google PageSpeed Insights, outil incontournable pour analyser et améliorer les performances de votre site. Ces ajustements, souvent simples à mettre en œuvre, renforcent à la fois la lisibilité, l’accessibilité et la rapidité de vos pages. Autant de signaux que Google valorise de plus en plus dans ses algorithmes de classement.

Apprenez à bien gérer vos propriétés dans la Google Search Console

Si vous cherchez à optimiser durablement votre référencement naturel et à mieux comprendre comment votre site est perçu par Google, la Google Search Console est l’outil incontournable à maîtriser.

Elle permet notamment d’auditer l’indexation, d’analyser les performances dans les résultats de recherche, de détecter les erreurs techniques et de soumettre vos sitemaps. Mais pour en tirer pleinement parti, il est essentiel de gérer correctement les propriétés de votre site.

Voici quelques points à surveiller :

- Ajoutez toutes les variantes de votre domaine (avec et sans www, http et https) ou utilisez la propriété de type “Domaine” pour un suivi unifié ;

- Vérifiez régulièrement les utilisateurs ayant accès à la Search Console : ne donnez les droits complets qu’aux administrateurs de confiance ;

- Examinez les rapports par section (performances, indexation, expérience, améliorations) pour prioriser vos actions SEO.

Dans le même esprit d’efficacité et de pertinence, Google recommande également de supprimer les ressources inutiles ou obsolètes, comme les anciens fichiers téléchargeables ou les contenus non consultés. Cela permet d’alléger votre site, de réduire l’exploration de pages secondaires par Googlebot, et de recentrer votre stratégie de crawl sur l’essentiel.

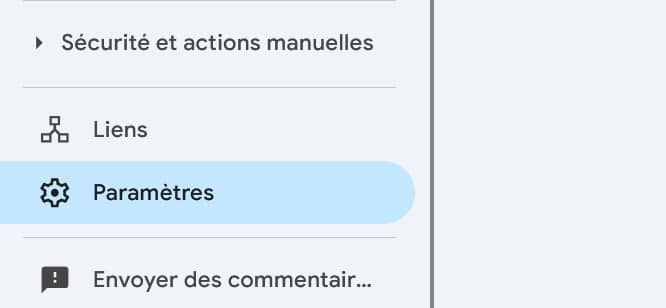

Notez que vous pouvez aussi déléguer la gestion en vous rendant sur cet onglet afin que d’autres utilisateurs confirmés puissent l’utiliser :

Suivre, diagnostiquer et améliorer : la Search Console comme outil d’optimisation continue

Une utilisation ponctuelle de la Google Search Console permet déjà de repérer des erreurs critiques. Mais son véritable potentiel se révèle dans une démarche d’analyse régulière et proactive. Pour un site en évolution constante, elle devient un outil de diagnostic et d’amélioration continue, bien au-delà de la simple détection de pages 404 ou de clics perdus.

Elle vous permet par exemple de :

- Surveiller l’impact réel de vos optimisations SEO (modification de balises, netlinking, réécriture d’un contenu) ;

- Repérer des variations de couverture de l’index (pages exclues, erreurs serveur, pages explorées non indexées…) ;

- Détecter une perte de visibilité sur certains mots-clés ou une baisse du CTR sur des pages stratégiques ;

- Observer l’évolution des signaux Web essentiels (Core Web Vitals) sur mobile et desktop.

Elle est aussi très utile lors de migrations de site, de refonte de structure ou de changement de protocole (http vers https, fusion de domaines, etc.). Les rapports de la Search Console vous aident à valider vos redirections, identifier les erreurs résiduelles et suivre la réindexation du nouveau périmètre.

Couplée à des outils comme Google Analytics, Screaming Frog ou Looker Studio (ex Google Data Studio), la Search Console devient une source de données fiable pour construire des tableaux de bord SEO personnalisés et suivre les KPIs de visibilité sur le long terme.

Pourquoi la Search Console reste incontournable dans une stratégie SEO moderne

Dans un environnement où les algorithmes de Google évoluent en permanence, la Search Console représente une source d’information directe et fiable. Contrairement à des outils externes qui analysent les SERP de façon indirecte, elle vous fournit des données issues directement des serveurs de Google, sur la manière dont votre site est exploré, indexé et cliqué. Elle est également un outil stratégique pour répondre aux nouvelles exigences du référencement : performance mobile, expérience utilisateur, compatibilité AMP, gestion des balises structurées… Chaque rapport devient un point d’appui pour prioriser vos actions techniques et éditoriales.

La Search Console est aussi un excellent outil de collaboration entre les différents profils impliqués dans un projet web : rédacteurs, développeurs, UX designers, webmasters. Elle permet de documenter l’évolution du site, de suivre les progrès réalisés, ou d’identifier les impacts négatifs d’une mise en production. Enfin, elle est essentielle pour anticiper les pénalités ou erreurs invisibles. Une baisse soudaine d’impressions ou des pages exclues de l’index sans raison apparente peuvent souvent être détectées dans la Search Console bien avant qu’elles ne se traduisent en pertes de trafic réelles.

Autrement dit, la Google Search Console n’est plus seulement un tableau de bord technique, mais un outil de pilotage SEO à part entière. Tout professionnel du web devrait y consacrer un temps régulier d’analyse et de suivi, que ce soit sur des projets récents ou des sites déjà bien établis.

0 commentaires