Une petite bombe dans la communauté SEO est arrivée hier en provenance du blog officiel de Google. Si le moteur de recherche nous habitue depuis maintenant de longues années à proposer régulièrement des mises à jour que certains qualifient de sectorielles (édition, santé/Médical notamment), proposant parfois d’un corolaire de bugs constaté par de nombreux éditeurs, le dernier arrivant est probablement l’un des plus importants depuis cinq ans : L’Update Google BERT pour Bidirectional Encoder Representations from Transformers en anglais, basé une nouvelle fois sur les technologies IA de la firme (on se souvient de Rank Brain), pourrait influencer les résultats sur dix pour cent des requêtes des internautes. Il revêt ici un caractère expérimental d’abord testé aux États-Unis avant d’arriver très prochainement en France, sans ajustements a priori particuliers par pays et fondé sur l’expérimentation américaine initiale.

En quoi consiste l’update BERT ?

BERT, c’est l’acronyme du réseau de neurones artificiels open source présenté par Google en 2018 pour mieux comprendre le langage naturel (le natural langage processing, ou NLP). A l’heure où la recherche vocale a pris un essor important, les formulations énoncées par les internautes requièrent une compréhension parfois plus subtile qu’un simple enchaînement décrypté des prépositions formant une expression de recherche. L’intensification des recherches a également joué son rôle, ce qui a pour conséquence de favoriser ces dernières années pas mal de stratégies SEO faisant focus sur la longue traîne. Mais ici, on touche plus encore à la compréhension du sens des mots au cœur des conjonctions et prépositions, limitant peut-être en théorie l’impact des chausse-trappes par exemple. Pour mieux comprendre ce à quoi il faut nous attendre, voici un tweet de Vincent Courson chez Google, nous présentant l’évolution prévue :

Blog original en anglais https://t.co/0PAdiPPZrD

— Vincent Courson (@VincentCourson) October 25, 2019

Vincent nous explique ainsi ensuite que l’on peut dès lors rechercher plus adroitement :

« impact du sommeil sur le corps humain chez les jeunes » plutôt que « impact sommeil corps jeune »

Jusqu’à présent, nous pouvions constater assez aisément que la notion de « stop word » avait encore une influence au même titre que la ponctuation, notamment dans le balisage. Cet Update Google va t-il fluidifier et inverser la logique des résultats et de la pertinence du fonctionnement du moteur de recherche ? C’est tout à fait possible bien que l’expérimentation ne nous donne pas à ce jour encore de réponses sûres sur des trends probants. Mais revenons sur BERT, c’est ici les notions de bidirectionnalité et de masquage de certains mots qu’il est important de comprendre en lisant l’article :

(…) nous utilisons la technique simple de masquage de certains mots de l’entrée, puis conditionnons chaque mot de manière bidirectionnelle afin de prédire les mots masqués.

L’exemple tiré :

Expression : L’homme est allé au [Masqué] (1). Il a acheté une [Masqué] (2) de lait.

L’étiquette : [Masqué] (1) = magasin; [Masqué] (2) = brique

Pour faire simple, BERT permet de considérer le contexte complet d’un mot en regardant les mots qui le précèdent et le suivent.

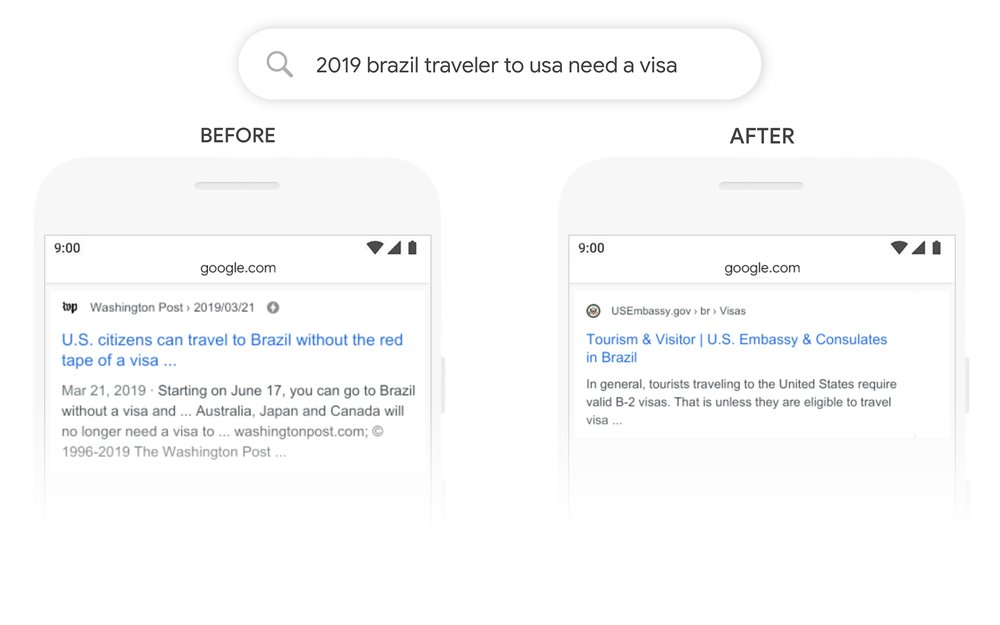

Et de prendre l’exemple parlant suivant aux USA :

Ici, Google ne comprenait pas le sens de la relation du « to » avec les autres mots, ce que BERT a pour objectif de corriger.

On ne se base plus simplement sur de la mise en correspondance des mots entre eux, mais l’objectif ici est de faire correspondre les propositions avec le contexte. C’est sinon assez révolutionnaire dans l’approche du moteur, pour le moins réorganisant.

On comprend par la même occasion ici que du point de vue hardware, l’impact d’un tel changement du mode de fonctionnement engendre une vraie réorganisation pour un moteur qui a pour mission d’interpréter autant de milliards de données chaque jour avec des processus jusqu’à présent très rodés.

Google et la pertinence sémantique

La pertinence est en toile de fond de ces avancées algorithmiques et si Moutain View a toujours tendu vers plus d’efforts pour la compréhension sémantique, la communauté pouvait constater que depuis quelques années et l’avènement du machine learning, l’usage de filtres algorithmiques orientés vers celle-ci ne semblait pas aussi impactant que par le passé. On se souvient notamment de toute la recherche établie autour de Hummingbird (Colibri) pour mieux comprendre les intentions et les expressions employées, mais ces travaux remontent déjà bien loin et il ne faut pas se cacher que la pertinence recherchée a connu parfois des secousses depuis.

BERT est probablement une grande promesse et revêt par sa manière de considérer les prépositions d’une façon nouvelle l’assurance prochaine d’un besoin plus approfondi pour les Webmasters de comprendre le cœur la pratique de l’algorithme. Pour les SEO, les efforts consentis sur les features snippets et la position zéro en première ligne devraient en toute logique s’intensifier également.

Autre source sur BERT, notamment pour l’exemple imagé : Article du blog Google

0 commentaires