L’algorithme de Google est particulièrement changeant et de nombreux critères sont déterminants pour le positionnement des sites dans les SERP du moteur de recherche. Les consultants référenceurs les étudient et retranscrivent les différents filtres connus aux grands publics.

Voici donc une liste volontairement non exhaustive de ce que l’on nomme le Zoo de Google, rassemblés selon leur fonction. Ce sont toutes ces petites modifications de l’algorithme qu’il est bon de connaître…

- La gestion du contenu, surtout la qualité du contenu

- Panda, ennemi des sites faibles en contenu

- Phantom 2, pour en remettre une couche sur le contenu

- Le web sémantique avec Hummingbird (le colibri de Google)

- La nature du contenu est visée avec Payday Loan ou encore DMCA Update (Digital Millennium Copyright)

- La hantise des référenceurs : Pingouin

- Pigeon, un bon coup de pouce pour inciter au search payant

- Google Possum ou Google Opossum en français

- L’EMD, ou Exact Match Domain

- Google Mobile friendly ou le Mobilgeddon

- HTTPS, ou la sécurité du site Internet comme critère de positionnement

- Rank Brain et l’introduction de l’intelligence artificielle ?

- Fred, apparu début 2017 à la suite de l’intégration en temps réel de Pingouin

- Les autres modifications de l’algorithme de Google

La gestion du contenu, surtout la qualité du contenu

L’un des critères fondamentaux en matière de référencement, c’est la qualité du contenu. Rappelez-vous, sur le Web « Content is King », pour reprendre l’expression de Bill Gates.

L’une des plus connue mise à jour de l’algorithme est Panda, du nom d’un ingénieur de chez Google, qui sort régulièrement tous les ans. Mais ce n’est pas la seule à s’occuper de ce que vous produisez en matière de contenu.

Panda, ennemi des sites faibles en contenu

Dernière mise à jour récente : Panda 4.2. Sorti en juillet 2015, Panda lutte particulièrement contre ce que l’on appelle les fermes à contenus. Ce sont des sites qui publient régulièrement du contenu de peu de valeur, voire dupliqué, et dont l’objectif est de générer du revenu publicitaire.

On pense bien sûr aux comparateurs de prix, qui sont aujourd’hui la cible déclarée du géant américain. Un sujet d’ailleurs sensible puisque Google nous propose un comparateur au travers de Google shopping.

Sa première sortie en février 2011, en août pour la France, visait aussi le Duplicate Content ou contenu dupliqué. Sur le principe, on ne peut que se réjouir d’une telle initiative. L’idée est donc de proposer un contenu original, neuf, pour ne pas polluer la toile de contenus pillés à droite et à gauche.

Sachez également qu’en théorie, ce contenu dupliqué et honni par les webmasters éthiques peut se trouver au sein même d’un site.

Quelque chose de peu agréable donc contre lequel Google s’est fait le parangon jusqu’à ce que l’on apprenne que celui-ci ne serait finalement pas si bien « géré » par l’algorithme. Pensez-vous, des années à préciser à tous les webmasters qu’il ne faut pas faire de duplication de contenu…

On se doute que les mises à jour régulière de Panda répondent à deux réalités : l’algorithme n’a pas la capacité de pouvoir traiter efficacement le contenu à 100% (ce n’est pas un traitement humain et la publication régulière, y compris sur les fameuses fermes à contenu, sont un moyen de lutter pour le positionnement) ; ensuite, il apparaît que l’hégémonie de Google passerait logiquement par une redéfinition des règles en fonction de ses intérêts (mais là aussi c’est un sujet sensible).

Google Shopping devrait entres autres permettre une reconsidération du search dans les prochains mois.

A suivre donc.

Phantom 2, pour en remettre une couche sur le contenu

Comme si Panda « ne suffisait pas », de nombreuses agences de référencement ont pu constater une baisse de trafic aux alentours du mois de mai. Beaucoup de spéculations à ce sujet, et c’est pourquoi a été baptisé et confirmé un « petit copain » de Panda, Phantom qui comme son nom l’indique n’est plus un animal.

Il ne s’agit pas pour autant de parler de pénalité dans ce cas. Une grande personnalité du petit monde du SEO, Barry Schwartz l’a baptisé « quality Update »

Il ne s’agit pas pour autant de parler de pénalité dans ce cas. Une grande personnalité du petit monde du SEO, Barry Schwartz l’a baptisé « quality Update »

En pratique, d’autres paramètres de contenu intègrent le cœur de l’algorithme comme la richesse sémantique, dont on parlera plus loin encore, le web design ou encore l’absence de publicité.

C’est intéressant quand on sait également que depuis plusieurs mois Google s’intéresse de plus en plus aux autres aspects que le HTML comme nous l’avions évoqué dans ce sujet il y a plusieurs mois.

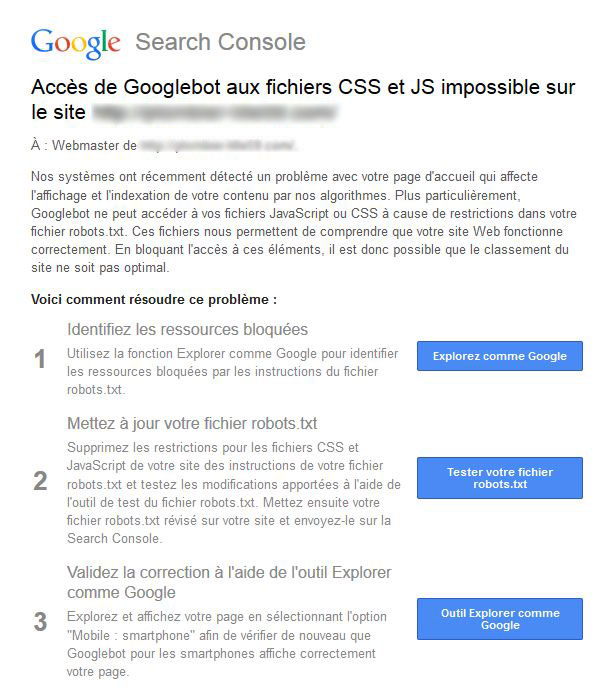

Ainsi avez-vous pu noter que Google sensibilise via des notifications à l’accès aux données telles que le CSS ou le Javascript ? Elle ressemble à ceci :

La solution consiste à aider GoogleBot à lire ces fichiers (les autres moteurs de recherche copiant avec retard Google), vous pouvez spécifier pour l’ensemble des robots :

La solution consiste à aider GoogleBot à lire ces fichiers (les autres moteurs de recherche copiant avec retard Google), vous pouvez spécifier pour l’ensemble des robots :

Allow: /*.js$

Allow: /*.css$La mise à jour de votre fichier robots.txt s’avère aujourd’hui primordiale et phantom n’y est certainement pas pour rien. Toujours plus de transparence est demandée par le moteur de recherche.

Le web sémantique avec Hummingbird (le colibri de Google)

La recherche sur les moteurs de recherche a pris il y a maintenant quelques années, un tournant assez étonnant avec l’avènement de la recherche sémantique. De nombreuses études ont paru sur le sujet et les requêtes des internautes sont disséquées en partie par l’intermédiaire de Colibri.

A proprement parler, il ne s’agit pas non plus d’une disposition de l’algorithme à sanction ou à la pénalité des sites. Non, Colibri est en fait d’un outil déployé par le moteur de recherche pour mieux comprendre l’indexation et les requêtes des internautes. Il est apparu fin d’année 2013, alors que la recherche par mobile commençait a exploser et avec elle l’entrée en jeu de la recherche parlée :

Ok Google, donne moi le nom du président des Etats-Unis… Ok Google, comment s’appelle sa femme ?

Très gourmand en sites à contenu comme Wikipédia, Hummingbird entre dans cette logique de contenu à la fois pertinent et provenant de sources principalement d’autorité. Pensez également à nourrir l’animal avec l’usage du schema.org, afin de rendre compréhensible et « mangeable » votre site. Ceci facilite un meilleur positionnement. Sortant rarement de son nid, le colibri marque l’arrivée de la recherche non pas simplement par mot clé mais bien plus du côté de la requête (un ou des mots clés contextualisés). Afficher un meilleur résultat en fonction du contexte de la requête et de sa compréhension, de l‘historique des recherches, répondre aux questions avant que l’on ne les pose, tel est le dessein de Google. Vous comprenez pourquoi nous sommes incités à plus de transparence…

La nature du contenu est visée avec Payday Loan ou encore DMCA Update (Digital Millennium Copyright)

Comprenez que ces évolutions assez anciennes visent à lutter contre des contenus moins éthiques. PayDay Loan s’attaque notamment au spamming.

Nous avions déjà vu que Google compte régir le search en fonction de critères non seulement légaux mais aussi moraux comme dans le cas de ses restrictions sur le search payant. Il s’avère que ces restrictions fonctionnent pour bonne part contre le téléchargement illégal (Pirate ou DMCA update) ainsi que sur les requêtes où le spam est important :

C’est particulièrement établi sur les rachats de crédit, le porno ou encore les contrefaçons de type pharmaceutique.

C’est un sujet assez controversé à nouveau puisque ce droit de retrait, s’il est possible de par l’auteur, reste potentiellement du ressort du leader du search. Ce dernier pénalise de lui-même les sites et de cette manière s’attribue des prérogatives ; c’est sujet à débat si l’on songe à la normalisation du web.

La hantise des référenceurs : Pingouin

L’expression est peut être un peu forte mais l’animal a une bonne place dans le zoo car il fait jaser sur la toile. Et pour cause, il tape sur ce qui intéresse au plus haut point bon nombre de webmasters : les backlinks.

Pingouin fait beaucoup de choses : En matière de contenu, il lutte contre le Keyword stuffing, cette pratique ancestrale qui consiste à bourrer de mots clés une page. Il lutte aussi contre le cloaking comme nous l’avions vu dans l’article dédié à sa sortie d’octobre 2014. Le contenu dupliqué fait également parti des objectifs ; Pour faire simple, l’ensemble des techniques qui pourrissent l’expérience des utilisateurs de Google, le spamdexing. De manière générale, et c’est la raison pour laquelle Pingouin revient souvent, Google cherche à casser les pratiques de référencement qu’il considère comme peu éthiques et les tentatives de sur-optimisations. Si l’on reprend le cas des backlinks, des-optimiser ses liens sortants rentre aujourd’hui dans la pratique en raison de Pingouin. Intégré définitivement à l’algorithme depuis septembre 2016.

Pigeon, un bon coup de pouce pour inciter au search payant

Ok c’est peut-être un parti pris, mais l’arrivée de Pigeon a considérablement changé les règles en matière de référencement local.

Aidé de Google My Business, cette évolution de l’algorithme a des conséquences sur votre manière d’approcher la réflexion sur les requêtes locales. Nous avions déjà évoqué le sujet sur Comment choisir ses mots-clés. Et c’est coup double pour Google qui oblige ainsi également à utiliser Google My Business pour que l’on vous trouve sur votre ville. Utilisant également le Knowledge Graph, Pigeon oblige également à retravailler directement la sémantique de votre site Internet (synonyme, orthographe, grammaire, formulations de marques, etc.) ; on en prend conscience avec une revisite de la Google Map.code>

Pigeon reste une des évolutions les plus visibles sur l’année 2015, avec mobile friendly.

Google Possum ou Google Opossum en français

Il fallait associer cette évolution de Google avec le précédent, Pigeon. En effet Google Opossum sorti en octobre 2016 a pour but de mieux traiter les requêtes locales. On note notamment des liens vers les Google My Business en première page via la recherche universelle. Lorsque vous tapiez par le passé une requête associant un mot clé + une ville, vous obteniez traditionnellement les propositions de la ville en question.

Cette fois-ci Google Possum propose au-delà de la ville tapée par l’internaute et notamment des résultats que l’on peut trouver assez éloignés géographiquement, en fonction d’une pertinence un peu nouvelle donc. Le positionnement de l’internaute est donc crucial puisque si vous êtes plus proche de la ville voisine, vous obtiendrez des résultats de la ville voisine. De la même manière, on constate que l’ordre des mots joue encore plus dans la pertinence des résultats observés. « Paris Coiffeur » ou « coiffeur Paris » ne donne pas la même chose. Les deux/trois résultats locaux peuvent s’inverser voire faire apparaître de nouveaux résultats.

L’EMD, ou Exact Match Domain

Alors voici un filtre dont les conséquences sont assez difficilement quantifiables pour peu que l’on respecte un tant soit peu l’ensemble des autres engagements que vous trouverez en partie dans le présent dossier. L’exact match domain, c’est par exemple « plombier-lille.com » ou encore coiffeur.fr Bref, un ensemble ou une partie de mots-clés se retrouvent dans le nom de domaine. Et si Matt Cutts avait annoncé des modifications de l’algo sur le sujet il y a maintenant trois ans, la réalité et la pratique montre que c’est un peu différent. L’article de Nicolas Ooghe est assez instructif sur le sujet.

En soi, il n’y a pas eu d’EMDgeddon… Préférez toutefois selon les souhaites de la firme de Mountain View des EMD uniquement si c’est bien le nom de votre site Internet. Si vous êtes un peu BH, que vous aimez les sites satellites détestés par la Quality Team de Google, pensez à l’utiliser sur d’autres niveaux (nous n’avons rien dit).

Google Mobile friendly ou le Mobilgeddon

Si vous vous intéressez a minima aux évolutions du search, vous avez forcément entendu parler du mobile-friendly. C’est le principe de la compatibilité mobile est c’est un vrai critère qui booste les pages friendly mobiles dans les SERP.

On a eu durant cette année 2015, date de sa sortie le 21 avril, quantité d’informations parfois contradictoires sur la manière de prendre l’information déployée par Google. Nous en avons nous mêmes parlé dans cet article qui reprends l’essentiel des informations sur le sujet. Aujourd’hui, les sites produits doivent avoir une version mobile. Si l’on ne peut parler d’impact immédiat, comme dans l’ensemble des mises à jour, cette évolution a produit et continue de produire des effets sur de nombreux sites Internet, à chaque passage de GoogleBot.

HTTPS, ou la sécurité du site Internet comme critère de positionnement

Sorti en août 2014 de manière officielle, Google produisant des tests avant toute déclaration, HTTPS vise à promouvoir les sites spécifiant cette sécurité supplémentaire. Le phénomène de passage au HTTPS s’est considérablement accéléré en 2016 sur l’ensemble du parc français de sites Internet. Google y est pour beaucoup, promouvant à la fois AMP et le HTTPS, des hébergeurs dominants également comme OVH qui a passé un accord avec Let’s Encrypt en juillet 2016 pour la mise en place automatique de serveurs mutualisés avec protocole SSL.

Le HTTPS est en quelque sorte devenu la norme et le fait d’y être pousse votre positionnement dans le moteur de recherche (au moins un peu). Attention au passage tout de même qui peut générer une petite perte de trafic temporaire.

Rank Brain et l’introduction de l’intelligence artificielle ?

Environ 15% des requêtes reçues par le moteur e recherche restent incomprises. Pour palier à la difficulté de lecture, Google a lancé fin 2015 une petite innovation basée sur de l’intelligence artificielle pour traiter tout cela. son impact a donc une certaine importance dans le référencement et il semblerait que son lancement soit très lié à l’exploitation de Humingbird (Colibri) également traité dans le présent article.

Rank Brain devient le troisième critère de référencement

Cette généralisation du principe s’est opérée sur le plan mondial.

Fred, apparu début 2017 à la suite de l’intégration en temps réel de Pingouin

Fred, c’est ce gros update de Google qui a eu lieu le 9 mars 2017. Google en février de cette même année avait déjà changé les règles de l’affichage des images, générant des pertes de trafic importantes via Google images.

Fred, toujours dans la continuité des guidelines de Google semble viser dans la lignée de Pingouin les liens factices et de mauvaise qualité.

Frappant, on ne s’en doutait pas les MFA (Made for Adsense), la communication de Google a été particulièrement faible sur le sujet.

La secousse de cette update baptisé par Garry Illyes d’un nom humain pour notre zoo s’est particulièrement fait ressentir d’abord outre-manche, alertant et mettant en émoi la communauté SEO, particulièrement les black Hat. Une nouvelle ère de nettoyage du web par Google ? Possible si l’on excepte le fait que de nombreux référenceurs jouent encore avec le netlinking agressif.

Les autres modifications de l’algorithme de Google

De nombreuses autres modifications ont été déclarées par Google et d’autres déduites. Un dossier complet réalisé par Webrank Info donne une vision d’ensemble de ce zoo.

Nous n’avons pas cité ainsi Page satellite, dont ampl’impact est assez flou et qu’il serait intéressant de voir comme un renfort à Pengouin sur la question des backlinks. Donner du jus par le biais de pages non présentes dans le sitemap est une technique proscrite.

Google fresness update en 2011 avait aussi changé beaucoup la manière de concevoir la réponses aux requêtes des internautes en contextualisant également celles-ci pour avoir les dernières modifications de contenus pour les sujets récurrents et également les sujets d’actualité. Son usage est particulièrement compréhensible dans le cas des sites E-commerces et des blogs puisque les articles sont soumis à évaluation et commentaires.

De là ce petit conseil, la fraîcheur et la mise à jour intervenant dans le positionnement de votre site, prenez soin de modifier vos contenus et de les mettre à jour.

On peut toutefois noter que l’évolution de l’algorithme de Google n’est pas forcément entachée d’errements et de remises en question.

Ainsi, la suppression de Google authorship que nous avions évoquée il y a quelques mois semble, est de l’avis d’experts comme Olivier Andrieu et d’autres, une simple suppression d’apparence dans les SERP; Il semblerait que ce ne soit plus le cas en cours d’année 2016. Toutefois, L’autorité, la pertinence et la qualité du contenu sont des notions bien trop importantes pour les abandonner du jour au lendemain.

Ce qui nous fait dire que cette suppression initiée en juin 2014 et sur laquelle nous avions communiqué, est peut-être le résultat d’un besoin de rééquilibrage de visibilité au profit d’autres outils de Google, outils exposés plus haut dans l’article comme le Knowledge graph ou encore les liens sponsorisés, et ce en dépit des déclarations plus ou moins officielles sur le sujet.

En février 2016, l‘introduction d’AMP pour un affichage environ 80% plus rapide sur mobile est aussi une évolution du moteur en soi. Une prime à l’AMP dans les classements existe.

D’autres modifications interviennent nécessairement sans que les webmasters en soient avertis, mais si vous suivez l’ensemble des préconisations vues dans le présent dossier, vous n’êtes pas très loin de la vérité en matière de référencement naturel.

0 commentaires