Vous êtes déjà tombé dessus des milliers de fois sans peut-être le savoir. Chaque fois que vous tapez une requête sur Google, Bing ou un autre moteur de recherche, la page qui s’affiche avec les résultats… c’est la SERP ! Un terme incontournable pour les spécialistes du SEO, et pourtant souvent mal compris en dehors du cercle technique. Explorons en profondeur ce qu’est réellement une SERP, comment elle fonctionne, ce qu’elle contient, et pourquoi elle est au cœur de toute stratégie de référencement naturel ou payant.

- Les composantes essentielles d’une SERP

- Comment les moteurs de recherche construisent une SERP

- Les différents types d’intentions de recherche et leur impact sur la SERP

- Comment analyser une SERP pour optimiser son contenu

- Les erreurs à éviter pour apparaître dans une SERP compétitive

- Quelle place pour le SEO face aux réponses générées par l’IA dans la SERP ?

- Qu’est-ce que la search generative experience (SGE) ?

- Des clics qui se déportent vers des réponses « auto-suffisantes »

- Une perte de contrôle éditorial sur la présentation des contenus dans la SERP

- Comment adapter sa stratégie SEO à cette nouvelle réalité de la SERP ?

- Vers un SEO centré sur la confiance et la traçabilité

Les composantes essentielles d’une SERP

Le terme SERP signifie Search Engine Results Page, autrement dit : la page de résultats d’un moteur de recherche. C’est le carrefour entre l’intention de recherche de l’utilisateur et les contenus que le moteur juge les plus pertinents. Une SERP peut sembler banale, mais elle contient en réalité une multitude d’éléments dynamiques et complexes. Voici les blocs les plus couramment rencontrés :

| Composant de la SERP | Description technique et rôle dans l’expérience utilisateur |

|---|---|

| Résultats organiques | Ce sont les liens dits « naturels », classés par les algorithmes de Google en fonction de la pertinence, la qualité du contenu, l’autorité du domaine, et d’autres signaux SEO. Ils constituent le cœur de la SERP traditionnelle. Leur position dépend entièrement du référencement naturel (SEO), sans intervention publicitaire. |

| Annonces payantes (SEA) | Résultats publicitaires affichés via des campagnes Google Ads ou Bing Ads. Positionnés en haut et bas de page, ils sont souvent prioritaires visuellement. Ils portent la mention “Annonce” ou “Sponsorisé”. Leur affichage dépend d’un système d’enchères et de score de qualité publicitaire. |

| Featured Snippet | Encadré affiché tout en haut de la SERP dans la « position zéro« . Il extrait un contenu structuré (liste, définition, tableau…) depuis une page web jugée particulièrement pertinente. Il répond directement à la requête, sans besoin de clic, et capte une part importante du trafic. |

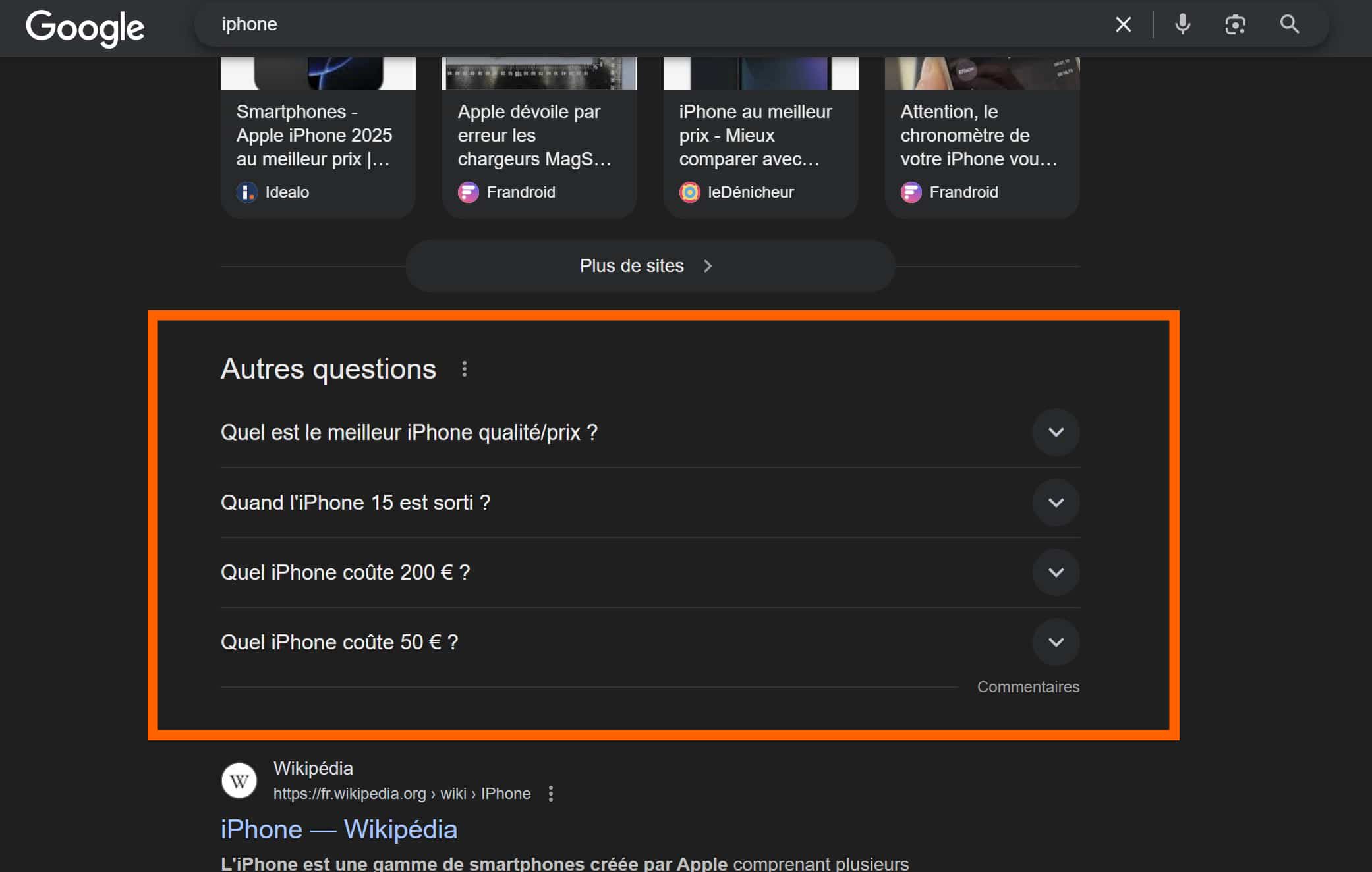

| People Also Ask (PAA) | Bloc interactif de questions fréquemment posées, générées dynamiquement. Chaque question se déplie pour afficher un mini-snippet provenant d’un site tiers. Ce format favorise la visibilité des pages bien structurées avec balisage FAQ ou contenu orienté utilisateur. |

| Knowledge Panel | Encart affiché à droite (sur desktop), contenant des informations structurées : entités connues, personnalités, lieux, entreprises. Alimenté principalement par Wikipédia, Google My Business, et la base de données de type Knowledge Graph. Impact fort sur la notoriété. |

| Pack local | Bloc cartographique accompagné de fiches Google Business Profile. Il apparaît lors de requêtes géolocalisées (ex : “boulangerie près de moi”). Indispensable pour le SEO local. Les critères incluent la distance, la pertinence et la popularité (avis clients, mentions locales). |

| Résultats images, vidéos, actualités ou produits | Carrousels ou blocs spécialisés déclenchés selon l’intention de recherche : visuelle (images), informationnelle (actualité), transactionnelle (produits). Leur affichage repose sur des formats structurés (schema.org) et l’indexation de types de contenu spécifiques (YouTube, Google Shopping, etc.). |

| Google Overviews (Search Generative Experience) | Résumés générés par intelligence artificielle, encore en déploiement progressif. Synthétisent des réponses complexes issues de plusieurs sources, parfois sans mention de l’auteur original. Ils modifient profondément la structure de la SERP en repoussant les résultats classiques plus bas. Sujet de débat chez les éditeurs, car ils impactent la visibilité directe des sites web. |

Chaque SERP est donc unique, construite dynamiquement à partir de nombreux signaux. Deux utilisateurs situés dans deux régions différentes peuvent voir une SERP totalement différente pour une même requête, en raison de la personnalisation des résultats, de la langue, ou de l’historique de navigation.

un exemple de PAA

Comment les moteurs de recherche construisent une SERP

Pour comprendre la SERP, il faut décortiquer la mécanique complexe qui la génère. Lorsqu’un internaute saisit une requête, le moteur de recherche ne parcourt pas le Web en temps réel comme pourrait le croire un utilisateur non initié. Il interroge à la place un index préconstruit, sorte de gigantesque base de données contenant des milliards de pages déjà analysées, triées et classées. Ce processus repose sur plusieurs couches technologiques imbriquées, allant du crawling à l’indexation, puis à la récupération des documents et leur classement final dans la SERP.

La première étape, en amont de l’affichage d’une SERP, est le crawl. Des robots d’exploration (Googlebot, Bingbot, etc.) parcourent le Web en suivant les liens de page en page. Ces bots identifient de nouveaux contenus, revisitent les anciens pour détecter les changements, et envoient les pages jugées pertinentes vers l’index du moteur. Ce crawl est continu, adaptatif, et fortement hiérarchisé en fonction de la fréquence de mise à jour supposée d’un site, de sa popularité et de sa structure technique (robots.txt, balises, canonicals…).

Vient ensuite l’indexation, qui consiste à analyser le contenu textuel, les métadonnées, la structure HTML, le balisage sémantique (comme schema.org) et tous les signaux disponibles sur la page pour en extraire un sens, une thématique, un niveau de qualité, et une « compréhension algorithmique ». L’index est constitué de représentations compressées et vectorisées des pages, exploitables en temps réel lors d’une requête utilisateur.

Lorsqu’une requête est tapée, l’algorithme entre en scène : il compare la formulation de la recherche avec les documents indexés à l’aide de modèles linguistiques (BERT, MUM chez Google) pour comprendre l’intention derrière les mots. L’objectif n’est pas seulement de “matcher” des mots-clés, mais d’interpréter l’objectif de l’utilisateur : cherche-t-il une définition, une adresse, un produit, une vidéo explicative, une recommandation ?

Les moteurs classent ensuite les résultats potentiels selon une multitude de signaux pondérés, parmi lesquels :

| Facteur de classement | Description détaillée |

|---|---|

| La pertinence sémantique | Il s’agit de la capacité d’une page à répondre précisément à l’intention de l’internaute. Les moteurs analysent les entités nommées, les synonymes, le champ lexical, les balises sémantiques (titres, listes, contenus enrichis), ainsi que la structure logique du texte. Les algorithmes comme BERT ou MUM permettent de comprendre le sens derrière la requête et de classer les documents selon leur alignement sémantique global. |

| La popularité | Mesurée principalement par la quantité et la qualité des backlinks pointant vers une page. Mais cela inclut aussi l’autorité du domaine, sa présence dans des sources reconnues, le volume de citations naturelles (mentions sans lien) et les signaux sociaux. Plus un site est “recommandé” sur le web, plus il est considéré comme pertinent et fiable. |

| La fraîcheur | Un contenu régulièrement mis à jour ou nouvellement publié peut être priorisé pour certaines requêtes sensibles au temps : actualités, prix, tendances, innovations. Google détecte les modifications de pages (même mineures), mesure la fréquence de publication, et ajuste sa pondération en conséquence. Certaines requêtes déclenchent des filtres “freshness” automatiques. |

| L’expérience utilisateur (UX) | Comprend les signaux techniques tels que la vitesse de chargement (PageSpeed), la stabilité visuelle (CLS), la réactivité (FID) mais aussi le design mobile-friendly, la facilité de navigation et l’absence d’éléments perturbateurs (pop-ups, autoplay, cookies intrusifs). Ces critères sont regroupés sous l’initiative Core Web Vitals et influencent directement le positionnement. |

| Le comportement utilisateur | Google utilise des signaux comportementaux agrégés et anonymisés : taux de clic (CTR) sur un résultat, temps passé sur la page, taux de rebond, pogo-sticking (retour rapide à la SERP), interaction avec le contenu. Ces données servent à réévaluer la pertinence réelle d’un contenu par rapport à l’intention initiale et à ajuster dynamiquement le classement. |

Sur cette base, le moteur génère une SERP personnalisée. Car oui, chaque utilisateur peut voir une version différente d’une même requête, en fonction de nombreux critères : sa géolocalisation, sa langue, son appareil (mobile ou desktop), son historique de recherche, son activité Google si connecté à un compte, etc. C’est ce qu’on appelle la SERP dynamique ou personnalisée. En fonction de l’intention détectée (informatif, navigationnel, transactionnel, local, etc.), Google assemble les différents blocs de résultats : featured snippet, vidéos, pack local, actualités, carrousels, annonces, Google Shopping, et depuis peu, les Google Overviews issus de l’intelligence artificielle générative (Search Generative Experience – SGE). Ce dernier module, en cours de déploiement, synthétise les réponses de plusieurs sources en un encadré autonome, potentiellement sans clic sortant, ce qui redéfinit la hiérarchie de visibilité dans la SERP.

Cette construction est non seulement complexe mais aussi évolutive. Google exécute chaque année plusieurs milliers de tests A/B sur ses SERP : Ordre des blocs, apparence visuelle, intégration de nouveaux formats (web stories, encarts IA, extraits audio…). Certaines modifications sont localisées à une région ou un type de requête, d’autres sont progressivement déployées à grande échelle. Pour les professionnels du référencement, surveiller la forme et la dynamique de la SERP est devenu une activité à part entière. Des outils comme SEMrush, Ahrefs, SEOClarity, ou encore les API de Google Search Console et des SERP trackers permettent de suivre l’évolution des positions, de détecter les types de résultats présents (et absents), et d’ajuster la stratégie de contenu et de netlinking en fonction. La SERP n’est donc pas un simple classement de liens : C’est un univers algorithmique, contextuel, en perpétuel mouvement. La comprendre, c’est comprendre l’interface entre l’utilisateur et le savoir disponible sur le Web. Et pour qu’un site web y apparaisse en bonne position, chaque élément de sa présence en ligne (technique, sémantique, éditorial, comportemental) doit contribuer à cette équation invisible que les moteurs recalculent en temps réel, pour chaque requête, chaque clic, chaque utilisateur.

Les différents types d’intentions de recherche et leur impact sur la SERP

Chaque requête saisie dans un moteur de recherche s’accompagne d’une intention utilisateur implicite. C’est cette intention que les moteurs tentent d’interpréter avant même de choisir les résultats à afficher. On distingue généralement quatre grandes catégories :

| Type d’intention de recherche | Description détaillée et impact sur la SERP |

|---|---|

| Informationnelle | L’internaute cherche à obtenir une information, comprendre un concept, ou apprendre comment réaliser une tâche. Les requêtes sont souvent formulées sous forme de questions (“comment”, “pourquoi”, “qu’est-ce que…”). Exemple : “comment fonctionne une pompe à chaleur”. Impact sur la SERP : présence fréquente de featured snippets (position zéro), vidéos explicatives, articles de blog, carrousels YouTube, et blocs People Also Ask (PAA). Le SEO éditorial est ici prioritaire. |

| Navigationnelle | L’utilisateur connaît déjà le site qu’il veut visiter, et utilise Google comme un raccourci. Les marques ou noms de domaine sont directement cités dans la requête. Exemple : “Facebook login”, “lemonde.fr”. Impact sur la SERP : mise en avant du site officiel avec sitelinks (liens internes directs), logo, description enrichie, et parfois Knowledge Panel pour les entités reconnues. Le positionnement est fortement dominé par le site recherché. |

| Transactionnelle | L’objectif ici est de réaliser une action concrète : acheter, s’abonner, réserver, télécharger. Ces requêtes ont une forte valeur commerciale directe. Exemple : “acheter iPhone 15”, “billet train Paris Lyon”. Impact sur la SERP : résultats riches en publicités (Google Ads), Google Shopping, carrousels de produits, snippets avec prix, avis clients, disponibilité. Forte présence de marketplaces et pages de conversion. |

| Commerciale pré-transactionnelle | L’utilisateur est encore en phase de recherche ou de comparaison. Il cherche à évaluer des options, lire des comparatifs ou avis avant de passer à l’action. Exemple : “meilleur aspirateur 2025”, “comparatif banque en ligne”. Impact sur la SERP : nombreux guides d’achat, listes de produits, classements sponsorisés, vidéos test, carrousels de comparateurs. Les contenus SEO doivent ici allier sémantique produit et valeur éditoriale. |

La structure de la SERP dépend donc directement de cette classification. Un bon référencement passe d’abord par une compréhension fine de l’intention ciblée pour adapter non seulement le contenu, mais aussi le format (texte long, vidéo, fiche produit, FAQ…).

Comment analyser une SERP pour optimiser son contenu

Observer une SERP permet de comprendre ce que Google considère comme pertinent pour une requête donnée. C’est une étape incontournable pour construire une stratégie SEO réaliste. Voici quelques éléments à surveiller :

| Élément à analyser dans la SERP | Utilité pour l’optimisation SEO |

|---|---|

| Le nombre de résultats sponsorisés | Une forte présence de Google Ads (en haut, en bas, voire parfois au milieu de la page) indique un environnement concurrentiel où des marques investissent activement en SEA. Cela peut réduire la visibilité organique en haut de page. Pour le SEO, cela implique de viser des formats enrichis (FAQ, position zéro) pour rester visible malgré la pression publicitaire. |

| Le type de contenu dominant | Observer si la SERP privilégie des articles de blog, des pages e-commerce, des fiches locales, ou des vidéos YouTube permet d’ajuster sa stratégie de contenu. Exemple : si les vidéos dominent une requête, publier un article long ne suffira pas. Adapter le format au comportement du moteur est une clé de positionnement. |

| Les fonctionnalités SERP visibles | Featured Snippets, PAA (People Also Ask), Local Pack, carrousels, FAQ, Google Maps, images… ces modules modifient radicalement la structure visuelle de la page. Leur présence peut détourner l’attention des résultats classiques. Identifier ces blocs permet d’adopter les bonnes balises (FAQPage, HowTo, Review) et d’enrichir le contenu pour cibler ces emplacements spécifiques. |

| La sémantique des titres et descriptions | Analyser les title tags et meta descriptions des résultats déjà bien positionnés donne des indices sur les mots-clés secondaires utilisés, les intentions couvertes, les formats préférés (liste, question, promesse, actualité…). C’est une excellente base pour reformuler ses balises et augmenter le taux de clic (CTR) sans nécessairement changer le contenu lui-même. |

Utiliser un outil comme Ahrefs, Semrush, Thruuu ou SEO Minion permet d’analyser les SERP à grande échelle, d’identifier les opportunités de format (FAQ, vidéo, longue traîne…) et de détecter les écarts entre votre contenu et ceux qui dominent la première page.

Les erreurs à éviter pour apparaître dans une SERP compétitive

Si apparaître dans une SERP est le but de toute stratégie SEO, certaines pratiques peuvent freiner – voire empêcher – votre visibilité. Voici les erreurs courantes à éviter :

- Contenu hors sujet ou mal aligné avec l’intention de recherche : Un article très complet, mais mal ciblé ne sera jamais favorisé ;

- Absence d’optimisation technique : Une page trop lente, mal balisée (balises title, Hn, meta description absente), non responsive aura du mal à se classer, même avec un bon contenu ;

- Maillage interne faible : Google favorise les pages intégrées dans une structure de site cohérente et bien liée sémantiquement ;

- Titre SEO ou meta description peu engageants : Un mauvais CTR peut impacter indirectement la position en signalant un manque d’adéquation avec la requête.

À l’inverse, travailler la qualité éditoriale, structurer son contenu avec des balises sémantiques, optimiser le maillage et répondre précisément à l’intention utilisateur sont autant de leviers pour monter dans la SERP et y rester.

Quelle place pour le SEO face aux réponses générées par l’IA dans la SERP ?

Avec l’émergence de la Search Generative Experience (SGE) de Google et l’intégration croissante des Google Overviews, l’architecture de la SERP connaît une transformation profonde. Google introduit désormais des blocs générés par intelligence artificielle, capables de synthétiser des réponses complexes à partir de multiples sources – sans nécessairement déclencher de clics sortants. Cela redéfinit le rôle du SEO dans un écosystème où l’IA devient elle-même un “éditeur de contenu”.

Qu’est-ce que la search generative experience (SGE) ?

La SGE désigne une nouvelle expérience de recherche proposée par Google, exploitant des modèles de langage avancés pour fournir des réponses rédigées dynamiquement. Ces résumés apparaissent tout en haut de la SERP sous forme de blocs informatifs, enrichis de citations, d’images, de liens complémentaires, et parfois d’actions suggérées. On les appelle aussi Google Overviews dans certaines interfaces. Contrairement aux featured snippets (qui extraient un extrait exact d’un seul site), les overviews sont une synthèse multi-sources. Elles peuvent répondre directement à des questions complexes, formuler des avis ou guider l’utilisateur… sans qu’il ait besoin de cliquer ailleurs. C’est une innovation puissante sur le plan UX, mais disruptive pour les éditeurs web.

Des clics qui se déportent vers des réponses « auto-suffisantes »

La première conséquence de cette évolution est la réduction de la visibilité directe des sites web. Là où, auparavant, un résultat positionné en 1re place pouvait capter 30 à 40 % des clics, l’apparition d’une réponse IA au-dessus de la ligne de flottaison détourne une grande part de l’attention – et du trafic. Google ayant pour objectif de fournir une réponse immédiate, il n’est pas rare que l’overview contienne l’essentiel de l’information recherchée, sans nécessiter de visite sur le site source. Ce phénomène, appelé no-click search, existait déjà avec les featured snippets, mais s’amplifie nettement avec l’IA générative.

Une perte de contrôle éditorial sur la présentation des contenus dans la SERP

Autre difficulté : les sources utilisées dans les overviews ne sont pas toujours clairement identifiables. Bien que Google indique vouloir “citer les références” utilisées dans les résumés, la présentation reste parfois floue, les liens secondaires discrets, et le choix des contenus agrégés opaque. Cela soulève une problématique majeure pour les éditeurs : comment garantir que leur travail de fond (études, comparatifs, avis, guides) sera reconnu et visible, s’il est absorbé dans une synthèse anonyme ? L’effet boîte noire des algorithmes de génération pose ici un vrai enjeu de transparence et d’équité algorithmique.

Comment adapter sa stratégie SEO à cette nouvelle réalité de la SERP ?

Face à cette mutation, le SEO ne disparaît pas. Il se transforme. Pour continuer à émerger dans une SERP pilotée par l’IA, les éditeurs doivent renforcer leur autorité sémantique et éditoriale à plusieurs niveaux :

- Produire du contenu original et profond : les textes génériques seront ignorés. Il faut publier des analyses, des données propriétaires, des contenus à forte valeur ajoutée ;

- Soigner le balisage sémantique : schema.org, balises FAQPage, Article, HowTo, Author, etc. permettent à Google de mieux comprendre le contenu et d’en extraire des éléments structurés pour l’overview ;

- Valoriser l’expertise humaine : mise en avant des auteurs (via des pages “auteur” avec bios crédibles), citations internes, contextualisation des sources et indicateurs de confiance renforcent la légitimité ;

- Diversifier les formats : podcast, vidéo, infographies, outils interactifs (tous les formats difficilement résumables par une IA) gagnent en importance.

En bref, il ne s’agit plus seulement de plaire aux robots d’indexation, mais de mériter d’être utilisé (et cité) par les modèles d’IA. C’est une logique de qualité éditoriale, d’autorité informationnelle et de structure technique fine.

Vers un SEO centré sur la confiance et la traçabilité

Ce nouveau contexte réintroduit une notion fondamentale : la légitimité de l’information. Google va devoir prouver que ses overviews ne sont pas de simples amalgames anonymes, mais bien des synthèses fondées sur des contenus fiables. Les signaux de qualité (E-E-A-T : Expertise, Experience, Authoritativeness, Trustworthiness) prennent donc une place encore plus importante.

Pour les professionnels du SEO, cela implique de repositionner la discipline comme un levier stratégique, éditorial et éthique. Plus question de “faire du volume” pour exister. Le SEO de demain sera précis, traçable, expert. Il servira moins à “tromper l’algorithme” qu’à nourrir les nouvelles couches d’intelligence automatisée du moteur de recherche.

0 commentaires