On associe souvent le SEO à la qualité du contenu, aux liens entrants ou encore à la structure des pages. Mais un levier discret, bien que redoutablement efficace, est encore trop peu utilisé : les logs serveurs. Ces fichiers techniques, générés automatiquement par votre hébergement, enregistrent chaque passage d’un visiteur ou d’un robot sur le site. En les analysant, on accède à une mine d’informations sur le comportement des crawlers comme Googlebot. Et si ces données brutes devenaient votre nouvel atout pour affiner votre stratégie de référencement ?

Ce que sont les logs serveurs : Structure et utilité en SEO

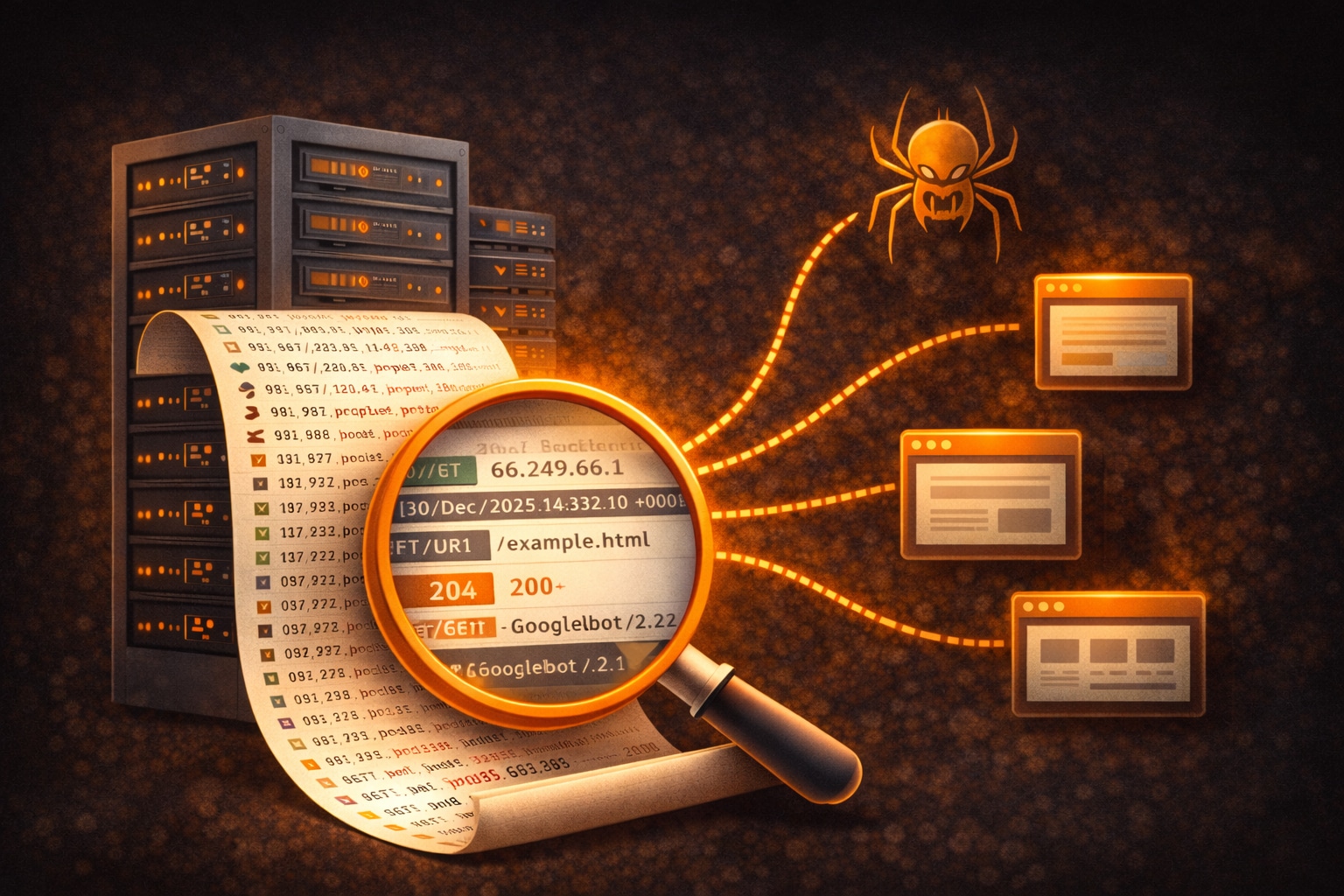

Les logs serveurs sont des fichiers générés automatiquement par le serveur d’hébergement de votre site web. Leur rôle est simple : enregistrer chaque requête effectuée sur votre site, que ce soit par un internaute, un robot d’indexation (comme Googlebot), ou une application tierce. À chaque visite, une ligne de log est créée, consignant une série d’informations précises et horodatées. Selon la configuration de votre serveur (Apache, Nginx, LiteSpeed, etc.), ces logs peuvent être stockés dans différents fichiers (access.log, error.log, etc.) et contenir plus ou moins d’informations. L’analyse de ces fichiers permet d’obtenir une vision très fine et détaillée de la manière dont votre site est consulté, notamment par les robots des moteurs de recherche. Voici les données que l’on retrouve généralement dans une ligne de log serveur classique :

- L’adresse IP du visiteur (ou du robot), permettant d’identifier l’origine de la requête ;

- La date et l’heure exactes de l’accès ;

- La méthode HTTP utilisée : souvent

GETpour une simple consultation ouPOSTpour l’envoi d’un formulaire ; - L’URL exacte demandée sur votre site Web ;

- Le code de réponse HTTP renvoyé par le serveur (200 = OK, 404 = page introuvable, 301 = redirection permanente, etc.) ;

- Le user-agent, c’est-à-dire l’outil ou logiciel qui a effectué la requête (navigateur web, crawler, outil de monitoring…) ;

- Le temps de réponse du serveur (optionnel mais très utile pour le SEO technique).

Voici un exemple typique de ligne de log brute :

66.249.66.1 - - [30/Dec/2025:14:32:10 +0000] "GET /page-exemple.html HTTP/1.1" 200 5323 "-" "Googlebot/2.1 (+http://www.google.com/bot.html)"

Dans cet exemple, on voit que l’IP 66.249.66.1, appartenant à Googlebot, a accédé à la page /page-exemple.html le 30 décembre 2025, et que le serveur a répondu avec un code 200, indiquant que la page a été servie correctement.

Pour un référenceur ou un consultant SEO Senior, ces données sont précieuses car elles permettent de répondre à des questions clés : Googlebot explore-t-il bien mes pages stratégiques ? Y a-t-il des erreurs de crawl que je n’ai pas détectées dans la Search Console ? Mon budget de crawl est-il gaspillé sur des pages inutiles ? Contrairement à la Search Console qui fournit une vue partielle ou échantillonnée, les logs serveurs représentent une source de vérité brute. Ils permettent d’avoir une vision exhaustive de l’activité des crawlers sur votre site. En SEO, cela ouvre la porte à des optimisations très ciblées, notamment sur les performances, la structure des liens internes, la pertinence des redirections ou encore l’identification de pages orphelines.

Les logs offrent donc une lecture stratégique du comportement des moteurs de recherche sur votre site, bien au-delà de ce que permettent les outils classiques d’analyse de trafic ou d’audit. Exploités correctement, ils deviennent un véritable atout pour affiner votre stratégie SEO technique.

Exploiter les logs serveurs pour identifier des opportunités SEO

L’analyse de logs est une démarche complémentaire à l’audit SEO classique. Elle permet d’accéder à des données factuelles, sans les biais potentiels des outils d’estimation. Voici les principaux enseignements que vous pouvez en tirer :

1. Identifier les pages réellement explorées par Google

Contrairement à ce que laisse penser la Google Search Console, qui fournit des données agrégées sur l’indexation et la visibilité (et parfois avec un certain délai), les logs serveurs permettent d’observer les visites des crawlers de façon précise, en temps réel, et sans filtre. Vous découvrez ainsi, ligne par ligne, quelles URL ont été réellement explorées par des robots comme Googlebot, Bingbot ou encore AhrefsBot.

Cet aperçu brut est précieux, car il révèle souvent un écart entre ce que vous pensez que Google voit… et ce qu’il explore vraiment. Vous pouvez alors :

- Détecter des pages jamais crawlées : certaines pages peuvent être totalement absentes des logs. Cela signifie que Google ne les visite pas, souvent parce qu’elles sont isolées dans le maillage interne, non liées depuis d’autres pages, ou exclues du sitemap. Ces pages dites « orphelines » passent donc totalement sous le radar, malgré leur potentiel SEO.

- Repérer des pages sur-crawlées : à l’inverse, certaines pages sont visitées de façon excessive, parfois plusieurs dizaines de fois par jour. C’est le cas des pages de pagination, des filtres e-commerce mal balisés (sans balise

rel="canonical"ounoindex) ou des URL dynamiques générées en masse. Un crawl trop fréquent sur ces pages non stratégiques dilapide le budget de crawl et ralentit la découverte des pages importantes. - Mesurer l’impact réel de vos actions SEO : après une refonte d’arborescence, l’ajout d’un cocon sémantique ou la mise en place d’un nouveau maillage interne, les logs permettent de vérifier si Google a bien modifié son comportement de crawl. Vous pouvez ainsi observer si les nouvelles pages sont explorées, si les anciennes sont encore consultées, ou si des erreurs persistent.

En croisant les logs avec une cartographie des URL du site (sitemap XML, crawl complet, liste des pages stratégiques), il devient possible de construire une matrice de suivi extrêmement utile pour :

- Prioriser les actions d’optimisation sur les pages importantes non visitées

- Réduire les accès inutiles aux pages techniques ou sans valeur SEO

- Faciliter l’indexation de nouveaux contenus grâce à une meilleure compréhension du comportement des bots

Par exemple, si vous lancez une nouvelle rubrique éditoriale ou des pages locales ciblant des mots clés géographiques, les logs vous indiqueront si ces pages ont bien été découvertes, et à quelle fréquence. C’est un indicateur d’efficacité immédiat pour mesurer l’exposition de votre contenu aux moteurs de recherche.

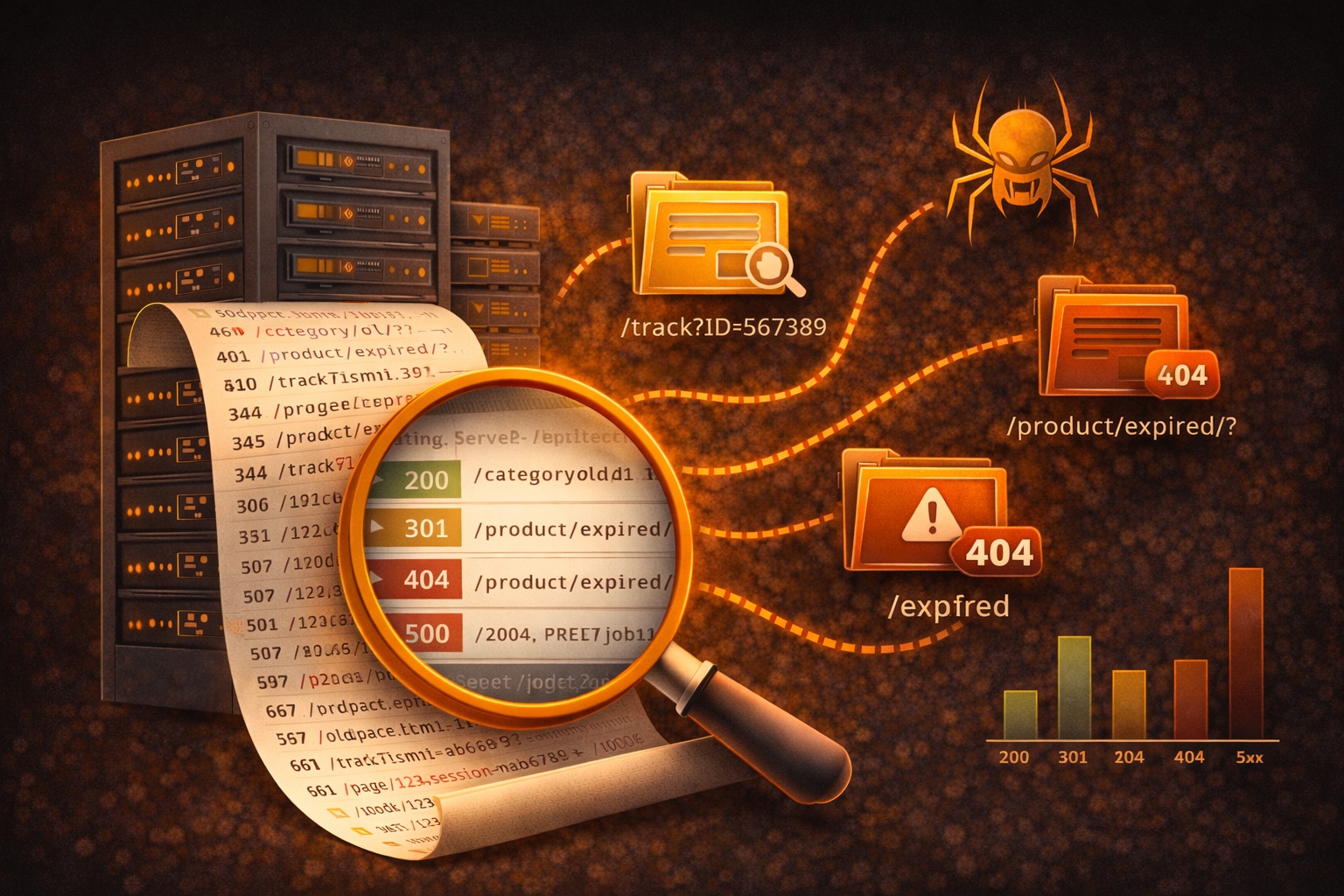

2. Analyser les codes HTTP rencontrés

Dans un log serveur, chaque requête est associée à un code de réponse HTTP qui indique si la page demandée a été correctement servie ou si une erreur s’est produite. Un code 200 est idéal : il signifie que la page a été trouvée et chargée normalement. Mais l’intérêt des logs ne se limite pas à la confirmation de pages valides. En analysant les autres codes HTTP, on accède à un diagnostic précis des problèmes techniques qui peuvent affecter le crawl, l’indexation et même l’expérience utilisateur. Voici les cas les plus fréquents repérés dans l’analyse de logs en SEO :

- Des erreurs 404 générées par les robots : ces erreurs indiquent que Googlebot ou un autre crawler a tenté d’accéder à une page qui n’existe plus. Cela peut être dû à :

- un lien cassé dans le maillage interne,

- un backlink externe pointant vers une ancienne URL,

- une suppression de contenu non redirigée correctement.

Trop d’erreurs 404 peuvent envoyer des signaux de mauvaise qualité aux moteurs et nuisent à l’efficacité du crawl.

- Des chaînes de redirection 301 ou 302 : une redirection unique est acceptable, mais les logs peuvent révéler des redirections en cascade (ex : A → B → C), qui gaspillent le budget de crawl et allongent le temps de chargement. Googlebot peut finir par abandonner la requête, surtout si la chaîne est trop longue ou mal optimisée.

- Des erreurs serveur 5xx : les codes comme 500, 502 ou 503 signalent des problèmes techniques côté serveur. S’ils sont ponctuels, ils peuvent passer inaperçus. Mais lorsqu’ils se répètent, Google peut décider de ralentir voire de suspendre temporairement le crawl, impactant la visibilité des pages concernées. C’est un signal critique à surveiller.

Les logs vous permettent aussi de repérer les codes 403 (accès interdit), qui peuvent trahir une configuration mal pensée (robots bloqués accidentellement), ou encore les 429 (trop de requêtes), qui indiquent que votre site limite le crawl pour des raisons de surcharge.

Voici un exemple simplifié d’analyse de distribution des codes dans les logs :

| Code HTTP | Signification | Nombre de requêtes (mois en cours) |

|---|---|---|

| 200 | Page servie correctement | 8 754 |

| 301 | Redirection permanente | 1 230 |

| 404 | Page introuvable | 642 |

| 503 | Service indisponible | 73 |

Ce type de suivi permet de repérer rapidement des anomalies ou des dérives. Par exemple, une hausse soudaine des erreurs 404 peut signaler un changement dans les URLs mal pris en compte (migration, refonte…), ou encore un scraping malveillant d’anciennes pages supprimées. Plan d’action SEO : en fonction de l’analyse, vous pouvez :

- mettre à jour ou corriger les liens cassés dans le maillage interne,

- ajouter des redirections 301 propres pour les URLs supprimées,

- réduire les chaînes de redirection à un seul saut maximum,

- travailler avec l’hébergeur pour corriger les erreurs 5xx récurrentes,

- configurer une surveillance automatique des pics d’erreur grâce à des outils comme OnCrawl ou Seolyzer.

Mettre en place un suivi régulier (hebdomadaire ou mensuel) des codes HTTP permet non seulement d’assurer la stabilité technique du site, mais aussi de préserver une bonne relation avec les robots des moteurs de recherche. Plus le crawl est fluide et sans erreur, plus Google pourra consacrer ses ressources à indexer vos pages stratégiques.

3. Détecter du crawl sur des URL inutiles ou obsolètes

L’un des apports majeurs de l’analyse des logs serveurs consiste à identifier les URLs que les robots des moteurs de recherche continuent d’explorer alors qu’elles n’ont plus, ou n’ont jamais eu, de véritable intérêt SEO. Ces pages peuvent être techniques, historiques ou générées automatiquement par le CMS, et représentent souvent une part importante du crawl total. Parmi les cas les plus fréquents, on retrouve :

- des anciennes versions de pages conservées après une refonte ou une migration,

- des fiches produits désactivées ou en rupture définitive sur un site e‑commerce,

- des URLs de filtres et de tris générées par la navigation à facettes,

- des pages de résultats internes, paramètres de tracking ou URLs avec des identifiants de session.

Le problème n’est pas seulement que ces pages soient explorées, mais qu’elles le soient au détriment des pages réellement stratégiques. Chaque passage de Googlebot sur une URL inutile consomme une partie de votre budget de crawl, limitant la fréquence d’exploration des pages importantes comme les pages catégories, les contenus éditoriaux ou les nouvelles pages mises en ligne. Les logs permettent d’objectiver ce phénomène. En croisant les URLs crawlées avec leur valeur SEO réelle (trafic, positionnement, conversion), vous pouvez rapidement mettre en évidence :

- des pages très souvent visitées par les robots mais sans trafic organique,

- des répertoires entiers crawlés inutilement,

- des paramètres d’URL responsables d’une explosion du nombre de pages explorées.

Une fois ces URLs identifiées, plusieurs leviers techniques peuvent être activés pour reprendre le contrôle du crawl :

- Désindexer les pages sans valeur à l’aide d’une balise

meta noindexou d’un en-tête HTTPX-Robots-Tag, tout en laissant éventuellement le crawl actif si nécessaire ; - Bloquer le crawl via le fichier robots.txt lorsque certaines sections du site n’ont aucune utilité pour les moteurs de recherche (ex : paramètres de filtres, pages de tri, URLs internes techniques) ;

- Mettre en place des redirections propres (301) vers des pages pertinentes lorsque des contenus ont été supprimés ou fusionnés, afin de canaliser le crawl et la popularité ;

- Supprimer définitivement certaines URLs lorsqu’elles n’ont aucune justification fonctionnelle ou SEO, en veillant à ne pas créer d’erreurs en chaîne.

Ce travail d’assainissement a un impact direct sur la performance SEO globale. En réduisant le bruit technique et les explorations inutiles, vous facilitez la tâche des robots, améliorez la découverte de vos contenus stratégiques et renforcez la cohérence de l’indexation. Sur des sites volumineux (e‑commerce, plateformes éditoriales, marketplaces), cette étape est souvent déterminante.

4. Prioriser les pages stratégiques peu crawlées

Il ne suffit pas de publier une page bien optimisée pour qu’elle soit visible sur Google. Encore faut-il que les robots d’exploration la découvrent, l’analysent et l’indexent. Une page stratégique (comme une landing page SEO ciblant une requête à fort potentiel) peut parfaitement rester invisible si elle est mal intégrée dans la structure du site. C’est là que l’analyse des logs serveurs devient une arme redoutable. Les logs permettent de répondre à une question fondamentale : quelles sont les pages importantes que Googlebot n’explore pas ou très peu ? Ces pages « sous-crawlées » ne sont pas nécessairement absentes de votre site, mais elles souffrent souvent de plusieurs handicaps :

- Un manque de liens internes pointant vers elles, ce qui les rend difficiles à atteindre pour les robots,

- Une position trop profonde dans l’arborescence (niveau 4 ou plus),

- Une absence dans le sitemap XML,

- Des performances techniques insuffisantes (temps de chargement trop élevé, erreurs serveur ponctuelles),

- Ou une concurrence interne trop forte (cannibalisation, pages similaires).

Ces pages, pourtant potentiellement très pertinentes pour votre référencement, ne bénéficient donc pas d’une exposition suffisante. Elles restent dans l’ombre alors qu’elles pourraient générer du trafic qualifié, des conversions ou améliorer votre couverture sémantique. Grâce aux logs, vous identifiez précisément quelles pages sont peu ou pas visitées par Googlebot. En croisant cette donnée avec vos objectifs SEO, votre stratégie de contenu ou vos cibles commerciales, vous pouvez ensuite agir de façon concrète pour leur redonner de la visibilité :

- Ajouter des liens internes depuis des pages bien crawlées (pages piliers, homepage, articles populaires…). Le lien interne reste l’un des signaux les plus forts pour guider les robots d’un moteur ;

- Les inclure dans le sitemap XML si ce n’est pas déjà fait. Le sitemap ne garantit pas le crawl, mais facilite la découverte initiale, notamment pour des pages fraîchement publiées ;

- Optimiser leur structure technique : Balises Hn, données structurées, balises meta, poids des images, temps de chargement, etc. Des performances techniques solides favorisent l’exploration et l’indexation ;

- Améliorer la cohérence thématique autour de la page : Renforcer le champ lexical, créer un cluster de contenus autour du sujet, créer une page pilier si besoin.

Ce travail permet de réorienter les efforts SEO vers les contenus qui comptent vraiment pour votre activité, en renforçant leur exposition aux moteurs. Il est particulièrement utile dans les cas suivants :

- nouvelle rubrique éditoriale ou campagne de contenu récemment lancée,

- pages de service locales ou géolocalisées, souvent oubliées dans le maillage,

- pages produit stratégiques en e‑commerce (meilleurs vendeurs, produits en marge forte, etc.),

- pages de prise de contact, devis ou génération de leads.

En priorisant ces pages peu crawlées mais à forte valeur, vous améliorez non seulement leur visibilité, mais aussi la rentabilité de votre stratégie SEO. C’est une façon de maximiser le retour sur investissement de vos contenus existants, sans forcément produire de nouvelles pages.

À l’échelle d’un site de taille moyenne ou importante, cette approche s’inscrit parfaitement dans une logique de pilotage SEO : faire mieux avec ce qui est déjà en ligne, en exploitant les données réelles issues des logs plutôt que des estimations ou des suppositions.

5. Détecter les pics d’activité ou les ralentissements serveur

Les logs serveurs constituent un outil de surveillance particulièrement efficace pour suivre l’intensité et la régularité du crawl des moteurs de recherche. En analysant le volume de requêtes émises par Googlebot au fil du temps, il devient possible d’identifier rapidement des anomalies, qu’il s’agisse de pics d’activité inhabituels ou, au contraire, de chutes soudaines du nombre de visites. Une baisse brutale du crawl n’est jamais anodine. Elle peut révéler plusieurs types de problèmes techniques ou structurels :

- Un blocage involontaire via le fichier robots.txt ou une règle serveur trop restrictive,

- Un ralentissement du serveur (temps de réponse élevé, surcharge CPU, problèmes d’hébergement),

- Une série d’erreurs 5xx ayant conduit Googlebot à limiter temporairement ses passages,

- Un changement d’arborescence ou de structure d’URL mal interprété par les robots après une refonte ou une migration,

- Un problème de sécurité ou de configuration réseau (firewall, CDN, protection anti‑bot trop agressive).

À l’inverse, les logs peuvent aussi mettre en évidence des pics d’activité anormaux, parfois causés par :

- Une explosion d’URLs générées automatiquement (paramètres, facettes, pagination),

- Une mauvaise gestion des redirections,

- Une tentative de scraping intensif par des bots tiers,

- Ou encore un site qui devient soudainement plus attractif pour les moteurs après une mise à jour majeure.

Dans tous les cas, ces variations ont un impact direct sur la visibilité SEO. Un crawl instable peut retarder l’indexation de nouveaux contenus, empêcher la prise en compte de mises à jour importantes ou réduire la fréquence de rafraîchissement des pages existantes dans l’index de Google. Grâce aux logs, vous disposez d’une vision quasi temps réel du comportement des crawlers. Contrairement à certains rapports différés, ils permettent de détecter rapidement une anomalie et d’agir avant que les conséquences ne deviennent visibles dans les positions ou le trafic organique. Dans une logique d’exploitation SEO, il est pertinent de :

- mettre en place un suivi régulier du volume de crawl (par jour ou par semaine),

- croiser les données de logs avec les performances serveur (temps de réponse, charge, disponibilité),

- analyser les périodes de baisse ou de hausse en lien avec les changements récents (déploiement, refonte, ajout massif de pages),

- configurer des alertes automatiques via des outils d’analyse de logs pour être prévenu en cas de dérive.

Cette capacité de détection précoce fait des logs serveurs un véritable tableau de bord technique pour le SEO. Ils permettent non seulement de comprendre ce qui s’est passé, mais surtout d’anticiper les impacts sur la visibilité et d’agir de manière proactive.

Sur des sites à fort enjeu SEO, comme les e‑commerces ou les médias, cette surveillance continue est souvent un facteur déterminant pour maintenir une performance stable et éviter des pertes de trafic difficiles à rattraper.

0 commentaires