Depuis fin 2024, les professionnels du SEO doivent composer avec la disparition progressive du paramètre « &num=100 », autrefois essentiel pour afficher les 100 premiers résultats de Google sur une seule page. Longtemps exploité pour faciliter le suivi de positionnement, ce paramètre n’est désormais plus pris en charge, Google ayant officiellement abandonné son fonctionnement. Dans cet article, voyons ensemble quelles conséquences ce petit événement a sur les outils et sur la manière de procéder au suivi du référencement naturel SEO.

Le paramètre num=100 : Un outil discret mais stratégique dans le suivi SEO

Le paramètre &num=100 n’était pas connu du grand public, mais il figurait parmi les leviers techniques les plus précieux pour les professionnels du référencement. En l’ajoutant à une URL de recherche Google, il permettait d’afficher jusqu’à 100 résultats organiques sur une seule page, contournant ainsi la pagination classique imposée par le moteur. Ce simple ajustement offrait un gain de temps considérable dans les analyses, tout en réduisant les ressources nécessaires à la collecte des données. Il était particulièrement prisé dans les processus de scraping, les audits concurrentiels et le suivi de positionnement à grande échelle.

Jusqu’à la fin de l’année 2023, ce paramètre faisait partie intégrante des architectures techniques de nombreux outils SEO, qu’ils soient développés en interne ou proposés commercialement. Des plateformes comme Monitorank, Yooda Insight, Ahrefs, SEMrush ou encore SEObserver l’utilisaient pour extraire efficacement l’ensemble du top 100 sur des mots-clés stratégiques. Grâce à lui, un seul appel HTTP suffisait pour obtenir une vision complète et fiable des résultats, sans avoir à simuler une navigation utilisateur ou déclencher plusieurs chargements de page. Cela contribuait à optimiser les performances serveurs et à maintenir des coûts d’infrastructure raisonnables, notamment dans le cadre de suivis quotidiens sur des milliers de requêtes.

À partir de fin 2024, cependant, les choses évoluent : Les référenceurs commencent à signaler des comportements incohérents. Tantôt le paramètre fonctionne normalement, tantôt il est ignoré, et Google revient à un affichage par défaut en 10 ou 20 résultats par page. Ces anomalies, d’abord perçues comme de simples dysfonctionnements, se révèlent rapidement être le symptôme d’une expérimentation plus large. Google semble mener des tests A/B à grande échelle sur le traitement de l’URL &num=100, sans communication officielle à ce sujet. La prise en charge du paramètre devient instable, et varie selon plusieurs critères : être connecté ou non à un compte Google, la géolocalisation de l’utilisateur, le type d’appareil utilisé, ou encore le navigateur.

Des observateurs comme Barry Schwartz (Search Engine Roundtable) relaient alors ces constats sur les réseaux sociaux et dans la communauté SEO*. Le phénomène s’intensifie début 2025, et les témoignages se multiplient. À ce stade, la majorité des professionnels s’accordent à dire que Google n’est plus simplement en phase de test : il est en train de retirer progressivement cette fonctionnalité. L’abandon du paramètre &num=100 ne relève plus d’un bug temporaire, mais bien d’un changement structurel dans la manière dont Google entend faire évoluer l’accès à ses résultats de recherche.

Ce retrait discret mais systématique du paramètre a des implications profondes sur la façon dont les outils SEO peuvent interagir avec les SERP. Il inaugure une nouvelle ère dans laquelle Google verrouille davantage l’accès technique à ses données, tout en obligeant les éditeurs de solutions à revoir leurs méthodes de collecte et d’analyse. Le « top 100 » en un seul appel n’est plus garanti, et avec lui, c’est toute une chaîne de valeur qui doit s’adapter en urgence.

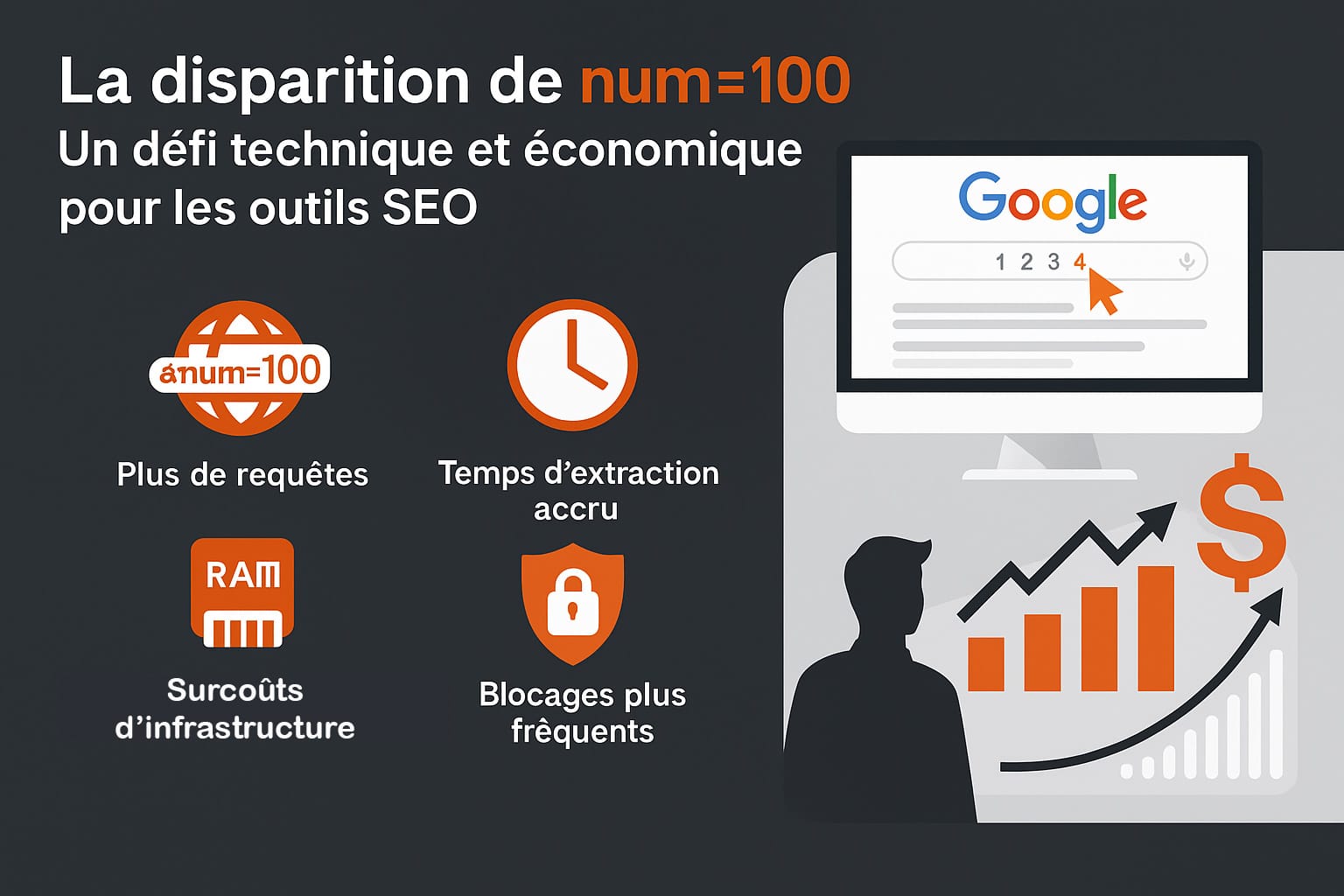

La disparition de num=100 : Un défi technique et économique pour les outils SEO

La disparition progressive du paramètre &num=100 n’est pas un simple ajustement de fonctionnalité, mais un véritable tournant pour les outils SEO. En rendant impossible l’affichage des 100 premiers résultats sur une seule page, Google complexifie considérablement l’accès automatisé à ses données de recherche. Là où une seule requête suffisait auparavant, il faut désormais charger manuellement (ou par script) chaque page de résultats, souvent à raison de 10 liens par page. Depuis le retour à la pagination classique en juin 2024, chaque page de la SERP équivaut à un rechargement complet du DOM, ce qui a plusieurs implications lourdes. Autrefois, grâce au scroll continu et à la légèreté des requêtes, les outils pouvaient extraire les positions de manière fluide et rapide. Désormais, le moindre appel nécessite une exécution JavaScript, un rendu complet, et un traitement intensif côté serveur. Cela signifie une consommation accrue de bande passante, de mémoire vive (RAM) et de processeur (CPU). De plus, à chaque chargement de page, les risques de déclencher un CAPTCHA ou de voir l’IP temporairement bloquée augmentent significativement. Le scraping est devenu plus lent, plus instable et bien plus coûteux à maintenir à grande échelle.

Des professionnels comme Fabien Barry (Monitorank) ont documenté cette transition sur LinkedIn, évoquant des surcoûts pouvant atteindre x5 à x7 selon les technologies employées. Certaines infrastructures, notamment celles basées sur des navigateurs headless comme Puppeteer ou Playwright, ont vu leurs ressources exploser : gestion du JavaScript, traitements DOM lourds, parallélisation des tâches, maintenance des proxys… autant de contraintes qui forcent aujourd’hui les éditeurs de solutions SEO à revoir leurs modèles économiques. Dans certains cas, cela s’est traduit par une réduction du nombre de pages trackées, une limitation du volume de mots-clés suivis, ou même une augmentation tarifaire pour les clients finaux. Voici un récapitulatif synthétique des principaux impacts constatés sur les outils SEO :

| Élément impacté | Conséquence de la disparition du paramètre &num=100 |

|---|---|

| Nombre de requêtes nécessaires | Passage de 1 à 5 ou 10 requêtes pour récupérer le top 100 |

| Temps moyen d’extraction | Multiplié par 5 à 8, selon les délais de chargement des pages |

| Ressources serveur mobilisées | Hausse importante de l’usage CPU, RAM et bande passante |

| Stabilité du scraping | Augmentation des blocages (IP bans, CAPTCHA) dès la 3e ou 4e page |

| Coût d’infrastructure | Multiplié par 5 à 7 selon la technologie utilisée (headless browser, proxy rotation, etc.) |

| Accessibilité des données complètes | Réduction des volumes exploitables et nécessité d’échantillonner davantage |

Depuis janvier 2025, une contrainte supplémentaire est venue compliquer encore la donne : Google impose désormais l’activation du JavaScript pour accéder à ses SERP de manière complète. Cela signifie que les solutions ne peuvent plus se contenter d’un appel HTML classique ; elles doivent désormais simuler une vraie session utilisateur, avec rendu de page, clics et comportement réaliste. Cela alourdit significativement le traitement, et impose souvent l’utilisation de navigateurs automatisés de type Chromium sans interface (headless).

Par ailleurs, Google semble renforcer les mécanismes de détection des comportements automatisés. Les systèmes de scraping doivent donc non seulement gérer des volumes plus élevés, mais aussi contourner des restrictions plus complexes : cookies dynamiques, fingerprinting, challenges comportementaux, ou encore délais variables entre les chargements.

Dans ce nouveau contexte, une question se pose naturellement : Le top 100 des résultats reste-t-il un objectif pertinent ? Si son extraction devient techniquement lourde et économiquement coûteuse, certains outils choisissent désormais de n’analyser que les 30 à 50 premiers résultats, plus proches du comportement réel des internautes. Ce recentrage s’accompagne souvent d’un repositionnement stratégique : Produire moins de données brutes, mais de meilleure qualité, plus contextualisée, et davantage orientée vers la compréhension de l’intention utilisateur.

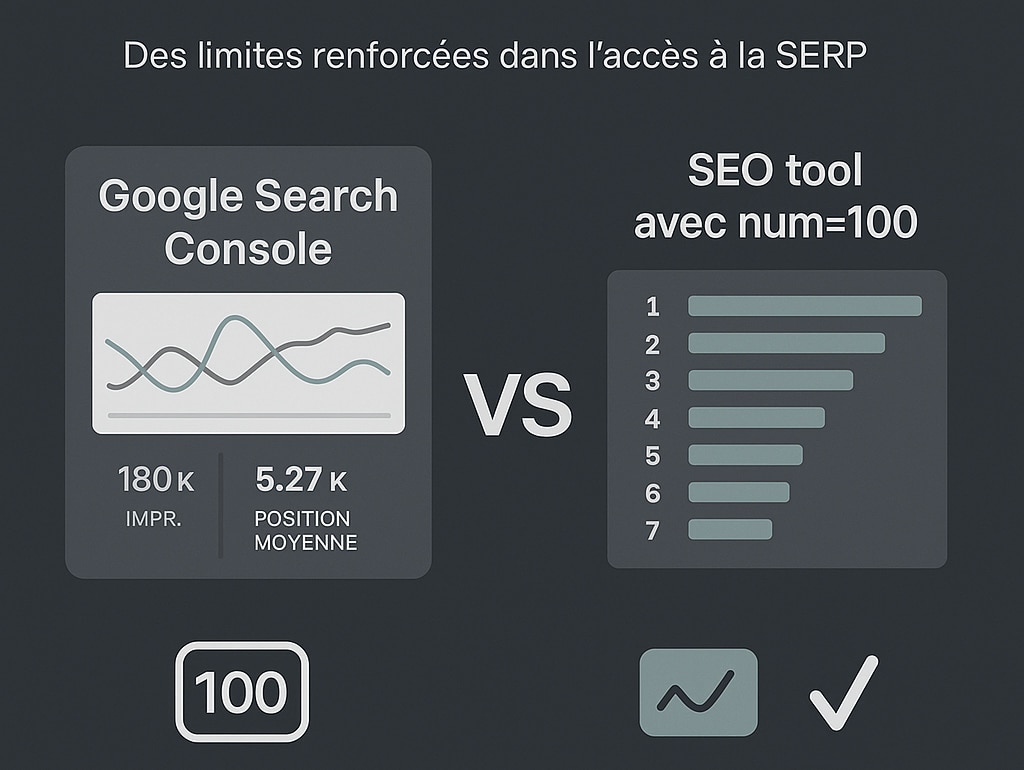

Search console et données partagées : des limites renforcées dans l’accès à la SERP

Face aux nouvelles contraintes imposées par la disparition du paramètre &num=100, la Google Search Console pourrait apparaître, en première lecture, comme une solution de repli pour les professionnels du référencement. Puisqu’elle fournit des données directement issues de Google (impressions, clics, taux de clics, positions moyennes) elle semble être un canal fiable pour analyser les performances d’un site dans les résultats de recherche. Pourtant, en y regardant de plus près, la Search Console présente des limites structurelles qui réduisent fortement son utilité en tant que substitut aux outils SEO classiques. Tout d’abord, la Search Console n’offre pas un accès complet et granulaire à la SERP. Elle ne permet pas de visualiser l’ensemble des résultats pour une requête donnée à un instant T, ce qui exclut toute capacité à reconstruire une SERP fidèle. De nombreux mots-clés, notamment ceux classés au-delà de la 50e position, ne sont tout simplement pas affichés, ou le sont sous forme agrégée. Cette limitation devient particulièrement problématique lorsque l’on cherche à évaluer la concurrence, à analyser des signaux faibles, ou à suivre des positions secondaires dans une stratégie de longue traîne.

A noter que l’impact sur le suivi des courbes GSC est impacté comme on le voit dans l’exemple que nous donnions sur la performance d’un E-commerce (septembre).

De plus, les données de position fournies par la Search Console sont des moyennes calculées sur une période donnée, souvent influencées par la localisation, le type d’appareil, ou la personnalisation des résultats. Elles ne permettent donc pas de connaître la position réelle d’une URL sur une requête donnée, à un moment précis. À l’inverse, les outils SEO tiers permettaient (grâce à &num=100) d’obtenir cette précision sur demande, en simulant une recherche standardisée.

Autre point clé : La mise à jour des données dans la Search Console n’est ni instantanée, ni systématique. Il faut parfois attendre 24 à 72 heures pour que les dernières impressions ou clics soient visibles. Cette latence complique le pilotage en temps réel, notamment pour le suivi post-publication, les tests SEO ou les campagnes de contenu réactif. À cela s’ajoute l’absence de fonctionnalités avancées comme le suivi concurrentiel ou la visualisation historique complète par position individuelle. Le tableau ci-dessous synthétise ces différences fondamentales :

| Fonctionnalité ou critère | Limite observée avec la Google Search Console |

|---|---|

| Accès aux 100 premiers résultats | Non garanti, résultats partiels ou tronqués au-delà de la position 50 |

| Précision de la position | Affichage d’une position moyenne, sans détail par requête unique |

| Délai de mise à jour | Données disponibles après 24 à 72 heures |

| Accès à la SERP complète | Impossible d’obtenir une reconstitution fidèle d’une page de résultats |

| Suivi concurrentiel | Non disponible nativement, aucun affichage des concurrents par mot-clé |

| Granularité des données | Données agrégées par URL et requêtes, sans segmentation par page de résultat |

En définitive, la Google Search Console reste un outil indispensable pour obtenir une vision globale et orientée performance d’un site, notamment en matière de visibilité, de trafic organique et d’opportunités de croissance. Elle excelle dans la mise en lumière des tendances, l’identification des requêtes stratégiques et le diagnostic technique (pages exclues, erreurs d’exploration, etc.).

Mais elle ne peut se substituer aux outils de tracking SERP lorsqu’il s’agit d’analyser précisément le positionnement, la concurrence ou la structure des résultats à grande échelle. La disparition du paramètre &num=100 rend cette distinction encore plus nette : Les deux approches sont désormais complémentaires, mais nécessitent des arbitrages techniques et budgétaires plus fins.

* Article sur le sujet par Search Engine Rountable

0 commentaires