En 2025, le paysage du trafic web continue de se transformer. Si Google conserve une position dominante, de nouvelles sources comme les réseaux sociaux, l’accès direct ou les intelligences artificielles s’imposent peu à peu dans les stratégies d’acquisition. À partir des dernières données d’Ahrefs, cet article décrypte les parts de trafic d’un site internet, les tendances émergentes et les leviers à activer pour rester visible dans un écosystème numérique de plus en plus fragmenté.

La domination persistante de Google, mais un paysage qui se diversifie

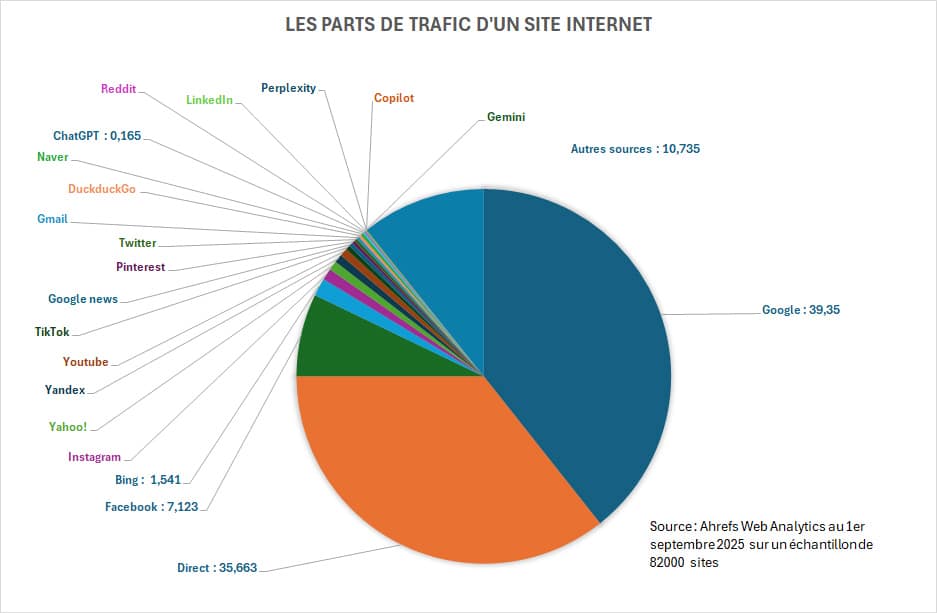

Depuis plus de deux décennies, Google façonne l’accès à l’information sur internet. Sa capacité à organiser le web, à proposer des résultats pertinents et à innover dans la recherche a fait de lui le moteur de référence pour des milliards d’utilisateurs. En 2025, cette domination se confirme une fois encore, avec 39,35 % du trafic web mondial généré par Google, selon les données issues d’Ahrefs Web Analytics*. Cela place la firme de Mountain View très largement en tête des sources de trafic, et confirme qu’une stratégie de visibilité en ligne reste étroitement liée à son écosystème.

Mais le monopole de Google ne s’exerce plus dans un vide. Contrairement aux années 2000 où il concentrait presque à lui seul les dynamiques de découverte de contenu, le trafic web d’aujourd’hui est marqué par une multiplication des canaux d’entrée. En deuxième position, on trouve le trafic direct (35,66 %) : Ces internautes qui tapent directement une URL ou cliquent sur un favori. Cela illustre le poids croissant de la fidélité des visiteurs et de la notoriété de marque, éléments devenus centraux dans un environnement digital saturé. Derrière ces deux piliers, des acteurs plus variés s’imposent : Facebook, avec 7,12 % du trafic, maintient un rôle important malgré une baisse d’attractivité chez les jeunes générations. Les plateformes comme Bing (1,54 %), Instagram, YouTube, Yahoo!, TikTok et Reddit apportent aussi leur part, parfois faible en volume, mais stratégique dans certaines niches, comme la vidéo, l’actualité ou les communautés spécialisées.

Enfin, on assiste à l’arrivée de nouveaux acteurs, plus récents : les assistants d’intelligence artificielle tels que ChatGPT (0,165 %), Gemini ou Perplexity. Leur impact reste marginal à ce jour, mais leur montée en puissance est visible, notamment en matière de consultation d’information ou de réponse directe, ce qui commence à influer sur les comportements de navigation. Voici un aperçu comparatif des principales sources de trafic en 2025 :

| Source | Part du trafic (%) |

|---|---|

| 39,35 | |

| Direct | 35,66 |

| 7,12 | |

| Autres sources (cumulées) | 10,73 |

| Bing | 1,54 |

| Instagram, Yahoo!, YouTube, TikTok… | < 1 chacune |

| ChatGPT | 0,165 |

Ce tableau confirme que si Google continue de régner, la carte du trafic web s’est étoffée au fil du temps. Chaque canal, même minoritaire, peut jouer un rôle stratégique selon les objectifs visés : notoriété, engagement, conversions ou référencement naturel. Quant aux intelligences artificielles génératives, elles restent encore à la marge, mais leur influence sur les parcours utilisateurs, et potentiellement sur les clics, ne fait que commencer à se dessiner. Voici a répartition plus détaillée sous forme de camembert :

Les intelligences artificielles : Des sources émergentes de trafic mais encore secondaires

Depuis les débuts de l’indexation web, les moteurs de recherche ont été les gardiens quasi exclusifs de la découverte de contenus. Mais en 2025, une nouvelle génération d’interfaces émerge avec l’ambition de redéfinir l’accès à l’information : les assistants d’intelligence artificielle générative. Portés par l’essor de modèles comme ChatGPT, Gemini ou Perplexity, ces outils promettent de transformer la manière dont les internautes formulent leurs requêtes… et dont les sites espèrent capter leur attention.

Pour autant, leur impact sur le trafic web reste aujourd’hui mesuré. Selon les données croisées d’Ahrefs et du rapport « AI SEO Statistics 2025 », Google génère encore 345 fois plus de trafic que ChatGPT, Gemini et Perplexity réunis. Même ChatGPT, pourtant leader dans le domaine, ne représente que 0,165 % du trafic moyen d’un site web, loin derrière les sources traditionnelles. Cette position marginale s’explique avant tout par la nature même de ces outils conversationnels. Contrairement aux moteurs classiques qui affichent une liste de liens, les assistants IA formulent des réponses complètes, contextuelles et souvent auto-suffisantes. Résultat : l’utilisateur trouve ce qu’il cherche sans forcément visiter un site. Les clics sont donc moins nombreux, malgré une forte exposition aux contenus de référence.

Mais si les volumes restent faibles, la qualité du trafic issu des IA semble prometteuse. Les visiteurs en provenance de ces plateformes passent plus de temps sur les pages, visitent en moyenne quatre contenus, et présentent parfois des taux de conversion supérieurs à ceux des visiteurs issus du référencement naturel traditionnel. Cela en fait un levier encore discret, mais à fort potentiel pour les éditeurs bien positionnés dans les réponses IA. Autre élément différenciant : La fraîcheur du contenu est déterminante dans la sélection opérée par ces outils. Les plateformes d’IA privilégient les sources récentes, en moyenne 25 % plus récentes que celles utilisées par les résultats organiques classiques. Ce critère redistribue les cartes, notamment pour les médias, les blogs spécialisés et les sites à forte actualité qui peuvent tirer leur épingle du jeu en publiant régulièrement du contenu mis à jour.

Enfin, la croissance du trafic IA est notable : il a été multiplié par 9,7 en seulement un an. Une dynamique alimentée par l’intégration progressive de ces assistants dans les navigateurs, les systèmes d’exploitation ou les outils bureautiques du quotidien. On pense notamment à Copilot dans Windows ou aux réponses générées dans la barre d’adresse de Chrome ou Edge. Autant d’interfaces où les clics deviennent plus rares, mais plus ciblés.

Quels leviers actionner pour capter le trafic multicanal en 2025

La fragmentation des sources de trafic en 2025 impose une transformation profonde des approches SEO et marketing digital. Autrefois centrées quasi exclusivement sur le référencement naturel dans Google, les stratégies efficaces doivent désormais intégrer une pluralité de points d’entrée : recherche organique classique, recommandations issues des IA génératives, réseaux sociaux, accès direct, messageries, voire plateformes vocales ou assistants intégrés aux navigateurs.

Dans ce nouvel environnement, les sites qui performent sont ceux qui parviennent à conjuguer technique, contenu et autorité de manière cohérente sur l’ensemble des canaux. Voici les leviers les plus pertinents à activer :

- Renforcer son référencement Google : Malgré l’émergence d’autres sources, Google reste le principal vecteur de trafic. Maintenir sa visibilité nécessite de respecter les fondamentaux techniques du SEO, en particulier :

- Structure HTML propre et hiérarchisée : Chaque page doit être organisée autour d’un unique

<h1>, suivi de<h2>,<h3>, etc., selon une arborescence logique. Éviter les titres sautés ou dupliqués ; - Contenu sémantiquement optimisé : Intégration naturelle des mots-clés principaux et secondaires dans les titres, paragraphes, listes et attributs ALT. Utilisation des entités nommées pour renforcer le contexte thématique ;

- Maillage interne maîtrisé : Liens internes placés dans les zones chaudes du contenu, avec ancres optimisées, pour renforcer la profondeur d’indexation et orienter le PageRank interne vers les pages stratégiques ;

- Backlinks de qualité : Acquisition de liens externes issus de domaines référents pertinents, à forte autorité, avec des ancres variées. Surveillance régulière via des outils comme Ahrefs ou Majestic ;

- Données structurées : Balisage JSON-LD conforme à schema.org sur les pages à fort potentiel (articles, FAQ, produits, événements) pour activer les résultats enrichis dans les SERP ;

- Gestion fine du crawl et de l’indexation : Usage réfléchi des directives

robots.txt, balisesmeta robots, canonicals, et pagination. Objectif : concentrer l’exploration sur les pages à forte valeur SEO ; - Fichiers techniques à jour :

sitemap.xmldynamique et propre,robots.txtsans erreurs bloquantes, et présence d’un fichierhumans.txtousecurity.txtselon le contexte ; - Architecture logique : Arborescence en silos thématiques, profondeur de clic limitée, URLs propres et hiérarchisées (

/categorie/sous-categorie/page.html) pour renforcer la cohérence sémantique et faciliter l’indexation.

- Structure HTML propre et hiérarchisée : Chaque page doit être organisée autour d’un unique

- Travailler la notoriété de marque (brand authority) : avec l’essor des IA, la visibilité dépend de plus en plus de la présence de la marque dans les contenus en ligne. Les IA comme ChatGPT ou Google AI Overviews accordent un poids important aux entités fréquemment citées :

- Les marques les plus mentionnées reçoivent jusqu’à 10 fois plus de citations dans les résultats IA ;

- Le nombre de mentions, la cohérence des ancres de lien (branded anchors) et le volume de recherches autour du nom de la marque influencent directement l’exposition dans les résumés générés par IA ;

- Les backlinks traditionnels ont une corrélation plus faible que les mentions de marque dans les algorithmes IA, ce qui pousse à développer des relations presse, partenariats éditoriaux et publications invitées.

- Produire du contenu frais et régulier : La fréquence de publication devient stratégique. Contrairement à Google qui valorise l’historique et l’autorité, les IA privilégient les sources récentes :

- Les contenus cités dans les résultats IA sont en moyenne 25,7 % plus récents que ceux présents dans les SERP classiques ;

- Mettre à jour régulièrement ses articles, ajouter des encadrés explicatifs ou des données fraîches augmente la probabilité d’apparaître dans les réponses générées par Perplexity ou ChatGPT ;

- Des outils comme structured data (schema.org) ou les balises

<lastmod>dans les sitemaps peuvent renforcer les signaux de fraîcheur.

- Diversifier les canaux sociaux : Le SEO ne vit plus en vase clos. En 2025, les réseaux sociaux génèrent toujours une part non négligeable du trafic, avec des plateformes comme Facebook (7,12 %), YouTube, TikTok ou même Reddit qui agissent comme des carrefours d’audience :

- Chaque plateforme a ses codes : Vertical video pour TikTok, formats longs pour YouTube, UGC pour Reddit. Adapter ses contenus natifs selon le canal est indispensable ;

- Les signaux sociaux peuvent influencer indirectement le SEO via une amplification de la visibilité et potentiellement l’acquisition de liens naturels ;

- Les extraits sociaux bien optimisés (titres, descriptions, miniatures) améliorent le CTR et renforcent la notoriété de marque, avec un impact positif sur les IA génératives également.

- Optimiser ses contenus pour les intelligences artificielles : Pour figurer dans les réponses générées par IA, il faut penser différemment :

- Rédiger avec clarté et concision : paragraphes courts, phrases structurées, style direct ;

- Utiliser des listes, tableaux, et définitions claires pour favoriser l’extraction automatique d’informations ;

- Répondre aux questions en début d’article (principe de l’inversion pyramidale), ce qui correspond mieux au fonctionnement des IA extractives ;

- Structurer ses contenus autour des requêtes naturelles (qui, quoi, comment, pourquoi…) afin d’aligner le contenu avec les modèles de langage utilisés par les IA conversationnelles ;

- Observer les citations dans les IA (via Perplexity ou Bing Chat) pour affiner son positionnement sémantique et sa stratégie éditoriale.

Ce contexte impose aux éditeurs, PME et marques de penser SEO au-delà de Google. Les comportements de recherche sont désormais hybrides et multicanaux : un même utilisateur peut découvrir un contenu via TikTok, le rechercher sur Google, puis poser une question sur ChatGPT… et cliquer sur un lien dans Perplexity. Comprendre ces parcours croisés est essentiel pour rester visible.

Enfin, dans une logique de performance, il devient stratégique de mesurer précisément la provenance et la qualité du trafic : intégration d’UTM tracking, suivi du temps de lecture, taux de conversion par canal, et analyse des sources d’attribution indirectes (assisted conversions). Ce sont ces données qui permettront d’affiner les arbitrages budgétaires entre SEO classique, contenu optimisé IA, SMO (Social Media Optimization) et marketing de notoriété.

Le SEO multicanal de nos jours n’est plus une option : C’est le socle indispensable d’une stratégie de visibilité durable dans un web régi par la volatilité des sources, l’instantanéité des requêtes et la personnalisation algorithmique croissante.

*Sources : Ahrefs Web Analytics, septembre 2025 – Étude sur 82 000 sites

0 commentaires