L’intelligence artificielle, ou IA, est un terme qui fascine autant qu’il interroge. De nos téléphones à nos voitures, des moteurs de recherche aux assistants vocaux, elle semble s’immiscer dans tous les pans de notre quotidien. Pourtant, que signifie réellement « intelligence artificielle » ? À quelles réalités scientifiques et technologiques ce concept renvoie-t-il ? Dans cet article, nous allons explorer les fondements de l’IA, sa définition et ses grands principes, pour en offrir une vision claire et accessible, adaptée à tous les niveaux de compréhension.

Comprendre la définition de l’intelligence artificielle, partir de son histoire

Pour saisir pleinement ce qu’est l’intelligence artificielle (IA), il est indispensable de remonter à ses origines, de suivre son évolution à travers les décennies, et de comprendre les concepts clés qui ont jalonné son développement. L’IA n’est pas née dans un laboratoire isolé, mais à l’intersection de plusieurs disciplines : mathématiques, logique, neurosciences, linguistique et informatique. Le terme « intelligence artificielle » est apparu pour la première fois en 1956, lors d’une conférence mythique organisée à Dartmouth College, aux États-Unis. Ce rendez-vous fondateur est aujourd’hui considéré comme l’acte de naissance officiel du domaine. À l’initiative de John McCarthy (mathématicien américain et professeur à Stanford) ce projet de recherche rassemblait plusieurs figures majeures, dont Marvin Minsky, Claude Shannon (le père de la théorie de l’information) et Nathaniel Rochester. L’objectif de cette réunion était clair : étudier comment des machines pourraient être rendues capables d’« apprendre tout aspect de l’intelligence humaine ».

À cette époque, l’ambition était immense, et le terme même d’intelligence artificielle faisait référence à la volonté de reproduire, voire de dépasser, les capacités cognitives humaines à travers des programmes informatiques. Cela incluait la résolution de problèmes, la planification, la compréhension du langage, la perception visuelle et même la créativité. Mais les racines intellectuelles de l’IA sont plus anciennes. On peut remonter à Alan Turing, mathématicien britannique qui, dès les années 1930-1940, posait les bases théoriques de la machine capable de penser. Dans son célèbre article de 1950, « Computing Machinery and Intelligence », Turing introduit le concept du test de Turing, une méthode visant à déterminer si une machine peut simuler une conversation humaine au point de tromper un interlocuteur humain. Ce test est encore aujourd’hui une référence dans la philosophie de l’IA.

Les années 1950-1970 furent marquées par un optimisme fort. On pensait qu’en quelques décennies, les machines pourraient égaler, voire surpasser, l’intelligence humaine. Les premiers programmes symboliques, comme le système Logic Theorist (1956) d’Allen Newell et Herbert Simon, ou ELIZA (1966), un simulateur de psychothérapeute développé par Joseph Weizenbaum au MIT, laissaient entrevoir les promesses de cette nouvelle science. Cependant, les limites techniques, la puissance de calcul insuffisante, le manque de données et l’inefficacité des algorithmes de l’époque ont entraîné ce que l’on appelle aujourd’hui les « hivers de l’IA » : des périodes de désintérêt et de réduction des financements, survenues notamment dans les années 1974-1980 puis à la fin des années 1980.

Le tournant décisif s’est produit dans les années 2000, grâce à trois évolutions majeures :

- Une explosion des capacités de calcul avec l’arrivée de processeurs plus puissants et de GPU dédiés à l’entraînement des modèles ;

- La disponibilité massive de données numériques (big data) issues d’internet, des capteurs, des réseaux sociaux ou des objets connectés ;

- Le perfectionnement des techniques d’apprentissage automatique (machine learning), en particulier du deep learning ou apprentissage profond, rendu célèbre par les réseaux de neurones artificiels multicouches.

Le machine learning repose sur la capacité des machines à extraire des modèles à partir de grandes quantités de données. À la différence des systèmes symboliques des débuts, il ne s’agit plus de programmer les règles, mais de laisser l’algorithme les découvrir lui-même. Le deep learning, en particulier, permet à des algorithmes d’imiter les connexions neuronales du cerveau humain à travers des couches hiérarchisées, et a donné lieu à des avancées majeures dans la reconnaissance d’images, la traduction automatique, et la génération de texte (comme c’est le cas ici avec les modèles de traitement du langage). Les travaux de chercheurs comme Geoffrey Hinton (Université de Toronto), Yann LeCun (Meta AI, pionnier du CNN – convolutional neural network), et Yoshua Bengio (Université de Montréal) ont été essentiels à cette révolution. Ensemble, ils ont reçu le Prix Turing en 2018, parfois considéré comme le « Nobel » de l’informatique, pour leur contribution décisive au développement du deep learning.

Voici quelques-uns des domaines dans lesquels l’intelligence artificielle intervient aujourd’hui :

- L’apprentissage automatique (ou machine learning) : c’est la capacité d’un système à améliorer ses performances en traitant de nouvelles données, sans modification explicite du programme. Il est utilisé dans les moteurs de recommandation, la détection de fraudes ou les assistants vocaux ;

- Le traitement automatique du langage naturel (TALN) : il permet aux machines de comprendre et de produire du langage humain. On le retrouve dans les traducteurs automatiques, les chatbots, ou les systèmes de résumé automatique ;

- La vision par ordinateur : grâce à l’analyse d’images, les machines peuvent reconnaître des visages, lire des plaques d’immatriculation ou diagnostiquer des maladies à partir d’imageries médicales ;

- La robotique : en associant IA et capteurs, les robots peuvent naviguer dans un environnement complexe, prendre des décisions en temps réel et interagir avec les humains.

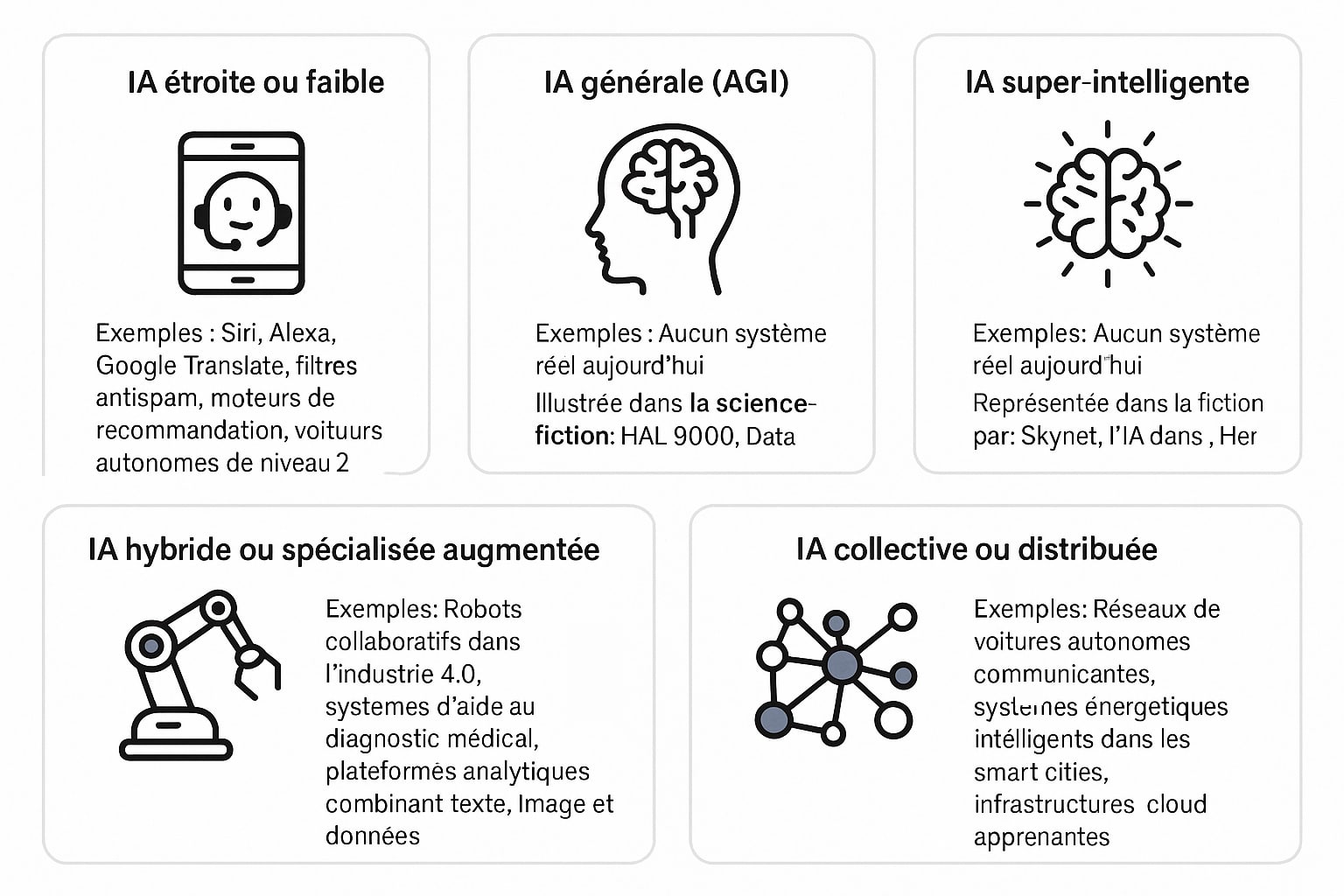

Enfin, l’intelligence artificielle se décline aujourd’hui en différents niveaux, dont voici les principaux :

| IA étroite ou faible | Cette forme d’intelligence artificielle est conçue pour exécuter une tâche spécifique, comme reconnaître une voix, traduire un texte ou détecter un visage. Elle ne possède ni conscience, ni compréhension contextuelle, et ne peut pas s’adapter à des tâches pour lesquelles elle n’a pas été entraînée. C’est l’unique forme d’IA réellement opérationnelle aujourd’hui. Exemples : Siri, Alexa, Google Translate, filtres antispam, moteurs de recommandation (Netflix, YouTube), voitures autonomes de niveau 2. |

|---|---|

| IA générale (AGI) | L’intelligence artificielle générale, ou AGI (Artificial General Intelligence), désigne une IA capable de comprendre, apprendre et exécuter n’importe quelle tâche intellectuelle que peut accomplir un humain. Elle pourrait généraliser ses apprentissages à des domaines variés, s’adapter et raisonner de façon autonome. Ce niveau d’IA n’existe pas encore, mais constitue un objectif recherché par de nombreux laboratoires de recherche. Exemples : Aucun système réel aujourd’hui. Illustrée dans la science-fiction : HAL 9000 (« 2001, l’Odyssée de l’espace »), Data (« Star Trek »). |

| IA super-intelligente | Ce niveau d’IA serait supérieur à l’intelligence humaine dans tous les domaines, y compris la créativité, la stratégie, la prise de décision et l’intelligence émotionnelle. Elle pourrait théoriquement concevoir des solutions que les humains ne pourraient même pas envisager. Cette hypothèse soulève d’importantes questions éthiques et de gouvernance technologique. Exemples : Aucun système réel aujourd’hui. Représentée dans la fiction par Skynet (« Terminator ») ou l’IA dans « Her » de Spike Jonze. |

| IA hybride ou spécialisée augmentée | Ce type d’IA combine plusieurs systèmes spécialisés pour accomplir des tâches complexes dans des environnements dynamiques. Elle n’atteint pas l’autonomie de l’AGI, mais peut être déployée dans des contextes industriels, médicaux ou logistiques avec un certain niveau d’adaptabilité. Elle est souvent assistée ou encadrée par l’humain. Exemples : Robots collaboratifs dans l’industrie 4.0, systèmes d’aide au diagnostic médical, plateformes analytiques combinant texte, image et données. |

| IA collective ou distribuée | Il s’agit d’un réseau de systèmes intelligents connectés entre eux, partageant des données pour apprendre et s’améliorer collectivement. Cette approche s’inspire de l’intelligence en essaim observée chez certaines espèces animales. Elle est déjà en développement dans des domaines comme les villes intelligentes ou les véhicules connectés. Exemples : Réseaux de voitures autonomes communicantes, systèmes énergétiques intelligents dans les smart cities, infrastructures cloud apprenantes. |

À travers cette perspective historique et conceptuelle, il apparaît clairement que l’intelligence artificielle est bien plus qu’un simple outil technologique : C’est une aventure scientifique, humaine et culturelle qui façonne notre présent et dessinera probablement les contours de notre avenir.

Les grands principes de fonctionnement de l’IA

Pour comprendre comment fonctionne une intelligence artificielle, il est nécessaire d’en explorer les grands principes, à la fois techniques, logiques et conceptuels. Si les approches peuvent varier selon les courants (symbolique, connexionniste, probabiliste ou hybride), plusieurs composantes fondamentales sont systématiquement mobilisées dans la mise en œuvre d’un système d’IA moderne. Ces principes, bien qu’issus de disciplines diverses (mathématiques, statistiques, informatique, neurobiologie), interagissent étroitement dans tous les modèles performants utilisés aujourd’hui.

| Les données | Les données sont la matière première de toute intelligence artificielle. Qu’elles soient textuelles (des articles, des messages), visuelles (des images ou vidéos), sonores (voix, musique) ou numériques (chiffres, capteurs), elles servent à alimenter le modèle. Sans un volume massif et diversifié de données, aucun système ne peut apprendre efficacement. Les performances d’un algorithme d’IA dépendent directement de la qualité, de la représentativité et de la quantité des données collectées. Rôle : Fournir au système des exemples permettant de détecter des tendances, corrélations ou anomalies. |

|---|---|

| Les algorithmes | Un algorithme est une suite d’instructions logiques qui permettent de transformer des données en résultats exploitables. Dans le cadre de l’IA, les algorithmes servent à construire des modèles capables de prédire, classifier, générer ou recommander. Certains sont basés sur des règles explicites (approche symbolique), d’autres s’appuient sur des réseaux de neurones artificiels (approche connexionniste). Ils représentent le cœur mathématique du système. Rôle : Analyser les données et établir des mécanismes de décision ou d’action automatisés. |

| L’entraînement | L’entraînement (ou apprentissage) est la phase au cours de laquelle l’IA ajuste ses paramètres internes en fonction des exemples qu’elle reçoit. C’est ici qu’interviennent les cycles d’itération, où le système améliore progressivement sa compréhension des relations entre les données d’entrée et de sortie. Par exemple, un modèle de reconnaissance d’images apprendra à identifier un chat à partir de milliers de photos, en affinant chaque fois son réseau neuronal. Rôle : Apprendre à partir d’expériences simulées et construire une logique de traitement interne efficace. |

| La validation | Une fois entraîné, un modèle doit être testé pour vérifier sa capacité à généraliser. C’est ce que permet la validation : on expose le modèle à des données nouvelles (non vues lors de l’apprentissage) pour mesurer sa précision, sa robustesse, ou encore sa tolérance aux erreurs. Cette étape est indispensable pour éviter les problèmes de surapprentissage (overfitting), où un modèle serait trop adapté à ses données d’entraînement mais inefficace en situation réelle. Rôle : Garantir la fiabilité du système dans des conditions variées et imprévues. |

| L’optimisation | L’optimisation consiste à affiner les performances du modèle, que ce soit en réduisant le temps de calcul, en améliorant la précision des résultats, ou en diminuant les biais. Cela peut passer par l’ajustement des hyperparamètres, le choix d’une architecture différente ou l’utilisation de techniques d’ensemble (comme le bagging ou le boosting). Cette phase est souvent itérative, avec l’aide d’ingénieurs spécialisés en data science ou en MLOps. Rôle : Maximiser la performance réelle et pratique du système en production. |

| L’explicabilité | De plus en plus, il est demandé que les modèles d’IA soient explicables, c’est-à-dire qu’ils puissent justifier leurs décisions. Cela est particulièrement vrai dans les domaines sensibles comme la finance, la justice ou la médecine. L’explicabilité vise à rendre transparent le fonctionnement des modèles, notamment ceux considérés comme « boîtes noires » (deep learning). Rôle : Favoriser la confiance, la responsabilité et la compréhension des systèmes intelligents. |

En plus de ces fondements, il convient d’examiner les différentes catégories d’IA existantes selon leur niveau de complexité et de capacité cognitive. On distingue principalement deux grandes catégories :

| IA faible | Également appelée IA étroite, elle est conçue pour exécuter une tâche précise et délimitée. Elle n’a ni conscience, ni sens commun, et ne peut pas s’appliquer à des situations pour lesquelles elle n’a pas été spécifiquement programmée ou entraînée. Elle représente la quasi-totalité des IA utilisées aujourd’hui dans les entreprises, les smartphones ou les applications en ligne. Exemples : Assistants vocaux (Siri, Google Assistant), moteurs de recommandation (Spotify, Amazon), outils de traduction automatique. |

|---|---|

| IA forte | L’IA forte, encore théorique, serait dotée d’une intelligence comparable à celle des humains. Elle pourrait comprendre, raisonner, avoir une conscience de soi, et interagir dans des environnements complexes sans supervision. Elle soulève des enjeux philosophiques, légaux et éthiques importants, notamment en lien avec les notions de droits, de responsabilité et de contrôle technologique. Exemples : Aucun système existant à ce jour. Concept illustré dans la fiction par des entités comme HAL 9000 (2001, l’Odyssée de l’espace), ou les androïdes de la série « Westworld ». |

À ce jour, toutes les IA en activité relèvent de l’IA faible. Mais les recherches en cours, notamment dans les laboratoires de grandes entreprises comme OpenAI, DeepMind (Google), ou Anthropic, cherchent à franchir les barrières techniques menant vers l’IA forte. Ce potentiel soulève des débats passionnés sur la sécurité, la gouvernance et l’impact à long terme de ces technologies sur la société humaine.

Les applications concrètes et les limites actuelles de l’IA

Si l’intelligence artificielle semble parfois relever du domaine de la science-fiction, elle est pourtant déjà solidement ancrée dans notre quotidien. Présente de manière souvent invisible dans les services numériques que nous utilisons chaque jour, elle alimente une grande variété de secteurs. Voici un aperçu structuré des domaines d’application concrets de l’IA et des principaux enjeux qu’elle soulève actuellement.

| Marketing et publicité | L’IA permet de personnaliser les expériences utilisateurs en temps réel : elle analyse les comportements de navigation, les préférences d’achat et les interactions passées pour proposer des publicités ou des recommandations ciblées. Les algorithmes prédictifs anticipent même les besoins des consommateurs. Exemples : Campagnes publicitaires automatisées sur Google Ads ou Facebook, recommandations de produits sur Amazon, scoring de leads dans les CRM. |

|---|---|

| Médecine et santé | En médecine, l’IA joue un rôle croissant dans le diagnostic, le suivi des patients et la recherche pharmaceutique. Elle est utilisée pour détecter des anomalies sur des images médicales, analyser des examens en grande quantité ou identifier des corrélations complexes entre symptômes et pathologies. L’IA contribue aussi à la médecine personnalisée, en croisant des données génétiques avec des traitements ciblés. Exemples : Diagnostic de cancers via l’imagerie (radiologie assistée par IA), assistants médicaux virtuels, plateformes d’analyse de données cliniques pour la recherche. |

| Finance | Dans le secteur financier, l’IA permet d’automatiser des processus complexes tout en renforçant la sécurité. Elle est utilisée pour détecter des fraudes en temps réel, établir des profils de risque, ou encore optimiser des stratégies d’investissement grâce au traitement de volumes massifs de données de marché. Elle est aussi employée dans les néobanques pour améliorer l’expérience client. Exemples : Détection d’opérations bancaires suspectes, trading algorithmique, chatbots pour les services clients bancaires, scoring de crédit automatisé. |

| Mobilité et transport | L’intelligence artificielle transforme la manière dont nous nous déplaçons. Elle est intégrée dans les systèmes d’aide à la conduite, les calculateurs d’itinéraires et la logistique urbaine. Elle joue aussi un rôle central dans le développement des véhicules autonomes, capables de percevoir leur environnement, de prendre des décisions en temps réel, et d’optimiser les trajets en fonction du trafic. Exemples : GPS intelligents, flottes logistiques optimisées, navettes autonomes, systèmes de maintenance prédictive dans les transports publics. |

| Éducation et formation | L’IA permet d’adapter les contenus pédagogiques au profil de chaque apprenant. Elle propose des parcours sur mesure, identifie les lacunes et fournit des recommandations ciblées pour améliorer la compréhension. Dans l’enseignement supérieur comme dans la formation professionnelle, elle optimise la progression de l’apprentissage tout en allégeant la charge des enseignants. Exemples : Plateformes d’e-learning adaptatives, correcteurs automatiques, chatbots pédagogiques, assistants vocaux éducatifs. |

| Justice et sécurité | Bien que plus controversée, l’utilisation de l’IA dans le domaine de la justice et de la sécurité se développe. Elle est utilisée pour analyser de grandes quantités de documents juridiques, évaluer les risques de récidive ou encore repérer des comportements suspects dans des flux vidéo. Toutefois, ces usages soulèvent des questions éthiques majeures, notamment en matière de biais et de respect des droits fondamentaux. Exemples : Prédiction de litiges, analyse de jurisprudence automatisée, systèmes de surveillance par reconnaissance faciale. |

Les limites actuelles de l’intelligence artificielle

Malgré ses performances, l’intelligence artificielle reste confrontée à plusieurs limites majeures qui en restreignent l’usage ou en complexifient le déploiement à grande échelle. Ces limites concernent autant les aspects techniques que sociaux et environnementaux.

| Dépendance aux données | Un système d’IA ne peut fonctionner que s’il est alimenté par des données pertinentes, nombreuses et diversifiées. Or, dans de nombreux cas, ces données sont biaisées, incomplètes ou mal représentatives de la réalité. Cela entraîne des erreurs de prédiction, des discriminations involontaires ou des interprétations erronées des situations. |

|---|---|

| Biais algorithmiques | Si les données d’entraînement comportent des biais sociaux, raciaux ou culturels, l’IA les reproduira ou les amplifiers. Ce phénomène, déjà documenté dans plusieurs études, remet en question la neutralité supposée des systèmes automatisés et pose des problèmes éthiques, notamment dans les domaines du recrutement, de la justice ou de l’octroi de crédit. |

| Manque de transparence | De nombreux modèles, en particulier les réseaux neuronaux profonds, sont qualifiés de « boîtes noires » : il est difficile, voire impossible, de comprendre précisément comment une décision a été prise. Cela limite la possibilité d’auditer ou de contester une décision automatisée, notamment dans les domaines réglementés. |

| Rigidité des systèmes | L’IA est encore peu adaptable hors de son contexte initial d’apprentissage. Une IA spécialisée dans la reconnaissance d’images médicales ne saura pas interpréter une scène urbaine. La généralisation des modèles à des environnements nouveaux reste l’un des grands défis du secteur. |

| Impact environnemental | L’entraînement des modèles d’IA, notamment les plus complexes (comme les grands modèles de langage ou les IA génératives), consomme d’énormes quantités d’énergie. Cela soulève des interrogations sur la soutenabilité écologique de ces technologies, à une époque où la réduction des émissions carbone est devenue une priorité mondiale. |

En résumé, l’intelligence artificielle transforme déjà profondément notre quotidien et nos secteurs d’activité, mais elle ne doit pas être perçue comme une solution universelle. Son développement s’accompagne de défis techniques, éthiques et environnementaux qui doivent être intégrés dans une stratégie responsable, multidisciplinaire et orientée vers l’intérêt général.

0 commentaires