Lorsqu’un étudiant est confronté à une question dont il ne connaît pas la réponse, il peut être tenté de deviner. Les modèles de langage fonctionnent de manière analogue : En situation d’incertitude, ils génèrent des réponses plausibles mais incorrectes, sans signaler leur ignorance. Ce phénomène, connu sous le nom d’hallucination, touche même les systèmes les plus avancés et nuit à la confiance qu’on peut leur accorder. Pourquoi ces modèles, pourtant entraînés sur des milliards de mots, continuent-ils à produire de telles erreurs ? Il ne s’agit ni d’un défaut caché de l’architecture ni d’un comportement inexplicable. D’après une étude publiée en septembre 2025* par des chercheurs d’OpenAI et de Georgia Tech, les hallucinations sont le résultat logique des choix faits lors de la conception, de l’entraînement et de l’évaluation des modèles. Cet article explore en profondeur ce phénomène, en analysant ses origines statistiques, ses liens avec la théorie de l’apprentissage, et les pistes pour développer des modèles de langage plus fiables.

Les origines statistiques des erreurs génératives des LLM

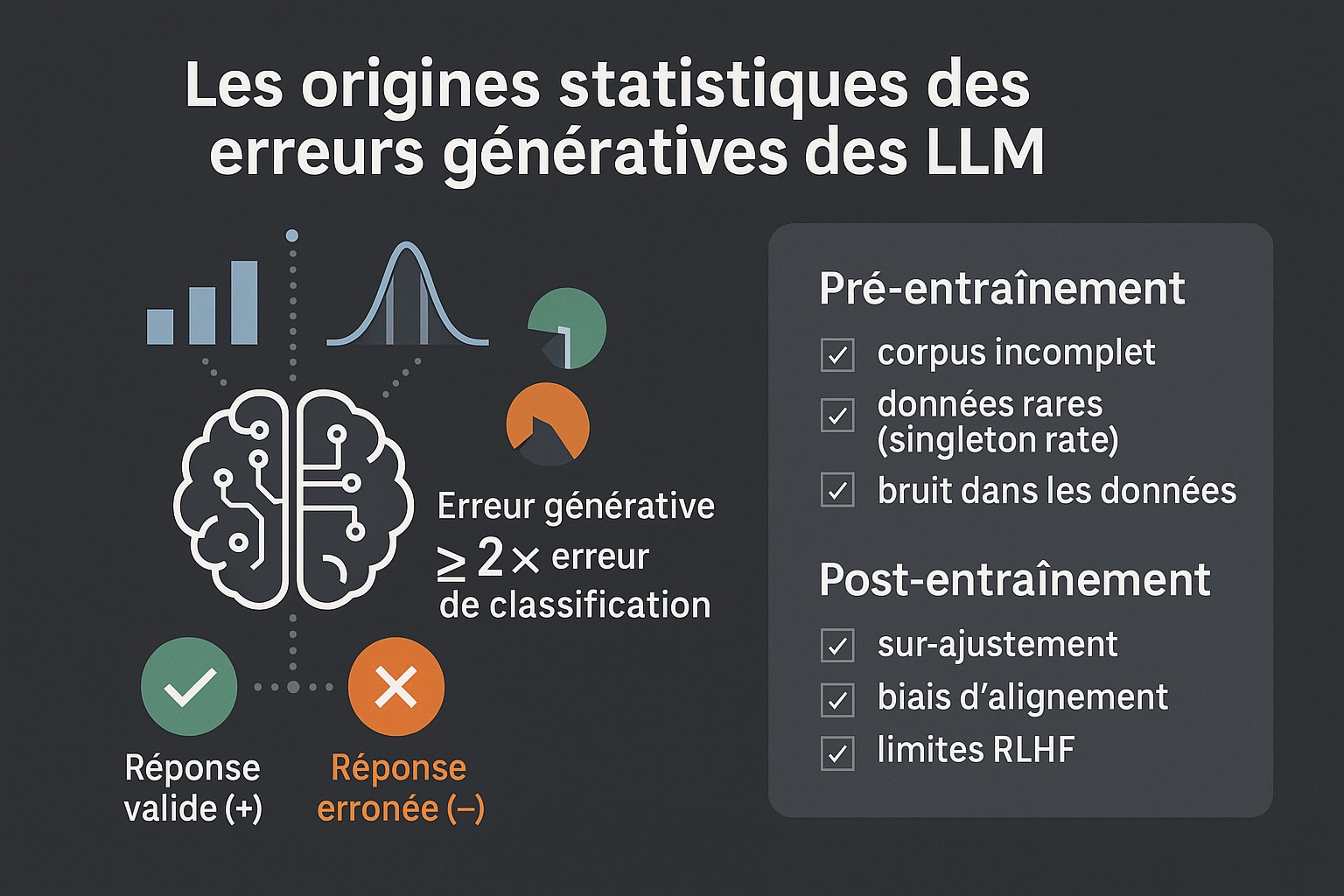

Contrairement à une idée reçue, les hallucinations ne sont pas des anomalies imprévisibles pour les LLM. Elles émergent naturellement de la manière dont les modèles de langage sont entraînés. Durant la phase de pré-entraînement, un modèle apprend à prédire la suite d’un texte à partir d’un corpus géant. Même si ce corpus était entièrement exempt d’erreurs (ce qui est rarement le cas), le processus statistique utilisé pousse le modèle à produire, tôt ou tard, des réponses incorrectes. Les chercheurs montrent que cette tendance peut être comprise à travers un problème de classification binaire : la tâche consiste à décider si une réponse générée est valide (+) ou erronée (−). On démontre alors qu’un modèle génératif qui fait des erreurs est mathématiquement équivalent à un classificateur imparfait. Plus précisément, le taux d’erreur génératif est au moins le double du taux de mauvaise classification dans ce cadre.

Une des conséquences les plus intéressantes de cette approche est la prédiction de la fréquence des hallucinations en fonction des données rares. Par exemple, si 20 % des dates d’anniversaire dans les données d’entraînement n’apparaissent qu’une seule fois, on peut s’attendre à ce qu’un modèle hallucine dans au moins 20 % des cas similaires. C’est ce que les auteurs appellent le singleton rate, un concept hérité des travaux de Turing sur la « missing mass ».

Mais ce n’est là qu’un des multiples facteurs qui contribuent aux hallucinations. Le tableau ci-dessous synthétise les principales causes, identifiées par les auteurs du rapport, en les catégorisant selon qu’elles apparaissent durant le pré-entraînement ou le post-entraînement.

Tableau récapitulatif des causes des hallucinations dans les modèles de langage

Les causes des hallucinations dans les modèles de langage peuvent être regroupées en deux grandes phases du cycle de vie des LLM : le pré-entraînement et le post-entraînement. Chaque phase introduit ses propres biais statistiques et incitations qui favorisent, d’une manière ou d’une autre, la génération de contenus erronés.

| Catégorie | Explication technique |

|---|---|

| Objectif statistique (cross-entropy) | Même avec des données sans erreur, minimiser l’entropie croisée pousse le modèle à produire des sorties incorrectes, car il tente d’approcher une distribution linguistique naturellement imparfaite. |

| Singleton rate (faits rares) | Les faits n’apparaissant qu’une fois dans les données d’entraînement sont plus susceptibles d’être halluciné car le modèle ne peut généraliser à partir d’un seul exemple. |

| Problèmes de modélisation | Des modèles limités (ex. : trigrammes) ne peuvent pas représenter correctement certains types de dépendances, ce qui conduit à des erreurs même sur des tâches simples. |

| Incertitude épistémique | Lorsque la connaissance nécessaire est absente des données, le modèle n’a aucun moyen fiable de répondre et tend à deviner une réponse plausible mais erronée. |

| GIGO (Garbage in, Garbage out) | Les erreurs présentes dans le corpus d’entraînement sont apprises et régurgitées par le modèle, perpétuant les fausses informations. |

| Décalage de distribution | Des différences entre les distributions de données d’entraînement et de test peuvent provoquer des extrapolations erronées, notamment pour des requêtes inhabituelles. |

| Limites computationnelles | Certains problèmes sont théoriquement inaccessibles à tout algorithme, y compris les LLM, comme le décryptage sans clé, ce qui entraîne des hallucinations par incapacité structurelle. |

| Évaluations binaires | Les systèmes d’évaluation qui ne reconnaissent que “vrai/faux” pénalisent les réponses prudentes et encouragent les conjectures confiantes, même incorrectes. |

| Absence de pénalités pour erreurs | Les modèles sont optimisés pour donner une réponse, même incertaine, car les erreurs ne sont pas explicitement sanctionnées dans les benchmarks courants. |

| Rétroaction inappropriée | Les techniques post-entraînement comme RLHF peuvent renforcer des comportements hallucinatoires si elles se basent sur des évaluations biaisées. |

Ce tableau met en lumière la complexité des mécanismes sous-jacents aux hallucinations, et montre qu’il n’existe pas de cause unique. Leur présence est le résultat d’une interaction entre des objectifs statistiques, des limitations de données, des architectures imparfaites et, surtout, des méthodes d’évaluation qui encouragent la prise de risques au lieu de la prudence. Pour construire des modèles plus fiables, il est donc indispensable d’agir sur l’ensemble de cette chaîne.

Pourquoi les hallucinations persistent après l’entraînement

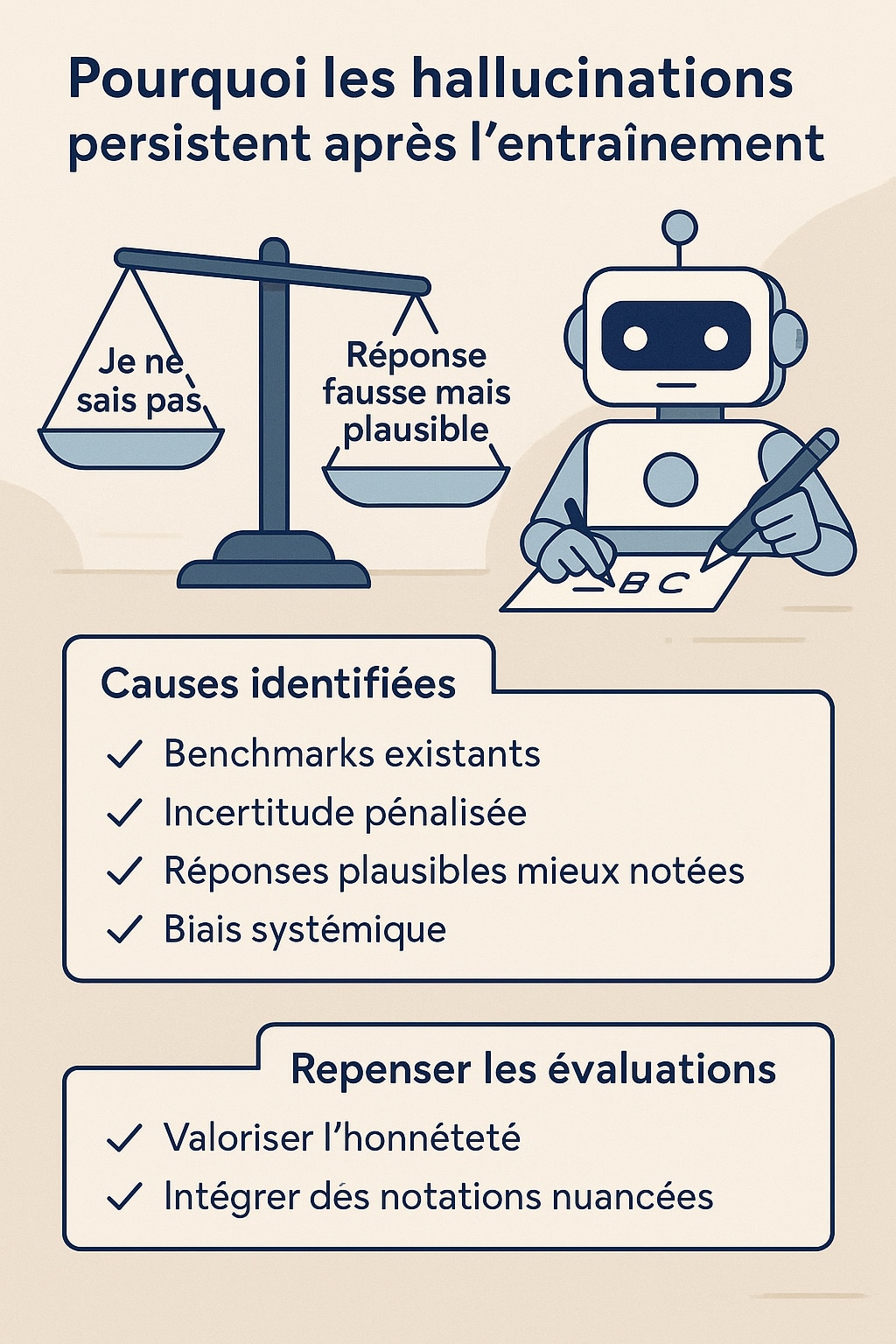

Si le pré-entraînement introduit des erreurs statistiques et structurelles dans les modèles, la phase de post-entraînement (souvent réalisée via des techniques comme le RLHF (reinforcement learning from human feedback) ou le DPO (direct preference optimization)) a pour objectif de corriger ces biais et d’améliorer la fiabilité des réponses. Pourtant, les hallucinations subsistent, parfois même renforcées. La raison ? Elle réside dans la manière dont nous évaluons les modèles. La majorité des benchmarks utilisés dans l’industrie reposent sur des métriques binaires : Une réponse est jugée comme correcte ou incorrecte, sans tenir compte du degré d’incertitude exprimé par le modèle. Dans ce système, une réponse incorrecte mais confiante est mieux notée qu’une réponse honnête du type « je ne sais pas ». Cette approche, bien que pratique pour classer les modèles sur des tableaux de performance, crée un environnement d’entraînement qui récompense la prise de risque et punit la prudence.

Le parallèle avec les étudiants est révélateur puisque lors d’un examen à choix multiples, un élève peut obtenir des points en devinant, même s’il n’a aucune idée de la bonne réponse. Il maximise ainsi son score attendu, même si sa réponse est purement spéculative. Les modèles de langage suivent cette logique : lorsqu’ils sont confrontés à une question incertaine, ils préfèrent produire une réponse confiante (et potentiellement erronée) plutôt que de s’abstenir, car c’est ainsi qu’ils obtiennent de meilleurs résultats sur les benchmarks. Ce phénomène est aggravé par le fait que les modèles n’ont généralement pas conscience des conséquences réelles de leurs erreurs. Une hallucination dans une réponse médicale ou juridique peut être lourde de conséquences, mais aucun système d’évaluation dominant n’intègre de pondération basée sur le risque ou la gravité de l’erreur. En l’absence d’une telle granularité, la stratégie optimale pour un modèle reste de toujours répondre, même quand il devrait se taire.

Les auteurs du rapport proposent donc une réorientation méthodologique : Plutôt que de créer des benchmarks spécifiques pour détecter les hallucinations (qui restent minoritaires dans l’écosystème d’évaluation), il faudrait corriger les benchmarks existants. Cela passe notamment par l’introduction de pénalités pour les erreurs confiantes, la valorisation des réponses exprimant une incertitude légitime, ou encore l’intégration de seuils de confiance explicites dans les consignes des tâches à résoudre.

Ce changement aurait deux effets bénéfiques : D’une part, il inciterait les modèles à calibrer plus finement leur niveau de confiance, et d’autre part, il favoriserait une IA plus transparente et responsable. Plutôt qu’un système qui « sait tout sur tout », nous pourrions alors nous rapprocher de modèles qui savent aussi reconnaître les limites de leur propre connaissance, une compétence précieuse, dans la réalité comme en intelligence artificielle.

Des pistes pour atténuer les hallucinations de ChatGPT et autres LLM

Heureusement, plusieurs solutions sont envisageables pour réduire la fréquence des hallucinations produites par les modèles de langage. Ces solutions ne consistent pas uniquement à renforcer les filtres ou à améliorer la qualité des données : elles impliquent surtout une refonte des mécanismes d’évaluation et d’interaction avec les modèles. Une des approches les plus prometteuses consiste à introduire des cibles explicites de confiance dans les instructions données au modèle. Par exemple, une consigne pourrait stipuler : « Ne répondez que si vous êtes sûr à plus de 75 %, sinon dites ‘je ne sais pas’. » Cette instruction transforme la tâche : le modèle ne doit plus simplement produire une réponse, mais aussi juger s’il est suffisamment confiant pour la proposer. En introduisant ainsi un seuil de confiance dans l’évaluation, on passe d’un système binaire à un système comportementalement calibré.

Cette stratégie permet de favoriser des comportements plus réalistes et responsables. Elle ouvre la voie à une nouvelle forme d’évaluation : l’évaluation comportementale, qui ne mesure pas seulement l’exactitude de la réponse, mais aussi l’adéquation du comportement du modèle face à l’incertitude. C’est ce que les chercheurs appellent la behavioral calibration : l’art d’inciter le modèle à ne répondre que lorsqu’il estime avoir une probabilité suffisante d’avoir raison. Un tel mécanisme a deux avantages clés. D’une part, il permet de limiter la génération de fausses informations dans les cas où le modèle est peu certain. D’autre part, il améliore la confiance utilisateur : un agent conversationnel qui sait reconnaître ce qu’il ne sait pas paraît immédiatement plus fiable qu’un modèle qui donne toujours une réponse, même fausse.

Pour renforcer cette approche, il est également possible d’intégrer des pénalités explicites pour les réponses erronées dans les benchmarks, à l’instar de certains examens humains (SAT, JEE, AMC, etc.), qui punissent les mauvaises réponses plus sévèrement que les non-réponses. En adaptant ce principe aux évaluations de LLM, on encouragerait des modèles plus prudents et moins enclins à “bluffer”.

En parallèle, les auteurs identifient plusieurs leviers statistiques supplémentaires qui permettent de mieux comprendre (et potentiellement de réduire) les hallucinations :

- Incertitude épistémique : Lorsqu’un fait est totalement absent du corpus d’entraînement, aucun modèle, même très avancé, ne peut le deviner correctement. Les hallucinations apparaissent alors comme des conjectures sur des données non apprises ;

- Pauvreté des modèles : Certains modèles, du fait de leur architecture ou de leur capacité limitée, échouent à modéliser des tâches apparemment simples. Par exemple, des modèles tokenisés peuvent mal interpréter les mots à cause d’une segmentation sous-optimale (ex. : compter les « D » dans « DEEPSEEK ») ;

- Garbage In, Garbage Out (GIGO) : Si les données d’entraînement contiennent des erreurs, des approximations ou des biais, les modèles les reproduiront avec assurance. Cela concerne aussi bien les erreurs humaines que les désinformations présentes sur le web ;

- Décalage de distribution : Des questions trop éloignées du domaine couvert par les données d’entraînement (out-of-distribution prompts) peuvent induire des réponses incorrectes. Le modèle extrapole à partir de ce qu’il connaît, avec des résultats parfois incohérents.

Enfin, il est important de souligner qu’aucune architecture, aussi sophistiquée soit-elle, ne peut garantir l’absence totale d’hallucinations. Même les systèmes de type RAG (retrieval-augmented generation), qui intègrent un module de recherche externe, peuvent échouer si la recherche ne retourne pas d’informations pertinentes ou si la synthèse générée interprète mal les sources. Par ailleurs, l’intégration de la recherche dans le pipeline ne résout pas les biais d’incitation présents dans l’évaluation elle-même.

Document source : Openai.com

0 commentaires