Qu’il s’agisse de regarder une vidéo en streaming, de stocker des fichiers dans le cloud ou de gérer des transactions bancaires en ligne, tout passe par une infrastructure physique bien réelle : Le data center. Souvent invisible pour les utilisateurs, ce centre névralgique du web mondial héberge, sécurise et traite d’immenses volumes de données 24 heures sur 24, le big data. Mais que cache réellement ce terme ? Comment fonctionne un data center ? Et pourquoi joue-t-il un rôle stratégique dans la transformation numérique des entreprises et des États ? Cet article vous guide dans les coulisses d’une technologie essentielle à notre quotidien connecté.

- La définition d’un data center : Le cœur physique du numérique mondial

- Comment fonctionne un data center ? Architecture, composants et logistique

- Les types de data centers et les évolutions technologiques

- Enjeux environnementaux, sécurité et souveraineté numérique avec les centres de données

- Vers le data center du futur : Modularité, sobriété et intelligence distribuée

La définition d’un data center : Le cœur physique du numérique mondial

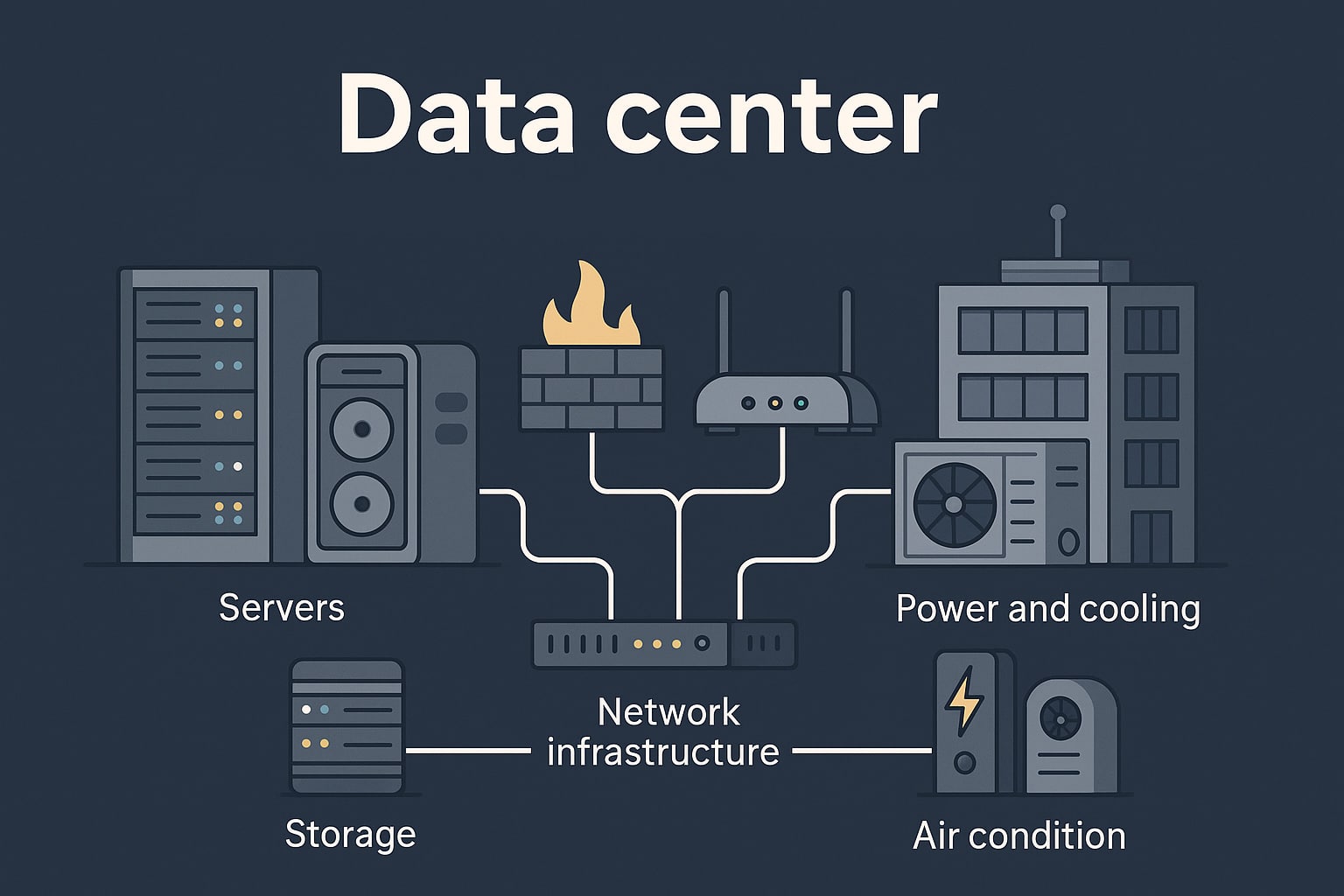

Un data center, ou centre de données en français, est une infrastructure physique destinée à héberger des équipements informatiques tels que des serveurs, des baies de stockage, des routeurs, des switchs et des dispositifs de sécurité. Son rôle fondamental est d’assurer la stockage, le traitement et la distribution d’informations numériques à grande échelle. Derrière chaque clic sur un site web, chaque visionnage de vidéo, chaque requête vocale ou transaction bancaire, un data center agit en coulisses pour permettre le fonctionnement fluide et continu des services numériques modernes.

Historiquement, l’idée de regrouper les équipements informatiques dans un espace dédié remonte aux années 1960, avec l’essor des mainframes (ordinateurs centraux) dans les grandes entreprises et les institutions gouvernementales. À cette époque, les centres de calcul de l’IBM 7090 ou du CDC 6600 étaient situés dans des pièces climatisées spécialement aménagées dans des laboratoires, des banques ou des universités comme le MIT ou l’Université Stanford. Ces précurseurs n’étaient pas encore appelés « data centers », mais ils en posaient les bases techniques et logistiques. Le terme lui-même a pris son essor dans les années 1990 avec la démocratisation d’Internet. À cette période, les entreprises commencent à héberger leurs propres serveurs web, messageries électroniques et bases de données dans des espaces techniques baptisés « salles serveurs ». Mais avec la montée en puissance du commerce en ligne, de la virtualisation et de la délocalisation informatique, la demande croît rapidement. Dans les années 2000, l’émergence du cloud computing (incarné par des acteurs comme Amazon Web Services (2006), Microsoft Azure (2010) ou Google Cloud) transforme le data center en une infrastructure industrielle mondiale.

Les plus grandes entreprises du numérique ont investi massivement dans des sites géants répartis stratégiquement dans le monde. En Virginie, le comté de Loudoun est surnommé « Data Center Alley » : plus de 70 % du trafic Internet mondial y transite à un moment donné. À Hamina, en Finlande, Google a transformé une ancienne usine de papier en centre de données écologique, refroidi par l’eau de la mer Baltique. À Marseille, des câbles sous-marins relient des centres de données européens aux réseaux africains et asiatiques, faisant du port français un hub numérique international. Aujourd’hui, un data center peut occuper des dizaines de milliers de mètres carrés, abriter des centaines de milliers de serveurs, consommer l’équivalent énergétique d’une ville moyenne, et fonctionner avec des exigences extrêmes de redondance, de disponibilité et de sécurité. Ces centres sont devenus des points vitaux pour l’économie mondiale, pour les gouvernements (notamment en matière de souveraineté numérique), mais aussi pour les usagers du quotidien qui, souvent sans le savoir, dépendent totalement de leur bon fonctionnement.

Comment fonctionne un data center ? Architecture, composants et logistique

Le fonctionnement d’un data center repose sur une architecture technique rigoureusement conçue pour garantir une disponibilité permanente des services, une résilience maximale face aux incidents (pannes, incendies, attaques), et une sécurité physique et logique infaillible. Il s’agit d’environnements hautement spécialisés, où chaque composant est redondé, monitoré, sécurisé et optimisé. Le moindre arrêt de service peut avoir des conséquences économiques, sociales ou politiques majeures, notamment pour les opérateurs télécoms, les plateformes de streaming, les services bancaires ou les applications critiques d’e-gouvernement. Un data center se structure autour de trois grands pôles techniques : La capacité de calcul (les serveurs), l’infrastructure réseau (connexion interne et Internet), et l’énergie & environnement (alimentation, refroidissement, surveillance). À cela s’ajoutent des couches logicielles (virtualisation, orchestration, stockage distribué, hyperviseurs) qui pilotent l’activité de l’ensemble. Le tout est intégré dans un écosystème logistique maîtrisé : Supervision 24/7, maintenance préventive, gestion des pièces détachées, protocoles de sécurité, plans de secours et audits réguliers.

| Composant du data center | Rôle et description |

|---|---|

| Serveurs | Machines physiques hébergeant des systèmes d’exploitation, des logiciels métiers, des services cloud ou des machines virtuelles. Leur densité est gérée pour optimiser l’espace et les performances. |

| Systèmes de stockage | Disques durs ou SSD regroupés en NAS ou SAN pour stocker les données, avec des niveaux de redondance (RAID, replication) assurant leur pérennité et rapidité d’accès. |

| Équipements réseau | Commutateurs (switches), routeurs, pare-feu, liens fibre optique à haute capacité (10G/100G). Ces éléments assurent la circulation fluide des données vers les utilisateurs ou autres data centers (réseaux WAN). |

| Alimentation électrique redondée | Alimentation électrique double (A et B), onduleurs (UPS), batteries, générateurs diesel de secours, gestion intelligente des pics de consommation pour garantir un fonctionnement ininterrompu. |

| Refroidissement | Systèmes HVAC (chauffage, ventilation, climatisation), circulation de l’air par couloirs chauds/froids, refroidissement liquide, échangeurs thermiques. Le contrôle thermique est essentiel pour éviter la surchauffe des racks. |

| Sécurité physique | Barrières d’accès, badges biométriques, caméras, rondes humaines, salles blanches. Les zones sensibles sont cloisonnées, et l’accès est soumis à une double ou triple authentification. |

| Surveillance & monitoring | Systèmes de télémétrie, SCADA, logiciels de supervision (Nagios, Zabbix, Prometheus) pour surveiller tous les paramètres physiques et logiciels en temps réel. |

Pour mesurer le niveau de qualité d’un data center, on utilise souvent la norme Tier définie par l’Uptime Institute. Il existe quatre niveaux :

- Tier I : infrastructure basique, sans redondance (disponibilité : 99,671 %, soit ~29h/an d’interruption possible) ;

- Tier II : composants redondés partiellement (99,741 % – ~22h/an) ;

- Tier III : maintenance possible sans interruption (N+1), avec tolérance aux pannes (99,982 % – ~1,6h/an) ;

- Tier IV : infrastructure totalement redondée (2N), tolérante aux pannes multiples, disponibilité de 99,995 % (soit environ 26 minutes d’indisponibilité par an).

La conception d’un data center est donc un compromis complexe entre puissance informatique, efficacité énergétique, résilience et coûts d’exploitation. Des innovations émergent pour en améliorer l’impact environnemental : refroidissement passif, immersion des serveurs dans des liquides diélectriques, exploitation de la chaleur pour le chauffage urbain, ou implantation dans des zones naturellement froides (Suède, Norvège, Islande).

Les types de data centers et les évolutions technologiques

Les data centers ne sont pas tous construits selon le même modèle. Leur conception et leur rôle dépendent à la fois de leur fonction, de leur dimensionnement, de leur localisation et de leur modèle économique. De la salle informatique traditionnelle au campus ultra-moderne à échelle industrielle, chaque type répond à des enjeux spécifiques d’usage, de performance, de sécurité et de proximité.

| Type de data center | Description |

|---|---|

| Data center d’entreprise | Installé au sein même d’une organisation (ex : banques, compagnies aériennes, hôpitaux, groupes industriels), ce type de centre est entièrement géré par l’entreprise qui l’exploite pour ses applications critiques et sa souveraineté des données. |

| Data center mutualisé (colocation) | Géré par un opérateur tiers (comme Equinix, Digital Realty ou Interxion), il permet à plusieurs clients de louer des espaces dans une infrastructure partagée, avec des services managés et des économies d’échelle importantes. |

| Data center cloud | Infrastructure exploitée par un fournisseur cloud public (AWS de Amazon, Microsoft Azure, Google Cloud Platform, Oracle Cloud, etc.), où les clients accèdent à la puissance de calcul ou de stockage à distance, en mode IaaS, PaaS ou SaaS. |

| Edge data center | Installé à la périphérie du réseau, au plus proche de l’utilisateur final (smart cities, objets connectés, véhicules autonomes), il réduit la latence en traitant localement les données générées par les terminaux connectés. |

| Hyperscale data center | Ces centres massifs hébergent des centaines de milliers de serveurs et sont déployés par les géants du numérique (Meta, Amazon, Google, Microsoft). Ils traitent des volumes de données colossaux, souvent à l’échelle planétaire. |

Le paysage des data centers évolue rapidement sous l’effet de plusieurs facteurs :

- Automatisation et IA : Pilotage intelligent de la consommation électrique, de la répartition des charges ou du refroidissement via des algorithmes prédictifs ;

- Refroidissement innovant : Immersion des serveurs dans des fluides non conducteurs, utilisation de l’air extérieur, refroidissement par eau glacée ou géothermie ;

- Serveurs modulaires : Adoption de formats conteneurisés ou préfabriqués, faciles à déployer et déplacer, adaptés à la croissance rapide de certaines régions ou à des contextes militaires/industriels ;

- Sobriété énergétique : Intégration d’énergies renouvelables (solaire, éolien, hydraulique), récupération de chaleur pour le chauffage urbain ou les serres agricoles ;

- Expérimentation sous-marine : Microsoft a testé des centres de données immergés au large des côtes écossaises avec Project Natick, visant à optimiser le refroidissement naturel et à rapprocher les données des zones urbaines côtières.

Ces innovations traduisent une tendance de fond : face à la multiplication des usages numériques (IA, streaming, big data, IoT), les data centers doivent devenir plus agiles, décentralisés, écologiques et intelligents. Le défi est immense : concilier performance informatique et soutenabilité environnementale.

Enjeux environnementaux, sécurité et souveraineté numérique avec les centres de données

À mesure que notre monde devient de plus en plus numérique, les data centers occupent une place stratégique dans les équilibres économiques, écologiques et géopolitiques. Ces infrastructures, bien qu’essentielles, posent une série de défis majeurs à l’échelle mondiale. Derrière chaque clic, vidéo ou transaction, se cache une demande en énergie, en sécurité et en transparence juridique qui ne cesse de croître.

| Enjeu | Description |

|---|---|

| Consommation énergétique | Un centre de données de taille moyenne peut consommer plusieurs mégawatts en continu. À l’échelle mondiale, les data centers représentent environ 1 à 2 % de la consommation électrique totale, un chiffre en augmentation constante. Des efforts importants sont engagés pour limiter leur empreinte carbone, en particulier en Europe du Nord (Norvège, Suède, Islande) où l’électricité est souvent d’origine renouvelable. |

| Refroidissement durable | Les systèmes de refroidissement traditionnels sont énergivores. De nouvelles approches se développent : free cooling (utilisation de l’air extérieur), immersion des serveurs, refroidissement liquide, ou encore récupération de chaleur pour alimenter les réseaux de chauffage urbain. |

| Sécurité informatique | Les data centers sont des cibles hautement sensibles pour les hackers, groupes criminels ou acteurs étatiques. Ils sont protégés par des architectures redondées, des pare-feux avancés, du chiffrement de bout en bout, une segmentation réseau stricte, et des protocoles de reprise après sinistre (PRA). |

| Souveraineté numérique | La question de la localisation des données est cruciale. De nombreuses entreprises et administrations souhaitent que leurs données restent sur leur territoire ou dans une juridiction respectueuse de leur législation. C’est ce qui alimente des projets comme GAIA-X, initiative européenne lancée en 2019 pour favoriser un écosystème cloud souverain, transparent et interopérable. |

| Respect du RGPD | Depuis 2018, le Règlement Général sur la Protection des Données impose que les données personnelles des citoyens européens soient stockées, traitées et protégées selon des normes strictes. Les opérateurs de data centers doivent donc assurer une conformité totale, incluant la traçabilité des accès, le chiffrement et la réversibilité des données hébergées. |

Le data center moderne ne peut plus être simplement vu comme une usine à serveurs. Il est au croisement de multiples dynamiques : Écologique, réglementaire, stratégique et technologique. Les politiques publiques, les fournisseurs de cloud, les grands groupes industriels comme les petites entreprises sont aujourd’hui tous concernés par la gestion responsable des ressources numériques.

Vers le data center du futur : Modularité, sobriété et intelligence distribuée

Face à la croissance exponentielle des usages numériques, les data centers doivent s’adapter pour répondre à des besoins toujours plus complexes. Le paradigme évolue désormais vers une infrastructure modulaire, décentralisée et pilotée par l’intelligence artificielle. On parle de data center 4.0, capable d’auto-ajustements énergétiques, d’automaintenance via capteurs intelligents, et de redéploiement agile selon les pics de demande (ex. : lors d’événements mondiaux, de crises sanitaires ou de pics e-commerce). Les initiatives d’hyper-convergence et d’orchestration logicielle permettent déjà à certaines entreprises de gérer plusieurs sites comme une seule entité logique. À terme, les data centers seront de plus en plus interconnectés et distribués, intégrés aux infrastructures des villes intelligentes et aux réseaux d’énergie décentralisée. L’enjeu est double : garantir la performance numérique globale tout en réduisant l’empreinte environnementale. Ce tournant impose une collaboration étroite entre ingénieurs informatiques, architectes réseau, urbanistes, écologues et décideurs publics pour bâtir un modèle durable du traitement massif de l’information.

Des architectures modulaires : Vers une flexibilité de déploiement totale

Les nouveaux data centers sont conçus pour être modulaires et évolutifs. Cela signifie qu’ils peuvent être construits sous forme de modules préfabriqués, souvent transportables dans des containers (data centers conteneurisés) et déployés très rapidement sur site. Cette approche répond au besoin de déploiement agile, particulièrement utile dans les zones en développement, les contextes militaires, ou les environnements industriels en mutation constante. La modularité permet aussi d’adapter la capacité d’un data center à la demande en temps réel, sans immobiliser de ressources énergétiques ou techniques inutiles. En ajoutant ou retirant des unités de calcul ou de stockage, les opérateurs réduisent leur coût d’exploitation et leur empreinte carbone. Cette logique dite scalable est aujourd’hui portée par des technologies comme Kubernetes (orchestration de conteneurs), OpenStack ou les microservices en cloud natif.

Une sobriété numérique comme impératif d’ingénierie

La sobriété énergétique n’est plus un vœu pieux, mais une nécessité technique. Le Power Usage Effectiveness (PUE), indicateur de rendement énergétique des data centers, tend vers 1,1 dans les meilleures installations (contre une moyenne mondiale encore autour de 1,57). Pour y parvenir, les centres de données du futur misent sur des technologies passives (free cooling, ventilation naturelle, récupération thermique), des processeurs basse consommation (ARM, RISC-V), et une logique de répartition de charge intelligente. De plus, la sobriété passe aussi par une gestion algorithmique de la demande. L’intelligence artificielle peut prédire les pics de charge, déplacer des workloads (tâches informatiques) vers des régions moins sollicitées, ou alimentées par une énergie plus verte. Le refroidissement à l’eau, les circuits de chaleur urbaine, ou encore le pilotage dynamique des flux réseau sont autant d’optimisations déjà en phase de déploiement dans les centres les plus avancés.

Intelligence distribuée : IA, edge computing et autonomie décisionnelle

Le data center de demain ne sera plus forcément un lieu unique. Grâce à l’essor du edge computing, les traitements sont de plus en plus répartis au plus près des terminaux : antennes 5G, hubs industriels, stations météorologiques, véhicules connectés… Cela permet de réduire drastiquement la latence, d’économiser de la bande passante et de renforcer la résilience globale du réseau. En parallèle, les algorithmes d’intelligence artificielle prennent une place centrale dans la gestion quotidienne des centres de données : analyse prédictive des pannes, gestion thermique, réallocation dynamique des ressources, détection d’anomalies, optimisation de l’empreinte carbone… Ces IA peuvent fonctionner en autonomie partielle ou complète sur des périodes données, selon des règles métiers préprogrammées, libérant ainsi les équipes humaines pour des tâches à plus forte valeur ajoutée.

Le rôle des standards ouverts et de l’interopérabilité

La montée en puissance de cette nouvelle génération de data centers s’accompagne d’un besoin accru de standards ouverts. Le projet Open Compute Project (OCP), lancé en 2011 par Facebook, vise à créer des architectures matérielles ouvertes, plus économes et compatibles entre elles. Des formats comme le Open19 ou le DCIM standardisé facilitent la supervision, la maintenance à distance et l’intégration multi-fournisseurs. Cette interopérabilité est également cruciale dans les environnements hybrides, où cohabitent clouds publics, clouds privés et infrastructures locales. Des solutions comme Kubernetes, Terraform ou Prometheus sont désormais des briques techniques incontournables dans l’automatisation et l’orchestration de ces environnements complexes. C’est ce tissu logiciel qui permettra aux data centers du futur d’être non seulement plus efficaces, mais aussi plus interopérables, évolutifs et souverains.

0 commentaires