Dans le monde du webmarketing et de l’optimisation web, prendre des décisions au « feeling » n’est plus une option. Pour maximiser l’efficacité d’une page, d’une campagne ou d’un parcours utilisateur, il est essentiel de tester, comparer et mesurer. C’est exactement ce que permet l’A/B testing : une méthode rigoureuse et accessible pour évaluer objectivement ce qui fonctionne le mieux auprès des utilisateurs. Que vous soyez responsable e-commerce, designer UX, traffic manager ou chef de produit, l’A/B testing vous aide à faire des choix basés sur des données, et non sur des intuitions. Dans cet article, nous allons définir clairement ce qu’est l’A/B testing, comprendre comment il fonctionne, découvrir des exemples concrets d’application, et voir pourquoi il est devenu un outil central dans toute stratégie d’optimisation de conversion.

Pour commencer : une définition claire de l’A/B testing

L’A/B testing, aussi appelé split testing, est une méthode d’expérimentation issue de la statistique appliquée au marketing digital. Elle consiste à comparer deux versions d’un même élément (page web, bouton, objet d’e-mail, visuel, formulaire, etc.) dans des conditions contrôlées, afin d’évaluer laquelle des deux versions produit les meilleurs résultats selon un indicateur de performance (KPI) précis : Taux de clic, taux de conversion, chiffre d’affaires, engagement, ou temps passé sur une page. Historiquement, cette approche trouve ses racines dans les expérimentations en agriculture et en médecine du début du XXe siècle, mais c’est dans les années 1990 qu’elle commence à s’imposer dans le monde du digital, sous l’impulsion de géants comme Google, Amazon ou encore Microsoft. En 2000, Google commence à tester différentes nuances de bleu pour ses liens publicitaires, une démarche qui aurait rapporté plus de 200 millions de dollars supplémentaires selon Marissa Mayer, ancienne vice-présidente de Google.

La démocratisation de l’A/B testing s’accélère dans les années 2010, grâce à l’arrivée d’outils comme Optimizely (fondé en 2010 par Dan Siroker, un ancien analyste de la campagne Obama 2008), VWO, AB Tasty ou encore Google Optimize. Ces plateformes ont rendu les tests accessibles sans compétence technique avancée, permettant à n’importe quelle entreprise (PME ou grand compte) de prendre des décisions basées sur les données, et non sur des intuitions ou des opinions. Le principe est simple : un même trafic utilisateur est divisé aléatoirement en deux groupes. Le premier voit la version A, dite « contrôle » (celle en place), tandis que le second voit la version B, modifiée sur un seul élément stratégique. Une fois le test lancé, il s’agit d’analyser les résultats sur la base d’indicateurs statistiques fiables, afin de déterminer si la version B génère une amélioration significative.

| Nom complet | A/B testing (ou split testing) |

| Objectif | Identifier la version la plus performante d’un élément en testant une seule variable à la fois |

| Principe | Diviser un échantillon d’utilisateurs aléatoirement entre deux versions (A et B) et analyser les performances comparées |

| Indicateurs suivis | Taux de clic, taux de conversion, durée de session, revenus générés, etc. |

| Utilisateurs ciblés | Visiteurs d’un site, destinataires d’un e-mail, utilisateurs d’une application |

À travers l’A/B testing, une entreprise adopte une démarche d’amélioration continue, fondée sur l’expérimentation et la validation scientifique. Il ne s’agit plus d’imaginer ce qui fonctionne, mais de prouver par les chiffres quelle version d’un contenu ou d’une interface est la plus efficace. À l’heure de l’expérience utilisateur ultra-personnalisée, cette méthode s’impose comme un outil stratégique incontournable dans les domaines du UX design, du e-commerce, du CRM et du marketing automation.

Comment fonctionne concrètement un test A/B ?

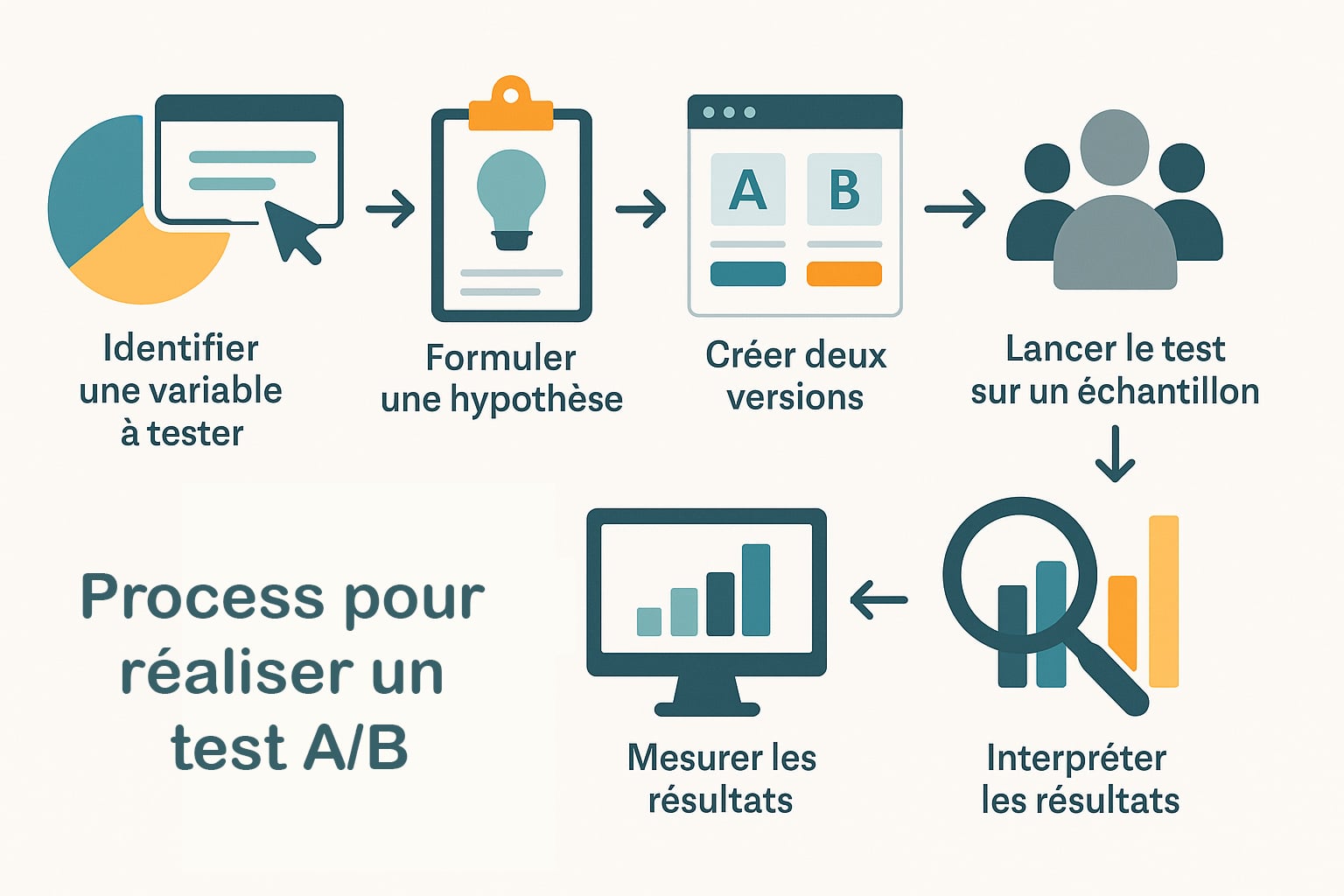

Le test A/B est une expérimentation contrôlée, structurée autour de la méthode scientifique. Son objectif est de déterminer, par l’observation rigoureuse, si une modification précise dans une interface ou un contenu génère une amélioration mesurable. Ce type de test, popularisé par les ingénieurs de la Silicon Valley dans les années 2000, repose sur les travaux en statistiques appliquées développés dès les années 1920 par Ronald A. Fisher, un pionnier de l’expérimentation moderne. Aujourd’hui, cette méthode est au cœur de l’optimisation des taux de conversion (CRO) dans les environnements web et logiciels. Qu’il s’agisse de tester la couleur d’un bouton sur Amazon, la disposition d’un formulaire sur Airbnb ou l’objet d’un e-mail marketing envoyé par Netflix, le processus suit généralement les étapes suivantes :

| 1. Identifier une variable à tester | Choisir un élément clé de la conversion : appel à l’action (CTA), visuel, titre, texte d’accroche, prix, etc. Le test A/B ne doit comparer qu’un seul changement à la fois pour en isoler l’impact. |

| 2. Formuler une hypothèse | Exemple : « Si le bouton d’achat devient rouge au lieu de bleu, alors le taux de clic augmentera de 10 %. » Cette hypothèse guide la conception du test. |

| 3. Créer deux versions | La version A correspond au design ou contenu existant (groupe témoin), tandis que la version B intègre le changement à tester (groupe de traitement). |

| 4. Lancer le test sur un échantillon | Les utilisateurs sont répartis aléatoirement entre les deux versions. Cette répartition peut être de 50/50, ou pondérée selon le niveau de risque ou les contraintes techniques. |

| 5. Mesurer les résultats | Les indicateurs clés (KPI) doivent être définis avant le lancement : clics, conversions, revenus, engagement, taux de rebond… |

| 6. Interpréter les résultats | Un test est jugé concluant si la version B obtient de meilleurs résultats avec une signification statistique suffisante (souvent p < 0,05). |

La signification statistique permet d’éviter de tirer des conclusions hâtives sur des fluctuations qui pourraient être dues au hasard. Pour cela, les plateformes modernes de testing intègrent des algorithmes de calcul automatique de validité, souvent basés sur des tests de Student ou des modèles bayésiens. Aujourd’hui, des solutions comme Optimizely (utilisée dès 2008 pour les campagnes d’Obama), AB Tasty (créée en France en 2009), VWO, Unbounce, ou encore Firebase A/B Testing (remplaçant Google Optimize depuis 2023) permettent de réaliser des expérimentations même sans connaissance technique approfondie. Ces outils permettent :

- De définir précisément les objectifs de test (KPI)

- De segmenter l’audience selon des critères comportementaux ou démographiques

- De suivre les performances en temps réel

- De garantir une répartition aléatoire équitable entre les versions

- De générer des rapports de performance avec des interprétations claires

Dans un environnement digital dominé par la performance et la personnalisation, comprendre et maîtriser le fonctionnement d’un test A/B est un atout stratégique. C’est une manière fiable de valider chaque changement avant de le généraliser, tout en s’appuyant sur les comportements réels des utilisateurs.

Des exemples concrets d’a/b testing dans le web marketing

L’A/B testing s’applique à presque tous les aspects de l’expérience utilisateur sur le web. De la page d’accueil à la campagne d’e-mailing, en passant par l’ergonomie d’une application mobile, les équipes marketing s’en servent pour améliorer les performances à chaque étape du parcours client. Voici quelques cas typiques qui illustrent l’usage stratégique de cette méthode :

| Cas d’usage | Variable testée |

| Page d’accueil e-commerce | Image principale (ex. : photo d’un homme vs d’une femme), texte du slogan, mise en avant des catégories ou produits phares |

| Landing page (page d’atterrissage) | Titre principal, longueur du formulaire, couleur ou texte du bouton d’action (ex. : « Obtenir une démo » vs « Commencer maintenant ») |

| Email marketing | Objet de l’e-mail, prénom personnalisé dans le message, heure et jour d’envoi, design visuel (photo réaliste vs illustration) |

| Fiche produit | Ordre des informations (avis en haut ou en bas), format des témoignages clients (texte seul vs note étoilée + commentaire), intégration d’une vidéo produit |

| Application mobile | Design de l’icône dans l’App Store, écran de démarrage, présence ou non d’un message de bienvenue personnalisé |

Un exemple célèbre est celui d’Amazon, dont la culture du test est poussée à l’extrême. L’entreprise met en place des centaines de tests A/B en continu : placement du bouton « Ajouter au panier », variations typographiques, titres des produits, structure de la fiche ou encore formulation des prix. Une variation positive de seulement 0,5 % sur le taux de conversion peut représenter des millions de dollars de chiffre d’affaires supplémentaire à l’échelle d’un géant comme Amazon.

D’autres entreprises emblématiques comme Airbnb, Netflix ou Booking.com ont intégré l’A/B testing comme partie intégrante de leur processus de développement. Booking, par exemple, a longtemps mené plus de 1 000 tests A/B simultanés sur différentes versions de ses pages. L’objectif ? Optimiser non seulement la conversion, mais aussi la confiance de l’utilisateur, sa rétention, et sa satisfaction globale.

Grâce à ces expérimentations systématiques, les entreprises peuvent transformer des hypothèses marketing en preuves concrètes, en se basant sur le comportement réel des utilisateurs, et non sur des intuitions ou des préférences internes. L’A/B testing devient ainsi un levier incontournable d’optimisation continue, dans une logique de data-driven marketing.

Pour aller plus loin : limites, dérives et bonnes pratiques de l’a/b testing

Si l’A/B testing est un outil puissant pour optimiser l’efficacité de vos actions digitales, il n’est pas exempt de limites ni de risques lorsqu’il est mal utilisé. Trop souvent, certaines entreprises tombent dans des travers méthodologiques ou adoptent des logiques de test déconnectées de la stratégie globale. Comprendre ce qu’un test peut réellement prouver, et comment bien l’interpréter, est essentiel pour éviter de tirer de fausses conclusions.

| Limite n°1 : une seule variable à la fois | Le principe fondamental de l’A/B testing repose sur la modification d’un seul élément entre deux versions pour en isoler l’effet. Mais cela devient rapidement restrictif dans des environnements complexes où plusieurs variables interagissent entre elles. Par exemple, tester simultanément un changement de couleur de bouton, de titre et de mise en page brouille l’analyse. Pour analyser plusieurs paramètres à la fois, on privilégiera un test multivarié (MVT) ou des tests séquentiels bien planifiés. Cette limitation peut freiner l’innovation si elle n’est pas compensée par une stratégie de testing évolutive. |

| Limite n°2 : un échantillon insuffisant | Le manque de volume est l’un des écueils les plus courants. Un test A/B mené sur un faible trafic produit des résultats peu fiables, car trop sensibles aux fluctuations aléatoires. Il est nécessaire d’atteindre une taille d’échantillon représentative pour obtenir une puissance statistique suffisante. Des outils en ligne permettent de calculer la taille minimale nécessaire en fonction du taux de conversion initial, de l’effet attendu et du niveau de confiance souhaité. Tester trop tôt ou sur une base trop restreinte revient à prendre des décisions sur des intuitions déguisées en données. |

| Limite n°3 : interprétation biaisée | Un des pièges fréquents est de considérer une petite différence entre les deux versions comme significative sans preuve statistique. Or, même une variation de +3 % peut être due au hasard. Il est donc impératif d’utiliser des outils d’analyse intégrant une p-value (souvent p < 0,05) ou d’employer des modèles bayésiens pour valider la robustesse du résultat. Ignorer cette dimension peut mener à déployer des modifications inefficaces, voire contre-productives. |

| Limite n°4 : tests sans stratégie globale | Lancer des tests A/B sans feuille de route globale peut générer des décisions incohérentes. Par exemple, améliorer un taux de clic au détriment du taux de conversion final, ou prioriser des changements cosmétiques sans impact sur les objectifs business. L’A/B testing doit s’inscrire dans une stratégie claire de conversion, fidélisation ou expérience utilisateur, avec des priorités alignées sur les besoins réels du projet. Autrement, on risque de multiplier les optimisations locales sans effet systémique. |

| Limite n°5 : dépendance à court terme | Un test A/B mesure généralement un comportement immédiat : clic, ajout au panier, envoi d’un formulaire. Mais il ne tient pas toujours compte des effets à moyen ou long terme, comme le taux de réachat, la satisfaction utilisateur ou la perception de la marque. Une variation performante à court terme peut, par exemple, générer une frustration ultérieure (ex. : incitation trop agressive à l’achat). Il est donc utile de coupler certains tests à une analyse plus large, incluant des KPI de rétention ou de valeur vie client (CLV). |

Pour tirer le meilleur de cette pratique, voici quelques bonnes pratiques à retenir :

- Formulez toujours une hypothèse claire avant de tester : sans hypothèse, il est difficile d’interpréter les résultats avec justesse ;

- Ne testez qu’un changement à la fois pour pouvoir attribuer les résultats à la bonne variable ;

- Attendez que le test atteigne une taille d’échantillon suffisante : ne concluez pas trop tôt ;

- Analysez l’impact selon différents segments d’utilisateurs : une version peut mieux fonctionner sur mobile que sur desktop, par exemple ;

- Intégrez les tests dans une stratégie d’optimisation continue (CRO), pilotée par des objectifs business réels.

Enfin, l’A/B testing n’est pas réservé aux grandes entreprises. Même une TPE ou un indépendant peut en tirer des bénéfices, pour peu qu’il sache structurer ses tests et interpréter ses données avec rigueur. Dans un monde où chaque clic peut compter, mesurer l’efficacité réelle de chaque variation devient un levier indispensable pour améliorer l’expérience utilisateur, augmenter la rentabilité et faire évoluer son offre de façon intelligente.

0 commentaires